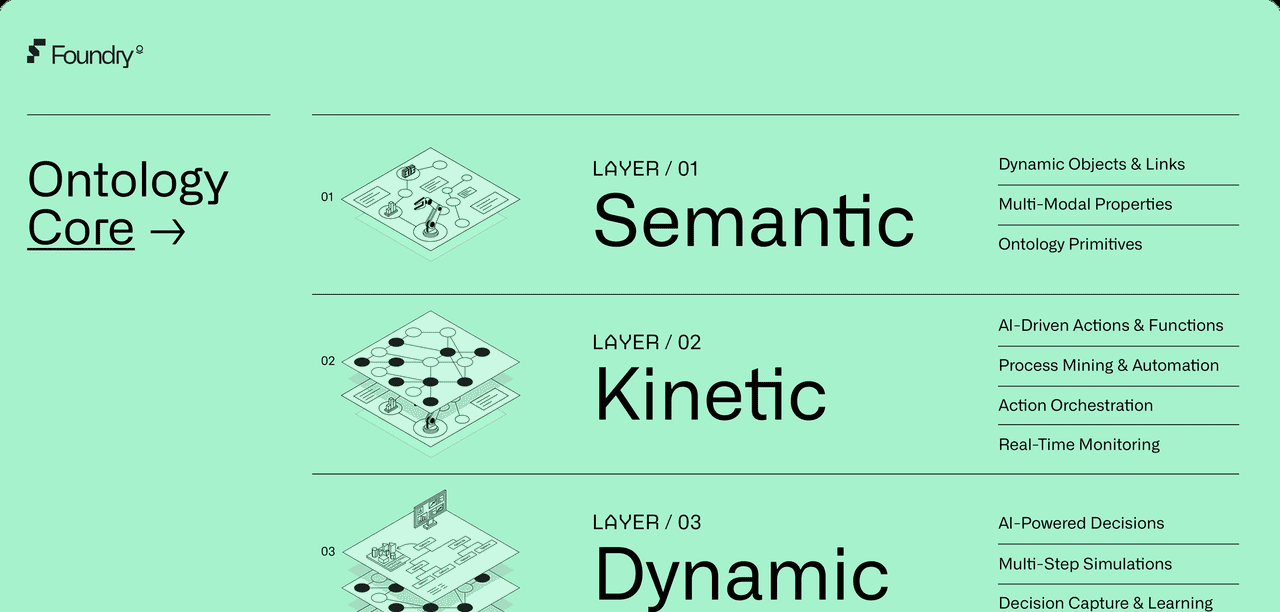

四大组件的“团队职责”:它们各自是什么?

“协同进化”:为什么激活函数(Sigmoid  ReLU)的进化,催生了优化器(SGD

ReLU)的进化,催生了优化器(SGD  Adam)的进化?

Adam)的进化?

综合演练:一个完整的训练示例,看它们如何协同作战。

1. 四大组件的“团队职责”

想象一下我们的终极目标:训练一个神经网络,即找到“损失函数”这座高维山脉的“最低谷”。

这四个组件在这个“下山”任务中扮演着不同的角色:

1. 激活函数 (Activation Function) ➡️ “地形的塑造者”

职责: 赋予网络“非线性”能力。

作用: 激活函数(如 ReLU, Sigmoid)是网络中的“非线性关节”。没有它们,神经网络(无论多深)都只等同于一个简单的线性模型。

对“下山”的影响: 它直接决定了“山脉”的形状。

Sigmoid 创造了充满“平原”(梯度消失区)的地形。

ReLU 创造了充满“陡峭峡谷”和“鞍点”的地形。

2. 梯度下降 (Gradient Descent) ➡️ “下山的最高战略”

职责: 提供了“如何下山”的核心哲学。

作用: 它的战略是:“在当前位置,找到最陡的下坡方向(负梯度),然后朝这个方向迈出一步。”

对“下山”的影响: 这是一个总纲领,所有“优化器”都必须遵守这个基本战略。

3. 反向传播 (Backpropagation) ➡️ “勘探工具 (GPS/雷达)”

职责: 高效地计算出那个“最陡的下坡方向”(即梯度 )。

)。

作用: 如果没有反向传播,梯度下降(战略)就无法执行,因为我们根本不知道“下坡路”在哪里。它利用链式法则,从损失(山顶)开始,高效地计算出每一个参数( 和

和  )应该为总损失负多少责任(即偏导数)。

)应该为总损失负多少责任(即偏导数)。

对“下山”的影响: 它不是优化器,也不是战略。它只是一个计算梯度的“工具”。

4. 优化器 (Optimizer) ➡️ “下山的交通工具”

职责: 具体执行“梯度下降”战略。

作用: 它拿到了反向传播(工具)算出的梯度(方向),然后决定“这一步到底该怎么走?”

对“下山”的影响:

朴素SGD (步行): “OK,就朝这个方向,迈出我固定的步长  。”

。”

Adam (智能越野车): “OK,我收到了这个方向。但我还记得我上一步的速度(动量),并且我会根据路况(梯度方差)来自动调整我的轮胎抓地力(自适应学习率),然后‘冲’过去!”

它们的关系(一句话总结):

为了实现梯度下降(战略),我们使用**反向传播(工具)来计算出由激活函数(地形)所定义的梯度,然后交给优化器(交通工具)**来真正执行这一步的更新。

误差

是逐层反向传播的。

从 L 层传到 L-1 层:

从 L-1 层传到 L-2 层:

…

这个过程会一直重复,直到网络的第一层。

2. “协同进化”:激活函数与优化器的深刻关系

这是您问题的核心。为什么激活函数从 Sigmoid  ReLU 的进化,迫使 优化器也必须从 SGD

ReLU 的进化,迫使 优化器也必须从 SGD  Adam 进化?

Adam 进化?

A. “旧时代”:Sigmoid + 朴素 SGD

地形 (Sigmoid):

Sigmoid 的致命缺陷是其导数永远  。

。

在深层网络中,链式法则导致

这创造了一个充满巨大“平原”的地形,即梯度消失。

交通工具 (朴素SGD):

SGD 在这个地形上训练。

当它走到“平原”上时,反向传播(工具)传回来的梯度  。

。

SGD 的更新是  。

。

结果: SGD 看到梯度为 0,就**“卡住”不动了**。它以为自己到了谷底,其实还在半山腰的平原上。

旧时代的困境: 无论优化器(SGD)多么努力,都无法克服激活函数(Sigmoid)创造的“地形缺陷”(梯度消失)。

B. “新时代”:ReLU + Adam

地形 (ReLU):

ReLU (  ) 登场了。

) 登场了。

它的导数是: (如果

(如果  )或

)或 (如果

(如果 )。

)。

它解决了梯度消失! 在激活的路径上,梯度是  ,梯度可以顺畅地流回深层。

,梯度可以顺畅地流回深层。

ReLU 创造的“新问题”:

ReLU 解决了一个旧问题,但也让地形变得更“崎岖”。

(1) 梯度爆炸: 既然导数是 1,梯度的幅度现在完全由权重  决定(

决定( )。如果

)。如果  ,梯度会爆炸。

,梯度会爆炸。

(2) 峡谷和鞍点: ReLU 的“分段线性”特性,创造了大量陡峭的“峡谷”和“鞍点”。

交通工具 (朴素SGD) 在新地形上的“翻车”:

朴素 SGD 开上了 ReLU 的“崎岖山路”。

在“峡谷”:SGD 在陡峭的“墙壁”间来回剧烈反弹,但在平缓的“谷底”方向(真正该走的方向)进展缓慢。

在“鞍点”:梯度  ,SGD 再次**“卡住”**。

,SGD 再次**“卡住”**。

在“陡坡”(梯度爆炸):SGD 一步迈得太大( ),直接**“飞出”**了山谷(训练发散)。

),直接**“飞出”**了山谷(训练发散)。

“协同进化”:Adam 的诞生

我们不能换回 Sigmoid(因为梯度消失),所以我们必须升级“交通工具”来适应 ReLU 的“崎岖地形”!

Adam (智能越野车) 被设计出来,用“两大法宝”专治这种地形:

(1) 动量 (Momentum): 解决“峡谷”和“鞍点”。

它( )积累了“惯性”。在峡谷中,反弹的梯度(方向相反)会相互抵消;在鞍点,它能凭借惯性“冲”过去。

)积累了“惯性”。在峡谷中,反弹的梯度(方向相反)会相互抵消;在鞍点,它能凭借惯性“冲”过去。

(2) 自适应学习率 (RMSProp): 解决“陡坡”和“缓坡”。

它( )跟踪梯度的“历史幅度”。

)跟踪梯度的“历史幅度”。

在“陡峭墙壁”(梯度大),它自动减小步长(防止飞出)。

在“平缓谷底”(梯度小),它自动增大步长(加速前进)。

进化的总结:

Sigmoid 创造了“平坦”但“无效”(梯度消失)的地形,ReLU 创造了“有效”(梯度流通)但“崎岖”(峡谷/爆炸)的地形。

优化器的进化 (SGD

Adam),就是为了让我们的“交通工具”有能力在这种“崎岖”但“有效”的新地形上安全、快速地行驶。

3. 综合演练:一次训练迭代的“团队协作”

让我们用一个简单的2层神经网络(手写数字 MNIST 识别)来展示这个“梦之队”的单次迭代(处理一个 Batch)。

团队配置:

地形: 隐藏层使用 ReLU 激活函数。

工具: 反向传播。

战略: 梯度下降。

交通工具: Adam 优化器。

初始化 (训练开始前):

He 初始化:我们选择 He 初始化来设置 。

。

协同关系: 为什么选 He?因为它在数学上被证明是 ReLU(地形) 的“最佳拍档”,可以防止信号(方差)在 ReLU 网络中消失或爆炸。

Adam 初始化:Adam 优化器创建了  等“记忆”向量,全部初始化为 0。

等“记忆”向量,全部初始化为 0。

单次迭代 (Batch) 开始:

步骤 1:前向传播 (Forward Pass)

目标: 计算当前参数下的损失。

过程:

x

z1 = W1 @ x + b1

a1 = ReLU(z1)

【激活函数(地形)】 在此工作。它将  中的所有负数变为 0,引入“非线性”。

中的所有负数变为 0,引入“非线性”。

z2 = W2 @ a1 + b2

a2 = Softmax(z2)

Loss = CrossEntropy(a2, y_true)

步骤 2:反向传播 (Backward Pass)

目标: 拿到“下山方向图”( 等)。

等)。

过程:

【反向传播(工具)】 启动!

从

Loss 。

。

利用  和

和  ,计算出

,计算出  和

和  。

。

计算  。

。

关键点: 计算

【激活函数(地形)】 再次工作!它的导数在此刻登场。

是一个“开关”:

是一个“开关”: 中 > 0 的位置,梯度为 1(通过);

中 > 0 的位置,梯度为 1(通过); 的位置,梯度为 0(阻断)。

的位置,梯度为 0(阻断)。

利用  和

和  ,计算出

,计算出  和

和  。

。

BP 结束: 我们现在手握所有参数的梯度( )。

)。

步骤 3:参数更新 (Optimizer Step)

目标: “下山”,更新参数  。

。

过程:

【梯度下降(战略)】 告诉我们:“是时候更新了!”

【Adam(交通工具)】 接管任务。

Adam 拿到  (例如),它不会立即更新。

(例如),它不会立即更新。

(A) 更新动量:

m = beta1 * m + (1 - beta1) *

abla W1

(B) 更新自适应:

v = beta2 * v + (1 - beta2) * (

abla W1)^2

(C) 修正偏差 (训练初期的补偿)

(D) 计算最终步长:

step = lr * m_corr / (sqrt(v_corr) + epsilon)

(E) 执行更新:

W1 = W1 - step

Adam 对  执行同样智能的更新。

执行同样智能的更新。

迭代结束。 神经网络的参数  已经被 Adam 优化器沿着反向传播计算出的、在 ReLU 地形上的梯度,智能地“推动”了一小步。

已经被 Adam 优化器沿着反向传播计算出的、在 ReLU 地形上的梯度,智能地“推动”了一小步。

总结:

这四个组件缺一不可。激活函数定义了问题(地形),反向传播分析了问题(计算梯度),梯度下降确立了目标(下山),而优化器则提供了解决问题的工具(智能下山)。

相关文章

是逐层反向传播的。

是逐层反向传播的。