大数据分布式存储:构建高效数据存储体系的实践与原理

一、引言:为什么需要分布式存储?

1.1 痛点:传统存储的“不可承受之重”

假设你是一家电商公司的技术负责人,面对以下场景:

每天产生10TB用户行为日志(点击、浏览、购买);每月新增1亿条订单数据(结构化,需支持实时查询);存储5000万张商品图片(非结构化,需高并发访问);大促期间(如双11),数据写入量激增10倍,同时需要支撑10万QPS的查询请求。

如果用传统的集中式存储(如单台NAS或SAN),会遇到什么问题?

** scalability 瓶颈**:存储容量受限于单台服务器的磁盘数量,无法线性扩展;性能瓶颈:单台服务器的CPU、内存、网络带宽无法应对高并发读写;可靠性风险:单点故障会导致整个存储系统宕机,数据丢失风险高;成本高:为了满足性能需求,需要购买高端服务器,成本呈指数级增长。

1.2 解决方案:分布式存储的崛起

分布式存储通过将数据分散存储在多台服务器(节点)上,解决了传统存储的痛点:

线性扩展:通过增加节点即可扩展存储容量和性能;高可靠性:通过多副本或纠删码机制,即使部分节点宕机,数据也不会丢失;高性能:通过并行处理(多节点同时读写),提高整体吞吐量;低成本:使用普通服务器(x86架构),降低硬件成本。

1.3 高效存储体系的核心目标

构建高效的分布式存储体系,需要平衡以下四个关键要素:

| 要素 | 目标 |

|---|---|

| Scalability(扩展性) | 支持水平扩展(增减节点不影响服务),应对数据量的爆炸式增长。 |

| Performance(性能) | 满足业务的读写延迟(如订单查询≤100ms)和吞吐量(如日志写入≥1GB/s)需求。 |

| Reliability(可靠性) | 达到**99.999%**的可用性(年 downtime ≤5分钟),避免数据丢失。 |

| Cost(成本) | 降低单位存储成本(如元/GB/月),通过技术优化(如纠删码、冷数据迁移)控制成本。 |

二、基础概念:分布式存储的“语言体系”

在深入原理之前,先明确几个核心术语,避免后续理解偏差:

2.1 核心术语解释

节点(Node):分布式存储中的单个服务器,负责存储数据或管理元数据(如HDFS的DataNode)。集群(Cluster):由多个节点组成的存储系统,共同提供存储服务(如Hadoop集群)。副本(Replica):数据的多个拷贝,用于提高可靠性(如HDFS默认3副本,存放在不同节点)。分片(Shard):将大文件或数据集拆分成小片段(如HBase的Region、Elasticsearch的Shard),分散存储在不同节点。一致性模型(Consistency Model):定义多副本之间的数据同步规则(如强一致性:所有副本同步更新;最终一致性:副本异步更新,最终一致)。存储引擎(Storage Engine):分布式存储的“数据组织方式”,常见类型:

文件存储(如HDFS):按文件目录结构存储,适合大文件(如日志);块存储(如Ceph RBD):将数据分成固定大小的块(如4MB),适合数据库(如MySQL);对象存储(如AWS S3、Ceph RGW):以“对象”(文件+元数据)为单位存储,适合非结构化数据(如图片、视频)。

2.2 关键理论:CAP定理

CAP定理是分布式系统的“圣经”,它指出:任何分布式系统都无法同时满足一致性(Consistency)、可用性(Availability)和分区容错性(Partition Tolerance),只能选择其中两个。

一致性(C):所有节点同时看到最新的数据(如银行转账,A账户扣钱后,B账户立即到账);可用性(A):任何请求都能得到响应(即使部分节点宕机);分区容错性(P):网络分区(如节点之间无法通信)时,系统仍能运行。

分布式存储的选择:

金融场景(如银行):优先选CP(强一致性+分区容错),牺牲部分可用性;互联网场景(如电商):优先选AP(高可用性+分区容错),接受最终一致性(如用户评论延迟1秒显示)。

三、核心原理:分布式存储的“底层逻辑”

3.1 分布式存储的架构设计

分布式存储的架构决定了其扩展性、可靠性和性能。常见的架构有两种:

3.1.1 主从架构(Master-Slave)

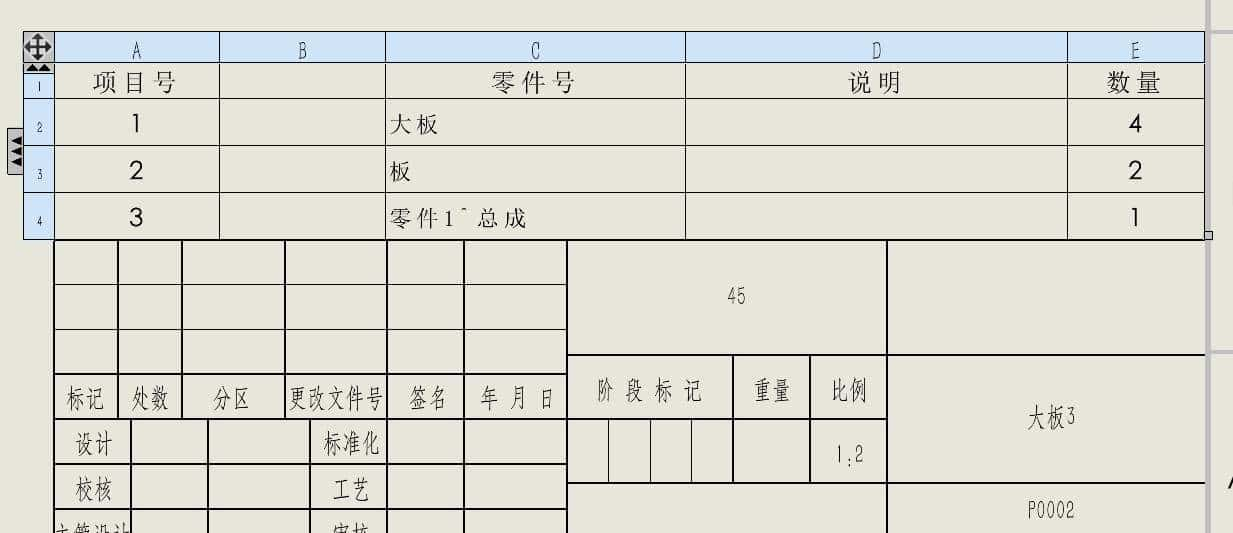

典型案例:HDFS(Hadoop Distributed File System)

架构说明:

主节点(Master):负责管理元数据(如文件目录、副本位置),协调从节点工作(如HDFS的NameNode);从节点(Slave):负责实际存储数据(如HDFS的DataNode),接受主节点的指令。

优点:

元数据管理集中,逻辑简单;适合大文件顺序写场景(如日志存储、大数据分析)。

缺点:

主节点是单点故障(需通过 standby 节点解决,如HDFS的Secondary NameNode);扩展性受限于主节点的处理能力(如NameNode的内存限制,无法存储过多元数据)。

3.1.2 去中心化架构(Decentralized)

典型案例:Ceph(统一存储系统)

架构说明:

无中心节点,所有节点平等(如Ceph的OSD节点,既存储数据又管理元数据);通过CRUSH算法(Controlled Replication Under Scalable Hashing)实现数据分布和副本管理。

优点:

无单点故障,高可用性;支持多租户(如同时提供块存储、文件存储、对象存储服务);扩展性好(增减节点时,数据自动重新分布)。

缺点:

逻辑复杂,运维难度高;适合混合存储场景(如同时存储图片、数据库、日志)。

3.1.3 架构选择建议

| 场景 | 推荐架构 | 原因 |

|---|---|---|

| 大数据分析(如Spark) | 主从架构(HDFS) | 大文件顺序写性能优,元数据管理简单。 |

| 多租户存储(如云服务) | 去中心化架构(Ceph) | 支持多种存储引擎,无单点故障,扩展性好。 |

| 实时数据库(如HBase) | 主从架构(HMaster+RegionServer) | 集中管理元数据,提高查询效率。 |

3.2 数据分布:如何把数据“拆”到不同节点?

数据分布是分布式存储的核心问题,直接影响扩展性和性能。常见的策略有三种:

3.2.1 哈希分片(Hash Sharding)

原理:将数据的键(Key)通过哈希函数(如MD5、SHA-1)映射到一个哈希空间(如0~2^32-1),然后将哈希空间分成多个区间,每个区间对应一个节点。

典型案例:Redis Cluster(一致性哈希)、Cassandra(MurmurHash)。

优点:

数据分布均匀(只要哈希函数足够好);增减节点时,只需迁移少量数据(一致性哈希可将迁移量控制在1/N,N为节点数)。

缺点:

不支持范围查询(如查询“用户ID在1000~2000之间的数据”,需要遍历所有节点);可能出现数据倾斜(如某个Key的哈希值集中在一个节点,导致该节点负载过高)。

优化方案:

使用一致性哈希(Consistent Hashing):将节点映射到哈希环上,数据根据Key的哈希值找到最近的节点。当节点增减时,只需移动相邻节点的数据(如图1所示)。增加虚拟节点(Virtual Node):每个物理节点对应多个虚拟节点(如100个),减少数据倾斜的概率。

3.2.2 范围分片(Range Sharding)

原理:将数据按Key的范围划分成多个分区(Partition),每个分区对应一个节点。

典型案例:HBase(Region)、Elasticsearch(Index Shard)。

优点:

支持范围查询(如查询“2023-10-01至2023-10-07的订单数据”,只需访问对应的分区);数据分布可控(可根据业务需求调整分区范围)。

缺点:

增减节点时,需要重新划分分区(迁移数据量较大);容易出现热点问题(如某个分区的Key访问量过大,导致该节点负载过高)。

优化方案:

预分区(Pre-Sharding):在创建表时,预先划分多个分区(如HBase的Region预分区),避免后续频繁调整;动态分区(Dynamic Sharding):根据节点负载自动调整分区范围(如Elasticsearch的自动扩展)。

3.2.3 目录分片(Directory Sharding)

原理:将数据按目录结构划分(如按日期、用户ID),每个目录对应一个节点。

典型案例:GFS(Google File System)、HDFS(按目录存储文件)。

优点:

逻辑简单(符合人类的文件管理习惯);适合大文件存储(如日志文件按日期划分,每个文件存到对应的节点)。

缺点:

不支持随机查询(如查询“用户ID=123的订单数据”,需要遍历所有目录);扩展性受限于目录结构(如日期目录无法无限扩展)。

优化方案:

结合哈希分片(如目录+哈希,如“2023-10-01/用户ID哈希值%10”),提高扩展性。

3.2.4 分布策略选择建议

| 场景 | 推荐策略 | 原因 |

|---|---|---|

| 实时随机查询(如HBase) | 范围分片 | 支持范围查询,适合结构化数据。 |

| 缓存系统(如Redis Cluster) | 哈希分片(一致性哈希) | 数据分布均匀,增减节点时迁移量小。 |

| 大文件存储(如HDFS) | 目录分片+范围分片 | 符合文件管理习惯,适合顺序写场景。 |

3.3 可靠性:如何保证数据“不丢”?

可靠性是分布式存储的“生命线”,常见的机制有两种:副本机制和纠删码。

3.3.1 副本机制(Replication)

原理:将数据的多个拷贝(副本)存储在不同节点,当某个节点宕机时,用其他副本恢复数据。

典型案例:HDFS(默认3副本)、Ceph(副本数可配置)。

副本同步方式:

同步副本(Synchronous Replication):写操作需等待所有副本写入成功后,才返回成功(强一致性);异步副本(Asynchronous Replication):写操作只需等待主副本写入成功后,就返回成功,其他副本异步同步(最终一致性)。

优点:

恢复速度快(只需复制副本,无需计算);实现简单(大部分分布式存储都支持)。

缺点:

存储成本高(3副本的成本是原始数据的3倍);写入性能受限于最慢的副本(同步副本)。

优化方案:

机架感知(Rack Awareness):将副本存放在不同机架(如HDFS的“机架感知”策略),避免整个机架宕机导致数据丢失;副本数动态调整(如根据数据热度调整副本数:热数据3副本,冷数据1副本)。

3.3.2 纠删码(Erasure Code, EC)

原理:将数据分成K个数据块,通过编码生成M个校验块(总块数为K+M),只要任意K个块(数据块+校验块)存在,就能恢复原始数据。

典型案例:HDFS(支持EC,如4+2:4个数据块+2个校验块)、Ceph(支持EC)。

计算方式:

例如,4+2纠删码:

原始数据:D1、D2、D3、D4(每个块1GB);校验块:P1=D1+D2+D3+D4(异或运算),P2=D1+2D2+3D3+4D4(线性组合);恢复:如果D1和D2宕机,可通过D3、D4、P1、P2计算出D1和D2。

优点:

存储成本低(4+2的成本是原始数据的1.5倍,远低于3副本的3倍);适合冷数据存储(如归档数据)。

缺点:

恢复时间长(需要计算,而不是直接复制);写入性能低(需要生成校验块,增加计算开销)。

优化方案:

混合存储(Hybrid Storage):热数据用副本机制(3副本),冷数据用纠删码(4+2),平衡成本和性能;硬件加速(如用GPU或FPGA加速校验块计算)。

3.3.3 副本与纠删码的选择建议

| 场景 | 推荐机制 | 原因 |

|---|---|---|

| 热数据(如最近7天的日志) | 副本机制(3副本) | 恢复速度快,满足高可用性需求。 |

| 冷数据(如超过6个月的订单) | 纠删码(4+2) | 存储成本低,适合归档场景。 |

| 金融数据(如交易记录) | 同步副本+纠删码 | 强一致性+高可靠性,满足监管要求。 |

3.4 故障恢复:如何应对节点宕机?

分布式存储的节点宕机是“常态”(如硬件故障、网络中断),故障恢复流程直接影响可用性。以HDFS为例,说明故障恢复的过程:

3.4.1 故障检测(Failure Detection)

心跳机制(Heartbeat):DataNode每隔3秒向NameNode发送心跳(Heartbeat),如果超过10分钟未收到心跳,NameNode判定该DataNode宕机;块报告(Block Report):DataNode每隔6小时向NameNode发送块报告(Block Report),汇报自己存储的块信息。

3.4.2 副本重新分配(Replica Reassignment)

当NameNode检测到某个DataNode宕机时,会执行以下步骤:

标记该DataNode上的所有块为“未完成”(Under-Replicated);计算需要补充的副本数(如HDFS默认3副本,宕机后剩下2副本,需要补充1个);选择合适的DataNode(如空闲节点、不同机架),复制副本;当副本数恢复到配置值后,标记该块为“完成”(Replicated)。

3.4.3 优化:快速恢复(Fast Recovery)

增量复制(Incremental Replication):只复制宕机节点上的新增数据(如HDFS的“增量块报告”),减少复制量;并行复制(Parallel Replication):同时复制多个块(如HDFS的“副本复制线程池”),提高恢复速度。

四、性能优化:构建“高效”存储体系的关键

4.1 缓存:减少“慢IO”的次数

缓存是提高性能的“第一利器”,通过将热点数据存储在高速存储介质(如内存、SSD)中,减少对慢存储(如机械硬盘)的访问。

常见缓存策略:

前端缓存(CDN):将静态资源(如商品图片)存储在离用户最近的CDN节点,减少回源请求(如阿里云CDN、Cloudflare);后端缓存(In-Memory Cache):将热点数据(如订单详情)存储在内存中(如Redis、Memcached),提高查询速度;存储层缓存(Storage Cache):将常用数据存储在SSD中(如HDFS的“缓存池”,Ceph的“SSD缓存层”),减少机械硬盘的IO压力。

优化建议:

缓存穿透(Cache Penetration):对于不存在的数据,避免频繁查询存储层(如用布隆过滤器过滤不存在的Key);缓存雪崩(Cache Avalanche):避免缓存同时过期(如给缓存设置随机过期时间);缓存击穿(Cache Breakdown):对于热点Key,避免缓存过期后大量请求穿透到存储层(如设置“永不过期”或“互斥锁”)。

4.2 IO优化:让“数据流动”更高效

IO是分布式存储的“瓶颈”(尤其是机械硬盘),优化IO方式可以显著提高性能。

常见IO优化策略:

顺序写优先(Sequential Write):机械硬盘的顺序写速度(如150MB/s)远快于随机写(如10MB/s),因此分布式存储(如HDFS)设计为适合顺序写(大文件、 append-only);批量写(Batch Write):将多个小文件合并成大文件写入(如Flume的“批量提交”,Kafka的“批量消息”),减少IO次数;异步写(Asynchronous Write):将数据先写入内存缓冲区,再异步写入磁盘(如HDFS的“Write-Ahead Log”,Ceph的“异步IO”),提高写入性能;IO调度算法(IO Scheduler):选择合适的IO调度算法(如Linux的“Deadline”调度算法,适合顺序写场景;“CFQ”调度算法,适合多租户场景)。

案例:HDFS的顺序写优化

HDFS的设计目标是存储大文件(如1GB以上),并且支持顺序写(append-only,不支持随机修改)。这样做的原因是:

大文件的顺序写可以减少“寻道时间”(机械硬盘的磁头移动时间);顺序写的IO吞吐量更高(如1GB的大文件,顺序写只需1次寻道,而1000个1MB的小文件需要1000次寻道)。

4.3 压缩:用“计算”换“存储”和“带宽”

压缩可以减少数据的大小,从而降低存储成本和网络传输成本(尤其是跨节点传输时)。

常见压缩算法:

| 算法 | 压缩比 | 压缩速度 | 解压速度 | 适用场景 |

|---|---|---|---|---|

| Snappy | 低(~2x) | 快(~500MB/s) | 快(~1GB/s) | 大数据分析(如Spark中间数据) |

| Gzip | 高(~6x) | 慢(~100MB/s) | 慢(~200MB/s) | 冷数据存储(如日志归档) |

| LZ4 | 中(~3x) | 很快(~1GB/s) | 很快(~2GB/s) | 实时数据处理(如Kafka消息) |

优化建议:

平衡压缩比和速度:对于实时场景(如Spark Streaming),选择LZ4或Snappy;对于离线场景(如Hive批处理),选择Gzip;端到端压缩:从数据采集(如Flume压缩日志)到存储(如HDFS存储压缩文件),再到处理(如Spark读取压缩文件),全程保持压缩,减少数据传输量。

4.4 并行处理:让“多节点”一起工作

分布式存储的优势是并行处理,通过将数据拆分成多个块,让多个节点同时处理,提高吞吐量。

常见并行策略:

数据分区(Data Partitioning):将数据拆分成多个分区(如Spark的RDD分区,HBase的Region),每个分区由一个节点处理;任务并行(Task Parallelism):将处理任务拆分成多个子任务(如Spark的Task,MapReduce的Map Task),每个子任务处理一个分区;流水线处理(Pipeline Processing):将数据处理流程拆分成多个阶段(如“读取→处理→写入”),每个阶段并行执行(如Flink的流水线处理)。

案例:Spark的RDD分区优化

Spark的RDD(弹性分布式数据集)是分布式存储的抽象,每个RDD由多个分区组成。优化分区数可以提高并行度:

太少分区:并行度低,无法充分利用集群资源;太多分区:任务调度开销大(每个任务需要初始化、执行、清理)。

优化建议:

分区数设置为**集群核心数的23倍**(如集群有100个核心,分区数设置为200300);使用自定义分区器(如按用户ID哈希分区),避免数据倾斜。

4.5 网络优化:让“数据传输”更顺畅

分布式存储的节点之间需要传输大量数据(如副本复制、任务数据传输),网络带宽是“瓶颈”。

常见网络优化策略:

高速网络:使用10Gbps以太网或InfiniBand(如Hadoop集群的“10Gbps网络”),提高传输速度;机架感知:将副本存放在不同机架(如HDFS的“机架感知”策略),减少跨机架的网络流量;数据本地化(Data Locality):将计算任务调度到数据所在的节点(如Spark的“数据本地化”策略),减少数据传输量(如“进程本地化”>“节点本地化”>“机架本地化”>“跨机架”)。

案例:Hadoop的“数据本地化”

Hadoop的MapReduce任务会优先调度到数据所在的节点(进程本地化),如果没有空闲资源,再调度到同一节点的其他进程(节点本地化),再调度到同一机架的其他节点(机架本地化),最后调度到跨机架的节点。这样可以减少数据传输量,提高任务执行速度。

五、实践案例:构建电商大数据存储体系

5.1 需求分析

某电商公司需要构建一个大数据存储体系,满足以下需求:

数据类型:结构化(订单数据)、半结构化(用户行为日志)、非结构化(商品图片);数据规模:每天10TB用户行为日志,每月1亿条订单数据,5000万张商品图片;访问模式:

订单数据:实时查询(如“查询用户最近30天的订单”);用户行为日志:离线分析(如“统计用户转化率”);商品图片:高并发访问(如“用户浏览商品时加载图片”);

可靠性要求:99.99%可用性,数据丢失率为0;成本要求:单位存储成本≤0.5元/GB/月。

5.2 技术栈选择

根据需求,选择以下技术栈:

| 数据类型 | 存储系统 | 原因 |

|---|---|---|

| 结构化(订单) | HBase | 支持实时随机查询(如按用户ID查询订单),扩展性好。 |

| 半结构化(日志) | HDFS | 适合大文件顺序写(用户行为日志按日期存储),支持离线分析(如Spark)。 |

| 非结构化(图片) | Ceph对象存储 | 支持高并发访问(商品图片),兼容S3协议(方便与CDN集成)。 |

| 数据处理 | Spark | 支持批处理(离线分析)和流处理(实时分析),与HDFS、HBase集成好。 |

| 数据采集 | Flume+Kafka | Flume采集日志,Kafka缓冲高并发写入(如大促期间的日志峰值)。 |

| 数据查询 | Presto+Hive | Presto支持Ad-hoc查询(如“查询最近7天的订单量”),Hive支持离线分析。 |

5.3 架构设计

(注:此处为示意图,实际需根据场景调整)

(注:此处为示意图,实际需根据场景调整)

架构说明:

数据采集层:使用Flume采集用户行为日志(如nginx日志),发送到Kafka缓冲;使用业务系统(如订单系统)将订单数据写入Kafka;使用图片上传服务将商品图片上传到Ceph对象存储。数据存储层:

HDFS:存储用户行为日志(按日期目录划分,如“2023-10-01/access.log”);HBase:存储订单数据(按用户ID哈希分区,避免数据倾斜);Ceph对象存储:存储商品图片(按“商品ID/图片名称”划分,使用CDN缓存)。

数据处理层:使用Spark读取HDFS的日志数据,进行离线分析(如统计用户转化率);使用Spark Streaming读取Kafka的订单数据,进行实时处理(如更新用户积分)。数据查询层:使用Presto查询HBase的订单数据(Ad-hoc查询),使用Hive查询HDFS的日志数据(离线分析);使用CDN查询Ceph的商品图片(高并发访问)。

5.4 优化点说明

5.4.1 HBase优化:避免数据倾斜

预分区:创建订单表时,按用户ID的哈希值预分区(如分成100个Region),避免数据集中在一个Region;加盐(Salting):对于热点用户(如大V用户),在用户ID前添加随机前缀(如“a-123”、“b-123”),将数据分散到不同Region。

5.4.2 HDFS优化:降低存储成本

纠删码:将冷数据(如超过6个月的日志)从3副本改为4+2纠删码,存储成本从3倍降低到1.5倍;冷数据迁移:将超过1年的日志迁移到阿里云的归档存储(成本约0.1元/GB/月),进一步降低成本。

5.4.3 Ceph优化:提高图片访问速度

CDN缓存:将商品图片的URL配置到阿里云CDN,用户访问图片时,优先从CDN节点获取(如“https://cdn.example.com/商品ID/图片名称”);SSD缓存:将热点图片(如最近7天的图片)存储在Ceph的SSD缓存层,提高读取速度。

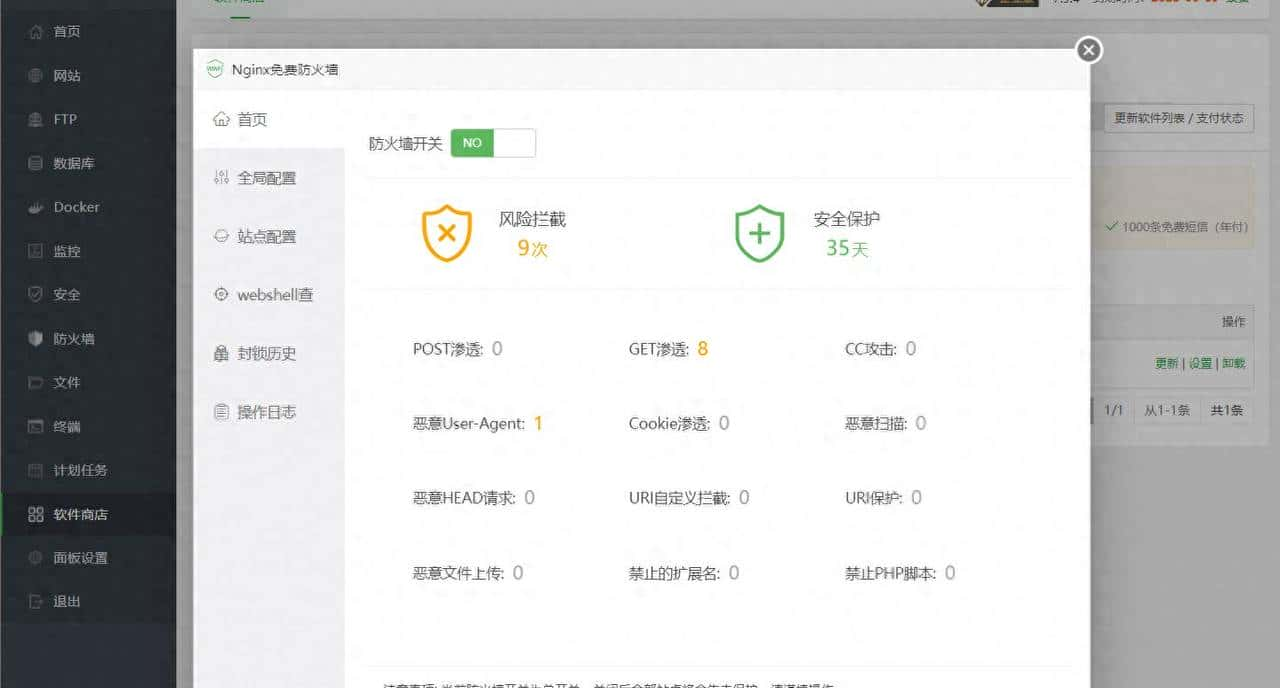

5.4.4 监控与运维

监控:使用Prometheus监控HDFS、HBase、Ceph的 metrics(如节点CPU利用率、磁盘使用率、网络流量),用Grafana展示 dashboard;警报:使用Alertmanager设置警报(如HDFS的磁盘使用率超过80%时,发送邮件报警);备份:定期将HDFS的日志数据备份到阿里云OSS(异地备份),将HBase的订单数据备份到Ceph(本地备份),防止数据丢失。

5.5 效果评估

扩展性:支持水平扩展(增减HDFS DataNode、HBase RegionServer、Ceph OSD节点),应对数据量增长;性能:

订单查询延迟≤100ms(HBase的随机读性能);日志写入吞吐量≥1GB/s(HDFS的顺序写性能);图片访问QPS≥10万(CDN+Ceph的高并发性能);

可靠性:达到99.99%可用性(年 downtime ≤8.76小时),数据丢失率为0;成本:单位存储成本≤0.4元/GB/月(通过纠删码、冷数据迁移、CDN缓存降低成本)。

六、常见问题与解决方案

6.1 数据倾斜(Data Skew)

问题:某个节点的存储或计算负载远高于其他节点(如HBase的某个Region数据量是其他Region的10倍)。

解决方案:

调整分区键:使用更均匀的分区键(如按用户ID哈希分区,而不是按订单ID);数据预处理:将热点数据拆分(如将大V用户的订单数据拆分成多个小文件);动态负载均衡:使用分布式存储的负载均衡工具(如HDFS的Balancer,Ceph的OSD Balancer),自动调整数据分布。

6.2 节点负载不均衡(Load Imbalance)

问题:某个节点的CPU、内存或磁盘使用率远高于其他节点(如Ceph的某个OSD节点磁盘使用率达到90%,而其他节点只有50%)。

解决方案:

数据迁移:将负载高的节点的数据迁移到负载低的节点(如Ceph的“osd reweight”命令,调整节点的权重);扩容:增加新节点,分担负载(如HDFS添加DataNode,Ceph添加OSD节点);优化查询:减少对负载高的节点的查询(如将热点数据缓存到其他节点)。

6.3 数据一致性问题(Data Consistency)

问题:多副本之间的数据不一致(如异步副本的情况下,主副本写入成功,但从副本未同步)。

解决方案:

选择合适的一致性模型:对于强一致性需求(如金融数据),使用同步副本;对于最终一致性需求(如电商评论),使用异步副本;版本控制:给数据添加版本号(如HBase的“时间戳”),读取时选择最新版本;冲突解决:对于并发写操作,使用冲突解决策略(如“最后写入胜利”,或自定义冲突解决逻辑)。

6.4 存储成本过高(High Storage Cost)

问题:分布式存储的成本远高于预期(如3副本的HDFS存储成本是原始数据的3倍)。

解决方案:

使用纠删码:将热数据的副本数减少(如从3副本改为4+2纠删码);冷数据迁移:将冷数据(如超过6个月的数据)迁移到成本更低的存储(如归档存储、对象存储);数据压缩:使用高效的压缩算法(如Snappy、Gzip),减少数据大小;删除过期数据:定期清理过期数据(如超过1年的日志数据),释放存储空间。

七、总结与展望

7.1 总结:构建高效分布式存储体系的关键

需求驱动:根据数据类型、访问模式、可靠性要求选择合适的分布式存储系统(如HDFS适合大文件顺序写,HBase适合实时随机查询);平衡 trade-off:在 scalability、性能、可靠性、成本之间找到平衡(如用纠删码降低成本,但牺牲恢复速度);优化细节:关注缓存、IO、网络、并行处理等细节(如数据本地化减少网络传输,顺序写提高IO性能);监控与运维:定期监控分布式存储的状态,及时解决问题(如数据倾斜、节点负载不均衡)。

7.2 展望:分布式存储的未来趋势

云原生:越来越多的分布式存储系统采用云原生架构(如Rook(Kubernetes原生的Ceph)、MinIO(云原生对象存储)),支持在Kubernetes集群中部署和管理;智能存储:使用AI预测数据访问模式(如用机器学习模型预测热点数据),自动调整缓存策略、数据分布、副本数(如“智能存储引擎”);边缘存储:在物联网设备(如摄像头、传感器)上部署分布式存储(如IPFS、EdgeX Foundry),减少数据传输到云端的成本和延迟;去中心化存储:使用区块链技术实现分布式存储(如Filecoin),提高安全性和隐私性(数据存储在多个节点,没有中心化机构控制)。

八、结语

分布式存储是大数据时代的“基础设施”,构建高效的数据存储体系需要深入理解其原理,结合实践经验优化细节。没有“完美”的分布式存储系统,只有“适合”的解决方案。希望本文能帮助你在构建分布式存储体系时,少走弯路,多快好省地满足业务需求。

如果你有任何问题或想法,欢迎在评论区留言,我们一起讨论!

参考资料:

《Hadoop权威指南》(第4版):讲解HDFS、MapReduce的原理与实践;《Ceph设计与实现》:深入讲解Ceph的架构与原理;《Spark快速大数据分析》:讲解Spark的RDD、DataFrame等核心概念;官方文档:HDFS(https://hadoop.apache.org/docs/stable/hadoop-project-dist/hadoop-hdfs/HdfsDesign.html)、Ceph(https://docs.ceph.com/en/latest/)、HBase(https://hbase.apache.org/)。

相关文章