#我在头条搞创作##在头条看见彼此##知识库#

【更多免费AI工具,请收藏关注】

前言

常常在头条上看到这样的情况,原创太难了,就算是宰相肚,天天输出,一天10篇的输出,也有捉襟见肘,江郎才尽的时候。

这时候有存货,取之不尽的存货就特别重大。

于是去找货,存起来。

列如买书看书,记在脑子里,勤快一点的写心得笔记,记在本子上;

列如去网上搜集段子,故事,去关注其他大流量博主的爆款文章,存下来,准备仿写搞伪原创;

列如去体验生活,多方打听,观察,认真搜集素材,存下备用。

可是每个人每天就是24小时,要高频次多输出内容,这些存货就不够用了。慢慢写效率太低。

如果有个助手类工具,能帮自己整理搜集到的素材,按格式要求输出符合要求的文章,那就太好了,个人可以专注搜集素材和发布前审核了。(实则搜集素材也有高效工具:网络爬虫和RPA,后来再分享)

打造自己的原创知识库

推荐2个开源AI工具,Ollama+AnythingLLM,Ollama负责下载,管理LLM大模型,AnythingLLM负责管理交互对话,文档管理,信息输出。2个工具都支持Win,Mac,Linux平台。

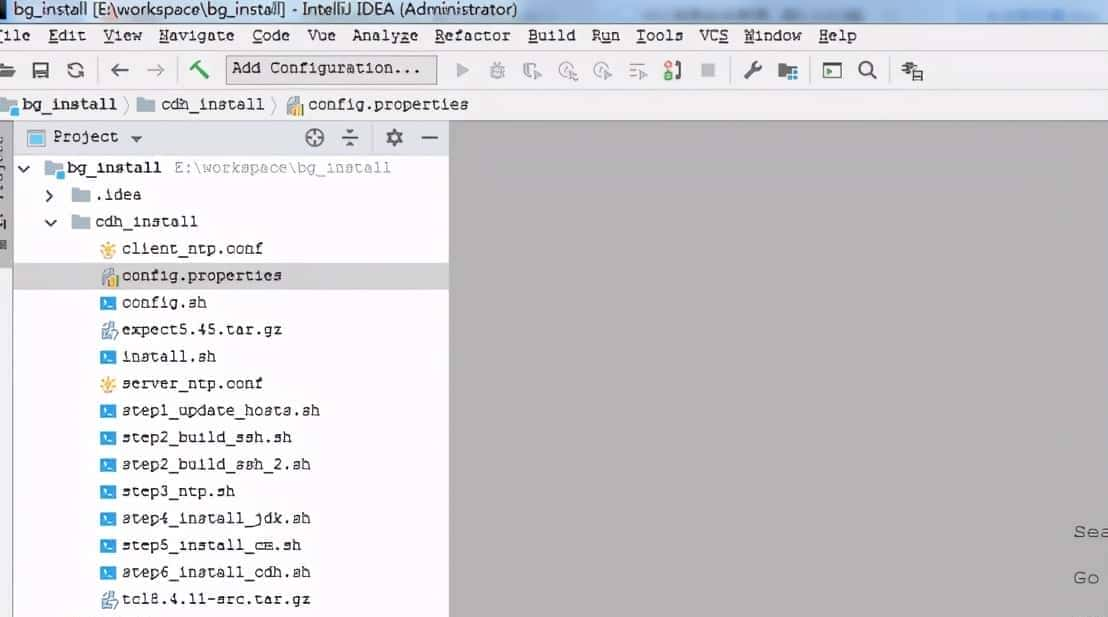

Ollama下载,安装,使用:

下载地址:

https://ollama.com/download

根据自己电脑系统选择对应的客户端安装,启动即可。

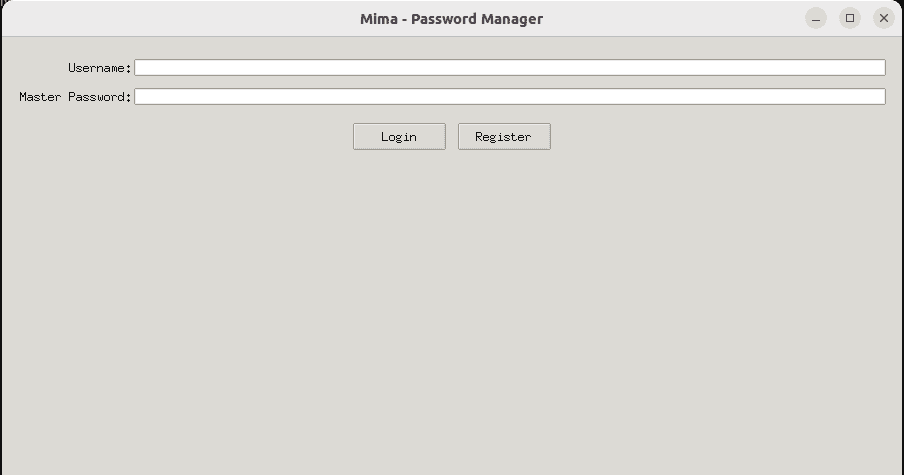

AnythingLLM下载,安装,使用:

下载地址:

https://useanything.com/download

根据自己电脑系统选择对应的客户端安装,启动即可。

2者合并使用:

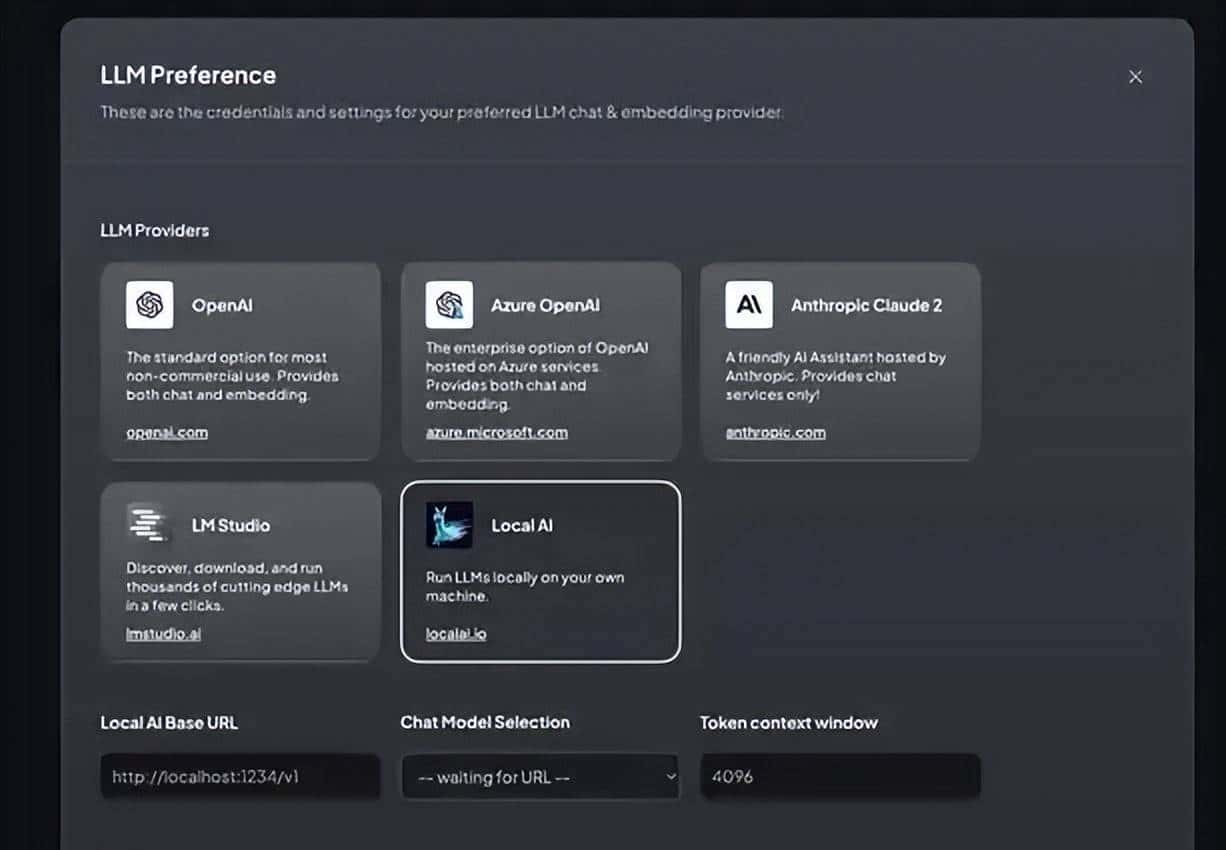

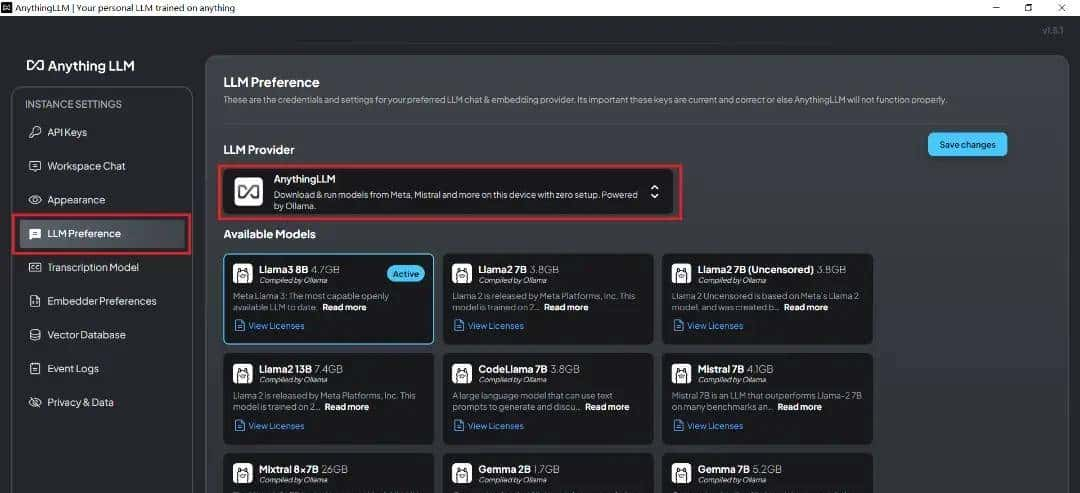

- 在AnythingLLM中跳过初始化配置,进入主页。选取和配置大模型,连接使用ollama。

- 当然,也可直接anythingLLM中直接下载和使用可提供支持的大模型,这里选择使用ollama负责模型的下载管理。需要注意的是,在连接ollama之前,需要先运行和启动ollama服务,并提前下载好大模型,这里事先已经拉取了llama2-chinese、llama3和qwen,因此出目前下拉列表中。在这里,我们选择使用llama2-chinese模型。

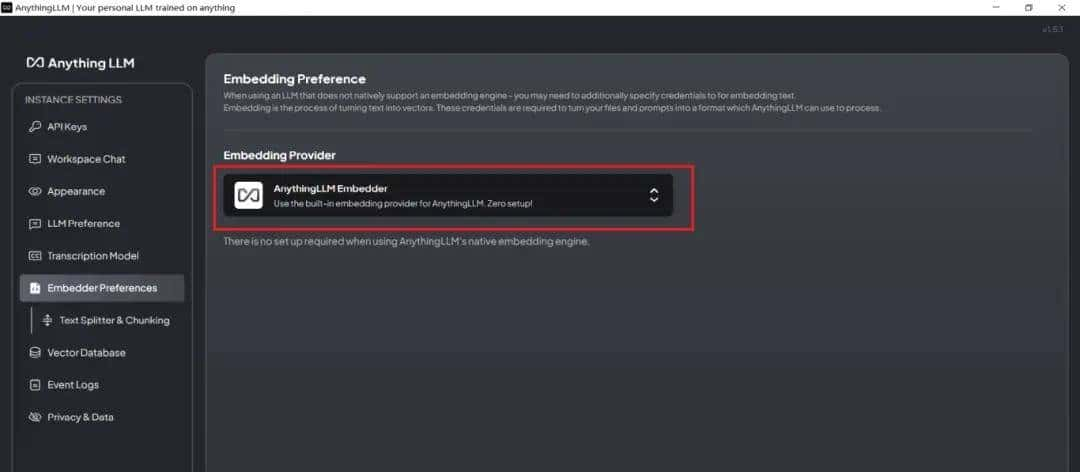

- 选择配置embedding模型,在Embedding Provider中,选择默认的AnythingLLM Embedder。

- 选择向量数据库,返回主页,新建工作区,配置知识库,为便于知识库分类管理,建立一个新的文件夹。点击文件上传。当然,anythingLLM也支持在线网页解析。点击刚上传的文档,选择“Move to Workspace”,并选择“Save and Embed”。

- 回到工作区,开始基于知识库,和大模型对话。可以提问题,获得答案,可以针对知识库内容,输出一个指定格式的文案等等。

原创内容输出

- 建立专属知识库(如心理治愈类,管理类,厨艺类,编程类,绘画书法等技艺类,生活哲理类,历史类,热点新闻类),将搜集到电子书,网页HTML文档,TXT,word,md文档投喂进去,解析。

- 在AnythingLLM主界面对话,输入要求,获得原创文章。

- 复制粘贴至新媒体平台,发布。

美好生活等着你

看会不等于会,实操一遍才算会,干起来吧!

【更多免费AI工具,请收藏关注】

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

您必须登录才能参与评论!

立即登录

为什么不直接anythingllm直接下载允许模型

下完了,怎么做

感谢分享👏

收藏了,感谢分享