数据中台与区块链技术结合:确保数据可信共享

关键词:数据中台、区块链、可信共享、数据治理、分布式账本、隐私保护、数据确权

摘要:在数字化时代,企业和机构面临“数据孤岛”与“信任缺失”两大难题:数据分散在各个系统中无法高效共享,而共享时又担心数据被篡改或滥用。本文将带您探索“数据中台”与“区块链”这对“信任CP”——数据中台负责整合、治理和服务数据,区块链负责记录和验证数据的“一生”。通过两者的结合,我们能打造一个“数据来源可追溯、共享过程可验证、操作记录不可篡改”的可信共享平台,让数据真正成为企业的“数字石油”。

背景介绍

目的和范围

今天,“数据驱动决策”已成为企业共识,但实际中,数据却像被锁在不同“抽屉”里的文件:财务部有财务系统数据,销售部有CRM数据,生产部有MES数据……这些“数据孤岛”导致企业无法全局分析,更无法与外部伙伴安全共享数据。即使勉强共享,也常因“数据是否被篡改”“谁该为数据负责”等问题陷入信任危机。

本文将聚焦“数据中台”与“区块链”的结合方案,覆盖以下范围:

数据中台如何解决“数据孤岛”问题?区块链如何解决“信任缺失”问题?两者结合的技术原理与实际应用场景。

预期读者

本文适合以下人群阅读:

企业IT负责人(想解决数据共享难题)数据工程师(想了解数据治理与新技术结合)区块链开发者(想探索区块链在企业级场景的应用)对数字化转型感兴趣的管理者(想理解技术如何驱动业务)

文档结构概述

本文将从“核心概念”入手,用生活案例解释数据中台和区块链;接着分析两者的“互补关系”,用“快递运输”类比数据共享流程;然后通过技术原理、代码示例、实战案例,展示如何落地;最后探讨未来趋势与挑战。

术语表

核心术语定义

数据中台:企业级数据管理平台,负责数据整合(把分散数据“搬”到一起)、治理(清洗、标准化数据)、服务(提供API供业务使用)。区块链:分布式账本技术,通过“区块+链”结构存储数据,每个区块包含前一个区块的哈希值,确保数据不可篡改。可信共享:数据在共享过程中,接收方可以验证数据来源、完整性和操作记录的真实性。

相关概念解释

数据孤岛:不同系统/部门的数据无法互通(如Excel表格、ERP系统、OA系统的数据独立存储)。哈希值:类似“数据指纹”,输入任意长度数据,输出固定长度的唯一值(如“你好”的哈希可能是

a1b2c3

核心概念与联系

故事引入:小明的“零食共享计划”

小明是班级零食小达人,家里有薯片、巧克力、果冻等各种零食,但都放在不同的盒子里(像企业的“数据孤岛”)。他想和同学共享零食,但遇到两个问题:

同学不知道他有哪些零食(数据未整合,无法高效共享);同学担心他偷偷替换过期零食(数据不可信,信任缺失)。

后来,小明做了两件事:

买了一个大柜子(数据中台),把所有零食分类摆放、贴标签(数据整合与治理);和同学约定:每次拿零食时,大家一起在黑板上记录“谁拿了什么、什么时候拿的”(区块链:分布式记账,不可篡改)。

从此,同学们既能快速找到想吃的零食(数据高效共享),又能通过黑板记录验证零食来源(数据可信)。

核心概念解释(像给小学生讲故事一样)

核心概念一:数据中台——企业的数据“大柜子”

数据中台就像小明的大柜子,作用是:

整合:把分散在各个系统的数据(像不同盒子的零食)集中到一起;治理:给数据“贴标签”(标注来源、格式)、“打扫卫生”(删除重复、错误数据);服务:提供“零食清单”(API接口),让业务部门(同学)直接拿需要的数据(零食)。

核心概念二:区块链——班级的“黑板记账本”

区块链就像小明和同学共用的黑板,特点是:

分布式:每个同学都有一份黑板的复印件(每个节点存储完整数据);不可篡改:要修改黑板上的记录,必须说服所有同学一起改(修改需多数节点同意);可追溯:从第一行记录开始,每一条都写着“上一条记录的指纹”(区块包含前一区块哈希值),能查到数据的“一生”。

核心概念三:可信共享——数据的“快递追踪单”

可信共享就像网购时的快递追踪单,能回答:

数据从哪里来?(发货地)数据被谁改过?(经过哪些网点)数据现在完整吗?(是否被拆包)

核心概念之间的关系(用小学生能理解的比喻)

数据中台与区块链的关系:一个“整理零食”,一个“记录拿零食”

数据中台负责“整理零食”(整合、治理数据),让大家能快速找到需要的数据;区块链负责“记录拿零食”(存储数据操作日志),让大家能验证数据是否被篡改;两者结合后,就像“大柜子+黑板”:既能高效共享数据,又能确保数据可信。

数据中台与可信共享的关系:“零食清单”是共享的前提

数据中台生成的“零食清单”(标准化数据)是可信共享的基础——如果零食没分类、没贴标签(数据混乱),即使有黑板记录(区块链),大家也不知道拿的是什么。

区块链与可信共享的关系:“黑板记录”是信任的保障

区块链的“黑板记录”(不可篡改的操作日志)是可信共享的保障——即使有人偷偷改了零食(篡改数据),黑板上的记录也能暴露他(通过哈希值验证数据完整性)。

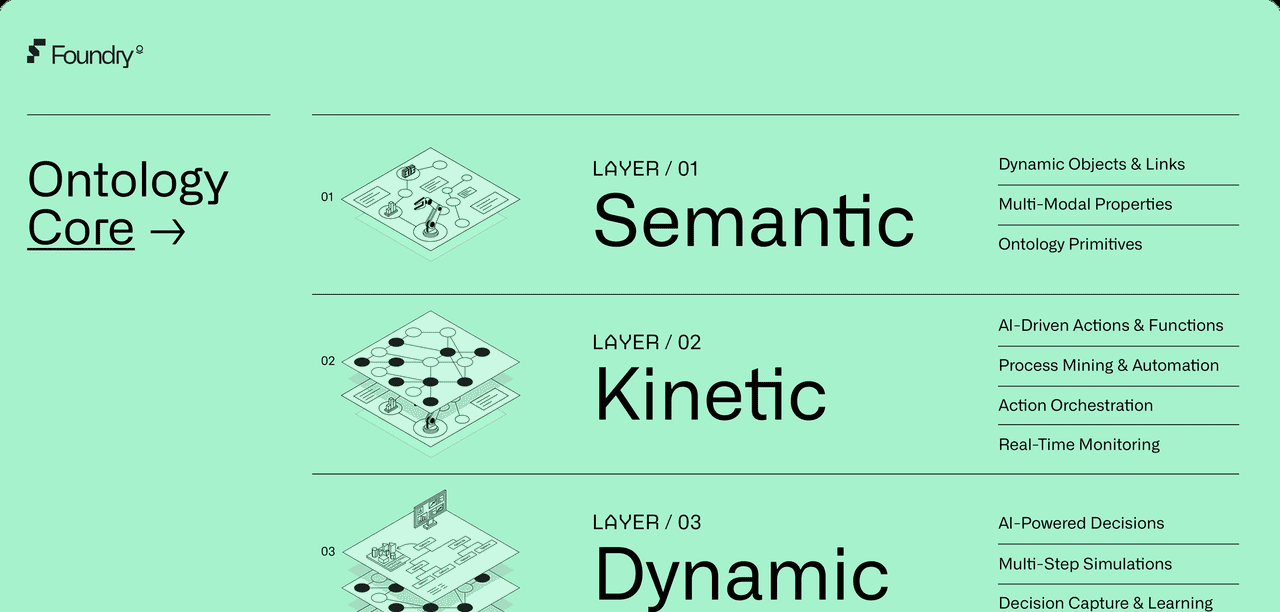

核心概念原理和架构的文本示意图

数据中台与区块链结合的架构可简化为:

数据源(业务系统) → 数据中台(整合、治理) → 区块链(存证、验证) → 数据使用方(业务应用)

数据源:企业内部系统(如ERP、CRM)或外部数据(如第三方API);数据中台:通过ETL(抽取-转换-加载)工具整合数据,用数据治理规则清洗、标准化数据;区块链:对数据的“元信息”(如数据ID、哈希值、操作时间、操作人)上链存证;数据使用方:通过API调用数据,同时通过区块链验证数据的来源和完整性。

Mermaid 流程图

graph TD

A[数据源系统] --> B[数据中台]

B --> C[数据治理(清洗/标准化)]

C --> D[生成数据哈希值]

D --> E[区块链存证(哈希+操作日志)]

E --> F[数据使用方(业务应用)]

F --> G[验证数据(对比链上哈希)]

核心算法原理 & 具体操作步骤

区块链如何保证数据不可篡改?——哈希算法与链式结构

区块链的核心是“区块+链”结构,每个区块包含:

区块头:前一个区块的哈希值、当前区块的时间戳、当前区块的哈希值;区块体:具体的数据操作记录(如“用户A在2023-10-1读取了数据X”)。

关键算法:哈希函数

哈希函数(如SHA-256)的特点是:

输入敏感:输入数据改动1位,输出哈希值完全改变(如“你好”的哈希是

a1b2c3

d4e5f6

a1b2c3

操作步骤:数据上链存证

数据中台生成标准化数据(如清洗后的用户订单数据);计算数据的哈希值(如

hash(data) = abc123

数据中台如何整合数据?——ETL与数据治理

数据中台的核心是ETL(Extract-Transform-Load)流程:

抽取(Extract):从不同数据源(如MySQL、Excel、API)读取数据;转换(Transform):清洗(删除重复数据)、标准化(统一日期格式为“YYYY-MM-DD”)、关联(将订单数据与用户数据关联);加载(Load):将处理后的数据存入数据仓库或数据湖,供业务使用。

代码示例(Python模拟数据清洗与哈希计算)

import hashlib

import pandas as pd

# 模拟数据源:两个Excel文件(订单数据和用户数据)

order_data = pd.read_excel("orders.xlsx")

user_data = pd.read_excel("users.xlsx")

# 数据清洗:删除订单数据中的重复行

clean_orders = order_data.drop_duplicates()

# 数据标准化:将用户数据的“注册时间”转为统一格式

user_data["注册时间"] = pd.to_datetime(user_data["注册时间"], format="%Y/%m/%d")

# 数据关联:通过“用户ID”合并订单与用户数据

merged_data = pd.merge(clean_orders, user_data, on="用户ID", how="left")

# 计算合并后数据的哈希值(模拟上链存证)

def calculate_hash(data):

# 将数据转为字符串,避免格式问题

data_str = data.to_json(orient="records")

# 使用SHA-256计算哈希

return hashlib.sha256(data_str.encode()).hexdigest()

data_hash = calculate_hash(merged_data)

print(f"数据哈希值:{data_hash}")

代码解读:

drop_duplicates()

pd.to_datetime()

pd.merge()

calculate_hash()

数学模型和公式 & 详细讲解 & 举例说明

哈希函数的数学性质

哈希函数可表示为:

( M ) 是任意长度的输入数据(如字符串、文件);( {0,1}^n ) 是固定长度的二进制输出(如SHA-256的( n=256 ))。

碰撞抵抗性:对于任意两个不同的输入 ( m_1

eq m_2 ),很难找到 ( H(m_1) = H(m_2) )。

例如:若 ( m_1 = ext{“数据1”} ),( m_2 = ext{“数据2”} ),则 ( H(m_1)

eq H(m_2) ) 的概率几乎为100%。

单向性:已知 ( H(m) ),无法计算出 ( m )。

例如:已知 ( H(m) = ext{“a1b2c3…”} ),无法反向推导出原始数据 ( m ) 是“用户订单123”。

区块链的链式结构数学表达

每个区块 ( B_i ) 包含前一个区块的哈希值 ( H(B_{i-1}) ),因此:

若有人篡改区块 ( B_i ) 中的数据,会导致 ( H(B_i) ) 改变,而区块 ( B_{i+1} ) 包含 ( H(B_i) ),因此 ( B_{i+1} ) 的哈希也会改变,最终整条链的哈希值都会断裂(如下图):

| 区块 | 前一区块哈希 | 当前区块数据 | 当前区块哈希 |

|---|---|---|---|

| ( B_1 ) | – | 初始数据 | ( H_1 ) |

| ( B_2 ) | ( H_1 ) | 数据A | ( H_2 ) |

| ( B_3 ) | ( H_2 ) | 数据B | ( H_3 ) |

若篡改 ( B_2 ) 的“数据A”为“数据A’”,则 ( H_2 ) 变为 ( H_2’ ),但 ( B_3 ) 的“前一区块哈希”仍是 ( H_2 ),导致 ( B_3 ) 与 ( B_2 ) 不匹配,链断裂。

项目实战:企业间数据共享平台开发

开发环境搭建

我们以“供应链数据共享”场景为例,搭建一个简化版平台,需要以下工具:

数据中台工具:Apache Spark(数据清洗)、Hive(数据存储);区块链平台:Hyperledger Fabric(企业级联盟链,支持权限管理);开发语言:Python(数据处理)、Go(智能合约开发);数据库:MySQL(存储元数据)。

源代码详细实现和代码解读

步骤1:数据中台清洗数据(Python)

from pyspark.sql import SparkSession

# 初始化Spark会话(模拟数据中台的计算能力)

spark = SparkSession.builder.appName("SupplyChainDataCleaning").getOrCreate()

# 读取供应链数据(采购单、物流单、销售单)

purchase_df = spark.read.csv("purchase.csv", header=True)

logistics_df = spark.read.csv("logistics.csv", header=True)

sales_df = spark.read.csv("sales.csv", header=True)

# 数据清洗:删除缺失“订单ID”的行

clean_purchase = purchase_df.filter(purchase_df["订单ID"].isNotNull())

clean_logistics = logistics_df.filter(logistics_df["订单ID"].isNotNull())

clean_sales = sales_df.filter(sales_df["订单ID"].isNotNull())

# 数据关联:通过“订单ID”合并三张表

merged_df = clean_purchase.join(clean_logistics, "订单ID", "left")

.join(clean_sales, "订单ID", "left")

# 计算数据哈希(用于上链)

def compute_hash(row):

row_str = ",".join([str(row[col]) for col in row.__fields__])

return hashlib.sha256(row_str.encode()).hexdigest()

# 为每条数据添加哈希列

merged_with_hash = merged_df.rdd.map(lambda row: (row, compute_hash(row))).toDF(["data", "hash"])

步骤2:区块链存证(Hyperledger Fabric智能合约)

智能合约(用Go语言编写)负责:

接收数据哈希、操作时间、操作人;将记录写入区块链;提供查询接口,验证数据哈希是否存在。

package main

import (

"github.com/hyperledger/fabric-contract-api-go/contractapi"

)

// 定义智能合约结构体

type DataContract struct {

contractapi.Contract

}

// 定义数据存证结构体(上链的记录)

type DataRecord struct {

DataHash string `json:"dataHash"` // 数据哈希值

Operator string `json:"operator"` // 操作人(如企业A)

Timestamp string `json:"timestamp"` // 操作时间(如2023-10-01 12:00:00)

}

// 存证方法:将数据记录写入区块链

func (c *DataContract) SaveRecord(ctx contractapi.TransactionContextInterface, dataHash string, operator string, timestamp string) error {

record := DataRecord{

DataHash: dataHash,

Operator: operator,

Timestamp: timestamp,

}

recordBytes, _ := json.Marshal(record)

// 使用数据哈希作为键,确保唯一性

return ctx.GetStub().PutState(dataHash, recordBytes)

}

// 查询方法:根据哈希值查询记录

func (c *DataContract) GetRecord(ctx contractapi.TransactionContextInterface, dataHash string) (*DataRecord, error) {

recordBytes, err := ctx.GetStub().GetState(dataHash)

if err != nil {

return nil, err

}

if recordBytes == nil {

return nil, fmt.Errorf("记录不存在")

}

var record DataRecord

json.Unmarshal(recordBytes, &record)

return &record, nil

}

func main() {

dataContract := new(DataContract)

if err := contractapi.Run(dataContract); err != nil {

panic(err)

}

}

步骤3:数据使用方验证(Python调用区块链接口)

import requests

def verify_data_hash(data_hash):

# 调用Hyperledger Fabric的API查询链上记录

response = requests.get(f"http://fabric-node:8080/query?hash={data_hash}")

if response.status_code == 200:

record = response.json()

return f"数据可信!操作人:{record['operator']},时间:{record['timestamp']}"

else:

return "数据不可信或未上链"

# 假设数据使用方(企业B)拿到了数据和哈希值

sample_hash = "a1b2c3d4..."

result = verify_data_hash(sample_hash)

print(result) # 输出:“数据可信!操作人:企业A,时间:2023-10-01 12:00:00”

代码解读与分析

数据中台部分:使用Spark清洗和关联数据,确保共享的数据是“干净、完整”的;区块链部分:智能合约定义了数据存证和查询的规则,确保只有授权方(如供应链成员)能操作;验证部分:数据使用方通过哈希值查询链上记录,确认数据来源和操作记录的真实性。

实际应用场景

场景1:医疗数据共享

医院之间需要共享患者病历,但担心数据被篡改。通过数据中台整合患者在不同医院的检查报告(如CT、血常规),用区块链记录“某医院在某时间读取了患者X的病历”,患者可通过链上记录查看哪些医生访问过自己的数据,确保隐私。

场景2:金融风控数据共享

银行需要共享“失信用户”数据,但担心泄露商业机密。数据中台将用户的逾期记录、贷款金额等数据脱敏(隐藏姓名、身份证号),区块链记录“某银行在某时间查询了用户Y的风控数据”,确保数据使用可追溯。

场景3:供应链溯源

消费者想知道“这盒牛奶从哪来的”。数据中台整合牧场(挤奶时间)、工厂(加工时间)、物流(运输路径)的数据,区块链记录每个环节的操作(如“牧场A在8:00挤奶”“工厂B在10:00加工”),消费者扫描牛奶盒上的二维码,即可查看全流程记录。

工具和资源推荐

数据中台工具

阿里云DataWorks:提供一站式数据整合、治理、开发工具,支持可视化ETL流程设计。华为FusionInsight:基于Hadoop的大数据平台,适合企业自建数据中台。Apache Airflow:开源工作流调度工具,可用于管理数据清洗任务。

区块链工具

Hyperledger Fabric:企业级联盟链,支持权限管理和隐私保护,适合金融、医疗等敏感场景。Polygon:以太坊Layer 2解决方案,适合需要高吞吐量的共享场景(如供应链)。Truffle:区块链开发框架,支持智能合约编译、测试和部署。

学习资源

书籍:《数据中台实战》(钟华)、《区块链:从技术到商业的区块链革命》(张健);课程:Coursera《Blockchain Basics》、极客时间《数据中台36讲》;社区:Hyperledger官方文档、Apache Spark中文社区。

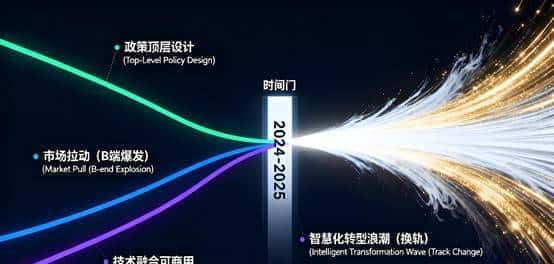

未来发展趋势与挑战

趋势1:与隐私计算结合,解决“数据可用不可见”

当前数据共享仍需暴露部分数据(如脱敏后的字段),未来可能结合联邦学习(在不传输原始数据的情况下训练模型)和同态加密(在加密数据上直接计算),实现“数据不出域,价值可流通”。

趋势2:边缘计算+数据中台,实时共享更高效

随着物联网设备增多(如工厂传感器、物流车辆GPS),数据产生速度加快。未来数据中台可能与边缘计算结合(在设备端做初步清洗),减少数据传输延迟,区块链则记录边缘计算的操作日志,确保实时数据可信。

挑战1:性能瓶颈

区块链的“共识算法”(如PBFT需要节点间通信)会导致延迟,数据中台处理海量数据时也需要高计算资源。如何平衡“可信”与“效率”是关键。

挑战2:监管合规

数据共享涉及隐私保护(如GDPR、《个人信息保护法》),区块链的“不可篡改”特性可能与“数据可删除权”冲突。未来需要设计“可管理的区块链”(如允许在合规情况下删除部分记录)。

总结:学到了什么?

核心概念回顾

数据中台:企业的数据“大柜子”,负责整合、治理、服务数据;区块链:分布式“黑板记账本”,负责记录数据操作日志,确保不可篡改;可信共享:通过数据中台“整理数据”+区块链“记录日志”,实现数据来源可追溯、操作可验证。

概念关系回顾

数据中台是“共享的基础”(没有整理好的数据,共享无意义);区块链是“信任的保障”(没有记录日志,共享无信任);两者结合后,就像“整理零食的柜子”+“记录拿零食的黑板”,让数据共享既高效又可信。

思考题:动动小脑筋

假设你是一家连锁超市的IT负责人,想和供应商共享“商品销售数据”,你会如何用数据中台和区块链设计共享方案?需要考虑哪些隐私保护问题?区块链的“不可篡改”特性可能导致错误数据无法修正(如员工误操作上传了错误数据),你能想到哪些解决方案?

附录:常见问题与解答

Q1:数据中台和数据仓库有什么区别?

A:数据仓库是“存储数据的地方”,而数据中台是“处理和服务数据的平台”。数据中台包含数据仓库,但多了数据治理(清洗、标准化)和数据服务(API输出)功能。

Q2:区块链会存储完整数据吗?

A:通常不会。区块链存储的是“数据哈希+操作日志”,原始数据仍存在数据中台或数据库中。这样既节省区块链存储空间,又能通过哈希验证数据完整性。

Q3:中小企业需要数据中台吗?

A:如果企业数据量小(如年数据量<100GB),可能不需要复杂的数据中台,用BI工具(如Tableau)即可。但如果数据分散且需要频繁共享(如连锁企业、跨部门协作),数据中台能显著提升效率。

扩展阅读 & 参考资料

《数据中台:让数据用起来》(阿里巴巴数据中台团队)Hyperledger Fabric官方文档:https://hyperledger-fabric.readthedocs.io/国家标准《数据管理能力成熟度评估模型(DCMM)》论文《Blockchain for Data Sharing in Industrial Internet of Things》(IEEE,2021)

相关文章