老黄一讲话,英伟达市值又创了新高,历史上第一个市值突破5万亿美元的公司。

量子计算为啥突然和 GPU 扯上关系?

实则量子计算和 GPU 没啥 “天生绑定” 的关系 ——GPU 不是量子计算机的核心零件,也不能替代量子比特干活。但目前量子计算还没成熟,刚好遇到了一堆 “麻烦事”,而 GPU 的特长刚好能解决这些麻烦,所以俩人才成了现阶段的 “好搭档”。

先搞懂:量子计算目前的 “麻烦” 在哪?

要理解 GPU 的作用,得先知道量子计算目前的 “短板”。咱们不用讲复杂公式,就记住两个关键点:

量子比特是 “玻璃心”,一用就出错

量子计算的核心是 “量子比特”,但它特别娇贵 —— 温度稍微不对、有点电磁干扰,甚至旁边有人走路震动,它的状态就会乱掉(这叫 “退相干”)。目前最先进的量子计算机,也只能让量子比特稳定几十到几百微秒,而且每一步计算都可能出错。

为了抵消错误,科学家得搞 “量子纠错”:用十几个甚至上百个 “物理量子比特”,去模拟一个 “逻辑量子比特”(相当于用一堆保镖保护一个 VIP)。但这会产生海量的实时数据—— 列如要实时监测每个物理量子比特的状态,判断有没有错、怎么纠正,这些数据得瞬间处理完,不然纠错就来不及了。

真正的量子计算机还太弱,许多实验得 “先模拟”

目前的量子计算机(叫 “NISQ 设备”,简单说就是 “没完全成熟的过渡款”),量子比特数量最多也就几百个,还没法跑复杂的算法(列如破解密码、模拟新药分子)。

那科学家怎么测试新算法?只能先在传统计算机上 “模拟量子计算” —— 列如用传统芯片搭建一个 “虚拟的量子计算机”,先在上面试算法好不好用、有没有 bug,再拿到真量子计算机上跑。但模拟量子系统特别费劲儿:模拟一个 50 个量子比特的系统,需要的计算量就超过全球超算的总和,普通 CPU 根本扛不住。

GPU 的 “超能力”,刚好能解决量子计算的麻烦

GPU 本来是为玩游戏、做动画设计的 —— 它擅长 “并行计算”,简单说就是 “能同时干几百上千件类似的小事”(列如同时处理一张图片里的所有像素),而 CPU 更擅长 “干一件复杂的大事”。

这刚好戳中了量子计算现阶段的两个痛点,所以 GPU 就成了 “得力帮手”,具体帮两件核心的事:

1. 帮科学家 “模拟量子计算机”,省时间省成本

刚才说过,模拟量子系统需要海量计算,CPU 跑起来慢得像蜗牛。而 GPU 的并行计算能力,能把模拟速度提几十甚至上百倍 —— 列如以前用 CPU 模拟 30 个量子比特的系统要几天,用 GPU 可能几小时就搞定了。

举个实际例子:谷歌、IBM 在研发量子算法时,都会先用 GPU 集群(一堆 GPU 连起来)模拟量子计算机的运行。列如测试 “量子化学模拟”(用量子计算预测分子反应),先在 GPU 上把算法调通,再拿到真量子计算机上验证,这样能少走许多弯路,不用浪费珍贵的量子比特运行时间。

2. 帮量子计算机 “实时纠错”,不让计算跑偏

前面说过,量子纠错需要处理海量实时数据 —— 列如每微秒要读取几十个物理量子比特的状态,判断有没有错,再生成 “纠正信号”(列如调整激光或微波的强度)。

这个过程要求 “毫秒级甚至微秒级响应”,CPU 根本来不及处理这么多并行数据。而 GPU 能同时处理多个量子比特的监测数据,瞬间算出纠错方案,相当于给量子计算机装了一个 “快速反应的纠错大脑”。列如 IBM 的量子纠错实验中,就用 GPU 来实时处理物理量子比特的读取数据,让纠错延迟从毫秒级降到了微秒级。

3. 帮量子计算机 “调参数”,让计算更稳定

除了纠错和模拟,GPU 还能帮量子计算机 “优化控制”。列如控制量子比特的激光、微波信号,需要精准的参数(列如频率、强度、持续时间),这些参数如果设得不对,量子比特就容易出错。

科学家会用 GPU 跑 “优化算法”:快速测试成千上万组参数,找到让量子比特最稳定、计算错误最少的那组。列如美国的量子公司 Rigetti,就用 GPU 来优化量子比特的控制信号,让量子计算的错误率降低了 30% 以上。

别搞错!GPU 不是量子计算的 “核心”,只是 “临时搭档”

这里必须澄清一个误区:GPU 不是量子计算的 “必需品”,更不是未来量子计算机的 “核心部件”—— 它只是 “现阶段的过渡工具”。

打个比方:就像你想盖一栋 100 层的大楼(量子计算成熟形态),但目前只有盖 10 层楼的技术(NISQ 设备)。GPU 就像 “挖掘机和起重机”,帮你先挖地基、搭脚手架、测试建材强度(模拟和纠错),但等大楼真的盖起来了,挖掘机就用不上了。

未来如果量子比特能做到 “零错误”(不用纠错),而且数量足够多(列如上百万个),那可能就不需要 GPU 帮忙了 —— 但这个过程至少还要 10-20 年,所以目前 GPU 和量子计算的 “合作”,会一直是研发的核心环节。

举个真实案例:英伟达怎么用 GPU 帮量子计算

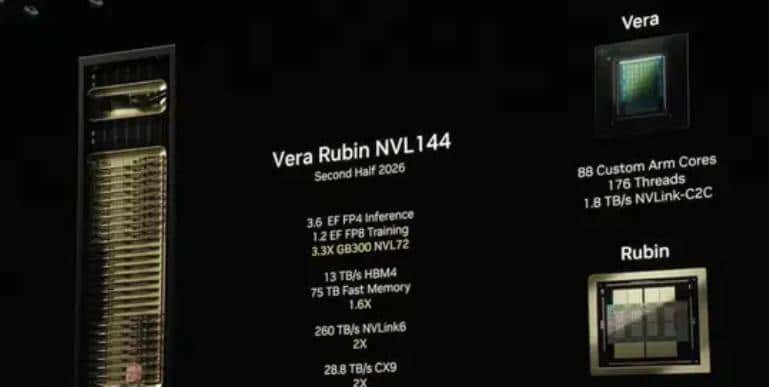

英伟达(GPU 领域的龙头)是最积极的玩家之一,它做了两件事,能更直观看到 GPU 的作用:

- 推出 “量子模拟工具包”(列如 CUDA Quantum):科学家不用自己写复杂的并行计算代码,直接用这个工具包,就能在 GPU 上模拟量子算法,速度比 CPU 快 100 倍以上。

- 和量子公司合作搞 “混合计算”:列如把 GPU 和量子计算机连起来 —— 简单的计算和纠错交给 GPU,复杂的量子运算交给量子比特,两者配合。列如在模拟新药分子时,GPU 先处理分子的基础数据,再把核心的量子计算部分传给量子计算机,最后 GPU 再把量子计算的结果整理成科学家能看懂的图表。

总结:GPU 和量子计算的关系,就像 “创业初期的合伙人”

量子计算的终极目标,是用量子比特直接解决传统计算机解决不了的问题,而 GPU 只是 “帮它度过创业初期的帮手”—— 帮它模拟实验、处理纠错数据、优化参数,让它能更快成熟。

等未来量子计算真的 “长大” 了(列如实现百万级逻辑量子比特、零错误),GPU 可能就会从 “核心帮手” 变成 “辅助工具”,但至少目前,没有 GPU 的帮忙,量子计算的研发速度会慢许多。

老黄利用量子伪科技在耍猴呢

量子的不确定性理论已经否定了所谓量子计算机,量子回声不是计算机,只是一种自然现象,没有任何用处!