📚论文标题:HAIC: Improving Human Action Understanding and Generation with Better Captions for Multi-modal Large Language Models

🎥发表会议:ACL2025

🏗️作者单位:哈尔滨工业大学(深圳)、快手科技

🔬论文链接:https://ieeexplore.ieee.org/stamp/stamp.jsp?tp=&arnumber=10658097&tag=1

🔧数据集地址:https://huggingface.co/datasets/KuaishouHAIC/HAIC

一、任务背景

多模态大语言模型在视频理解任务中展现出卓越能力,但人类动作理解仍然是重要挑战。

| 问题 | 具体表现 | |

|---|---|---|

| 通用视频描述数据集 | 动作描述粗糙 | 仅提供概括性描述,缺乏细节 |

| 单一人体动作数据集 | 场景单一 | 主要关注单人场景,忽略多人互动 |

| 群体活动数据集 | 描述一致性过强 | 仅描述”一群人进行某种活动” |

核心问题:缺乏能够清晰区分不同个体、按时间顺序详细描述每个人身体动作和互动的标准化标注格式。

二、创新贡献

创新两阶段数据标注流程:结合视频自动积累和标准化标注格式

高质量数据集:提供126K训练样本和综合评估基准

实证有效性:在理解和生成任务上均展示显著性能提升

三、两阶段数据标注方法

阶段一:🔍 动作视频积累

目标:从大规模视频中筛选出包含清晰、有意义的人类动作且细节丰富的视频

关键策略:

元数据过滤:使用 spaCy 工具丢弃低分辨率视频以及其描述中不包含动词的视频,使用SceneDetect将视频分割为独特场景的短片段,只保留5 到 20 秒的片段

人类存在过滤:从每个片段均匀采样16帧,使用RTMPose目标检测器识别人类

人类动作过滤:使用RTMPose检测人类边界框和17个身体关键点,基于帧间最大IoU构建人物轨迹,确保相邻关键点之间的L1距离大于0.085

筛选结果:仅有约1%的视频满足质量要求,体现了高度选择性。

阶段二:📍标注格式设计

标准化标注格式特点:

使用人类属性来区分不同个体

按时间顺序标注每个人的详细身体动作和互动

分别描述每个主体的属性和行为序列

所有标注者接受一周培训

每个视频先由1名标注者标注,然后由另外3名标注者检查并补充遗漏点

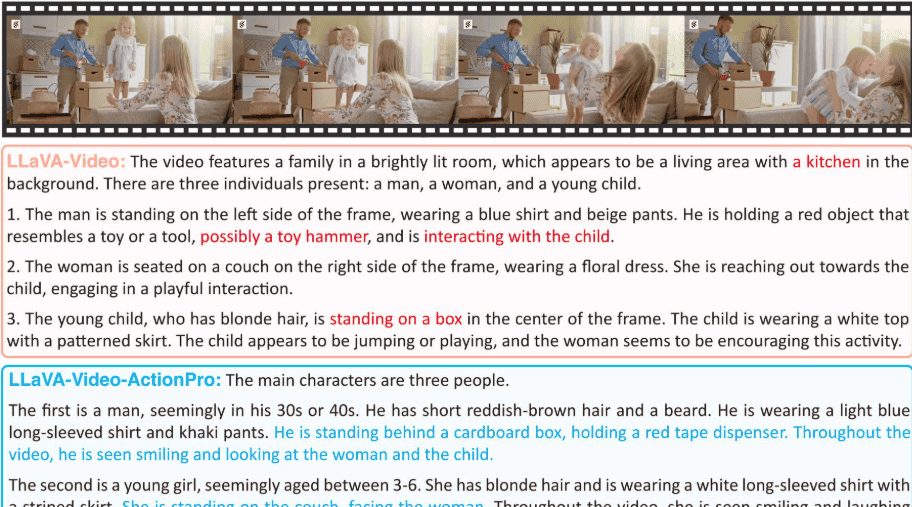

标注格式对比示例

| 标注类型 | 描述特点 | 详细程度 |

|---|---|---|

| MSR-VTT | “两个男人在舞台上拳击” | 高度概括 |

| LLaVA-Video | 描述场景、服装、整体动作 | 中等细节 |

| HAIC格式 | 分别描述每个主体的属性、初始姿态、具体动作序列 | 细粒度细节 |

标注的示例

HAIC: The main characters are two people.

The first subject is a middle-aged man, wearing purple boxing shorts with black and green patterns and white letters, and black and red boxing gloves. Initially, he faces his opponent in an attacking stance, then bends down and rushes towards Subject 2, throwing a punch. After Subject 2 dodges, he chases Subject 2 and throws five right hooks.

The second subject is a middle-aged man, wearing black boxing shorts with green patterns and white letters, and black and blue boxing gloves. Initially, he faces Subject 1, then he bends down to dodge Subject 1's attack, stumbles, and is chased and punched by Subject 1. Finally, he straightens up, puts his hands over his head, breaks away from the aack, and the two confront each other.

四、实验结论

4.1 HAIC训练数据集构成

📊数据源选择:选择WebVid-10M数据集作为训练视频源,因为它更加大规模、高质量

⚡构建流程:

应用动作视频积累管道从WebVid-10M收集动作视频

获得126000个视频(占原始数据集的1.2%)

使用Gemini-1.5-Pro生成标准化格式的描述

通过额外判断过滤不符合预定义格式或质量低的失败案例

4.2 HAICBench数据集

📊标注流程设计:采用LLM辅助的人工标注管道评估MLLMs在人类动作理解方面的能力

🏋️视频源选择:为避免与公共基准重叠,选择Omega多模态数据集作为基准视频源:

包含超过3000万个2分钟视频片段

通过视频积累阶段获得视频片段

手动检查获得1140个视频片段,共7548个问答对

4.3 问答对生成

🎯使用GPT-4o生成人类交互、动作细节、动作序列、计数、人类属性方面的多项选择问答对

4.4 实验结论

HAICTrain训练数据集具有有效性,LLaVA-Video-ActionPro-7B训练后,模型的人类动作理解能力得到显著提升

HAICBench全面覆盖人类动作理解的各个方面,表明大模型还有很多提升空间

高质量描述对文本到视频生成有益

4.5 问答示例

五、总结启发

📝总结

高质量的数据标注是提升多模态大语言模型在人类动作理解任务上性能的关键。

HAIC项目通过一个两阶段的数据标注流程,旨在解决现有数据集中动作描述粗糙、缺乏细粒度细节的问题。

🚀启发

多模态大模型对于视频更深层次的理解还有一定距离

细粒度的标注能够显著提升模型性能

能够使用大模型进行高效的人机协作标注数据

相关文章