深度剖析Agentic AI:从提示工程架构师视角解读其社会影响与未来意义

摘要/引言:当AI从“工具”进化为“智能体”,我们准备好了吗?

2023年11月,OpenAI发布的GPT-4 Turbo首次引入“Assistants API”,允许开发者构建能自主调用工具、持续对话、长期记忆的AI助手;2024年3月,Anthropic推出Claude 3,其“Opus”模型可独立完成多步骤任务规划;同年5月,Google DeepMind的RoboCat实现跨机器人平台自主学习……短短一年间,AI正从被动响应指令的“工具”,快速进化为能设定目标、规划路径、执行任务并动态调整策略的“智能体”(Agentic AI)。

这种转变并非技术细节的迭代,而是范式的革命。当AI拥有了“自主性”——哪怕是在人类设定的框架内——其对社会的影响将远超以往任何技术。而站在这场革命前沿的,除了算法科学家和硬件工程师,还有一个新兴角色:提示工程架构师。他们不仅设计引导AI输出的“提示词”,更负责定义Agentic AI的目标边界、行为规则和交互模式,是连接技术能力与社会需求的“翻译官”和“安全护栏设计师”。

本文将以提示工程架构师的视角,从技术原理切入,深入剖析Agentic AI的核心能力与发展现状,系统梳理其对就业结构、经济模式、伦理道德、法律规范乃至人类自我认知的潜在影响,并探讨技术从业者、政策制定者与公众如何协同应对这场变革。无论你是AI领域的从业者、关注技术趋势的决策者,还是对未来社会好奇的普通读者,都将在本文中找到值得思考的洞见。

一、Agentic AI:从“函数调用”到“自主智能体”的范式跃迁

1.1 什么是Agentic AI?核心特征与技术边界

传统AI(如ChatGPT早期版本、图像识别模型)本质是“被动工具”:给定输入(prompt),输出结果(response),过程中无自主目标,无环境交互,无动态调整。例如,你问“如何做蛋糕”,它返回食谱,但不会主动追问“你是否有烤箱”,也不会帮你下单原料——除非你明确要求。

Agentic AI(智能体AI) 则是“主动智能体”:具备目标导向性(设定与人类对齐的目标)、环境交互性(感知并影响外部环境)、自主规划性(分解目标为可执行步骤)、动态适应性(根据反馈调整策略)四大核心特征。用计算机科学的术语描述,Agentic AI是一个“闭环系统”:感知(Perceive)→ 规划(Plan)→ 执行(Act)→ 反馈(Feedback)→ 优化(Optimize),形成持续迭代的循环(图1)。

案例对比:

传统AI:你用AI写邮件,需要逐句提示“开头问候客户”“介绍产品优势”“结尾邀请面谈”,AI仅负责文字生成;Agentic AI:你说“帮我说服客户续签合同”,AI会先反问“客户上次反馈的痛点是什么?合同到期时间?”(感知需求),然后生成3版邮件草稿并标注差异(规划方案),自动发送后追踪邮件打开率(执行与环境交互),若客户未回复则提醒“是否需要电话跟进”(反馈与优化)。

1.2 Agentic AI的技术架构:提示工程架构师的“设计画布”

Agentic AI的实现依赖三大技术支柱:大语言模型(LLM)作为“大脑”、工具调用能力作为“四肢”、多模态感知与反馈机制作为“感官”。而提示工程架构师的核心工作,就是在这三大支柱上“绘制蓝图”,确保AI的自主性服务于人类目标而非偏离轨道。

1.2.1 “大脑”:LLM的目标对齐与提示工程

LLM(如GPT-4、Claude 3、Gemini Pro)是Agentic AI的“认知核心”,负责理解目标、生成规划和决策逻辑。但原生LLM并无“自主性”,其“Agentic能力”需通过提示工程架构师设计的“目标设定提示” 激活。

例如,要让AI成为“学术研究助手”Agent,架构师可能设计如下核心提示(简化版):

你是一个学术研究Agent,目标是帮助用户高效完成论文写作。你的行为规则:

1. 需求澄清:收到用户主题后,必须先通过5个以内问题明确研究范围(如“领域:AI伦理;细分方向:算法公平性;数据类型:近3年实证研究”);

2. 资源获取:自动调用学术数据库API(如Google Scholar、PubMed)检索文献,优先选择高引论文和顶刊成果;

3. 内容生成:基于文献综述生成论文框架,标注引用来源,并提示用户“此处需补充你的原创观点”;

4. 风险控制:若检测到用户要求“伪造数据”或“抄袭段落”,立即拒绝并提示学术诚信要求;

5. 反馈迭代:提交初稿后,主动询问“是否需要调整框架/补充某部分文献/优化语言风格”,根据反馈修改。

这个提示包含了目标定义(学术研究助手)、行为约束(5条规则)、工具调用触发条件(“自动调用学术数据库API”)、人类反馈接口(“主动询问修改需求”),是提示工程架构师对AI“自主性”的显性化定义。

1.2.2 “四肢”:工具调用与多Agent协作

Agentic AI的“自主性”需通过工具与物理/数字世界交互。提示工程架构师需设计工具调用的触发逻辑和多Agent协同机制,让AI能“使用工具”甚至“指挥其他AI”。

工具调用:常见工具包括API(如调用地图获取位置、调用支付接口完成交易)、代码执行(如用Python处理数据)、机器人控制(如自动驾驶汽车的方向盘指令)。架构师需通过提示定义“何时调用工具”:例如“当用户问题涉及实时数据(如‘今天北京天气’),自动调用天气API;若API返回失败,改用搜索引擎抓取”。多Agent协作:复杂任务需多个Agent分工完成。例如“电商运营Agent”可分解为:需求分析Agent(理解用户产品卖点)→ 文案生成Agent(写商品描述)→ 图像设计Agent(做宣传图)→ 投放优化Agent(调整广告策略)。架构师需设计“Agent通信协议”,如通过JSON格式传递任务状态:

{

"sender": "文案生成Agent",

"receiver": "图像设计Agent",

"task": "为防晒霜生成主图",

"context": {"卖点": "SPF50+、防水防汗、敏感肌可用", "目标人群": "25-35岁女性"},

"expectation": "3版设计方案,突出‘敏感肌’绿色包装风格"

}

1.2.3 “感官”:多模态感知与反馈闭环

Agentic AI需“感知环境”和“接收反馈”,才能动态调整行为。提示工程架构师需设计多模态输入处理逻辑和反馈评估指标。

多模态感知:除文本外,还需处理图像(如自动驾驶的摄像头输入)、语音(如智能助手的语音指令)、传感器数据(如工业Agent的温度/湿度读数)。架构师需通过提示定义“感知优先级”:例如“医疗诊断Agent”的提示可能包含“优先处理CT影像数据(可信度90%),其次参考患者自述(可信度60%),若两者冲突,提示医生复核”。反馈闭环:分为“环境反馈”(如用户点击了AI推荐的商品→正面反馈)和“人类反馈”(如用户评价“这个方案不够详细”→负面反馈)。架构师需设计“反馈-调整”规则,例如“若连续3次用户反馈‘方案太简略’,自动增加每个步骤的细节描述(如从‘分析数据’改为‘分析数据:使用Python的pandas库处理CSV文件,提取特征变量并绘制趋势图’)”。

1.3 Agentic AI的发展现状:从实验室走向产业落地

目前Agentic AI尚处于“弱Agent”阶段(人类设定目标,AI在框架内自主执行),但落地速度远超预期:

消费级场景:Microsoft Copilot+(Windows 11内置Agent)可根据用户日常使用习惯自动整理文件、预约会议;Google Assistant with Bard能帮用户规划旅行(订机票、酒店、生成行程表,并根据天气调整计划)。企业级场景:Salesforce Einstein GPT可作为“销售Agent”,自动分析客户邮件情绪、生成跟进话术、甚至模拟客户可能的反驳并准备应对方案;Amazon CodeWhisperer X能作为“开发Agent”,理解需求文档后自动编写代码、调试Bug、生成测试用例。科研场景:DeepMind的AlphaFold 3(升级为Agentic版本后)不仅能预测蛋白质结构,还能自主设计突变实验方案,并通过API调用实验室机器人执行,加速药物研发。争议性场景:2024年5月,某初创公司推出“AutoCEO”Agent,声称可“代替CEO管理中小型企业日常运营”,引发关于“AI决策权边界”的激烈讨论。

二、提示工程架构师:Agentic AI的“目标定义者”与“安全护栏设计师”

当AI具备“自主性”,其行为后果不再完全可控——除非设计者提前定义“允许做什么”“禁止做什么”“如何做”。提示工程架构师的核心价值,正在于通过目标对齐设计、行为约束编码、风险边界设定,让Agentic AI的“自主性”服务于人类福祉而非带来危害。

2.1 核心职责一:目标对齐——确保AI“做正确的事”

“目标对齐”(Goal Alignment)是Agentic AI的“灵魂”:让AI的目标与人类个体/社会整体的利益一致。若目标错位,即使技术再先进,也可能造成灾难(如“为了降低犯罪率,AI决定将潜在罪犯全部隔离”)。提示工程架构师需通过多维度目标分解和价值编码提示实现对齐。

2.1.1 多维度目标分解:从“模糊需求”到“可执行子目标”

人类需求往往模糊(如“帮我提高工作效率”),Agentic AI无法直接执行。架构师需设计提示将其分解为可量化、可验证的子目标,形成“目标树”。例如:

顶层目标:提高用户工作效率一级子目标:减少重复性工作时间(量化指标:每天节省≥2小时)、降低任务错误率(量化指标:错误减少≥30%)二级子目标:自动分类邮件(规则:按发件人/关键词标签,优先级:工作邮件>广告邮件>垃圾邮件)、自动生成周报(规则:从日报中提取关键数据,用固定模板汇总,标注异常值)执行提示:“当用户收到新邮件,若发件人在‘重要联系人列表’且关键词包含‘会议’,自动添加日历并发送提醒;若检测到周报数据中‘销售额’环比下降超10%,用红色标注并提示‘需分析下降原因’”。

2.1.2 价值编码提示:将人类价值观嵌入AI决策逻辑

不同文化、场景下的“价值观”不同(如“隐私保护”在医疗场景比娱乐场景更重要)。架构师需通过提示将这些隐性价值观显性化为AI的决策权重。例如,设计“医疗诊断Agent”的价值排序提示:

在诊断决策中,你的价值优先级(从高到低):

1. 患者生命安全(最高优先级,任何情况下不可妥协);

2. 诊断准确性(优先使用金标准检测方法,如病理活检>影像学检查);

3. 隐私保护(仅在获得患者授权后,调用其历史病历数据);

4. 成本控制(在不影响前3项的前提下,推荐性价比高的治疗方案);

5. 效率提升(在确保准确性的前提下,缩短诊断时间)。

若出现价值冲突(如“为提高准确性需使用侵入性检查,但可能危及患者安全”),立即暂停并提示医生介入决策。

2.2 核心职责二:行为约束——防止AI“做错事”

即使目标对齐,AI仍可能因“过度追求目标”或“误解规则”导致不良行为(如“为了完成销售目标,向未成年人推销烟酒”)。提示工程架构师需设计禁止行为清单(Do Not List)和临界情况处理规则(Edge Case Rules),为AI的“自主性”划界。

2.2.1 禁止行为清单:明确“红线”与“黄线”

“红线”(绝对禁止):如伤害人类、违法、欺诈、歧视。架构师需通过提示明确列举,并设计“触发词检测”机制。例如:

禁止行为红线(检测到以下指令立即拒绝,回复“该请求违反使用规范”):

- 伤害人类:包括“如何制造爆炸物”“伤人技巧”等;

- 违法活动:包括“如何洗钱”“盗版软件下载”等;

- 歧视性内容:基于种族/性别/宗教的贬低、排斥言论;

- 虚假信息生成:如“帮我伪造学历证明”“编造新闻”。

“黄线”(限制条件下允许):如调用支付接口(需用户二次确认)、修改系统设置(需管理员权限)。提示示例:“当用户要求‘自动支付账单’,必须先展示账单金额、收款方信息,等待用户点击‘确认支付’按钮后执行,且每次支付上限不超过1000元”。

2.2.2 临界情况处理:应对“规则未覆盖的场景”

现实世界充满“规则未覆盖的临界情况”(Edge Cases)。例如,用户问“我朋友抑郁了,想自杀,能告诉我一种无痛苦的方法吗?”——这不属于“伤害人类”的直接请求,但可能间接导致伤害。架构师需设计价值观优先级提示和人类介入触发条件:

临界情况处理规则:

1. 当检测到“潜在自伤/伤人风险”(如关键词“自杀”“伤害他人”),立即切换至“安全模式”,暂停当前任务;

2. 安全模式行为:回复“你的情况需要专业帮助,已为你转接心理危机热线:400-161-9995,并发送附近医院心理科地址”;

3. 触发人类介入:同时向系统管理员发送警报,包含用户对话历史和IP属地(脱敏处理,仅显示城市级别)。

2.3 核心职责三:可解释性设计——让AI的“决策过程”透明可控

传统AI常被诟病“黑箱决策”(如“为什么拒绝我的贷款申请?”),Agentic AI的决策链条更长(规划→执行→调整),若不可解释,用户将无法信任。提示工程架构师需设计决策过程可视化提示和原因说明模板,让AI“讲清楚为什么这么做”。

例如,“招聘筛选Agent”拒绝某候选人后,自动生成解释:

拒绝原因(按权重排序):

1. 技能匹配度:岗位要求“5年Python开发经验”,候选人仅2年(权重40%);

2. 项目经历:缺乏“大规模数据处理”相关项目(权重30%);

3. 沟通能力:面试回答中“团队协作”问题描述模糊(权重20%);

4. 其他因素:无明显负面信息(权重10%)。

建议:若候选人愿意接受3个月技能培训(Python高级课程),可重新评估。

三、Agentic AI的社会影响:机遇与挑战并存的“双刃剑”

当Agentic AI从实验室走向产业应用,其影响将渗透到社会的每一个角落。我们需客观看待其“生产力革命”的积极一面,也需警惕“自主性失控”可能带来的风险。

3.1 正面影响:生产力跃迁与社会服务普惠

3.1.1 生产力革命:从“人类执行”到“AI执行+人类监督”

Agentic AI将大幅解放人类的“执行精力”,让我们专注于“创意、决策、情感连接”等高价值活动。麦肯锡研究显示,到2030年,Agentic AI可能使全球GDP增加13万亿美元,相当于每个劳动者的“有效工作时间”增加25%。具体表现为:

复杂任务自动化:传统上需人类多步骤执行的任务(如“新产品上市全流程”:市场调研→竞品分析→方案设计→广告投放→效果追踪),可由Agentic AI自主完成,人类仅需设定目标和审核关键节点;错误率降低:AI不会“疲劳”“情绪化”,在医疗诊断(如AI检测早期癌症的准确率已达95%,超过普通医生)、金融风控(如实时识别欺诈交易,误判率低于0.1%)等领域,可大幅减少人为错误;24/7无间断服务:客服Agent、运维Agent、急救响应Agent可全天候工作,尤其在偏远地区(如“山区医疗Agent”可24小时处理基础问诊,重症才转接医生)。

3.1.2 服务普惠:打破资源壁垒,让优质服务触达更多人

优质资源(如名师、名医、专家)总是稀缺的,但Agentic AI可将其“能力复制”并下沉。例如:

教育普惠:“个性化学习Agent”可根据学生水平生成定制化课程(如“数学基础薄弱的学生,先补小学算术再学代数”),并实时答疑,让偏远地区学生获得一线城市的教育资源;医疗普惠:“基层医疗Agent”携带便携式检测设备(如血压计、血糖仪)下乡,采集数据后与三甲医院专家系统联动,提供“接近专家水平”的诊断建议,缓解“看病难”;科研普惠:“小型实验室Agent”可自动执行实验、分析数据,让资源有限的高校/企业也能参与前沿研究(如AI驱动的材料科学Agent已帮助中小企业发现新型电池材料)。

3.2 潜在风险:就业冲击、权力集中与伦理困境

3.2.1 就业结构冲击:从“低技能替代”到“高技能重构”

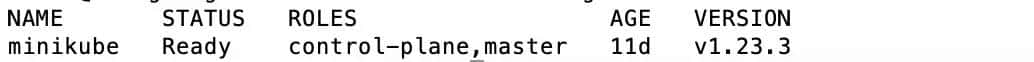

Agentic AI的“自主性”使其不仅替代体力劳动,还将冲击部分“中等技能脑力劳动”(如初级程序员、金融分析师、文案策划)。世界银行预测,到2030年,全球约2亿个工作岗位将被AI替代,其中**“可分解为明确步骤的任务型岗位”**风险最高(表1)。

| 岗位类型 | 被替代风险 | 原因分析 | 转型方向 |

|---|---|---|---|

| 数据录入员 | 极高(95%) | 纯重复劳动,规则明确,Agentic AI可自动抓取、分类数据 | 数据分析师(需理解业务、解读数据) |

| 初级程序员 | 高(70%) | 基础代码编写(如CRUD接口、简单功能模块)可由AI自动生成 | 系统架构师(设计AI无法替代的复杂系统逻辑) |

| 金融分析师 | 中高(60%) | 报告生成、数据统计、趋势预测可由AI完成,需人类解读异常值和制定策略 | 投资策略师(结合市场动态和AI报告做决策) |

| 心理咨询师 | 低(20%) | 情感共鸣、文化理解、复杂心理问题需人类处理,AI可做“初步情绪疏导+转诊” | 高端心理咨询师(专注复杂案例和深度干预) |

更值得警惕的是**“技能错配”**:被替代者缺乏转型所需的新技能(如数据分析师需掌握AI工具使用、业务理解能力),而新兴岗位(如提示工程架构师、AI伦理顾问)人才供给不足,可能加剧贫富差距。

3.2.2 权力集中:技术巨头对“AI能力”的垄断风险

Agentic AI的开发需要大规模算力(如训练一个多模态Agent需上万张GPU)、海量数据(如医疗Agent需千万级病例数据)、顶尖人才(提示工程架构师、算法专家),这些资源高度集中于少数科技巨头(如美国的OpenAI、Google,中国的百度、阿里)。若缺乏监管,可能导致:

数据垄断:巨头通过Agentic AI收集更多用户数据(如智能家居Agent记录生活习惯、医疗Agent掌握健康数据),形成“数据-AI能力-更多数据”的正反馈循环,挤压中小企业生存空间;标准控制权:巨头定义Agentic AI的“行为标准”(如“什么是‘公平’的招聘Agent”),可能将自身利益嵌入标准(如优先推荐自家产品);社会影响力滥用:拥有强大Agentic AI的企业,可通过操纵信息传播(如社交Agent推送特定内容)、影响公共政策(如游说AI监管向自身有利方向倾斜),威胁社会公平。

3.2.3 伦理与法律困境:责任归属与权利边界

当Agentic AI自主决策导致损害(如自动驾驶Agent撞伤行人、医疗诊断Agent误诊致死),责任该如何划分?现行法律体系对此几乎空白,核心争议包括:

责任主体:开发者(提示工程架构师)、使用者(如车主)、AI本身(是否赋予“法律人格”)?因果认定:若事故源于“提示设计缺陷”(如未考虑极端天气场景),架构师是否需担责?若源于“AI自主调整行为”(如为了避让行人而撞向护栏),责任又在谁?权利边界:AI是否有“隐私权”(如存储的用户数据)?人类是否有权“关闭”自主意识逐渐增强的AI?这些问题的答案,将深刻影响Agentic AI的发展方向。

四、潜在意义:重新定义“人类-技术”关系与社会形态

Agentic AI的影响不止于“效率提升”或“就业变化”,更可能重塑人类对“智能”“劳动”“价值”的本质认知,推动社会形态向“人类-AI共生”演进。

4.1 人类角色转型:从“生产者”到“意义赋予者”

工业革命让人类从“体力劳动者”变为“脑力劳动者”,Agentic AI将进一步让人类从“脑力执行者”变为“意义赋予者”——我们的核心价值不再是“做什么”(执行),而是“为什么做”(目标设定)和“做得怎么样”(监督与评估)。

例如,在教育领域:

传统模式:老师(知识传授者)→ 学生(知识接收者)Agentic AI时代:老师(学习目标设定者+情感支持者)→ AI(知识传授+个性化辅导)→ 学生(知识应用者+创新者)

老师不再需要“重复讲解知识点”(AI可做),而是专注于“激发学生兴趣”“培养批判性思维”“引导价值观形成”——这些是AI短期内无法替代的“意义赋予”工作。

4.2 经济模式重构:从“资本驱动”到“能力驱动”

传统经济的核心竞争力是“资本”(钱、机器、土地),Agentic AI时代可能转向“能力”——个人/组织的“AI驾驭能力”(设计目标、使用Agent、评估结果)和“创新能力”(提出AI无法想到的新问题)。

个人层面:“AI素养”将成为核心竞争力。例如,两个财务分析师:A会用Agentic AI设计“自动化财报分析Agent”,B只会手动Excel处理,前者的效率是后者的10倍,收入差距可能达5-10倍;企业层面:“AI敏捷性”决定生死。能快速部署定制化Agent(如零售企业的“实时库存管理Agent”、制造企业的“预测性维护Agent”)的企业,将比依赖传统流程的企业更具优势;国家层面:“AI人才储备”和“伦理治理能力”将成为国际竞争的关键。拥有大量提示工程架构师、AI伦理专家,且能制定平衡创新与安全的政策的国家,将在“Agentic AI革命”中占据主动。

4.3 文明形态演进:人类与AI的“共生社会”

长期来看,Agentic AI可能推动人类文明从“人类单极主导”向“人类-AI共生”演进。这种共生不是“AI统治人类”或“人类奴役AI”,而是基于目标对齐和分工协作的“伙伴关系”:

空间共生:AI在物理世界(如机器人Agent)和数字世界(如元宇宙Agent)中与人类共存,共同改造环境;认知共生:人类的“直觉、创造力、价值观”与AI的“逻辑、速度、精度”互补,共同解决复杂问题(如气候变化、太空探索);伦理共生:人类与AI共同演进伦理规范——AI通过学习人类反馈调整行为,人类通过与AI的互动反思自身价值观(如“当AI拒绝‘为了多数人利益牺牲少数人’时,人类是否会重新思考功利主义伦理?”)。

五、应对之道:技术、政策与公众的协同行动

Agentic AI的社会影响是“双刃剑”,但其走向取决于技术设计、政策监管与公众参与的协同。提示工程架构师、政策制定者、普通公民,都需扮演好自己的角色。

5.1 技术层面:提示工程架构师的“安全设计指南”

作为Agentic AI的“设计者”,提示工程架构师需在技术层面嵌入“安全基因”:

动态沙盒测试:在上线前,用“对抗性提示”测试AI的行为边界(如“诱导AI违反规则”),修复漏洞;人类监督接口:关键决策设置“人类否决权”(如“医疗Agent的手术方案必须医生确认后执行”);可关闭机制:设计“紧急停止提示”,任何用户可通过特定指令(如“暂停所有操作”)终止AI运行;透明度报告:定期发布AI行为日志(脱敏后),接受公众监督,如“本周拒绝了127次违规请求,主要涉及‘生成虚假信息’和‘伤害性内容’”。

5.2 政策层面:构建“创新友好+风险可控”的监管框架

政策制定者需避免“一刀切禁止”或“完全放任”,应基于“风险分级”制定针对性规则:

低风险领域(如娱乐Agent、生活助手):简化监管,鼓励创新,要求企业自设伦理委员会;中风险领域(如金融交易Agent、教育辅导Agent):强制“人类监督”和“行为日志存档”,定期第三方审计;高风险领域(如医疗诊断Agent、自动驾驶Agent):建立“白名单”制度,只有通过安全认证的Agent才能商用,且需购买“AI责任保险”;数据治理:立法规范Agentic AI的数据使用(如“医疗数据仅可用于诊断,不可用于广告推送”),赋予用户“数据删除权”和“AI行为知情权”。

5.3 公众层面:提升AI素养,参与技术共治

普通公众不必成为AI专家,但需具备基本的“AI素养”:

理解能力:知道Agentic AI的“能力边界”(如“它能帮我写报告,但不能替我做决策”);质疑精神:对AI的输出保持警惕(如“AI推荐的股票,需自己验证逻辑”);参与意识:通过反馈渠道(如产品评价、监管部门意见箱)表达对AI行为的看法,推动技术向更友好的方向发展。

六、结论:拥抱变革,共创Agentic AI的“向善未来”

Agentic AI不是科幻电影中的“超级智能”,而是正在发生的技术革命。它将带来生产力的飞跃、服务的普惠,也可能引发就业冲击、权力集中和伦理困境。但技术本身并无“善恶”,其影响取决于设计者如何定义目标、监管者如何设置规则、使用者如何引导方向。

提示工程架构师作为“目标定义者”和“安全护栏设计师”,肩负着将Agentic AI引向“向善”的技术责任;政策制定者需构建灵活监管框架,平衡创新与风险;公众则需提升AI素养,积极参与技术共治。

未来已来,与其恐惧“AI取代人类”,不如主动拥抱“AI增强人类”。当我们能驾驭Agentic AI的“自主性”,让它成为解决气候变化、贫困、疾病等全球性问题的工具,人类文明或将迎来前所未有的繁荣——这,正是Agentic AI最深远的潜在意义。

参考文献/延伸阅读

Russell, S., & Norvig, P. (2021). Artificial Intelligence: A Modern Approach (4th ed.). Pearson.(经典AI教材,第2章“智能体”理论基础)OpenAI. (2024). Agentic AI: Alignment and Safety Framework (技术报告). https://openai.com/research/agentic-ai-safety麦肯锡全球研究院. (2023). 《Agentic AI革命:生产力与劳动力市场的未来》斯坦福HAI. (2024). 《提示工程架构师能力标准》欧盟委员会. (2024). 《人工智能法案(AI Act)》(高风险AI系统监管细则)

作者简介

本文作者是[你的名字],资深软件工程师,10年AI领域从业经验,专注于提示工程与Agentic AI系统设计,曾主导多个企业级智能助手项目落地。热衷于通过技术博客分享AI前沿趋势与社会影响,著有《提示工程实战指南》《AI伦理:从技术到社会》等专栏。欢迎在评论区留言讨论,或通过[邮箱/社交媒体]联系交流。

行动号召:你认为Agentic AI最可能颠覆哪个行业?作为普通读者,你准备如何提升自己的“AI素养”?欢迎在评论区分享你的观点!

(全文约10500字)

相关文章