Python3.14发布:Python重大更新

Python3.14来了:是把你的程序推上天,还是把部署整崩了?我亲眼见过两种结局

那天像过年似的热闹,2025年10月7日的发布会把技术圈搅得水花四溅。我记得群里有人半夜发消息兴奋得睡不着,也有人在开会时偷偷看更新日志揉着太阳穴。说实话,看到“自由线程模式”“多解释器并发”“t-string模板”“增量垃圾回收”“为JIT做准备”的那些条目,我既激动又有点慌,激动是由于终于有人拿着大刀要砍掉GIL的桎梏,慌是由于每一次底层变动都可能把现有部署搞得七零八落。

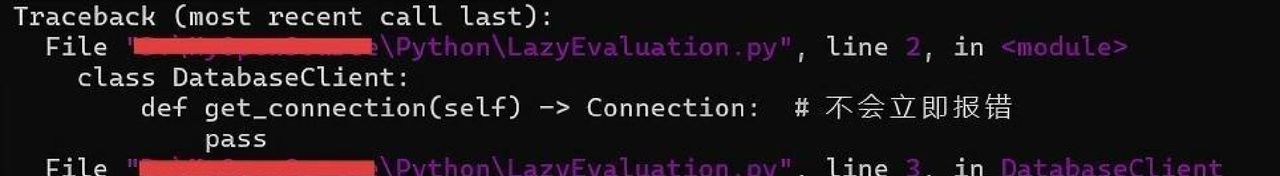

先讲清楚几个你最关心的点。所谓的自由线程模式,官方文档里是把GIL的约束变成可选策略,让CPU能在真正多核上并行算力,这对CPU密集型任务意义很大。多解释器并发像把同一幢房子分成若干独立房间,互不干扰,减少了内存竞争。安全方面引入的t-string模板,主打防注入、自动转义,能在模板渲染层头疼的XSS、注入上降风险。内存和回收的更新,包括增量垃圾回收和更细致的分代策略,目的是缩短长停顿、减少碎片。底层还为将来更激进的JIT编译铺路,换句话说,团队在把Python既做更快也做得更“可演进”。

我有个朋友小李在一家中型电商当后端架构师,前段时间他们在灰度环境试跑了3.14的几个特性。说起来很现实:把模板改成t-string后,前端团队少了好几次因转义出错的应急单,安全审计也省了点力气;把部分API从多进程改成多解释器并发后,峰值吞吐提升明显,但代价是那些基于C扩展的老组件出现兼容问题,不得不花时间更改或重写绑定。小李的结论是,这波收益是真实的,但迁移并非一次性动作,得分阶段、带着回滚计划跑。

我同事小赵在做模型训练,他试着在开发机上把训练脚本跑在多核并行路径上,数据预处理的确 快了不少,内存利用也更友善,让他能在同一台机器上跑更大的batch。但他也碰到现实问题,许多深度学习框架的关键部分还是靠C/C++或CUDA实现,Python层面的并行并不必然让GPU训练更快,所以你要分清楚加速的是Python逻辑还是底层算子。说白了,3.14给了开发者更多工具,但能不能立刻见效,取决于你的应用构成和依赖链成熟度。

如果你要准备升级,提议别盲目推生产环境。先在隔离的虚拟环境里跑完整测试套件,先备份现网的虚拟环境和部署脚本,再在灰度或单机环境验证关键路径。特别注意C扩展和第三方二进制包的兼容性,若发现问题,优先评估替代库或思考把关键模块做成独立服务后端。对并发相关的改动,务必做压力和并发安全测试,内存回收策略带来的行为差异也需要用性能剖析工具观察。说实话,这些步骤听着繁琐,但比起上线后翻车花的时间要少得多。

不得不说,任何一次底层改革都会有“蜜月期”和“阵痛期”。我个人觉得Python这次是朝着更系统化、工业化的方向迈了一大步,这对企业级应用和大数据场景是利好;但对小脚本、教学和快速迭代的项目来说,短期内可能没那么迫切的升级需求。产业链上那些核心库的跟进速度,会决定这次变革到底是在一年内普及,还是需要更长时间慢慢沉淀。

最后,关于该不该赶紧学,我的提议是:先学概念再学实践。花个周末把新特性概览过一遍,在本地用小项目试试多解释器和t-string,记录兼容性问题,参与社区讨论或提交小bug,这种参与感会比盲目焦虑更有收获。反正我是这么觉得的——与其担心“什么时候才能上3.14”,不如先把小块改通了再推进大面积迁移,这样才能把风险降到可控。

你那边是在思考升级生产环境,还是先在团队里做个试点?说说你遇到的最大顾虑或者已经尝试过的问题,我想听听你真实的经历和想法。

相关文章