各位互联网开发的同行们,不知道你们有没有过这样的经历:明明用了号称 “高并发神器” 的 Netty,可项目上线后还是频繁出现连接超时、CPU 占用飙升的问题?前阵子我身边的一个技术团队就踩了这个坑,今天咱们就从这个真实案例切入,一步步把 Netty 多路复用的原理讲透,再结合专家提议聊聊怎么避坑,最后也欢迎大家一起讨论自己的实战经验。

案例:用了 Netty 却没解决高并发,问题出在哪?

我朋友所在的团队是做即时通讯服务的,前段时间为了支撑用户量增长,把原来的传统 IO 通信模块换成了 Netty。一开始大家都觉得稳了 —— 毕竟 Netty 在高并发场景下的口碑摆在那,不少大厂的 IM、网关服务都用它。可上线没几天,问题就来了:

当同时在线用户突破 5 万时,服务端开始频繁出现 “连接建立超时” 的告警;查看监控面板,发现 CPU 使用率从正常的 30% 飙升到 80% 以上,甚至偶尔会触发限流阈值。更奇怪的是,团队排查代码时,发现 Netty 的初始化配置、Handler 逻辑都没明显问题 ——BossGroup、WorkerGroup 的线程数按 “CPU 核心数 * 2” 配置,也用了 NioServerSocketChannel,看起来就是标准的 Netty 高并发配置。

后来他们拉着我一起复盘,把日志、监控数据翻了个遍,才发现核心问题:虽然用了 Netty,但根本没理解多路复用的底层逻辑,等于 “拿着神器却没开刃”。列如他们在 WorkerGroup 的 Handler 里写了同步阻塞的数据库查询操作,还没做任务队列隔离;更关键的是,对 Netty 基于 Selector 的多路复用机制一知半解,甚至不知道 “为什么一个 Selector 能管理上千个连接”,遇到问题自然抓瞎。

这个案例实则很典型 —— 许多开发同行用 Netty,都是 “照着文档粘配置”,对底层原理只停留在 “听说过多路复用” 的层面。今天咱们就从这个案例的问题出发,把 Netty 多路复用的原理拆解开,搞懂它到底是怎么做到 “用少量线程管理大量连接” 的。

问题分析:从案例痛点挖透 Netty 多路复用的核心逻辑

要搞懂 Netty 多路复用,得先从 “传统 IO 的痛点” 说起 —— 毕竟多路复用就是为了解决传统 IO 的瓶颈才出现的。咱们先回顾下案例里提到的 “高并发下 CPU 飙升”,实则根源就藏在传统 IO 模型和 Netty 多路复用模型的差异里。

1. 先搞懂:传统 BIO 为什么扛不住高并发?

在 Netty 流行之前,许多服务用的是 BIO(阻塞 IO)模型。列如一个简单的 BIO 服务端,会用 “一个线程处理一个连接” 的逻辑:当客户端发起连接时,服务端就创建一个新线程,专门负责这个连接的读写操作。

这种模式在低并发场景下没问题,但一旦连接数突破千级,问题就暴露了:线程是操作系统的宝贵资源,创建线程需要占用内存(默认 JVM 线程栈大小是 1M),线程切换也会消耗 CPU 资源。列如同时有 1 万个连接,就需要 1 万个线程,光是线程栈就占用 10G 内存,CPU 在频繁的线程上下文切换中根本没法专注处理业务逻辑 —— 这就是案例里 “CPU 飙升” 的底层缘由之一,只不过案例团队用了 Netty,但因错误写法 “变相回到了 BIO 的坑”。

2. 再拆解:Netty 多路复用是怎么 “用少量线程管大量连接” 的?

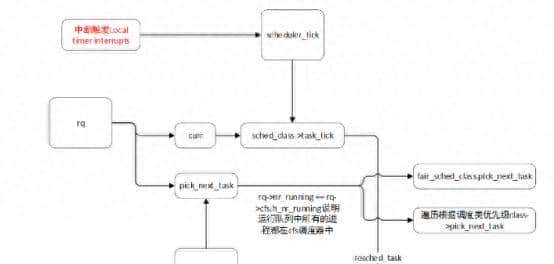

Netty 的多路复用,本质是基于 JDK 的 NIO(非阻塞 IO)实现的,核心依赖 “Selector(选择器)” 这个组件。咱们可以把 Selector 理解成 “连接调度员”—— 它能同时监控多个 Channel(通道,对应客户端连接)的 IO 事件(列如 “连接就绪”“读就绪”“写就绪”),然后把就绪的事件分配给 WorkerGroup 里的线程处理。

具体到流程,咱们可以分成 3 步,结合案例里的 IM 服务场景来理解:

(1)第一步:注册 Channel 到 Selector,实现 “一个 Selector 管多连接”

当客户端发起连接时,Netty 的 BossGroup 线程会处理 “连接建立” 事件,然后把建立好的 SocketChannel 注册到 Selector 上。这里有个关键:注册时会指定要监控的 IO 事件类型,列如对 IM 服务来说,主要是 “读就绪”(客户端发消息过来了)和 “写就绪”(服务端要给客户端发消息)。

注意,此时的 SocketChannel 必须设置为 “非阻塞模式”—— 这是多路复用的前提。由于如果 Channel 是阻塞的,那么当没有 IO 事件时,线程会一直卡在读写操作上,没法去处理其他 Channel 的事件,就又回到了 BIO 的老路。

(2)第二步:Selector 轮询就绪事件,避免 “线程空等”

WorkerGroup 里的线程会不断调用 Selector 的 select () 方法,轮询有没有就绪的 IO 事件。这里的 “就绪” 很关键 —— 列如 “读就绪” 不是指 “数据已经读完”,而是 “数据已经到达操作系统的内核缓冲区,线程可以去读了”;如果没就绪,线程不会阻塞在某个 Channel 上,而是会释放 CPU 资源,去做其他事情(列如处理已经就绪的事件)。

这就解决了传统 BIO 的 “线程空等” 问题。列如案例里如果没有错误的阻塞操作,Worker 线程就不会卡在数据库查询上,而是能高效地通过 Selector 轮询更多连接的事件 —— 这也是 Netty 能 “用 4 个 Worker 线程管理 1 万连接” 的核心缘由。

(3)第三步:分发就绪事件,线程只处理 “有活干” 的连接

当 Selector 检测到有 IO 事件就绪时,会把这些就绪的 Channel 封装成 SelectionKey,返回给 Worker 线程。Worker 线程拿到 SelectionKey 后,就会调用对应的 Handler 逻辑处理事件 —— 列如 “读就绪” 就调用 channel.read () 读取数据,解析 IM 消息;“写就绪” 就调用 channel.write () 发送消息。

这里要注意:一个 Worker 线程同一时间只会处理一个就绪的 Channel 事件,处理完之后会回到 Selector 继续轮询。由于 IO 事件的处理(列如读数据、写数据)是快速的(大部分时间是数据在内存中的拷贝),所以少量线程就能处理大量连接的就绪事件 —— 这也是案例团队如果没写阻塞代码,CPU 就不会飙升的关键。

3. 案例的核心问题:错用 Netty 导致多路复用 “失效”

回到开头的案例,咱们再分析下他们的问题根源:

- 问题 1:Handler 里有同步阻塞操作(数据库查询)。当 Worker 线程处理某个 Channel 的读事件时,调用了阻塞的 JDBC 查询,此时线程会被阻塞,没法回到 Selector 轮询其他连接的事件 —— 相当于 “一个线程被一个连接绑死”,变相回到了 BIO 模式,CPU 自然会由于线程不够用而飙升。

- 问题 2:没理解 Selector 的 “水平触发” 特性。Netty 默认用的是水平触发(LT),即如果一个 Channel 的事件没处理完(列如读了一半数据),Selector 会一直把它标记为就绪,导致 Worker 线程反复处理同一个 Channel—— 案例里由于数据解析逻辑有 bug,导致某个连接的读事件一直没处理完,占用了大量 Worker 线程资源。

搞懂了这些底层逻辑,咱们再看看行业里的专家是怎么提议正确使用 Netty 多路复用的,避免踩类似的坑。

专家提议:3 个关键技巧,让 Netty 多路复用发挥最大效能

我特意咨询了几位在大厂做 Netty 网关、IM 服务的技术专家,他们结合自己的实战经验,给出了 3 个核心提议,正好能解决案例里的问题,也适合咱们大部分互联网开发同行参考:

1. 坚决避免在 Handler 中写同步阻塞操作,用 “异步 + 线程池” 隔离

这是专家们反复强调的 “第一原则”。由于 Handler 是在 Worker 线程中执行的,一旦有同步阻塞操作(列如 JDBC 查询、Redis 阻塞命令、HTTP 同步调用),就会导致 Worker 线程被占用,没法处理其他连接的事件 —— 直接破坏多路复用的高效性。

正确的做法是:把阻塞操作放到专门的业务线程池里执行,Handler 只负责 IO 事件的快速处理(列如读数据、写数据)。列如案例里的 IM 服务,应该在 Handler 中读取完客户端消息后,把 “消息存储到数据库” 的操作提交给业务线程池,Worker 线程立即回到 Selector 继续轮询。

专家给出的具体配置提议:

- 业务线程池的核心线程数可以按 “CPU 核心数” 配置,最大线程数按 “CPU 核心数 * 2” 配置,避免线程过多导致切换消耗;

- 用 Netty 的 EventExecutorGroup 绑定特定的 Handler,实现 “IO 线程” 和 “业务线程” 的隔离,列如:

// 创建业务线程池

EventExecutorGroup businessGroup = new DefaultEventExecutorGroup(4);

// 给需要执行阻塞操作的Handler绑定业务线程池

pipeline.addLast(businessGroup, "businessHandler", new BusinessHandler());2. 根据业务场景选择 “水平触发(LT)” 或 “边缘触发(ET)”

Selector 有两种触发模式:水平触发(LT)和边缘触发(ET),Netty 默认用 LT,但许多开发同行不知道两者的差异,导致用错场景。

专家的提议是:

- 如果业务逻辑能保证 “一次处理完就绪事件”(列如 IM 消息都是短消息,一次能读完),可以用 LT,配置简单,不容易出问题;

- 如果是处理大文件传输、大数据包(列如一次读不完),提议用 ET,配合非阻塞 IO,能减少 Selector 的轮询次数,提升性能。但要注意:ET 模式下必须把 Channel 的所有数据读完(列如在循环里调用 read () 直到返回 – 1),否则会导致数据残留,后续没法触发读事件。

案例里的问题实则也和 LT 有关 —— 由于数据没处理完,Selector 一直触发读事件,占用了 Worker 线程。如果他们的业务适合 ET,配合循环读数据,就能避免这个问题。

3. 合理配置 Selector 数量和 Worker 线程数,避免 “资源浪费” 或 “资源不足”

许多开发同行配置 WorkerGroup 时,要么随意设个固定值(列如 10),要么按 “CPU 核心数 * 2” 一刀切,但实则需要结合业务场景调整。

专家给出的配置公式和提议:

- Selector 数量:默认情况下,Netty 的一个 Worker 线程对应一个 Selector,所以 Selector 数量等于 Worker 线程数。如果是 IO 密集型业务(列如 IM、网关,大部分时间在处理 IO 事件),Worker 线程数提议设为 “CPU 核心数” 或 “CPU 核心数 + 1”—— 由于 IO 操作会释放 CPU,线程切换成本低;

- 如果是 IO + 计算混合业务(列如一边处理 IO,一边做数据加密、序列化),Worker 线程数可以设为 “CPU 核心数 * 2”,避免 CPU 空闲;

- 监控 Selector 的 “空轮询率”:如果空轮询率过高(列如 Selector 大部分时间没检测到就绪事件),说明 Worker 线程数过多,需要减少;如果常常出现 “就绪事件排队”,说明 Worker 线程数不足,需要增加。

案例里的团队实则配置了 “CPU 核心数 * 2” 的 Worker 线程,但由于阻塞操作导致线程被占用,相当于实际可用的 Worker 线程变少,所以才出现连接超时 —— 这也说明 “配置合理” 的前提是 “代码没坑”,两者缺一不可。

互动讨论:你用 Netty 时踩过哪些多路复用的坑?

讲完原理和专家提议,咱们也来聊聊实战经验。实则 Netty 多路复用的坑,许多时候不是原理难,而是 “细节没注意”—— 列如我之前遇到过 “Selector 惊群问题”(多个 Worker 线程同时监听一个 Selector,导致事件重复处理),后来通过 Netty 的 “延迟注册” 机制解决了;还有朋友遇到过 “Channel 注册后没设置非阻塞模式”,结果 Worker 线程直接阻塞在 read () 上。

不知道各位开发同行在项目中用 Netty 时,有没有遇到过类似的多路复用问题?列如:

- 有没有由于阻塞操作导致 Netty 性能下降的经历?最后是怎么解决的?

- 用 ET 模式时,有没有踩过 “数据没读完” 或 “数据读重复” 的坑?

- 对 Selector 数量、Worker 线程数的配置,你有没有自己的实战心得?

欢迎在评论区分享你的经历和解决方案,咱们一起避坑,把 Netty 多路复用用得更溜~毕竟技术都是在交流中进步的,你的一个小经验,可能就能帮其他同行少踩一个大坑!

相关文章