①HDN:Homography Decomposition Networks(2022)

链接:GitHub – zhanxinrui/HDN: Homography Decomposition Networks for Planar Object Tracking

归类:用于改进新视角渲染的子方法(找到类似于SUDS这种能够复现的基础框架,在此基础上加入这些子方法)。

目的:提出了一种新的单应性(homography)分解方法,以提高在视频中跟踪平面物体的鲁棒性和精度。

HDN 辅助新视图渲染是有意义的?

前期图像校正或变换初始化

对平面区域做透视纠正,减少NeRF或SfM输入误差。

用作训练期间几何先验监督

提供局部单应性约束,帮助模型学习准确视图变换。

多视图融合中的配准模块

可用于NeRF中的图像配准步骤。

②AImotive 的项目(2024,不考虑)

链接:https://aimotive.com/aisim-neural-reconstruction-and-rendering

归类:是类似于SUDS的框架,该项目通过集成神经辐射场(NeRF)和三维高斯点渲染(3D Gaussian Splatting)等技术,自动从实车采集的数据(如RGB图像、LiDAR点云、GNSS轨迹)中重建静态环境。随后,利用 aiSim 平台添加动态对象,实现对复杂交通场景的仿真。

目的:生成多模态、高质量的仿真数据,支持感知算法的训练和优化。

AImotive 的项目核心功能之一就是输出新视角渲染的图像

项目会根据虚拟相机轨迹或用户指定的视角,生成真实感极强的新视角图像序列。

输出数据包括:

新视角的 RGB 图像(

image_0000.png

.jpg

对应的深度图(如

.exr

.png

可能还有语义标签图(用于感知任务训练)

aiSim 平台及其 Neural Reconstruction and Rendering 模块并未开源。

③NeuRAD(CVPR 2024,考虑)

NeuRAD 是目前神经辐射场领域中最适配自动驾驶仿真需求的系统之一,结合了高效建模、动态对象支持、传感器仿真、可编辑性和优秀开源性,超越了 MARS 与 SUDS 的主要瓶颈。

github链接:[georghess/neurad-studio: CVPR2024] NeuRAD: Neural Rendering for Autonomous Driving

项目主页链接:NeuRAD: Neural Rendering for Autonomous Driving – Zenseact Research

论文链接:[2311.15260] NeuRAD: Neural Rendering for Autonomous Driving

归类:是类似于Mars的框架

目的:建立一个✅ 高真实感、✅ 支持动态对象、✅ 可编辑、✅ 可模拟传感器特性的 神经渲染仿真平台。

NeuRAD就是做用于自动驾驶(AD)的神经渲染(Nerf)的

比Mars和SUDS效果都好:

特点:①效果好(在多个自动驾驶数据集上达到 SoTA 水平(PSNR/SSIM/LPIPS)性能。);②训练速度比Mars和SUDS快(使用高效 hash grid(类似 Instant-NGP)结构,使训练可在1小时内完成(A100环境下)。);③上手容易;④没有像SUDS那样复杂的预处理;⑤代码开源

复现难度对比:

| 项目 | 依赖工具链 | 数据要求 | 配置复杂度 | 训练硬件建议 | 总体复现难度 |

|---|---|---|---|---|---|

| NeuRAD | Nerfstudio + PyTorch | 自动生成训练样本,兼容多个数据集 | ⭐⭐ 简单 | RTX 3090 起步 / A100 推荐 | ⭐⭐⭐(推荐起步项目) |

| MARS | 自定义 NeRF 模块拼接 + KITTI数据预处理 | 需3D检测 + tracklet 标签 | ⭐⭐⭐ 中等 | 需一定显存资源(>=24G) | ⭐⭐⭐⭐ |

| SUDS | Hash grid 实现 + optical flow 提取 + DINO 特征提取 + 自定义分区器 | 高度自动化但需要光流与特征提取器配置 | ⭐⭐⭐⭐ 偏复杂 | A100 多卡/分布式强烈推荐 | ⭐⭐⭐⭐⭐(工程要求高) |

优势与创新点:

| 特性 | NeuRAD 表现 | 对比说明 |

|---|---|---|

| 动态建模 | ✅ 支持,单网络统一建模 | MARS 拆成多个 NeRF,SUDS 多分支哈希表 |

| 场景编辑 | ✅ 插入/编辑/模拟 actor | SUDS 支持较弱,MARS支持但较复杂 |

| 传感器建模 | ✅ LiDAR + 摄像头 模拟物理特性 | MARS无LiDAR支持,SUDS不模拟beam |

| 运行效率 | ✅ 快速训练/渲染 | 优于MARS/SUDS |

| 开源可复现 | ✅ 完整开源,文档完善 | SUDS次之,MARS部分依赖较重 |

NeuRAD输入:RGB 图像、相机轨迹(IMU/GNSS推算)、LiDAR 点云(辅助建模)、Actor 轨迹(通过追踪器提取)

NeuRAD输出:新视角图像、深度图、反射率图、点云drop率、场景编辑结果等

④Nerf-KBS(EI 2025,挺好的,但是没有详细的复现步骤)

github链接:GitHub – GandalfTGrey/Nerf-KBS

归类:是类似于SUDS和Mars的框架

目的:Nerf-KBS 针对传统 NeRF 无法有效处理动态驾驶场景中运动物体带来的模糊与伪影问题,提出了一种基于语义分割 + 光流估计 + 图像修复(inpainting)的预处理机制,以恢复被运动物体遮挡的静态背景,从而提升 NeRF 的新视角渲染质量。

与其他系统比较

| 维度 | Nerf-KBS | NeuRAD | MARS | SUDS |

|---|---|---|---|---|

| 核心策略 | 动态分割 + inpainting | 动静统一建模(NFF)+ 传感器模拟 | Instance-level NeRF + 插件式编辑 | 多哈希网格 + 场景流建模 |

| 动态处理 | 显式剔除动态对象后重建静态背景 | 学习动态对象与背景的联合体渲染 | 明确多实例前景 NeRF(需标签) | 无监督 flow 引导动态区域建模 |

| 是否编辑动态对象 | ❌(移除后重建) | ✅(可插入/控制) | ✅(轨迹控制) | ⚠️ 仅建模,不可控 |

| LiDAR/传感器仿真 | ❌ 无建模 | ✅ 支持 beam/drop 模拟 | ❌ | 部分支持 depth 引导 |

| 训练效率 | ✅ 3090 单卡训练 1h | ✅ A100 1h | 中 | 慢(城市级) |

| 代码开源性 | ✅ GitHub 完整公开 | ✅ nerfstudio plugin | ✅ 公开模块化结构 | ✅ 部分开源(高耦合) |

Nerf-KBS是2025年的文章,它在KITII_MOT06序列上的精度(27.19)比NeuRAD(27.00)好,比NeuRAD2x(27.91)差,Nerf-KBS项目的代码挺简洁美观的,但是在github上没有详细说明复现步骤。

⑤Towards City-Scale Neural Rendering(SUDS作者博士论文)

这篇博士论文可以看作是对 SUDS 的全面升级版,在 城市尺度、渲染效率、视觉质量、模态融合与系统应用完整性方面全面增强,不仅包含了原 SUDS 方法,还加入了三大关键模块(HybridNeRF、PyNeRF、多尺度训练优化),后面如果找到了合适的框架之后,可以看看这篇论文是在SUDS上面如何创新的,借鉴一下想法和思路。

⑥MapNerf(2023,不考虑)

链接:代码未开源

目的:NeRF 轨迹外视角(out-of-trajectory views)合成质量差、语义结构错乱。这是因为训练数据集中多数视角都沿真实车辆轨迹采集(路径局部采样密度高),NeRF 仅在已观测区域建模效果好,在外插视角出现扭曲/偏差。通过引入地图先验(map priors),提升NeRF在车道偏移/轨迹外视角下的渲染质量与语义一致性。

数据集未使用KITTI

⑦READ(2022,不考虑)

链接:GitHub – flycloud2010/READ-: AAAI2023,implementation of “READ: Large-Scale Neural Scene Rendering for Autonomous Driving”, the experimental results are significantly better than Nerf-based methods

目的:利用稀疏点云和神经特征渲染网络,在普通 PC 上完成公里级街道场景的新视角写实图像合成,并支持拼接与场景编辑。

输入:多视角图像序列、SfM/MVS重建所得稀疏点云、相机参数

输出:给定任意新视角生成的高质量 RGB 图像,可选输出编辑后或拼接后新视角图像(模拟车祸、移除车辆等)

使用数据集:KITTI Dataset、Brno Urban Dataset

时间过于久远,不考虑复现,且与现在的模型比起来精度较低(23.28)

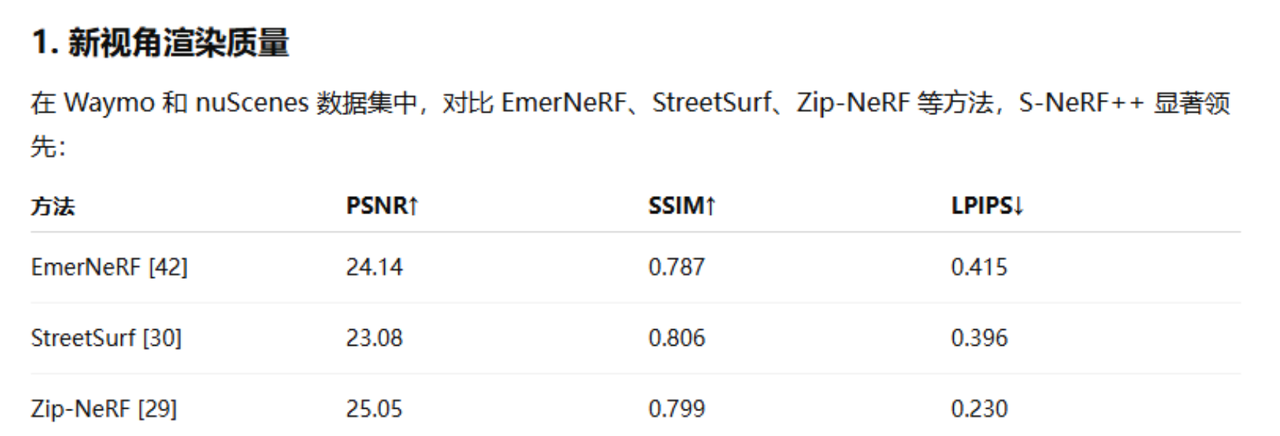

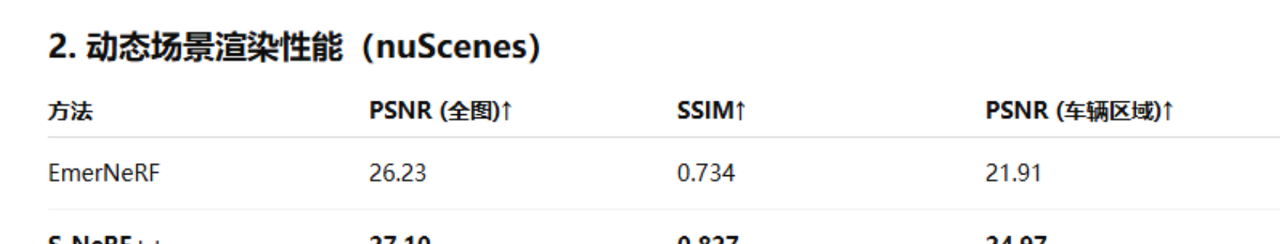

⑧S-Nerf++(2025,考虑)

github链接:GitHub – fudan-zvg/S-NeRF: [ICLR 2023 & TPAMI 2025] S-NeRF: Neural Radiance Fields for Street Views

项目主页链接:S-NeRF++

论文解读链接:[论文审查] S-NeRF++: Autonomous Driving Simulation via Neural Reconstruction and Generation

归类:类似于suds这种框架

目的:S-NeRF++ 致力于构建一个面向自动驾驶的高真实性仿真系统,核心目标是联合重建与生成大规模街景和动态前景对象(如车辆),提升渲染质量、仿真灵活性和多样性,增强下游任务性能。(不仅有新视图合成,还有重建)

输入:nuScenes/Waymo 等自动驾驶数据集,包括多视角图像、LiDAR 点云、车辆轨迹等,没有使用KITTI数据集。

输出:渲染图像、语义标签、深度图、插入后图像、3D 框标注

数据集:nuScenes(6视角,32线LiDAR):1000条序列中选取60段进行训练;Waymo Open Dataset(5视角,64线LiDAR):选取100段,分为训练与测试;Co3D + 自采集前景视频:用于构建人/车辆前景资产库;

实验结果:

⑨Block-Nerf(CVPR 2022,不考虑)

链接:hjxwhy/Block-NeRF: This project is the non-official PyTorch implementation of Block-NeRF.

目的:将大规模街区(如旧金山多个街区)场景分块,分别训练多个独立 NeRF,实现可组合渲染、局部更新和无限扩展的新视图合成系统。

输入:多帧图像(12相机 × 多次巡航)、IMU/GPS 姿态信息、曝光时间、语义 mask

输出:给定任意新视角的高质量 RGB 渲染图像,可选输出不同曝光/天气/昼夜下图像、按时间段组合视图序列

数据集:Block-NeRF 使用的数据集全部是自采集的,并未使用或公开任何标准公共数据集。

时间过于久远,且未使用公开数据集不考虑复现

⑩NeuRAS(ICCV2023,不考虑)

github链接:无,代码未开源

项目链接:Real-Time Neural Rasterization for Large Scenes – Waabi

目的:解决神经渲染(NeRF)在城市级大场景下“高保真 vs 实时性”之间难以兼顾的问题。传统 NeRF 类方法虽然效果好,但在大场景(>10,000 m²)上渲染缓慢;图形学方法可实时渲染,但真实感不足。NeuRas 提出结合光栅化管线(Rasterization)与神经纹理的混合神经渲染框架,首次实现了城市级场景在 1920×1080 分辨率下的 >100 FPS 实时渲染,也就是一秒可以渲染几百张高质量的图片,Instant-NPG(已是加速版)在 800×800 分辨率下一般约 20 FPS。

特点:速度快

输入:多视角图像 + 相机位姿(SfM/SLAM)+ 粗网格(Mesh)

输出:指定视角下高保真 RGB 渲染图(1920×1080),FPS ≥ 100

数据集:PandaSet、BlendedMVS(无人机)

实验结果:

⑪Towards Zero Bottlenecks for Scaling Autonomous Driving(NeuRAD作者博士论文)

在复现NeuRAD后可以看看他的博士论文有没有对其进行改进。

⑫EmerNerf(2023)

github链接:NVlabs/EmerNeRF:EmerNeRF 的 PyTorch 实现:通过自我监督进行紧急时空场景分解

目的:EmerNeRF 的目标是构建一个高效且可扩展的神经渲染系统,用于多智能体(multi-agent)环境下的感知仿真。它针对传统 NeRF 在城市级多视角、多车辆场景中存在的问题(如效率低、扩展性差、渲染冗余)提出新型“局部应激表示(emergent local representations)”框架。

输入:场景图像序列 + 相机/激光雷达参数 + 地图区域划分信息

输出:指定视角的新合成图像(RGB)、深度图、点云、语义图等

数据集:Waymo Open Dataset

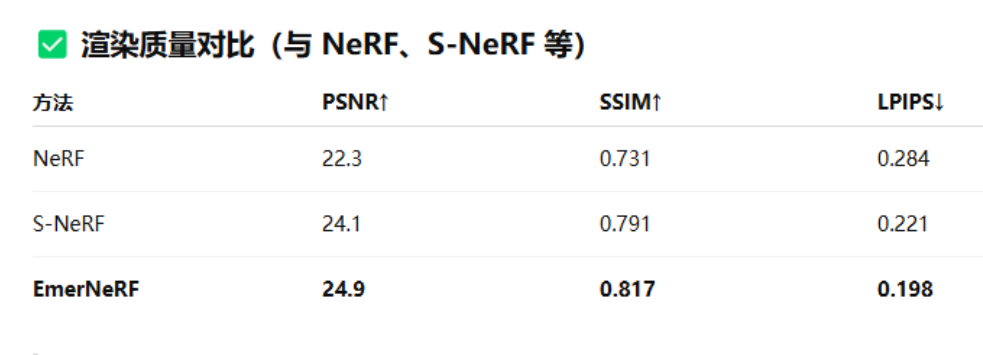

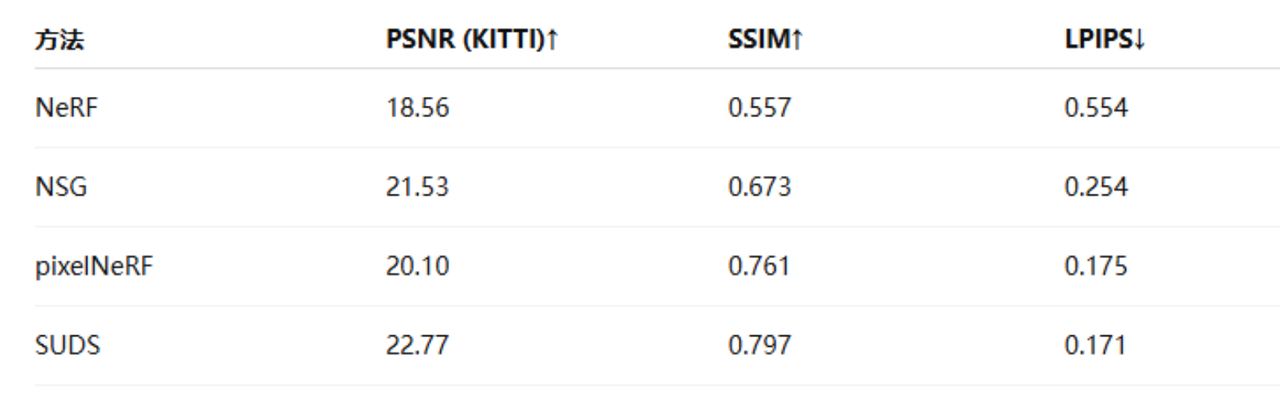

实验结果:比S-Nerf好,但是比不过S-NeRF++

⑬面向自动驾驶场景的神经辐射场综述(2023年,图学学报)

系统地回顾了神经辐射场(NeRF)在自动驾驶场景中的典型应用方法,并分类总结了多个代表性 NeRF 扩展模型。

稀疏视角重键:

大规模场景重建:

动态场景建模:

加速训练与实时渲染:

可编辑场景合成:

性能对比:

各个方法时间分布:

2020 ── NeRF-W 2021 ── pixelNeRF, GRF, MVSNeRF, DVGO, NSFF, D-NeRF, Mega-NeRF 2022 ── Block-NeRF, Plenoxels, Point-NeRF, Progressive LocalRF, Instant-NGP, DNMP, NSG 2023 ── SUDS, MARS, UniSim, Hex-Plane, MixVoxels, NeuRas, READ

相关文章