论文标题:

An Online Fragmentation-Aware GPU Scheduler for Multi-Tenant MIG-based Clouds

论文链接:

https://arxiv.org/pdf/2511.18906

一句话总结 (TL;DR):

本文提出了一种针对NVIDIA MIG技术的新型调度算法,通过量化GPU资源碎片化程度并动态优化分配策略,在未知工作负载特性的情况下,将高负载下的任务接受率平均提升10%,显著提高云服务商的GPU资源利用率。

研究背景:为什么这项研究很重要?

随着AI应用爆炸式增长,云服务商纷纷推出“GPU即服务”平台,通过多租户共享GPU资源来降低成本。NVIDIA的多实例GPU(MIG) 技术因其硬件级隔离优势(避免资源争用、提升安全性)成为主流方案。

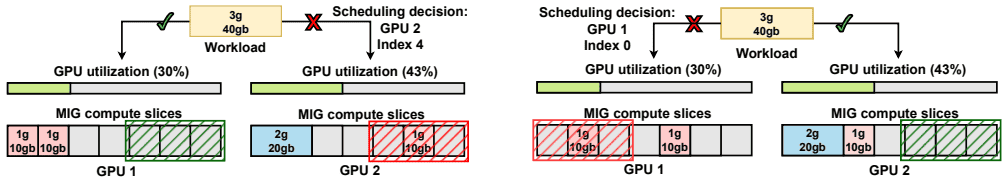

然而,MIG的固定分区模式就像一套不能拆改的精装公寓:虽然每个租户有独立空间,但户型选择有限。当不同规格的工作负载(如小模型推理与大模型训练)频繁上下线时,GPU内部会产生大量“碎片空间”——这些空闲资源因分区限制而无法被新任务利用,导致GPU实际利用率低下,云服务商收入受损。

核心思想与方法:它的解决方案是什么?

研究团队的核心洞察是:碎片化不是绝对的,而是相对于当前请求的MIG配置而言的。基于此,他们设计了两个关键创新:

1. 智能碎片度量标尺

传统的碎片衡量标准在MIG场景下失效,因为即使资源连续,也可能因分区索引约束而无法分配。新指标通过“假设测试”量化碎片严重程度:对每个可能配置,检测其是否因现有分配而变得不可调度,并按内存切片权重累加得分。得分越高,GPU的“无效空间”越大。

2. 最小碎片增量(MFI)算法

算法采用贪心策略,为每个新任务执行“预分配测试”:

遍历所有GPU,计算当前碎片得分模拟将任务分配到每个可行位置后的新得分选择使碎片增量最小的GPU和分区索引

这就像玩俄罗斯方块时,不是简单填满空行,而是优先选择对后续方块布局影响最小的落点。

实验与效果:它的效果如何?

团队在四种典型负载分布下对比了五种调度策略:

MIG不感知方案:First-Fit(FF)、Round-Robin(RR)MIG感知方案:Best-Fit with Best-Index(BF-BI)、Worst-Fit with Best-Index(WF-BI)本文方案:MFI

关键发现:

一致领先:MFI在所有负载场景下均保持最高任务接受率(接近100%),尤其在“小任务偏多”的碎片高发场景优势明显资源高效:在达到相同任务处理量时,MFI所需GPU数量与最优打包策略相当,但实际利用率更高适应性强:在不同MIG配置分布下性能稳定,无需预先了解负载特征

价值与展望:它对我们有什么启发?

实际应用价值:

对云服务商:直接提升GPU集群吞吐量,增加营收对AI应用开发者:降低资源获取难度,提高任务部署成功率对集群管理者:无需复杂预测或任务迁移即可优化资源效率

未来方向:

结合动态重调度机制,进一步优化长期运行集群的碎片情况扩展到异构GPU环境(如A100与H100混合集群)探索与节能策略的协同优化

总结

这项研究将经典的碎片化问题与新兴的MIG技术特性相结合,用简洁高效的在线算法解决了云GPU资源的实际痛点。其核心价值在于证明了:即使在没有先验知识且约束严格的场景下,通过合理的量化指标和实时决策,也能显著提升硬件利用率。这种思路对于任何受限于硬件分区约束的资源调度场景都具有参考意义。

关于作者

大家好,我是宝爷,浙大本科、前华为工程师、现某芯片公司系统架构负责人,关注个人成长。

新的图解文章都在公众号「宝爷说」首发,别忘记关注了哦!

感谢你读到这里。

如果这篇文章对您有所帮助,欢迎点赞、分享或收藏!你的支持是我创作的动力!

如果您不想错过未来的更新,记得点个星标 ⭐,下次我更新你就能第一时间收到推送啦。

相关文章