标题:VR开发实战: Unity XR Interaction Toolkit手势交互方案

关键词:VR开发、Unity XR Interaction Toolkit、手势交互

摘要(meta描述):本文介绍了如何利用Unity XR Interaction Toolkit实现VR应用中的手势交互,包括手势识别、交互动作实现等方面的技术和实践经验。

一、引言

随着VR技术的快速发展,越来越多的开发者开始关注如何在VR应用中实现更加直观便捷的交互方式。而Unity XR Interaction Toolkit作为Unity官方推出的VR交互解决方案,为开发者提供了一套完整的手势交互工具包。本文将介绍如何利用Unity XR Interaction Toolkit实现VR应用中的手势交互方案,主要包括手势识别和交互动作实现等内容。

二、Unity XR Interaction Toolkit简介

什么是Unity XR Interaction Toolkit

是Unity官方推出的一款专门用于实现交互式XR体验的工具包。它旨在简化开发者在Unity中创建VR和AR应用程序的过程,涵盖了手势交互、物体抓取、UI交互等功能。它提供了丰富的API和组件,方便开发者快速构建交互式体验。

的特点

简化开发流程:提供了一整套的交互解决方案,省去了开发者自行实现交互逻辑的工作。

定制灵活:支持自定义手势和交互行为,满足不同应用场景下的需求。

跨平台兼容:支持主流的VR和AR设备,包括Oculus Rift、HTC Vive、Windows Mixed Reality等。

三、Unity XR Interaction Toolkit实现手势交互

手势识别

在Unity XR Interaction Toolkit中,手势识别是实现手势交互的基础。通过识别用户手部或控制器的运动轨迹和姿势,可以实现对应的交互动作。

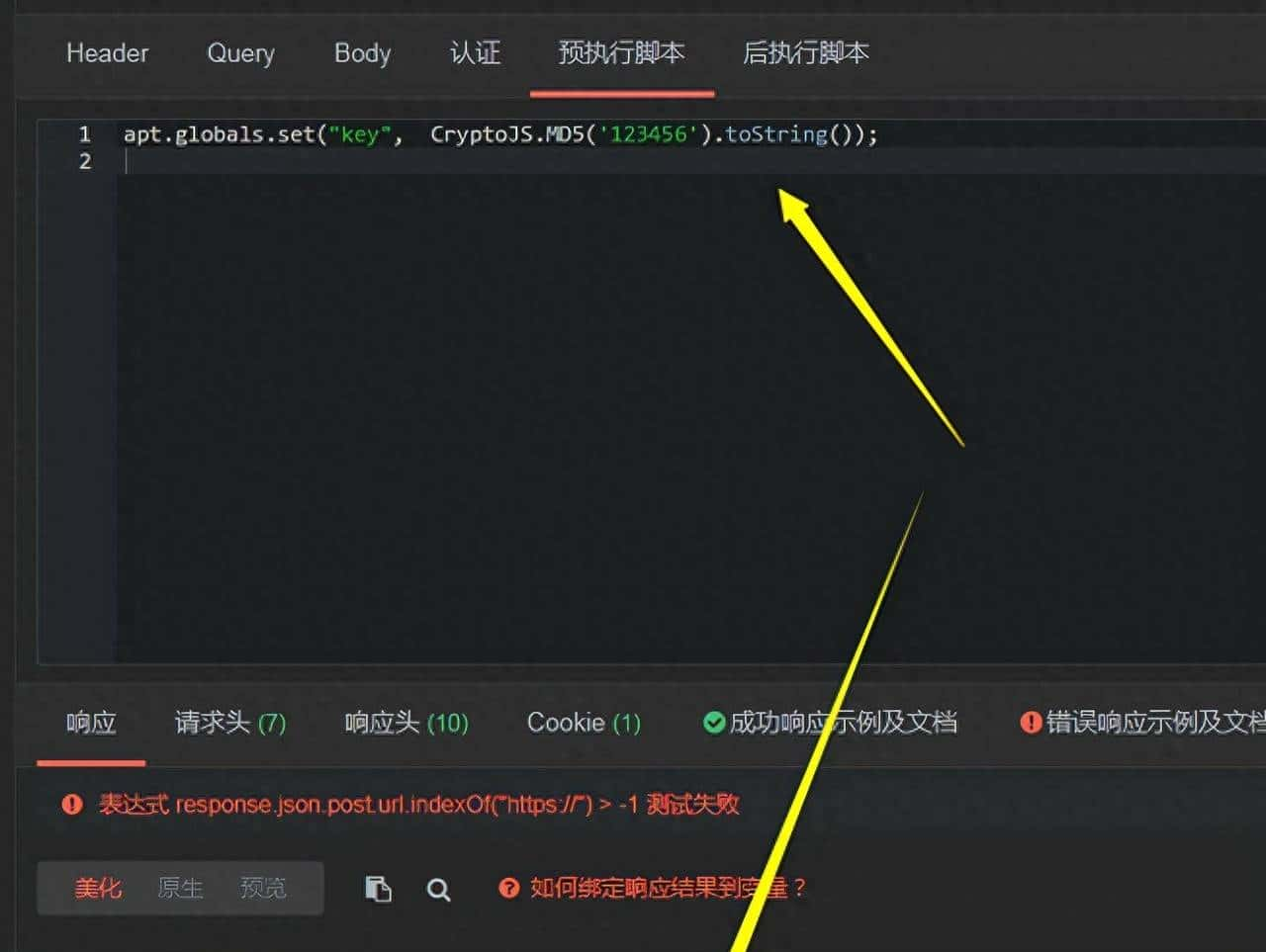

代码示例:手势识别

手势识别逻辑

上述代码演示了如何通过Unity XR Interaction Toolkit中的XRController来获取手柄的输入,并根据输入数值实现手势识别逻辑。

交互动作实现

一旦完成手势识别,接下来就是根据识别到的手势实现相应的交互动作。列如,通过识别“握拳”手势来抓取物体、通过“滑动”手势来调整UI界面等。

代码示例:交互动作实现

实现交互动作

上述代码演示了如何通过继承XRBaseInteractable类,重写OnSelectEnter方法实现交互动作。该方法会在交互器进入当前交互体时被调用,从而触发相应的交互动作。

四、案例分析:VR手势交互应用实践

以一个虚拟画板应用为例,结合Unity XR Interaction Toolkit实现了用户通过手势绘画的交互体验。用户可以通过手势来选择画笔颜色、调整画笔粗细,实现直观的绘画操作。

五、结论

本文简要介绍了Unity XR Interaction Toolkit在VR开发中的手势交互方案,包括手势识别和交互动作实现。并通过一个虚拟画板应用的案例进行了实践演示,展示了其在实际应用中的价值和优势。

关键词:VR开发、Unity XR Interaction Toolkit、手势交互、交互动作实现

标签:VR开发、Unity、XR、交互设计、手势识别

以上就是我们对于“VR开发实战: Unity XR Interaction Toolkit手势交互方案”的介绍,如果你有更多问题或者疑问,欢迎在留言区与我们互动。

相关文章