目前的大模型开发越来越简单了,国产AI大模型接口也越来越多了,不过这更加让开发者困扰,到底应该选哪个接口呢?

在国内环境,以及按照目前知名度来说,AI大模型接入肯定首选Deepseek大模型,有几个缘由:够智能、知名度高、用户多。许多自己开发大模型的大厂产品都明确接入Deepseek,列如腾讯元宝、百度搜索,这说明什么,对自己产品没信心?蹭热度?成本更低?还是说打不过就加入?

模型确定使用Deepseek,就直接使用官网接口就行了还有什么可讲的?当然不是。Deepseek是开源开放模型,不止是Deepseek官网有接口可以调用,还有许多第三方平台都支持Deepseek,这就是本文需要讨论的话题了,选择哪家合适?

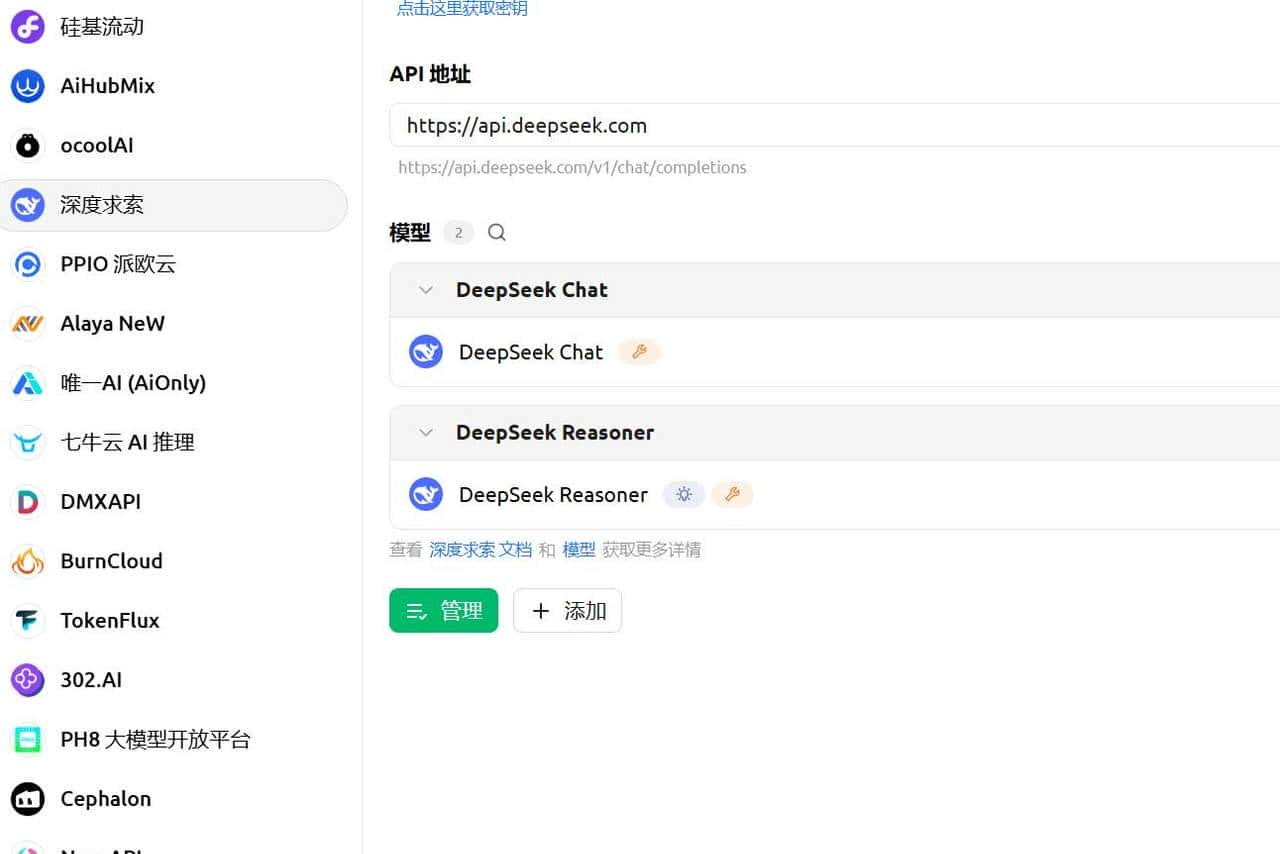

从CherryStudio这个开源项目的大模型设置选项我们可参考许多提供大模型接口的厂商,单单国内这么多厂商该怎么选才好呢?我个人根据几个参考因素决定:稳定性、价格、扩展能力。

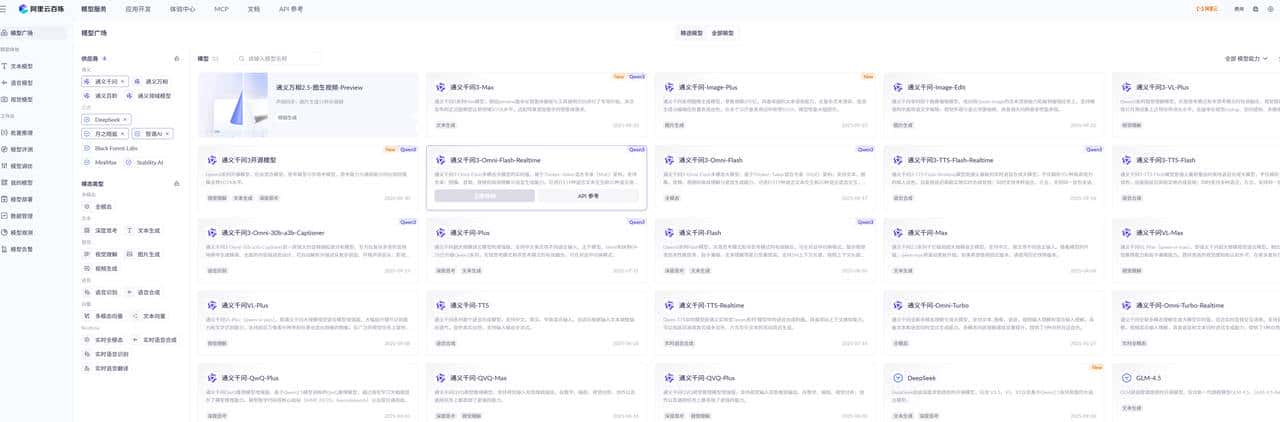

要我推荐,我推荐阿里云百炼平台,其次第一不推荐Deepseek官方接口。理由如下,阿里云是国内较大的云服务器品牌,服务器稳定性肯定顶流,不像Deepseek这种在服务器和互联网领域经营较小的公司,导致官方聊天都常常服务器繁忙,当然,api接口可能不存在这种情况,但除了服务器可靠性,主要还是由于Deepseek官方接口功能太少了,就几个对话和模型基础功能,缺少许多服务,仅靠Deepseek很难支撑业务,列如文本嵌入接口就没有,除了文字输入其它能力也没有,如果选阿里云平台,文本向量嵌入、文字输入,知识库,联网搜索等功能都可以使用。

另外阿里云平台新用户都有千万tokens免费额度的接口调用,可选模型也许多,还有图片模态的大模型,后续项目升级更多AI功能也不用换接口或者增加接口做不同api-key的维护。

另外阿里云平台支持模型微调、训练、还和国内最大的大模型仓库modelscope深度绑定,最接近大模型一站式服务的平台。

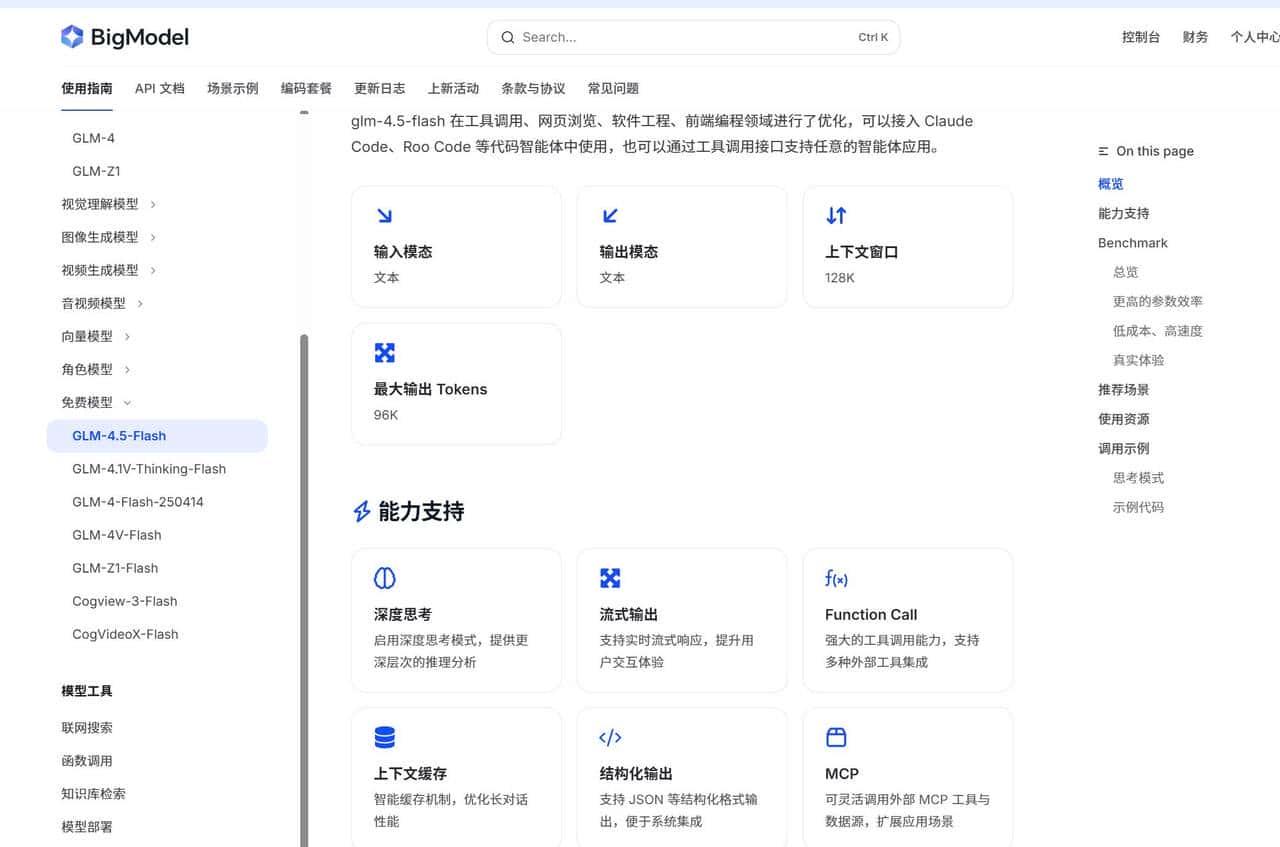

除了阿里云,且不是Deepseek大模型需求,也可以看看智谱AI大模型GLM,这个不仅有新用户免费额度,还有完全免费的大模型GLM-4.5-Flash,尽管只有2的并发数,入门级开发实则完全够了,且智谱AI大模型接口功能完备,不仅具备深度思考、函数调用,还直接在接口就支持MCP配置调用,内置支持知识库,免费1G空间,能省较大的开发工作量。

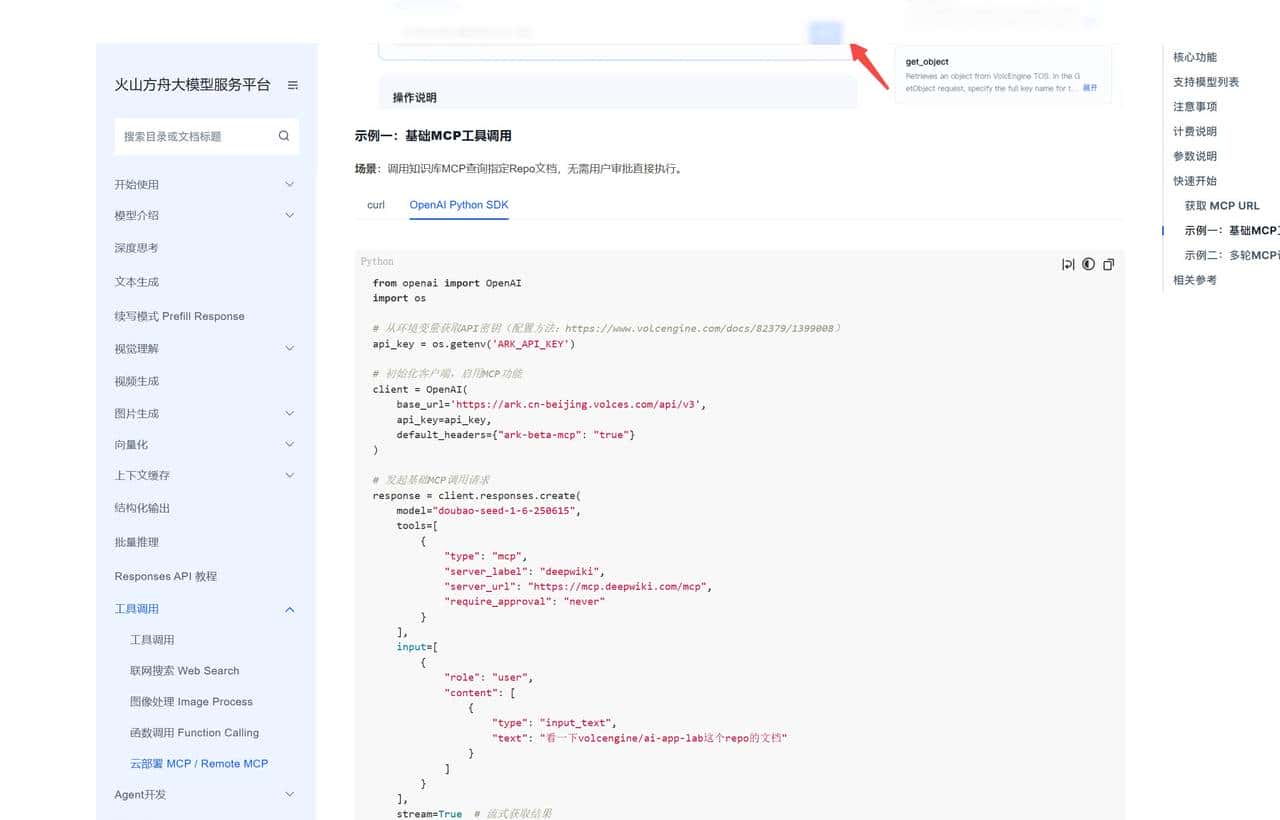

目前,豆包也支持API接口调用MCP服务能力,省去开发者自己配置MCP Client的烦恼。

收藏了,感谢分享