多语言翻译上下文理解升级:提示工程架构师用Agentic AI的5个进阶技巧

一、引言:为什么你的翻译总差“那点意思”?

1. 一个让译者崩溃的真实场景

上周,我帮朋友翻译一份法国文学奖的获奖致辞。原文里有这么一句话:

“Le roman est un miroir qui ne reflète pas le monde, mais le creux où le monde se cache.”

朋友用某知名翻译软件得到的结果是:

“小说是一面不反映世界的镜子,而是世界隐藏的空洞。”

读起来像机器在“逐词堆砌”——完全丢失了原文中“镜子照见的不是世界本身,而是世界背后的留白”的哲学意味。更糟的是,致辞中反复提到的“le creux”(空洞/留白),后面被译成了“缝隙”“凹陷”,前后完全不一致。

这不是个例。你可能也遇到过:

翻译合同里的“不可抗力”被译成“无法抗拒的力量”(正确译法是法律术语“force majeure”对应的“不可抗力”);翻译小说时,前文的“他”突然变成了“她”(指代消解错误);翻译广告标语“科技以人为本”被译成“Technology is people-oriented”(不如“Technology serves people”更贴合原句的人文温度)。

2. 传统翻译的“上下文盲区”

传统机器翻译(MT)的核心是“统计匹配”或“深度学习的序列到序列(Seq2Seq)模型”,它的上下文理解局限在局部窗口(比如GPT-4的8k/32k tokens),无法解决三个关键问题:

长期依赖:长文本(如小说、论文)中,前面的情节/定义会影响后面的翻译,但模型会“忘记”;逻辑连贯:指代(他/她/它)、因果关系需要推理,而不是“猜”;文化与领域适配:隐喻、专业术语需要“懂背景”,而不是“直译”。

这时候,Agentic AI(智能体AI) 站了出来——它不是“输入→输出”的工具,而是有自主决策、记忆、工具调用能力的“翻译助手”。它能像人类译者一样:

先读完全文,梳理结构;遇到不懂的术语,查专业词典;记住前面的翻译选择(比如“Alice”译为“爱丽丝”);调整语言风格适配场景(比如法律文本要严谨,小说要生动)。

3. 本文能给你什么?

如果你是提示工程架构师(或想提升翻译效果的AI开发者),这篇文章会帮你:

理解Agentic AI解决翻译上下文问题的核心逻辑;掌握5个可落地的进阶技巧(配提示词示例、代码片段);避开新手常踩的“上下文陷阱”。

接下来,我们从基础概念讲起,再一步步拆解技巧。

二、基础知识:Agentic AI与翻译的“上下文难题”

在讲技巧前,先明确三个关键概念——它们是理解后续内容的基石。

1. 多语言翻译的“上下文四难”

翻译的本质是“跨语言的意义传递”,而上下文是“意义的载体”。传统翻译的瓶颈,恰恰是解决不了这四个“上下文难题”:

| 难题类型 | 例子 |

|---|---|

| 指代消解 | 英文:“The cat chased the dog. It ran away.” 中的”It”指猫还是狗? |

| 逻辑连贯 | 中文:“他努力学习,所以考上了大学。” 中的“所以”需要保留因果关系。 |

| 领域适配 | 医学文本:“hypertension” 要译为“高血压”(而非“高压”)。 |

| 文化隐喻 | 中文:“画饼充饥” 不能直译“draw a cake to satisfy hunger”,要译“castles in the air”(空中楼阁)。 |

2. 什么是Agentic AI?

Agentic AI(智能体AI)是具备目标导向、自主行动能力的AI系统,核心特征是:

记忆:存储历史交互和背景知识(比如前面的翻译决策);规划:将大目标拆成小步骤(比如“先查术语→再确认指代→最后翻译”);工具调用:使用外部工具(比如知识图谱、向量数据库)补充信息;反馈:根据结果调整策略(比如发现翻译不一致,返回修改)。

对比传统AI:

| 维度 | 传统AI | Agentic AI |

|---|---|---|

| 核心逻辑 | 输入→输出(Static) | 目标→行动→反馈(Dynamic) |

| 上下文处理 | 局部窗口(Limited Context) | 长期记忆+动态调取(Unlimited) |

| 决策方式 | 统计/模式匹配 | 推理+工具辅助 |

3. Agentic AI翻译的“核心能力模型”

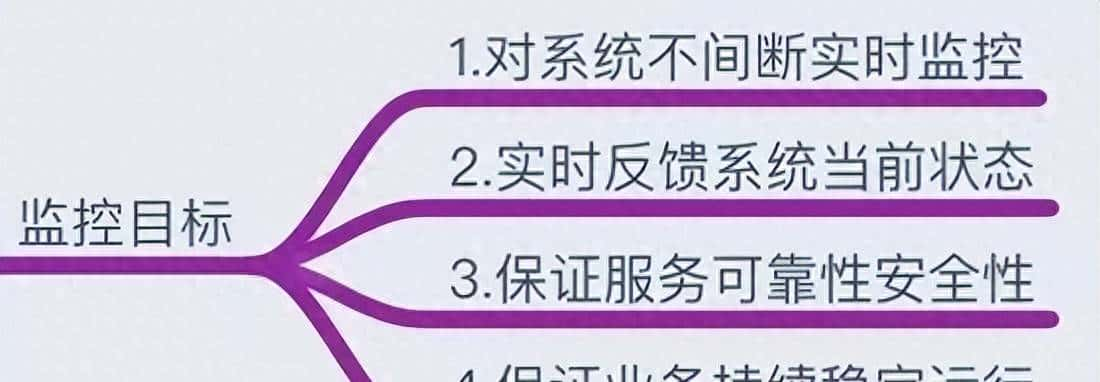

要解决翻译的上下文问题,Agentic AI需要具备四个核心能力(对应后面的5个技巧):

长期记忆:记住长文本的关键信息(比如小说的人物关系);因果推理:分析上下文的逻辑链(比如“it”指代什么);知识融合:调用领域知识(比如法律术语);情境适配:调整语言风格和文化隐喻;一致性校准:确保前后翻译一致(比如人名、术语)。

三、核心技巧:用Agentic AI升级翻译上下文理解的5个方法

这部分是文章的“干货区”——每个技巧都会讲为什么重要、怎么实现(提示词+工具)、真实案例。

技巧1:构建“分层上下文记忆系统”——解决长文本“记不住”的问题

为什么需要?

传统翻译模型的“上下文窗口”是有限的(比如GPT-4 Turbo是128k tokens,约9.6万字),但面对长篇小说、学术论文、法律合同(动辄几十甚至上百万字),模型会“忘记”前面的内容。比如翻译一本小说,第10章提到的“主角的童年创伤”,第20章需要呼应,但模型可能已经“忘了”。

怎么做?

构建三层记忆系统,将上下文拆分成“短期→中期→长期”,用不同的存储方式处理:

| 记忆层级 | 内容类型 | 存储工具 | 调用逻辑 |

|---|---|---|---|

| 短期记忆 | 当前翻译的段落/句子 | 内存(In-Memory) | 直接注入提示词 |

| 中期记忆 | 篇章结构/关键情节 | 摘要算法(如TextRank) | 压缩成“关键节点”存储 |

| 长期记忆 | 领域知识/文化背景 | 向量数据库(如Pinecone) | 用相似度检索调取相关内容 |

提示工程示例

假设你要翻译一本维多利亚时代的小说,长期记忆存储了“维多利亚时代的社交礼仪”(比如“女性不能主动和陌生男性说话”),中期记忆存储了“前5章的人物关系”(比如“主角Emma是贵族小姐,喜欢Mr. Knightley”),短期记忆是当前要翻译的句子:

“Emma hesitated before speaking to Mr. Knightley, knowing the rules of the ton.”

提示词设计(结合三层记忆):

你现在需要翻译一段维多利亚时代的小说片段,请遵循以下步骤:

1. 调取长期记忆:维多利亚时代的社交礼仪——“ton”指“上层社会的社交规则”,女性不能主动和陌生男性说话;

2. 调取中期记忆:主角Emma喜欢Mr. Knightley,但之前没主动说过话;

3. 结合短期记忆(当前句子):Emma在和Mr. Knightley说话前犹豫了,因为知道“ton”的规则;

4. 翻译要求:保留原句的犹豫感,“ton”译为“上层社会的社交惯例”(符合长期记忆)。

请翻译:"Emma hesitated before speaking to Mr. Knightley, knowing the rules of the ton."

翻译结果:

“爱玛在和奈特利先生说话前犹豫了——她清楚上层社会的社交惯例。”

工具实现:用Pinecone存储长期记忆

Pinecone是一个向量数据库,可以将文本转换成“向量”(数字标签),然后通过“相似度检索”快速找到相关内容。以下是Python代码片段(用LangChain连接Pinecone):

from langchain.vectorstores import Pinecone

from langchain.embeddings.openai import OpenAIEmbeddings

import pinecone

# 初始化Pinecone

pinecone.init(api_key="YOUR_API_KEY", environment="us-west1-gcp")

index_name = "translation-memory"

# 生成embedding(将文本转换成向量)

embeddings = OpenAIEmbeddings(openai_api_key="YOUR_API_KEY")

# 存储长期记忆(比如“维多利亚时代的社交礼仪”)

long_term_memory = [

"维多利亚时代的“ton”指上层社会的社交规则,女性不能主动和陌生男性说话",

"维多利亚时代的婚礼需要父母同意,否则视为无效"

]

vector_store = Pinecone.from_texts(long_term_memory, embeddings, index_name=index_name)

# 翻译时检索相关记忆

query = "Emma hesitated before speaking to Mr. Knightley, knowing the rules of the ton"

relevant_memory = vector_store.similarity_search(query, k=1) # 取最相关的1条

# 将记忆注入提示词

prompt = f"长期记忆:{relevant_memory[0].page_content}

请翻译:{query}"

技巧2:用“因果推理链”解决指代与逻辑连贯——让翻译“有逻辑”

为什么需要?

指代消解(比如“他/她/它”指谁)是翻译的“老大难”。传统翻译模型靠“统计概率”猜(比如“it”更可能指前面的“dog”而不是“cat”),但遇到复杂逻辑就会错。比如:

“The chef prepared the meal. It was delicious.”

传统翻译:“厨师准备了这顿饭。它很美味。”(正确)

但如果是:

“The chef prepared the meal with fresh ingredients. It took two hours.”

传统翻译可能会错译“it”为“饭菜”(正确是“准备过程”)。

怎么做?

让Agentic AI先梳理因果推理链,再翻译。具体步骤:

提取上下文的“实体”(比如“chef”“meal”“ingredients”);分析“动作-对象”关系(比如“prepared”的对象是“meal”,“took two hours”的对象是“preparing”);确认指代对象;翻译。

提示工程示例

原文:

“The team spent months developing the software. It crashed on the first day of launch.”

提示词设计(要求推理链):

请按照以下步骤翻译:

1. 列出上下文的实体:team(团队)、software(软件)、launch(发布);

2. 分析动作-对象关系:

- "spent months developing" 的对象是 "software";

- "crashed" 的对象是 "software"(因为软件会崩溃,团队不会);

3. 确认指代:"It" 指 "software";

4. 翻译要求:保留因果关系,"crashed" 译为“崩溃”(符合技术语境)。

请输出推理过程+翻译结果。

输出结果:

推理过程:

实体:team(团队)、software(软件)、launch(发布);动作-对象:“developing” → “software”;“crashed” → “software”;指代:“It” → “software”。

翻译:“团队花了数月时间开发这款软件。它在发布第一天就崩溃了。”

工具实现:用LangChain的“Chain”做推理

LangChain的“SequentialChain”可以将推理步骤拆分成多个环节,确保逻辑连贯。以下是代码示例:

from langchain.chains import SequentialChain, LLMChain

from langchain.prompts import PromptTemplate

from langchain.llms import OpenAI

# 初始化LLM

llm = OpenAI(temperature=0, openai_api_key="YOUR_API_KEY")

# 步骤1:提取实体

entity_prompt = PromptTemplate(

input_variables=["text"],

template="请列出以下文本中的实体:{text}

实体列表:"

)

entity_chain = LLMChain(llm=llm, prompt=entity_prompt, output_key="entities")

# 步骤2:分析动作-对象关系

relation_prompt = PromptTemplate(

input_variables=["text", "entities"],

template="文本:{text}

实体:{entities}

请分析动作-对象关系:"

)

relation_chain = LLMChain(llm=llm, prompt=relation_prompt, output_key="relations")

# 步骤3:确认指代

referent_prompt = PromptTemplate(

input_variables=["text", "relations"],

template="文本:{text}

动作-对象关系:{relations}

请确认划线词的指代对象:"

)

referent_chain = LLMChain(llm=llm, prompt=referent_prompt, output_key="referent")

# 步骤4:翻译

translate_prompt = PromptTemplate(

input_variables=["text", "referent"],

template="文本:{text}

指代对象:{referent}

请翻译:"

)

translate_chain = LLMChain(llm=llm, prompt=translate_prompt, output_key="translation")

# 组合成 SequentialChain

overall_chain = SequentialChain(

chains=[entity_chain, relation_chain, referent_chain, translate_chain],

input_variables=["text"],

output_variables=["entities", "relations", "referent", "translation"],

verbose=True # 打印推理过程

)

# 测试

text = "The team spent months developing the software. It crashed on the first day of launch."

result = overall_chain.run(text)

print("翻译结果:", result["translation"])

技巧3:领域知识图谱的“动态融合”——解决专业术语“译不准”的问题

为什么需要?

专业领域(法律、医学、科技)的翻译,术语准确性是生命线。比如:

法律文本中的“force majeure”必须译为“不可抗力”(而非“无法抗拒的力量”);医学文本中的“myocardial infarction”必须译为“心肌梗死”(而非“心肌梗塞”——注意“塞”和“死”的区别);科技文本中的“API”必须译为“应用程序编程接口”(而非“接口”)。

传统翻译用静态术语库(比如Excel表格),但术语会更新(比如新的医学名词),而且无法处理“一词多义”(比如“bug”在日常是“虫子”,在科技是“漏洞”)。

怎么做?

用领域知识图谱(Knowledge Graph)动态补充术语信息。知识图谱是“实体-关系”的网络(比如“force majeure”→“法律术语”→“不可抗力”),Agentic AI可以实时调用知识图谱API,确认术语的准确译法。

提示工程示例

原文(法律合同):

“The contract shall be terminated if either party is unable to perform due to force majeure.”

提示词设计(调用法律知识图谱):

请按照以下步骤翻译:

1. 识别专业术语:force majeure;

2. 调用法律知识图谱查询:force majeure → 法律术语,译为“不可抗力”(定义:不能预见、不能避免并不能克服的客观情况);

3. 翻译要求:保留合同的严谨性,“terminated”译为“终止”,“perform”译为“履行”。

请输出术语查询结果+翻译结果。

输出结果:

术语查询:force majeure → 不可抗力(法律术语);

翻译:“若任何一方因不可抗力无法履行合同,本合同终止。”

工具实现:用DBpedia知识图谱

DBpedia是免费的通用知识图谱,包含大量领域术语。以下是用Python调用DBpedia的示例:

import requests

def query_dbpedia(term):

"""调用DBpedia查询术语"""

url = "https://dbpedia.org/sparql"

query = f"""

SELECT ?label WHERE {{

dbr:{term} rdfs:label ?label .

FILTER (lang(?label) = 'zh') # 取中文标签

}}

"""

params = {"query": query, "format": "json"}

response = requests.get(url, params=params)

data = response.json()

if data["results"]["bindings"]:

return data["results"]["bindings"][0]["label"]["value"]

else:

return term # 没有结果则返回原词

# 测试

term = "Force_majeure" # DBpedia中的实体名

chinese_term = query_dbpedia(term)

print(f"{term} → {chinese_term}") # 输出:Force_majeure → 不可抗力

提示词整合:将知识图谱的结果注入提示词,比如:

术语查询结果:{chinese_term}({query_dbpedia(term)})

请翻译:{text}

技巧4:文化隐喻的“情境化对齐”——让翻译“有灵魂”

为什么需要?

文化隐喻是翻译的“天花板”——它承载了一个民族的历史、价值观和生活方式。比如:

中文的“龙”(吉祥、权力)≠ 英文的“dragon”(邪恶、暴力);中文的“画饼充饥”(空口承诺)≠ 英文的“draw a cake to satisfy hunger”(字面意思);英文的“break a leg”(祝好运)≠ 中文的“打断腿”(诅咒)。

传统翻译要么“直译”(失去隐喻意义),要么“意译”(失去原文化意象),而Agentic AI可以情境化对齐——先分析隐喻的“情境意义”,再找到目标语言中“情境匹配”的表达。

怎么做?

文化隐喻翻译的核心是“情境优先,意象其次”,具体步骤:

分析原隐喻的“情境意义”(比如“画饼充饥”→“用空口承诺安慰人”);在目标语言中找到“情境匹配”的隐喻(比如英文的“castles in the air”→“空中楼阁”,同样表示“不切实际的承诺”);保留原文化意象(如果目标语言有对应意象,比如“龙”译为“loong”而非“dragon”)。

提示工程示例

原文(中文广告标语):

“我们的产品像“雨后春笋”一样快速增长。”

提示词设计(情境化对齐):

请按照以下步骤翻译:

1. 分析原隐喻的情境意义:“雨后春笋”→ 形容增长速度快、数量多;

2. 寻找英文中情境匹配的隐喻:“spring up like mushrooms”(像蘑菇一样冒出来,同样形容快速增长);

3. 翻译要求:保留原句的生动性,“产品”译为“products”,“快速增长”译为“growing rapidly”。

请输出情境分析+翻译结果。

输出结果:

情境分析:“雨后春笋”→ 快速增长、数量多;

翻译:“Our products are growing rapidly, springing up like mushrooms.”

另一个例子:保留文化意象

原文(中文神话):

“龙是中国文化中的吉祥象征。”

提示词设计(保留意象):

请按照以下步骤翻译:

1. 分析原隐喻的文化意象:“龙”→ 中国文化中的吉祥、权力象征,不同于英文的“dragon”(邪恶);

2. 翻译要求:保留“龙”的原意象,译为“loong”(国际通用的中文“龙”译法);

3. 补充解释(可选):如果目标读者不熟悉“loong”,可以加脚注。

请翻译:"龙是中国文化中的吉祥象征。"

输出结果:

“The loong is a symbol of good fortune in Chinese culture.”

技巧5:多轮反馈式“上下文校准”——解决翻译“不一致”的问题

为什么需要?

翻译的“一致性”是基础要求——比如:

前文译“Alice”为“爱丽丝”,后面不能译“艾丽丝”;前文译“New York”为“纽约”,后面不能译“新约克”;法律文本中的“合同”要始终译为“contract”,不能有时译为“agreement”。

传统翻译模型没有“记忆”,每句话都是“独立处理”,很容易出现不一致。而Agentic AI可以多轮反馈——将前面的翻译决策存储在记忆中,每轮翻译前检查一致性。

怎么做?

构建翻译决策记忆库(比如键值对:“Alice”→“爱丽丝”,“New York”→“纽约”),每轮翻译前:

提取当前句子中的“需要一致的元素”(比如人名、地名、术语);检查记忆库中是否有已有的翻译决策;如果有,使用记忆库中的译法;如果没有,新增翻译决策到记忆库。

提示工程示例

原文(小说片段):

“Alice met Bob in New York. Alice invited Bob to her apartment.”

提示词设计(多轮反馈):

请按照以下步骤翻译:

1. 调取翻译决策记忆库:

- Alice → 爱丽丝;

- Bob → 鲍勃;

- New York → 纽约;

2. 检查当前句子中的元素:Alice、Bob、her apartment;

3. 翻译要求:使用记忆库中的译法,保持一致性;

4. 新增决策(如果有):her apartment → 她的公寓(存入记忆库)。

请输出翻译结果+更新后的记忆库。

输出结果:

翻译:“爱丽丝在纽约遇到了鲍勃。爱丽丝邀请鲍勃去她的公寓。”

更新后的记忆库:Alice→爱丽丝,Bob→鲍勃,New York→纽约,her apartment→她的公寓。

工具实现:用LangChain的“Memory”模块

LangChain的“ConversationBufferMemory”可以存储对话历史(即翻译决策),以下是代码示例:

from langchain.chains import LLMChain

from langchain.prompts import PromptTemplate

from langchain.llms import OpenAI

from langchain.memory import ConversationBufferMemory

# 初始化记忆库

memory = ConversationBufferMemory(memory_key="translation_memory")

# 提示词模板(包含记忆库)

prompt = PromptTemplate(

input_variables=["text", "translation_memory"],

template="翻译决策记忆库:{translation_memory}

请翻译以下文本,保持一致性:{text}"

)

# 初始化LLM Chain

llm_chain = LLMChain(

llm=OpenAI(temperature=0, openai_api_key="YOUR_API_KEY"),

prompt=prompt,

memory=memory,

verbose=True

)

# 第一轮翻译(Alice met Bob in New York.)

text1 = "Alice met Bob in New York."

result1 = llm_chain.run(text1)

print("第一轮翻译:", result1) # 输出:“爱丽丝在纽约遇到了鲍勃。”

# 第二轮翻译(Alice invited Bob to her apartment.)

text2 = "Alice invited Bob to her apartment."

result2 = llm_chain.run(text2)

print("第二轮翻译:", result2) # 输出:“爱丽丝邀请鲍勃去她的公寓。”

# 查看记忆库

print("记忆库:", memory.load_memory_variables({}))

# 输出:{"translation_memory": "Human: Alice met Bob in New York.

AI: 爱丽丝在纽约遇到了鲍勃。

Human: Alice invited Bob to her apartment.

AI: 爱丽丝邀请鲍勃去她的公寓。"}

四、进阶探讨:Agentic AI翻译的“陷阱”与“最佳实践”

掌握了技巧,还要避开“陷阱”——以下是提示工程架构师常踩的4个坑,以及对应的解决方法。

1. 陷阱1:记忆过载——“太多信息反而影响翻译”

问题:分层记忆系统中,如果长期记忆存储了太多无关信息(比如翻译小说时,存入了“维多利亚时代的交通方式”,但当前段落是关于“社交礼仪”),会干扰模型的判断。

解决方法:

用“相似度阈值”过滤无关记忆(比如只调取相似度>0.8的内容);定期清理记忆库(比如删除3个月以上未使用的内容);对长期记忆进行“主题分类”(比如“社交礼仪”“交通方式”“服饰”),翻译时只调取对应主题的记忆。

2. 陷阱2:推理成本过高——“推理链太长,翻译变慢”

问题:因果推理链如果拆分成太多步骤(比如“提取实体→分析关系→确认指代→检查一致性→翻译”),会增加API调用次数,导致翻译速度变慢。

解决方法:

对简单句子(比如“Alice is a student.”)跳过推理链,直接翻译;用“Few-shot Prompting”(少量示例)压缩推理步骤(比如给模型一个“推理+翻译”的示例,让它模仿);使用更高效的LLM(比如GPT-4 Turbo比GPT-3.5更快)。

3. 陷阱3:文化对齐的“过度本地化”——“失去原文化特色”

问题:为了适配目标语言的文化,过度修改原隐喻,导致原文化特色丢失。比如翻译中国神话中的“龙”为“dragon”(邪恶),会误导目标读者。

解决方法:

对于“文化独有的意象”(比如“龙”“饺子”“京剧”),保留原词(译为“loong”“jiaozi”“Peking Opera”),并加脚注解释;对于“通用隐喻”(比如“画饼充饥”→“castles in the air”),使用目标语言的对应隐喻;让目标读者“适应原文化”——比如“饺子”已经成为国际通用词,不需要译为“dumpling”。

4. 陷阱4:工具调用的“准确性依赖”——“知识图谱错了,翻译也错了”

问题:如果知识图谱中的信息错误(比如“force majeure”被错误地译为“强制 majeure”),会导致翻译错误。

解决方法:

使用权威的知识图谱(比如法律领域用“中国法律法规数据库”,医学领域用“PubMed”);加入“双重验证”(比如调用两个知识图谱,对比结果);允许人工修正(比如翻译后,让人工检查术语准确性)。

最佳实践总结

上下文优先:翻译前先分析上下文(结构、逻辑、文化),再动手;记忆分层:用短期→中期→长期记忆系统,解决长文本问题;推理适度:简单句子跳过推理链,复杂句子用“最少步骤”推理;文化平衡:保留原文化特色,同时适配目标语言的情境;工具可靠:选择权威的知识图谱和向量数据库,避免错误。

五、结论:从“机器翻译”到“Agent翻译”的未来

1. 核心要点回顾

本文讲了5个用Agentic AI升级翻译上下文理解的技巧:

分层上下文记忆:解决长文本“记不住”;因果推理链:解决指代与逻辑连贯;领域知识图谱:解决专业术语“译不准”;文化隐喻情境化对齐:解决翻译“没灵魂”;多轮反馈校准:解决翻译“不一致”。

2. 未来展望

Agentic AI翻译的下一个趋势是多模态+实时互动:

多模态翻译:结合文本、图像、语音的上下文(比如翻译图片中的“龙”,同时参考图片中的“祥云”,确认是“吉祥的龙”);实时跨语言对话:比如在国际会议中,Agentic AI能记住前面的对话内容,实时翻译并保持一致性;个性化翻译:根据用户的语言风格(比如“正式”“口语化”)调整翻译结果。

3. 行动号召

现在就动手实践吧!你可以:

用LangChain+Pinecone构建一个分层记忆翻译Agent;用DBpedia调用领域知识,翻译一篇专业文本;在评论区分享你的实践结果,或提出问题;推荐资源:

LangChain官方文档:https://langchain.com/docs/Pinecone向量数据库:https://www.pinecone.io/OpenAI Agent文档:https://platform.openai.com/docs/guides/function-calling

最后一句话:翻译的本质是“传递意义”,而Agentic AI的价值,就是让机器像人类一样“理解意义”——这不是取代译者,而是让译者更专注于“有温度的创作”。

期待你用Agentic AI做出“有灵魂”的翻译!

作者:[你的名字]

公众号:[你的公众号]

github:[你的github链接]

备注:本文代码示例基于LangChain v0.0.300+、OpenAI API v1,实际使用时请调整版本。

相关文章