由于网上信息较少,在搭建ollama时受到网络限制,选择离线安装模式。

官网下载 ollama linux amd64.tgz,

一、安装ollama

1.安装:

1)tar -zxvf Ollama Linux AMD64.tgz

2)将 ollama 执行命令移动到 /usr/bin 目录下,执行sudo mv bin/ollama /usr/bin/ollama

2.配置权限

1)创建执行用户(自用可忽略), 可以直接设置 root 或其他用户执行权限)

sudo useradd -r -s /bin/false -U -m -d /usr/share/ollama ollama

sudo usermod -a -G ollama $(whoami)

2)ollma必备配置文件

创建文件 /etc/systemd/system/ollama.service, 并填充如下内容, 其中的 User 和 Group 根据权限填写

Description=Ollama Service

After=network-online.target

[Service]

ExecStart=/usr/bin/ollama serve

User=ollama

Group=ollama

Restart=always

RestartSec=3

Environment=“PATH=$PATH”

[Install]

WantedBy=default.target

3)加载配置

sudo systemctl daemon-reload

4)设置开机启动

sudo systemctl enable ollama

5)启动 ollama 服务

sudo systemctl start ollama

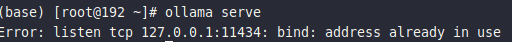

3.验证ollama

4. 应用ollama pull命令 下载Deepseek、Qwen等模型

二、安装openwebui

我通过VMware workstation虚拟环境搭建ubuntu24.04 后安装openwebui

1.kylinV11中安装VMware Workstation,下载 VMware-Workstation-Full-25H2-24995812.x86_64.bundle,

1)安装时先获取权限

sudo chmod +x VMware-Workstation-Full-15.0.0-10134415.x86_64.bundle

2)安装运行

./VMware-Workstation-Full-15.0.0-10134415.x86_64.bundle

2.安装Ubuntu24.04

(略)

3.apt安装必要基础环境

1)包括buildesstentials,net-tools,jdk-default,apt-transport-https ca-certificates curl software-properties-common等

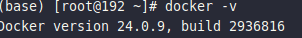

2)apt安装dock.io

验证一下:

3)配置docker国内源

大量文章,略

4)拉取openwebui

docker pull ghcr.nju.edu.cn/open-webui/open-webui:main

5)安装

docker run -d -p 3000:8080 -e OLLAMA_BASE_URL=(主机IP):11434 -v open-webui:/app/backend/data –name open-webui –restart always ghcr.nju.edu.cn/open-webui/open-webui:main

浏览器验证 localhost:3000

相关文章