一个开源的干净且可自定义的 RAG UI,用于与您的文档进行聊天。构建时同时思考了最终用户和开发人员。

介绍

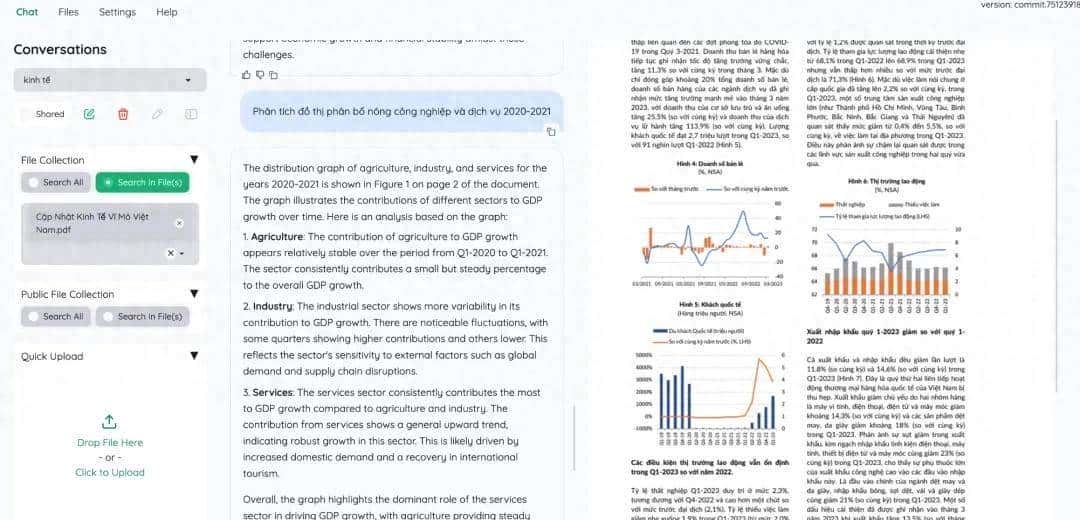

该项目作为一个功能性的 RAG UI,适用于想要对其文档进行 QA 的最终用户和想要构建自己的 RAG 管道的开发人员。

- 对于最终用户:

- 基于 RAG 的 QA 的简洁用户界面。

- 支持 LLM API 提供商(OpenAI、AzureOpenAI、Cohere 等)和本地 LLM(通过ollama和llama-cpp-python)。

- 简单的安装脚本。

- 对于开发人员:

- 用于构建您自己的基于 RAG 的文档 QA 管道的框架。

- 使用提供的 UI(使用 Gradio 构建)自定义并查看 RAG 管道的运行情况。

主要特点

- 托管您自己的文档 QA (RAG) web-UI。支持多用户登录,在私人/公共收藏中组织您的文件,与他人协作并分享您最喜爱的聊天。

- 组织您的 LLM 和嵌入模型。支持本地 LLM 和流行的 API 提供商(OpenAI、Azure、Ollama、Groq)。

- 混合 RAG 管道。合理的默认 RAG 管道采用混合(全文和矢量)检索器 + 重新排名,以确保最佳检索质量。

- 多模式问答支持。使用图表和表格支持对多个文档执行问答。支持多模式文档解析(可在 UI 上选择选项)。

- 通过文档预览提前查看引文。默认情况下,系统将提供详细的引文以确保 LLM 答案的正确性。直接在浏览器内置的 PDF 查看器中查看引文(包括相关分数) ,并突出显示。当检索管道返回相关性低的文章时发出警告。

- 支持复杂的推理方法。使用问题分解来回答您的复杂/多跳问题。支持使用 ReAct、ReWOO 和其他代理进行基于代理的推理。

- 可配置设置 UI。您可以在 UI 上调整检索和生成过程的最重大方面(包括提示)。

- 可扩展。基于 Gradio 构建,您可以随意自定义/添加任何 UI 元素。此外,我们的目标是支持多种文档索引和检索策略。GraphRAG索引管道作为示例提供。

Github:https://github.com/Cinnamon/kotaemon

官方文档:

https://cinnamon.github.io/kotaemon/

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...