1. 部署Ollama

1.1 Ollama简介

Ollama是一个大模型容器管理框架,用于快速在本地运行大模型。

Ollama官网:https://www.ollama.com

Ollama github:https://github.com/ollama/ollama

1.2 Docker部署Ollama

(1) 拉取镜像

docker pull ollama/ollama(2) 运行容器

# CPU 模式

docker run -d -p 11434:11434 -v /home/docker/ollama:/root/.ollama --name ollama ollama/ollama

# GPU 模式

docker run --gpus=all -d -p 11434:11434 -v /home/docker/ollama:/root/.ollama --name ollama ollama/ollama可以使用基于 docker-compose 进行部署。

docker-compose.yml:

services:

ollama:

image: ollama/ollama

container_name: ollama

restart: unless-stopped

ports:

- 11434:11434

volumes:

- /home/docker/ollama:/root/.ollama

environment:

# 允许局域网跨域形式访问API

OLLAMA_HOST=0.0.0.0:11434

OLLAMA_ORIGINS=*在docker-compose.yml目录运行部署语句:

docker compose up -d1.3 下载运行大模型

(1) 进入容器

docker exec -it ollama /bin/bash(2) 验证

ollama --version如果显示Ollama版本信息,说明安装成功。

(3) 下载大模型

ollama pull deepseek-r1:1.5b(4) 运行大模型

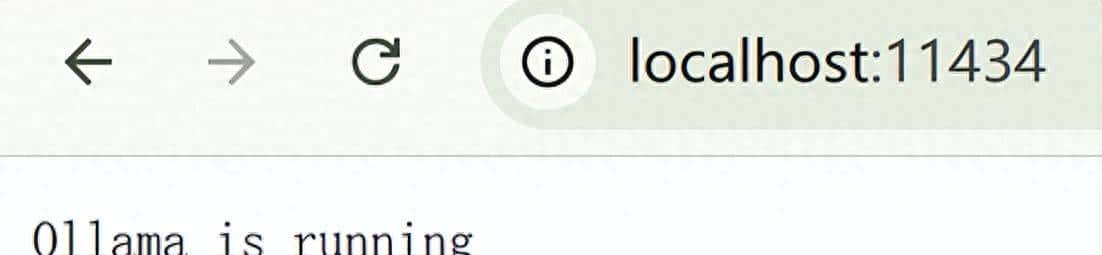

ollama run deepseek-r1:1.5b运行后在浏览器中打开 http://localhost:11434

2. 部署Open WebUI

2.1 Open WebUI简介

Open WebUI是用于与大模型交互的Web界面。

2.2 Docker部署Open WebUI

(1) 拉取镜像

docker pull ghcr.io/open-webui/open-webui:latest(2) 运行容器

docker run -d

-p 3000:8080

--add-host=host.docker.internal:host-gateway

--name open-webui

--restart always

ghcr.io/open-webui/open-webui:latest其中,参数

-p 3000:8080 :将 WebUI 的 8080 端口映射到本地的 3000 端口

2.3 设置Open WebUI

浏览器中打开http://localhost:3000,首次打开需要创建管理员账号。

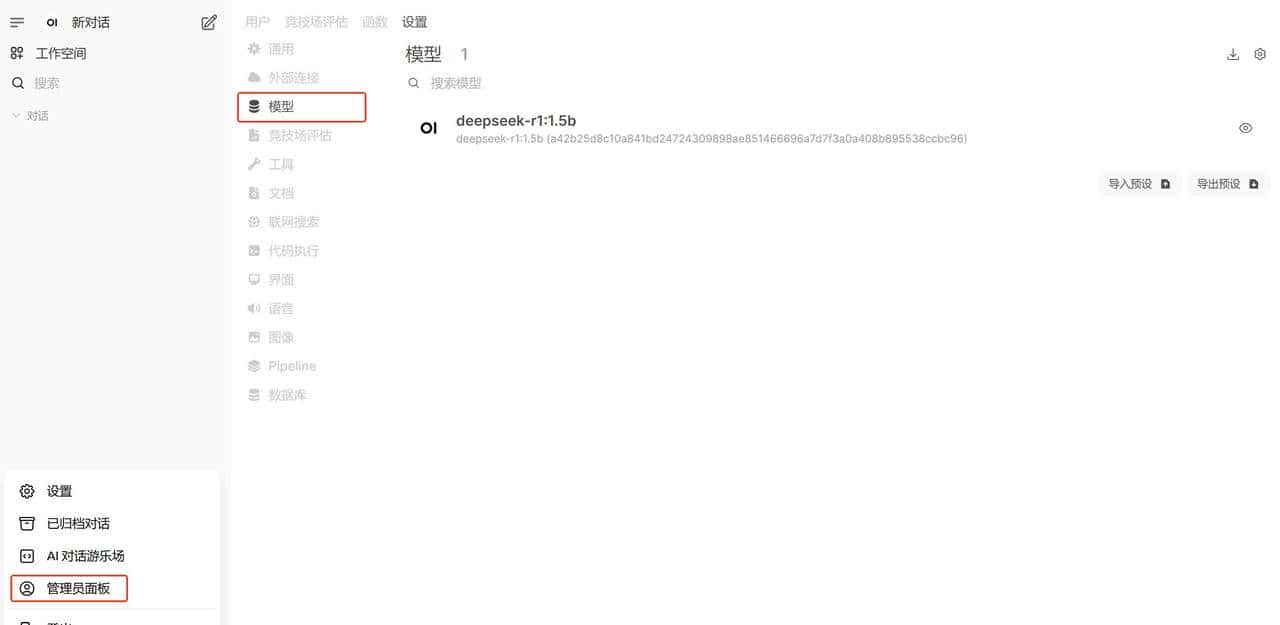

(1) 管理模型

【管理员模板】-【模型】进入管理模型,选择Ollama,可以增加、删除模型。

(2) 对话

对话界面选择安装的大模型

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...