从测试到上线:AI应用架构师主导智能供应商评估系统的灰度发布全流程解析

元数据框架

标题

从测试到上线:AI应用架构师主导智能供应商评估系统的灰度发布全流程解析

关键词

AI灰度发布、智能供应商评估、模型迭代、流量路由、数据漂移、风险控制、持续交付

摘要

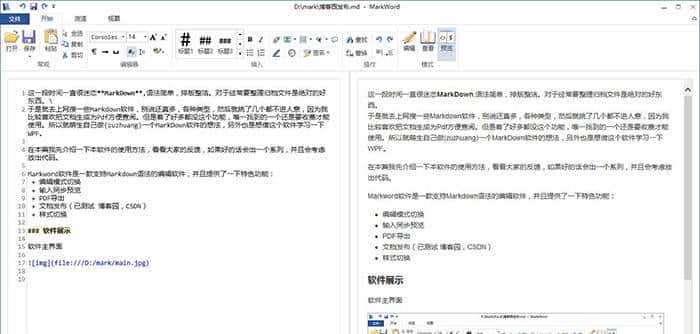

灰度发布是AI系统从测试到上线的“风险缓冲带”——它既不是传统软件的“全量切换”,也不是简单的“功能试用”,而是针对AI模型的概率性、数据依赖性和业务决策敏感性设计的增量交付机制。本文以“智能供应商评估系统”为具体场景,从架构师视角拆解灰度发布的全流程:从概念层的“风险分层模型”到架构层的“流量-模型-评估闭环”,从实现层的“代码优化”到运营层的“指标监控”,最终回答一个核心问题:如何让AI模型在复杂业务场景中“安全着陆”? 本文融合理论推导、架构设计、代码实现和实践案例,覆盖从入门到专家的多层次需求,是AI应用架构师的“灰度发布操作手册”。

1. 概念基础:AI灰度发布的特殊性与场景定义

要理解AI系统的灰度发布,首先需要明确两个前提:灰度发布的本质和AI系统的“非传统”特性。

1.1 灰度发布的本质:风险可控的增量交付

灰度发布(Canary Release)的核心逻辑源于“金丝雀实验”——18世纪煤矿工人用金丝雀检测瓦斯:若金丝雀死亡,立即撤离。类比到软件发布:

“金丝雀群体”:小比例用户/流量;“瓦斯检测”:验证新功能/模型的稳定性、性能和业务价值;“撤离机制”:若出现问题,快速回滚至稳定版本。

传统软件的灰度发布聚焦功能验证(如“新按钮是否能点击”),而AI系统的灰度发布需要额外解决三个问题:

模型的概率性输出:AI模型给出的是“供应商违约概率0.8”而非“是/否”的确定性结果,需验证概率与业务决策的匹配度;数据分布漂移:训练数据与线上数据的分布差异(如供应商突然新增“ESG评估”维度)会导致模型性能下降;业务决策的敏感性:供应商评估结果直接影响采购预算、合同签订,错误决策的代价远高于传统软件的“功能失效”。

1.2 智能供应商评估系统的场景定义

我们以某大型制造企业的“智能供应商评估系统”为例,明确场景边界:

业务目标:替代传统人工评估(耗时久、主观化),自动化输出供应商的“综合能力评分”(范围0-10),覆盖资质合规、绩效历史、风险预警、协作效率四大维度;系统架构:由“数据采集层(对接ERP/CRM/天眼查)→特征工程层(提取供应商30+特征)→模型层(XGBoost+Transformer混合模型)→应用层(评估报告生成)”组成;核心痛点:模型对“新类型供应商”(如新能源材料供应商)的评估精度低,且线上数据与训练数据的“行业分布”差异大(训练数据以传统制造业为主)。

1.3 关键术语精确化

为避免歧义,先定义本文核心术语:

流量染色:给请求标记“灰度/稳定”标签,用于路由和分析;模型版本管理:用唯一ID(如

model-v1.2.3

2. 理论框架:AI灰度发布的第一性原理推导

AI灰度发布的设计需回归“风险控制”的第一性原理。我们通过风险分层模型、流量分配数学框架和评估指标体系,建立可量化的理论基础。

2.1 风险分层模型:AI系统的三维风险矩阵

AI系统的风险可分为三层(从技术到业务),每层对应不同的灰度验证目标:

| 风险层级 | 风险类型 | 示例 | 灰度验证目标 |

|---|---|---|---|

| 模型层 | 性能风险(精度/偏差) | 新能源供应商的评估精度比训练集低30% | 验证模型对新数据的适配性 |

| 系统层 | 可靠性风险(延迟/宕机) | 模型推理延迟从100ms升至500ms | 验证系统的高并发承载能力 |

| 业务层 | 决策风险(用户信任) | 采购团队因模型解释性差拒绝使用 | 验证模型输出与业务决策的匹配度 |

第一性原理结论:灰度发布的核心是按层级拆解风险,用小流量验证高风险点。

2.2 流量分配的数学框架:从“拍脑袋”到“可计算”

流量分配是灰度发布的核心决策——分配多少流量给灰度版本?传统做法是“经验值(如10%)”,但AI系统需用数学模型量化:

2.2.1 流量分配比例的计算模型

设:

( R ):可接受的最大风险损失(如业务指标下降不超过5%);( I ):灰度版本的预期影响度(如覆盖10%用户时,业务指标变化的方差);( p ):灰度流量比例(0≤p≤1)。

则流量分配比例的计算公式为:

示例:若可接受风险损失R=5%,预期影响度I=0.04(方差),C=1.5,则:

2.2.2 流量分配的策略选择

随机分配:基于用户ID的哈希值(如MD5末位),适合无明显用户分层的场景;分层分配:按用户特征(如“采购金额>100万的用户”)分配,适合验证特定用户群的模型效果;动态分配:根据实时指标调整(如模型精度提升则增加流量),适合快速迭代的场景。

2.3 评估指标体系:从“模型精度”到“业务价值”

AI系统的灰度评估需覆盖模型、系统、业务三个维度,避免“模型精度高但业务没用”的陷阱:

2.3.1 模型指标(技术层)

精度指标:Precision(精准率,避免误判优质供应商)、Recall(召回率,避免漏判高风险供应商)、F1-score(综合指标);稳定性指标:预测结果的方差(如同一供应商多次评估的分数波动≤1);漂移指标:特征分布差异(如线上特征均值与训练集的绝对差≤20%,用KS检验或PSI指标量化)。

2.3.2 系统指标(工程层)

性能指标:QPS(每秒请求数)、延迟(P95≤200ms)、错误率(≤0.1%);可靠性指标:服务可用性(≥99.9%)、回滚时间(≤5分钟);资源指标:CPU利用率(≤70%)、内存占用(≤4GB)。

2.3.3 业务指标(价值层)

效率指标:评估耗时从4小时缩短至10分钟(效率提升率= (4×60-10)/240=95.8%);效果指标:供应商违约率从8%降至5%(风险降低率=37.5%);满意度指标:采购团队对模型的信任度评分(≥4.5/5)。

2.4 竞争范式分析:AI灰度 vs 传统灰度

| 维度 | 传统软件灰度发布 | AI系统灰度发布 |

|---|---|---|

| 验证核心 | 功能正确性 | 模型性能+数据适配+业务匹配 |

| 流量分配 | 固定比例 | 动态调整(基于指标) |

| 回滚触发条件 | 功能失效 | 模型精度下降/数据漂移/业务指标恶化 |

| 评估周期 | 短(小时级) | 长(天级/周级,需积累数据) |

3. 架构设计:AI灰度发布的闭环系统

智能供应商评估系统的灰度发布架构需实现**“流量路由-模型服务-数据采集-评估分析-决策调整”的闭环**。我们用“组件分解+交互模型”的方式设计架构。

3.1 核心组件分解

灰度发布架构由5个核心组件组成(从请求入口到决策出口):

3.1.1 流量路由层(Traffic Router)

功能:根据流量分配策略,将请求转发至“稳定版模型”或“灰度版模型”;技术选型:Nginx(轻量级,支持Lua脚本定制路由规则)、API Gateway(如Kong,支持流量染色和监控);关键设计:

流量染色:在请求头中添加

X-Canary-Version

v1.2.3

backup

3.1.2 模型服务层(Model Serving)

功能:将AI模型封装为可调用的API,支持版本管理和高并发;技术选型:TensorFlow Serving(支持TensorFlow模型)、TorchServe(支持PyTorch模型)、Triton Inference Server(多框架支持);关键设计:

版本隔离:用不同的服务端口或路径区分版本(如

/v1/stable/predict

/v1/gray/predict

3.1.3 数据采集层(Data Collector)

功能:收集灰度请求的“输入-输出-日志”,用于后续评估;技术选型:Fluentd(日志收集)、Kafka(消息队列,缓冲高并发数据)、Prometheus( metrics 采集);关键设计:

数据关联:用

Request-ID

3.1.4 评估分析层(Evaluation & Analysis)

功能:实时计算模型、系统、业务指标,生成评估报告;技术选型:

实时分析:Flink(流处理,计算P95延迟、实时F1-score);离线分析:Spark(批量处理,计算数据漂移、长期业务指标);可视化:Grafana(仪表盘,展示流量比例、指标变化);

关键设计:

指标阈值:设置报警阈值(如模型F1-score<0.8时触发警报);根因分析:用因果推断(如DoWhy库)区分“模型问题”和“数据问题”(如评估分数下降是因为模型精度低,还是供应商数据质量差?)。

3.1.5 决策引擎(Decision Engine)

功能:根据评估结果自动调整流量分配或触发回滚;技术选型:规则引擎(如Drools)、强化学习模型(如DQN,自动学习流量分配策略);关键设计:

规则配置:

若灰度模型F1-score > 稳定版+5% → 流量增加20%;若数据漂移PSI>0.2 → 暂停灰度,触发模型重新训练;若系统错误率>1% → 立即回滚至稳定版;

人工审核:关键决策(如全量上线)需业务团队确认,避免“技术驱动业务”的陷阱。

3.2 组件交互模型(Mermaid图表)

以下是灰度发布架构的交互流程:

graph TD

A[用户请求] --> B{流量路由层}

B -->|稳定流量| C[稳定模型服务]

B -->|灰度流量| D[灰度模型服务]

C --> E[数据采集层]

D --> E

E --> F[Kafka消息队列]

F --> G[实时分析(Flink)]

F --> H[离线分析(Spark)]

G --> I[评估仪表盘(Grafana)]

H --> I

I --> J[决策引擎]

J -->|调整流量| B

J -->|回滚| C

J -->|全量上线| D

J -->|触发训练| K[模型训练 pipeline]

3.3 设计模式应用

为提升架构的可扩展性和可维护性,我们应用了以下设计模式:

3.3.1 特征开关(Feature Toggle)

用开关控制灰度功能的开启(如“是否启用新能源供应商特征”),避免修改代码。示例配置(YAML):

features:

new_energy_supplier:

enabled: true

gray_ratio: 0.2 # 仅20%灰度用户可见

3.3.2 版本化数据管道

确保灰度模型和稳定模型使用一致的数据处理逻辑(如特征归一化、缺失值填充),避免“数据预处理不一致”导致的模型性能差异。示例(Python):

from sklearn.preprocessing import StandardScaler

# 版本化的特征预处理函数

def preprocess_features_v1(data):

scaler = StandardScaler()

return scaler.fit_transform(data[['revenue', 'contract_count']])

def preprocess_features_v2(data):

# v2版本新增“新能源资质”特征

scaler = StandardScaler()

return scaler.fit_transform(data[['revenue', 'contract_count', 'new_energy_cert']])

3.3.3 蓝绿部署+灰度发布

先用蓝绿部署(Blue-Green Deployment)将灰度模型部署到测试环境,验证稳定性后,再用灰度发布逐步推广到生产环境——结合二者的优势(蓝绿的“快速回滚”+灰度的“增量验证”)。

4. 实现机制:从代码到落地的关键细节

架构设计的价值在于“可实现”。本节将拆解灰度发布的核心代码实现、边缘情况处理和性能优化。

4.1 流量路由层的代码实现(Nginx+Lua)

Nginx是最常用的流量路由工具,我们用Lua脚本实现基于用户ID的随机分配:

4.1.1 Nginx配置文件(

nginx.conf

nginx.conf

http {

upstream stable_model {

server stable-model-service:8000;

}

upstream gray_model {

server gray-model-service:8000;

server stable-model-service:8000 backup; # 灰度宕机时切回稳定版

}

server {

listen 80;

location /evaluate {

access_by_lua_file /etc/nginx/lua/gray_router.lua; # 流量路由逻辑

}

}

}

4.1.2 Lua路由脚本(

gray_router.lua

gray_router.lua

local function is_gray_user(user_id)

-- 计算用户ID的哈希值(MD5)

local md5 = ngx.md5(user_id)

-- 取哈希值的最后一位(16进制),转换为整数

local last_char = string.sub(md5, -1)

local num = tonumber(last_char, 16)

-- 灰度比例:20%(num < 16*0.2=3.2 → num≤3)

return num <= 3

end

local user_id = ngx.var.arg_user_id -- 从请求参数中获取user_id

if user_id and is_gray_user(user_id) then

ngx.var.upstream = "gray_model" -- 转发到灰度模型

ngx.req.set_header("X-Canary-Version", "v1.2.3") -- 添加流量染色头

else

ngx.var.upstream = "stable_model" -- 转发到稳定模型

end

4.2 模型服务层的代码实现(Triton Inference Server)

Triton是NVIDIA推出的高性能模型服务框架,支持多模型版本管理。以下是灰度模型的部署配置:

4.2.1 模型目录结构

models/

├── supplier_evaluation/ # 模型名称

│ ├── 1/ # 稳定版(v1)

│ │ └── model.onnx

│ ├── 2/ # 灰度版(v2,新增新能源特征)

│ │ └── model.onnx

│ └── config.pbtxt # 模型配置文件

4.2.2 模型配置文件(

config.pbtxt

config.pbtxt

name: "supplier_evaluation"

platform: "onnxruntime_onnx"

max_batch_size: 32

input [

{

name: "input_features"

data_type: TYPE_FP32

dims: [30] # 稳定版:30个特征

}

]

output [

{

name: "score"

data_type: TYPE_FP32

dims: [1]

}

]

# 灰度版模型配置(v2)

version_policy: {

specific: {

versions: [1, 2] # 同时部署v1和v2

}

}

# 路由规则:根据请求头中的X-Canary-Version选择版本

dynamic_batching {

preferred_batch_size: [8, 16, 32]

}

request_processing {

request_header_route: {

header_name: "X-Canary-Version"

header_value: "v1.2.3"

model_version: 2

}

default_model_version: 1 # 默认使用v1(稳定版)

}

4.3 边缘情况处理

AI系统的灰度发布需覆盖以下边缘情况:

4.3.1 灰度模型服务宕机

通过Nginx的

backup

4.3.2 输入特征缺失

在模型服务层添加“缺失值填充”逻辑(如用均值填充数值特征,用“未知”填充分类特征),避免模型推理失败。示例(Python):

def handle_missing_features(data):

numeric_features = ['revenue', 'contract_count']

categorical_features = ['industry_type']

# 填充数值特征(均值)

for feat in numeric_features:

if pd.isna(data[feat]).any():

data[feat].fillna(data[feat].mean(), inplace=True)

# 填充分类特征(未知)

for feat in categorical_features:

if pd.isna(data[feat]).any():

data[feat].fillna('未知', inplace=True)

return data

4.3.3 模型输出异常

若模型输出的分数超过0-10的范围(如11或-2),触发“异常值处理”:

记录异常请求(包括输入特征和模型版本);返回稳定版模型的分数;触发警报,通知算法团队排查问题。

4.4 性能优化

AI系统的性能瓶颈通常在模型推理和数据传输,以下是优化技巧:

4.4.1 模型推理加速

用ONNX Runtime优化模型:将PyTorch/XGBoost模型转换为ONNX格式,推理速度提升2-5倍;批量推理:用Triton的

dynamic_batching

4.4.2 数据传输优化

用Protobuf替代JSON:Protobuf的序列化体积是JSON的1/3-1/5,降低网络延迟;压缩传输:用Gzip压缩请求和响应数据(Nginx支持

gzip on

5. 实际应用:灰度发布的全流程执行

本节以“智能供应商评估系统v2.0灰度发布”为例,拆解从准备→启动→迭代→全量的完整流程。

5.1 准备阶段:明确目标与规则

5.1.1 灰度目标

验证v2.0模型对“新能源供应商”的评估精度(目标:F1-score≥0.85);验证系统在高并发下的稳定性(目标:P95延迟≤200ms,错误率≤0.1%);收集采购团队的反馈(目标:信任度评分≥4.5/5)。

5.1.2 灰度用户选择

选择“新能源材料采购组”的100名用户作为灰度群体(占总用户的5%)——这些用户最了解新能源供应商的业务需求,能提供有价值的反馈。

5.1.3 监控配置

在Grafana中配置以下仪表盘:

流量比例:灰度流量占比(目标:初始5%);模型指标:F1-score(新能源供应商)、数据漂移PSI;系统指标:P95延迟、错误率;业务指标:评估耗时、采购团队反馈评分。

5.2 启动阶段:小流量验证

5.2.1 初始流量:5%

将灰度流量设置为5%(仅“新能源材料采购组”的用户),观察24小时:

模型指标:新能源供应商的F1-score=0.88(达标);系统指标:P95延迟=150ms(达标),错误率=0.05%(达标);业务反馈:采购团队认为“新能源资质”特征的解释性好,但希望增加“冷链物流能力”的评估维度。

5.2.2 调整与优化

根据业务反馈,在v2.0模型中新增“冷链物流能力”特征(通过对接物流系统的API获取数据),重新训练模型(v2.1),并将灰度流量保持5%继续验证。

5.3 迭代阶段:逐步扩大流量

5.3.1 流量提升至20%

当v2.1模型的F1-score稳定在0.90以上,将灰度流量扩大至20%(覆盖“电子元件采购组”的用户):

模型指标:电子元件供应商的F1-score=0.87(达标);系统指标:P95延迟=180ms(达标),错误率=0.08%(达标);业务反馈:电子元件采购组希望“增加供应商的交货准时率”特征。

5.3.2 流量提升至50%

新增“交货准时率”特征(从ERP系统提取数据),训练v2.2模型,将流量扩大至50%:

模型指标:全量供应商的F1-score=0.89(达标);系统指标:P95延迟=190ms(达标),错误率=0.09%(达标);业务反馈:采购团队对模型的信任度评分=4.7/5(达标)。

5.4 全量阶段:正式上线

当灰度流量达到50%且所有指标稳定3天,启动全量上线:

将v2.2模型升级为稳定版;关闭灰度流量,所有用户使用v2.2模型;持续监控7天,确认无异常;归档灰度版本(v2.0、v2.1),保留30天以备回滚。

5.5 实践经验总结

小步快跑:每次灰度只验证1-2个新功能/特征,避免“变更过大导致问题定位困难”;用户参与:让业务用户参与灰度测试,获取“接地气”的反馈(技术团队常忽略业务细节);快速回滚:确保回滚流程在5分钟内完成(用Kubernetes的

rollback

6. 高级考量:AI灰度发布的未来挑战

随着AI系统的复杂度提升,灰度发布需应对扩展性、安全性、伦理性的挑战。

6.1 扩展性挑战:从“单模型”到“多模型协同”

未来的智能供应商评估系统可能会用“多模型协同”(如用Transformer模型处理文本类特征,用XGBoost处理数值类特征),灰度发布需解决:

模型间的依赖关系:若灰度版Transformer模型的输出变化,如何影响XGBoost模型的性能?流量分配的复杂度:如何为每个模型分配独立的灰度流量?评估的一致性:如何确保多模型的评估结果与业务决策一致?

解决方案:采用“联邦灰度发布”——每个模型独立灰度,但共享评估指标(如综合评分的F1-score),确保整体性能达标。

6.2 安全性挑战:从“功能安全”到“AI安全”

AI系统的安全风险包括模型投毒(攻击者注入恶意数据,导致模型误判)、模型窃取(攻击者通过API调用获取模型参数)、决策操纵(攻击者篡改模型输出,让高风险供应商通过评估)。

灰度发布中的安全措施:

输入数据校验:在流量路由层过滤恶意输入(如“供应商名称包含特殊字符”);模型输出签名:为模型输出添加数字签名,防止篡改(如用RSA算法签名);异常行为检测:用异常检测模型(如Isolation Forest)监控灰度请求的行为(如短时间内多次评估同一供应商)。

6.3 伦理性挑战:从“技术正确”到“价值正确”

AI模型的偏见可能导致公平性问题(如对中小供应商的评估分数低于大型供应商),灰度发布需验证:

模型的公平性指标:如 demographic parity(不同规模供应商的评估通过率差异≤10%);业务决策的公平性:采购团队是否因模型偏见而拒绝与中小供应商合作?

解决方案:

在评估指标体系中加入“公平性指标”(如DI分数,Disparate Impact Ratio);让伦理委员会参与灰度决策(如当模型的DI分数<0.8时,禁止全量上线);提供“模型解释功能”(如SHAP值),让用户理解模型的决策逻辑,减少偏见的影响。

6.4 未来演化向量

自动灰度发布:用强化学习模型(如DQN)自动学习流量分配策略,无需人工干预;自修复灰度系统:当灰度模型出现问题时,自动触发模型重新训练(用联邦学习或增量学习),无需回滚;跨企业灰度发布:用联邦学习技术,在多个企业间共享模型但不共享数据,验证模型的通用性(如制造企业和零售企业的供应商评估模型)。

7. 综合与拓展:AI灰度发布的战略价值

7.1 跨领域应用:从供应商评估到泛AI场景

AI灰度发布的流程可复制到以下场景:

推荐系统:验证新推荐算法对用户点击率的提升;风控系统:验证新风险模型对欺诈检测率的提升;医疗诊断系统:验证新诊断模型对疾病识别率的提升。

核心逻辑都是**“用小流量验证高风险,用数据驱动决策”**。

7.2 研究前沿:从“经验驱动”到“数据驱动”

当前AI灰度发布的研究热点包括:

基于因果推断的评估:区分“模型效果”和“外部因素”(如供应商自身的业绩提升);基于强化学习的流量分配:让系统自动学习最优的流量比例;基于联邦学习的灰度发布:在保护数据隐私的前提下,验证模型的通用性。

7.3 开放问题:待解决的挑战

如何量化AI系统的灰度风险? 目前的风险评估多依赖经验,缺乏统一的量化模型;如何处理灰度发布中的数据漂移? 数据漂移的检测和修复仍需人工干预;如何协调技术团队和业务团队的灰度决策? 技术团队关注模型性能,业务团队关注业务价值,需建立共同的决策框架。

7.4 战略建议:企业如何落地AI灰度发布?

建立标准流程:制定《AI灰度发布操作手册》,明确目标、规则、流程和责任;培养跨团队能力:AI架构师需具备“技术+业务+沟通”的综合能力,协调算法、工程、业务团队;投资工具链:采购或自研流量路由、模型服务、监控分析工具(如Triton、Grafana、Flink);重视伦理与安全:建立AI伦理委员会,制定安全规范,避免模型偏见和安全漏洞。

结语:AI灰度发布是“技术与业务的桥梁”

AI系统的价值不在于“模型精度有多高”,而在于“能否安全、有效地解决业务问题”。灰度发布是连接“技术模型”和“业务价值”的桥梁——它让AI架构师从“模型开发者”转变为“业务价值交付者”,让AI系统从“实验室”走向“生产环境”。

未来,随着AI技术的普及,灰度发布将成为AI应用的“标配流程”。而优秀的AI架构师,将是那些能“用技术解决风险,用数据驱动决策,用业务思维设计流程”的人。

参考资料(权威来源):

《Site Reliability Engineering》(Google SRE团队,灰度发布的经典实践);《Building Machine Learning Powered Applications》(Emmanuel Ameisen,AI模型部署的最佳实践);《AI Fairness 360》(IBM,AI公平性的评估工具);《Triton Inference Server Documentation》(NVIDIA,模型服务的权威指南)。

相关文章