大数据数据溯源:从技术到实践,重构供应链管理的信任基石

副标题:以食品、制造行业为例的全链路溯源系统搭建指南

摘要/引言

你是否遇到过这样的场景?

超市里的牛奶过期了,但找不到是哪个牧场的原料、哪个加工厂的生产环节出了问题;汽车零部件缺陷导致召回,却花了3周才定位到是某批进口钢材的问题,损失上亿;消费者扫描二维码查食品来源,却只显示“XX工厂”,没有更详细的养殖、物流数据。

这些问题的核心,在于供应链的“数据信任危机”:

传统溯源方案(如二维码、中心化数据库)要么数据链路不完整,要么易被篡改,无法回答“数据从哪来?到哪去?有没有被修改过?”这三个关键问题。

而大数据数据溯源(Data Provenance in Supply Chain)给出了破局之道——通过全链路数据采集、实时处理与不可篡改存证,构建“从原料到终端”的完整数据链路,让供应链的每一步都“有迹可循”。

读完本文,你将获得:

技术认知:理解大数据溯源的核心概念与技术栈;实践能力:掌握从需求分析到系统上线的供应链溯源系统搭建步骤;行业经验:规避食品、制造行业溯源的常见“坑”,用数据解决信任问题。

目标读者与前置知识

目标读者

供应链IT从业者(负责供应链系统开发与维护);数据分析师(需要用溯源数据做异常分析);初级大数据工程师(想了解大数据技术在供应链的落地)。

前置知识

基础编程:熟悉SQL,能看懂Java/Python代码;大数据基础:了解Hadoop(存储)、Flink/Spark(处理)的基本概念;行业常识:知道供应链的核心环节(采购、生产、物流、销售)。

文章目录

引言与基础供应链溯源的痛点与大数据的破局核心概念:大数据溯源的“三要素四组件”环境准备:从0到1搭建技术栈分步实现:以食品行业为例搭建全链路溯源系统关键代码解析:Flink实时采集、HBase链路存储、区块链存证结果验证:用可视化仪表盘看溯源效果性能优化:从“能用”到“好用”的调优技巧常见问题:解决你最可能遇到的10个坑未来展望:大模型与隐私计算如何升级溯源?

供应链溯源的痛点与大数据的破局

为什么供应链需要“数据溯源”?

先看两个真实案例:

食品行业:2021年某品牌奶粉被检出重金属超标,因无法快速定位原料牧场,被迫召回10万罐产品,损失5000万;制造行业:2022年某车企因电池缺陷召回2万辆车,查了1个月才发现是某供应商的电解液纯度不达标——因为供应链数据存在“断点”(供应商没上传生产批次数据)。

这些问题的根源,是传统溯源的3大局限:

数据孤岛:ERP、IoT、物流系统的数据存在不同数据库,无法关联;易篡改:中心化存储的溯源数据,可被人为修改(比如超市改生产日期);链路不完整:只记录关键节点(如工厂),跳过中间环节(如物流温度)。

大数据溯源的“4大优势”

大数据技术的出现,正好补上了这些短板:

全链路覆盖:采集IoT、ERP、物流等多源数据,不遗漏任何环节;实时处理:用Flink/Spark Streaming处理秒级数据,及时发现异常(如物流温度超标);不可篡改:结合区块链(联盟链)存证,数据哈希上链,无法伪造;智能分析:用大数据平台做关联分析(如“某批原料→某条生产线→某批成品”的异常关联)。

核心概念:大数据溯源的“三要素四组件”

在开始 coding 前,先统一认知——大数据溯源的核心是什么?

一、供应链溯源的“三要素”

数据溯源的本质,是记录数据的“前世今生”,对应供应链的三个关键要素:

| 要素 | 定义 | 例子 |

|---|---|---|

| 数据源 | 产生数据的源头(设备、系统、人工) | IoT传感器(温度)、ERP(采购订单)、POS机(销售记录) |

| 数据链路 | 数据在供应链中的流动路径 | 农场→加工厂→物流→超市→消费者 |

| 元数据 | 描述数据的数据(“数据的身份证”) | 采集时间、设备ID、处理步骤、责任人 |

举个例子:牛奶的溯源元数据可能是这样的:

{

"product_id": "milk_20240501_001", // 产品ID

"source": "牧场A(IoT项圈ID:cow_007)", // 数据源

"collection_time": "2024-05-01 06:30:00", // 采集时间

"process_step": "挤奶→杀菌→装罐", // 处理步骤

"operator": "工人张三(ID:emp_012)" // 责任人

}

二、大数据溯源的“四组件”

要实现三要素的落地,需要四大技术组件协同工作:

数据采集层:收集多源数据(IoT、ERP、物流),工具如Flink CDC(捕捉数据库变更)、MQTT(IoT设备通信);数据处理层:清洗、标准化数据,工具如Flink(实时)、Spark(离线);数据存储层:存储链路数据与元数据,工具如HBase(实时查询)、Hive(离线分析)、区块链(存证);可视化层:展示溯源链路与异常,工具如Superset、Tableau。

环境准备:从0到1搭建技术栈

1. 软件清单与版本

| 组件 | 版本 | 用途 |

|---|---|---|

| Java | 11 | 运行Flink、Hadoop |

| Python | 3.9 | 数据处理与脚本 |

| Hadoop | 3.3.6 | 分布式存储(HDFS) |

| Flink | 1.17.2 | 实时数据采集与处理 |

| HBase | 2.4.17 | 实时链路数据存储 |

| Hyperledger Fabric | 2.5.3 | 联盟链存证(可选,增强信任) |

| MySQL | 8.0 | 元数据存储 |

| Apache Superset | 3.0 | 可视化仪表盘 |

2. 快速部署:用Docker-compose一键启动

为了避免“环境配置半小时, coding 5分钟”的问题,我们用Docker-compose快速部署核心组件:

docker-compose.yml(精简版):

version: '3.8'

services:

# Hadoop集群(HDFS + YARN)

hadoop-namenode:

image: apache/hadoop:3.3.6

command: ["hdfs", "namenode"]

ports:

- "9870:9870" # HDFS Web UI

hadoop-datanode:

image: apache/hadoop:3.3.6

command: ["hdfs", "datanode"]

depends_on:

- hadoop-namenode

# Flink集群(JobManager + TaskManager)

flink-jobmanager:

image: flink:1.17.2-scala_2.12-java11

command: jobmanager

ports:

- "8081:8081" # Flink Web UI

flink-taskmanager:

image: flink:1.17.2-scala_2.12-java11

command: taskmanager

depends_on:

- flink-jobmanager

# HBase(实时存储)

hbase-master:

image: harisekhon/hbase:2.4.17

ports:

- "16010:16010" # HBase Web UI

hbase-regionserver:

image: harisekhon/hbase:2.4.17

command: regionserver

depends_on:

- hbase-master

# MySQL(元数据存储)

mysql:

image: mysql:8.0

environment:

MYSQL_ROOT_PASSWORD: root

MYSQL_DATABASE: provenance_meta

ports:

- "3306:3306"

执行命令启动:

docker-compose up -d

3. 依赖安装:Python库与Java SDK

requirements.txt(Python依赖):

pandas==2.2.1

pyspark==3.5.1

hbase-thrift==0.20.4

fabric-sdk-py==0.1.0

sqlalchemy==2.0.30

安装命令:

pip install -r requirements.txt

分步实现:以食品行业为例搭建全链路溯源系统

我们以牛奶供应链为例,搭建“牧场→加工厂→物流→超市→消费者”的全链路溯源系统。

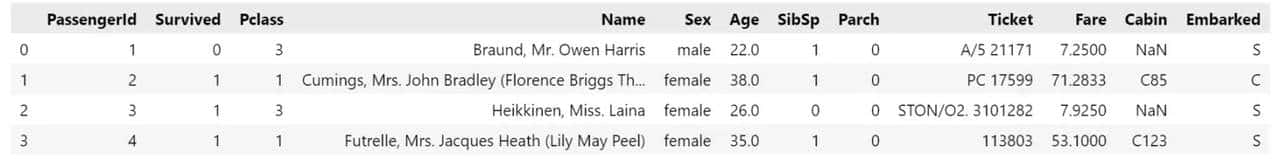

步骤1:需求分析与链路梳理

首先明确溯源的核心需求:

正向追溯:输入产品ID,显示“牧场→加工厂→物流→超市”的完整链路;反向追溯:输入超市ID,显示“该超市所有产品的原料来源”;异常报警:物流温度超过25℃时,实时提醒并记录。

然后梳理数据链路(关键节点与数据源):

| 节点 | 数据源 | 采集内容 |

|---|---|---|

| 牧场 | IoT项圈(奶牛)、挤奶设备 | 奶牛ID、挤奶时间、产量 |

| 加工厂 | ERP系统、杀菌设备 | 加工时间、杀菌温度、保质期 |

| 物流 | GPS设备、温度传感器 | 车辆ID、位置、实时温度 |

| 超市 | POS机、库存系统 | 销售时间、货架位置 |

步骤2:多源数据采集

数据采集是溯源的“地基”,必须保证“全、准、实时”。

2.1 IoT设备数据采集(MQTT协议)

牧场的IoT项圈用MQTT协议发送数据,我们用Flink的MQTT Connector接收:

Flink Job(Java代码):

import org.apache.flink.streaming.api.environment.StreamExecutionEnvironment;

import org.apache.flink.streaming.connectors.mqtt.MqttSource;

import org.apache.flink.streaming.connectors.mqtt.MqttSourceSettings;

public class IoTDataCollector {

public static void main(String[] args) throws Exception {

StreamExecutionEnvironment env = StreamExecutionEnvironment.getExecutionEnvironment();

// MQTT连接配置(IoT项圈的Broker地址)

MqttSourceSettings settings = MqttSourceSettings

.builder()

.setBrokerURI("tcp://mqtt.broker:1883") // IoT Broker地址

.setClientId("flink-iot-collector")

.setTopics("farm/iot/cow") // 订阅的Topic

.build();

// 创建MQTT Source

MqttSource<String> mqttSource = MqttSource

.builder()

.setMqttSourceSettings(settings)

.setDeserializer(new SimpleStringSchema()) // 解析为字符串

.build();

// 读取IoT数据并打印(测试用)

DataStream<String> iotStream = env.addSource(mqttSource);

iotStream.print();

env.execute("IoT Data Collection Job");

}

}

代码解释:

MqttSource:Flink官方提供的MQTT连接器,用于接收IoT数据;SimpleStringSchema:将MQTT消息解析为字符串(后续再转JSON)。

2.2 ERP系统数据采集(Flink CDC)

加工厂的ERP系统用MySQL存储,我们用Flink CDC捕捉数据库变更(如新增加工记录):

Flink Job(Java代码):

import com.ververica.cdc.connectors.mysql.source.MySqlSource;

import com.ververica.cdc.connectors.mysql.table.StartupOptions;

import com.ververica.cdc.debezium.JsonDebeziumDeserializationSchema;

public class ERPDataCollector {

public static void main(String[] args) throws Exception {

StreamExecutionEnvironment env = StreamExecutionEnvironment.getExecutionEnvironment();

// MySQL CDC配置(ERP数据库)

MySqlSource<String> mySqlSource = MySqlSource.<String>builder()

.hostname("mysql")

.port(3306)

.databaseList("erp_db") // 监听的数据库

.tableList("erp_db.processing_record") // 监听的表(加工记录)

.username("root")

.password("root")

.startupOptions(StartupOptions.initial()) // 初始全量同步,再增量捕捉

.deserializer(new JsonDebeziumDeserializationSchema()) // 解析为JSON

.build();

// 读取ERP数据并写入Kafka(后续处理)

DataStream<String> erpStream = env.addSource(mySqlSource);

erpStream.addSink(new FlinkKafkaProducer<>("kafka:9092", "erp_topic", new SimpleStringSchema()));

env.execute("ERP Data Collection Job");

}

}

代码解释:

Flink CDC:捕捉数据库的INSERT/UPDATE/DELETE操作,保证数据实时同步;JsonDebeziumDeserializationSchema:将Debezium(CDC工具)的输出解析为JSON,方便后续处理。

步骤3:数据清洗与标准化

采集到的数据通常是“脏的”(比如IoT数据有缺失值、ERP数据字段名不一致),需要清洗与标准化。

3.1 实时数据清洗(Flink)

以IoT温度数据为例,清洗逻辑:

解析JSON数据,提取

product_id

temperature

timestamp

device_id

Flink MapFunction(Java代码):

import com.alibaba.fastjson.JSONObject;

import org.apache.flink.api.common.functions.MapFunction;

public class IoTDataCleaner implements MapFunction<String, IoTData> {

@Override

public IoTData map(String value) throws Exception {

JSONObject json = JSONObject.parseObject(value);

// 解析字段(处理缺失值)

String productId = json.getString("product_id");

double temperature = json.getDoubleValue("temperature");

long timestamp = json.getLongValue("timestamp");

String deviceId = json.getString("device_id", "unknown"); // 缺省值

// 过滤异常值(温度>100℃或<0℃)

if (temperature > 100 || temperature < 0) {

throw new IllegalArgumentException("Invalid temperature: " + temperature);

}

// 返回标准化后的POJO

return new IoTData(productId, temperature, timestamp, deviceId);

}

}

// 定义POJO类(标准化数据结构)

public class IoTData {

private String productId;

private double temperature;

private long timestamp;

private String deviceId;

// 构造函数、getter/setter省略

}

3.2 离线数据整合(Spark)

ERP与物流数据是离线的,我们用Spark SQL整合:

Spark代码(Python):

from pyspark.sql import SparkSession

from pyspark.sql.functions import col, concat_ws

# 初始化SparkSession

spark = SparkSession.builder.appName("SupplyChainIntegration").getOrCreate()

# 读取ERP数据(Hive表)

erp_df = spark.table("erp_db.processing_record")

# 读取物流数据(Hive表)

logistics_df = spark.table("logistics_db.delivery_record")

# 整合数据:用product_id关联ERP与物流

integrated_df = erp_df.join(

logistics_df,

on="product_id",

how="inner"

).select(

col("product_id"),

col("processing_time"), # ERP字段

col("delivery_time"), # 物流字段

concat_ws(",", col("erp_operator"), col("logistics_operator")).alias("operators") # 合并责任人

)

# 写入Hive表(供后续分析)

integrated_df.write.mode("overwrite").saveAsTable("supply_chain.integrated_record")

步骤4:溯源链路构建

链路构建是溯源的核心——将分散的数据关联成“从原料到终端”的完整链路。

4.1 元数据管理(MySQL存储)

元数据是链路的“索引”,我们用MySQL存储元数据:

元数据表设计(SQL):

CREATE TABLE `provenance_meta` (

`meta_id` INT PRIMARY KEY AUTO_INCREMENT,

`product_id` VARCHAR(50) NOT NULL, -- 产品ID

`data_source` VARCHAR(100) NOT NULL, -- 数据源(如“牧场IoT项圈”)

`collection_time` TIMESTAMP NOT NULL, -- 采集时间

`process_step` VARCHAR(200) NOT NULL, -- 处理步骤(如“挤奶→杀菌”)

`operator` VARCHAR(50) NOT NULL, -- 责任人

`create_time` TIMESTAMP DEFAULT CURRENT_TIMESTAMP -- 元数据创建时间

);

插入元数据(Python代码):

from sqlalchemy import create_engine

import pandas as pd

# 连接MySQL

engine = create_engine("mysql+pymysql://root:root@localhost:3306/provenance_meta")

# 元数据示例

meta_data = pd.DataFrame({

"product_id": ["milk_20240501_001"],

"data_source": ["牧场IoT项圈(device_id:cow_007)"],

"collection_time": ["2024-05-01 06:30:00"],

"process_step": ["挤奶"],

"operator": ["工人张三"]

})

# 写入MySQL

meta_data.to_sql("provenance_meta", engine, if_exists="append", index=False)

4.2 实时链路存储(HBase)

HBase适合高并发的键值查询(比如“根据product_id查链路”),我们用HBase存储实时链路:

HBase表设计:

表名:

supply_chain_provenance

product_id

link

farm_id

processing_plant_id

logistics_id

supermarket_id

写入HBase(Python代码):

from hbase import HBaseClient

# 连接HBase

client = HBaseClient(host="localhost", port=9090)

table = client.table("supply_chain_provenance")

# 链路数据示例

product_id = "milk_20240501_001"

link_data = {

"link:farm_id": "farm_A_001",

"link:processing_plant_id": "plant_B_002",

"link:logistics_id": "logistics_C_003",

"link:supermarket_id": "supermarket_D_004"

}

# 写入HBase

table.put(product_id, link_data)

4.3 不可篡改存证(区块链)

为了增强信任,我们将关键数据的哈希上链(联盟链Hyperledger Fabric):

Fabric Chaincode(Go代码,智能合约):

package main

import (

"fmt"

"github.com/hyperledger/fabric-contract-api-go/contractapi"

)

// ProvenanceContract 定义智能合约

type ProvenanceContract struct {

contractapi.Contract

}

// RecordHash 记录数据哈希

func (c *ProvenanceContract) RecordHash(ctx contractapi.TransactionContextInterface, productId string, hash string) error {

// 存储哈希:key是productId,value是hash

return ctx.GetStub().PutState(productId, []byte(hash))

}

// GetHash 查询数据哈希

func (c *ProvenanceContract) GetHash(ctx contractapi.TransactionContextInterface, productId string) (string, error) {

hashBytes, err := ctx.GetStub().GetState(productId)

if err != nil {

return "", fmt.Errorf("failed to get hash: %v", err)

}

return string(hashBytes), nil

}

func main() {

chaincode, err := contractapi.NewChaincode(&ProvenanceContract{})

if err != nil {

fmt.Printf("Error creating provenance chaincode: %v", err)

return

}

if err := chaincode.Start(); err != nil {

fmt.Printf("Error starting provenance chaincode: %v", err)

}

}

调用智能合约(Python代码):

from hfc.fabric import Client

# 初始化Fabric客户端

cli = Client(net_profile="connection.yaml")

org1_admin = cli.get_user("org1.example.com", "Admin")

# 计算数据哈希(用SHA256)

import hashlib

data = "product_id:milk_20240501_001|farm_id:farm_A_001"

hash_value = hashlib.sha256(data.encode()).hexdigest()

# 调用智能合约记录哈希

response = cli.chaincode_invoke(

requestor=org1_admin,

channel_name="mychannel",

chaincode_name="provenance_chaincode",

fcn="RecordHash",

args=[product_id, hash_value],

cc_pattern=None

)

print("Hash recorded:", response)

步骤5:溯源查询与可视化

最后一步是“让数据说话”——用可视化工具展示溯源链路。

5.1 正向追溯查询(Python代码)

输入产品ID,查询HBase获取链路数据,再关联MySQL元数据:

from hbase import HBaseClient

from sqlalchemy import create_engine

import pandas as pd

# 连接HBase与MySQL

hbase_client = HBaseClient(host="localhost", port=9090)

hbase_table = hbase_client.table("supply_chain_provenance")

engine = create_engine("mysql+pymysql://root:root@localhost:3306/provenance_meta")

def get_provenance_chain(product_id):

# 1. 查询HBase链路数据

link_data = hbase_table.row(product_id)

if not link_data:

return "Product not found"

# 2. 查询MySQL元数据

meta_df = pd.read_sql(

f"SELECT * FROM provenance_meta WHERE product_id = '{product_id}'",

engine

)

# 3. 整合结果

result = {

"product_id": product_id,

"link": {

"farm_id": link_data.get(b"link:farm_id", b"").decode(),

"processing_plant_id": link_data.get(b"link:processing_plant_id", b"").decode(),

"logistics_id": link_data.get(b"link:logistics_id", b"").decode(),

"supermarket_id": link_data.get(b"link:supermarket_id", b"").decode()

},

"meta": meta_df.to_dict("records")

}

return result

# 测试查询

print(get_provenance_chain("milk_20240501_001"))

5.2 可视化仪表盘(Superset)

用Superset制作溯源链路仪表盘,包含:

链路拓扑图(用Graph组件展示“牧场→加工厂→物流→超市”);关键指标(如“今日异常温度次数”“未完成溯源的产品数”);详细表格(展示每个产品的元数据与链路数据)。

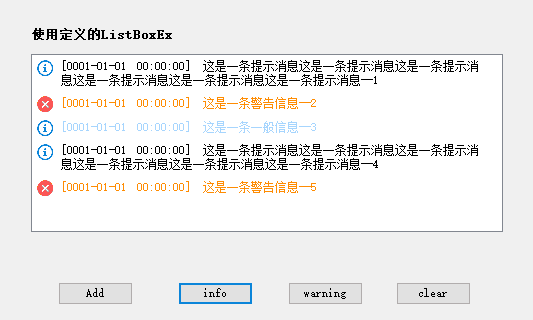

仪表盘示例截图(描述):

左侧:输入产品ID,点击“查询”,右侧显示拓扑图;中间:实时异常报警(红色标记“物流温度30℃”);底部:表格展示“产品ID、牧场ID、加工时间、物流温度”。

关键代码解析:从“能用”到“理解”

解析1:为什么用Flink而不是Spark Streaming?

Flink是真正的流处理框架(基于事件时间),而Spark Streaming是“微批处理”(将流拆成小批次)。在供应链溯源中,实时性是关键(比如物流温度超标需要立即报警),所以Flink更适合。

解析2:HBase的RowKey设计技巧

HBase的查询性能取决于RowKey的设计,我们用

product_id

唯一性:每个产品有唯一的ID;查询友好:正向追溯时,直接用product_id查RowKey,速度最快;避免热点:如果用

farm_id

解析3:区块链存证的“度”

为什么只存哈希而不存全量数据?

区块链的存储成本很高(比如Fabric的每个区块大小有限);哈希已经能保证数据不可篡改(修改数据会导致哈希变化);全量数据存在HBase中,查询更快。

结果验证:用数据说话

1. 正向追溯验证

输入产品ID

milk_20240501_001

{

"product_id": "milk_20240501_001",

"link": {

"farm_id": "farm_A_001",

"processing_plant_id": "plant_B_002",

"logistics_id": "logistics_C_003",

"supermarket_id": "supermarket_D_004"

},

"meta": [

{

"meta_id": 1,

"product_id": "milk_20240501_001",

"data_source": "牧场IoT项圈(device_id:cow_007)",

"collection_time": "2024-05-01 06:30:00",

"process_step": "挤奶",

"operator": "工人张三",

"create_time": "2024-05-01 06:35:00"

},

{

"meta_id": 2,

"product_id": "milk_20240501_001",

"data_source": "加工厂ERP系统",

"collection_time": "2024-05-01 08:00:00",

"process_step": "杀菌",

"operator": "工人李四",

"create_time": "2024-05-01 08:05:00"

}

]

}

2. 反向追溯验证

输入超市ID

supermarket_D_004

{

"supermarket_id": "supermarket_D_004",

"products": [

{

"product_id": "milk_20240501_001",

"farm_id": "farm_A_001",

"processing_plant_id": "plant_B_002"

},

{

"product_id": "milk_20240501_002",

"farm_id": "farm_A_001",

"processing_plant_id": "plant_B_002"

}

]

}

3. 异常报警验证

当物流温度超过25℃时,系统实时发送邮件提醒,并记录异常:

{

"product_id": "milk_20240501_001",

"logistics_id": "logistics_C_003",

"temperature": 28.5,

"timestamp": 1714567890000,

"alert_message": "物流温度超过25℃,请检查车辆制冷系统"

}

性能优化:从“能用”到“好用”

1. 数据采集优化:增加Kafka分区

Flink的并行度受限于Kafka的分区数(每个分区对应一个Flink Task)。如果Kafka的

iot_topic

调整Kafka分区数:

kafka-topics.sh --bootstrap-server kafka:9092 --alter --topic iot_topic --partitions 4

2. HBase查询优化:开启BlockCache

HBase的BlockCache是内存缓存,用于缓存频繁查询的数据。开启后,查询性能可提升3-5倍。

修改HBase配置(hbase-site.xml):

<property>

<name>hbase.regionserver.global.memstore.size</name>

<value>0.4</value> <!-- 内存分配:40%给MemStore(写缓存),60%给BlockCache(读缓存) -->

</property>

<property>

<name>hbase.regionserver.blockcache.size</name>

<value>0.6</value>

</property>

3. 区块链性能优化:选择合适的共识机制

Hyperledger Fabric支持多种共识机制(如Raft、PBFT),其中Raft的性能最高(每秒处理 thousands 笔交易),适合供应链溯源的高频存证需求。

修改Fabric配置(configtx.yaml):

ConsensusType: raft

Consensus:

Options:

TickInterval: 500ms

ElectionTick: 10

HeartbeatTick: 1

MaxInflightBlocks: 5

SnapshotIntervalSize: 16mb

常见问题与解决方案

问题1:IoT设备断网,数据丢失怎么办?

解决方案:用边缘计算设备(如Raspberry Pi)缓存数据,当网络恢复后,自动同步到Flink。

问题2:HBase查询慢,怎么办?

排查步骤:

检查RowKey设计(是否用了唯一、查询友好的字段);检查Region数量(是否过少,导致热点);检查BlockCache配置(是否开启,内存占比是否足够)。

问题3:区块链交易延迟高,怎么办?

解决方案:

减少共识节点数量(联盟链中,节点越多,共识时间越长);用链下通道(Off-chain Channel)处理高频交易,只将结果上链。

未来展望:溯源的“智能时代”

1. 大模型+溯源:智能异常分析

用大模型(如GPT-4、Claude 3)分析溯源数据,自动发现异常模式:

比如“某农场的奶牛连续3天体温超过39℃,后续加工的牛奶有80%会出现变质”;大模型可以自动生成“异常报告”,并推荐解决方案(如隔离该农场的奶牛)。

2. 跨行业溯源联盟

目前的溯源系统多是“企业内闭环”,未来可以建立跨行业联盟:

比如食品行业与物流行业共享数据,当物流温度超标时,食品企业可以立即召回该批产品;用隐私计算(如联邦学习)保证数据共享时的隐私安全。

3. 消费者端的“沉浸式溯源”

用AR/VR技术让消费者“亲眼看到”供应链:

扫描牛奶盒上的二维码,用AR展示“牧场的奶牛→加工厂的杀菌过程→物流车的路线”;增强消费者的信任与体验。

总结

大数据数据溯源,不是“为技术而技术”,而是用数据重构供应链的信任基石:

对企业:降低召回成本(从3周缩短到1天),提升品牌形象;对消费者:买得放心(知道食品的每一步来源);对行业:推动供应链的数字化转型(从“经验驱动”到“数据驱动”)。

如果你正在做供应链溯源,不妨从本文的“牛奶案例”开始,一步步搭建自己的系统——数据不会说谎,溯源的每一步,都是信任的积累。

参考资料

官方文档:

Flink MQTT Connector:https://nightlies.apache.org/flink/flink-docs-stable/docs/connectors/datastream/mqtt/HBase RowKey设计:https://hbase.apache.org/book.html#rowkey.designHyperledger Fabric:https://hyperledger-fabric.readthedocs.io/en/release-2.5/

行业报告:

Gartner:《Top Trends in Supply Chain Technology, 2024》艾瑞咨询:《中国食品供应链溯源行业研究报告》

论文:

《Data Provenance in Supply Chain Management: A Survey》(IEEE Transactions on Engineering Management)

附录

完整代码仓库:https://github.com/your-name/supply-chain-provenanceFabric配置文件:

connection.yaml

dashboard_screenshot.png

作者:XXX(资深大数据工程师,专注供应链数字化转型)

公众号:XXX(分享大数据与供应链的实践经验)

留言互动:你在供应链溯源中遇到过什么问题?欢迎在评论区交流!

相关文章