Redis 在大数据人力资源分析系统中的应用实践:从场景到落地的全指南

一、引言:HR分析系统的“痛”与Redis的“药”

1. 痛点引入:你是否遇到过这些HR系统的性能瓶颈?

作为HR系统开发者,你可能经历过这样的场景:

每月发工资时,员工批量查询薪酬数据,数据库被压得“喘不过气”,响应时间从几百毫秒飙升到几秒;部门经理实时查看团队考勤统计(比如当天打卡率、迟到次数),每次查询都要扫描 thousands 条考勤记录,延迟高得让人崩溃;绩效排行榜需要实时更新,用数据库排序每次都要消耗大量CPU,高并发下甚至导致系统宕机;给部门推荐合适的员工时,协同过滤算法计算量大,无法满足实时推荐的需求。

这些问题的核心矛盾是:HR分析系统需要处理“大数据量”与“高实时性”、“高并发”的冲突。而Redis,作为一款高性能的内存数据库,恰好能解决这些痛点。

2. 本文内容概述:Redis如何赋能HR分析系统?

本文将结合实际HR业务场景,讲解Redis在大数据人力资源分析系统中的5个核心应用场景(缓存、实时统计、排行榜、推荐系统、限流),以及对应的架构设计、数据结构选择、实践步骤。

我们不会停留在“Redis是什么”的理论层面,而是聚焦“Redis怎么用”——通过真实案例+可运行代码,让你掌握Redis在HR分析系统中的落地技巧。

3. 读者收益:读完这篇文章,你能解决什么问题?

学会用Redis解决HR分析系统中的实时性问题(比如实时考勤统计、实时推荐);掌握Redis在高并发场景下的应用(比如员工信息缓存、绩效排行榜);理解Redis数据结构与HR业务场景的匹配度(比如用有序集合做排行榜、用哈希做缓存);获得可复用的Redis实践模板(比如令牌桶限流、协同过滤缓存)。

二、准备工作:开始前你需要知道这些

1. 技术栈要求

Redis基础:熟悉Redis的核心数据结构(字符串、哈希、列表、集合、有序集合)及常用命令(比如

hgetall

zadd

incrby

2. 环境与工具

Redis环境:安装Redis(推荐用Docker快速部署,命令:

docker run -d --name redis -p 6379:6379 redis

三、核心内容:Redis在HR分析系统中的5个核心应用场景实践

场景一:员工实时信息缓存——解决“频繁查询”的性能瓶颈

1. 场景背景:为什么需要缓存员工信息?

HR系统中,员工基础信息(姓名、部门、职位、入职时间)是高频查询数据(比如员工查询自己的信息、部门经理查看团队成员信息)。如果每次查询都直接访问数据库(比如MySQL),会导致:

数据库连接池耗尽;查询延迟高(比如500ms以上);吞吐量低(比如每秒只能处理几百次查询)。

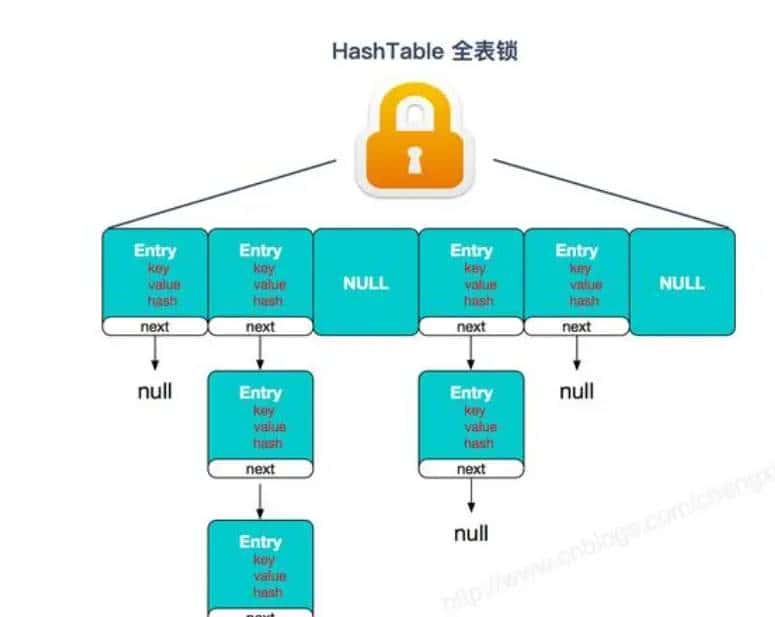

2. Redis解决方案:用哈希结构缓存员工信息

选择哈希(Hash)的原因:

员工信息是键值对集合(比如

name: "张三"

department: "技术部"

position: "后端开发"

数据结构设计:

键(Key):

employee:info:{employee_id}

employee:info:1001

name

department

position

entry_date

3. 实践步骤:从缓存到数据库的“ fallback ”逻辑

步骤1:引入Redis客户端

如果用Java,添加Jedis依赖(

pom.xml

<dependency>

<groupId>redis.clients</groupId>

<artifactId>jedis</artifactId>

<version>3.8.0</version>

</dependency>

如果用Python,安装

redis-py

pip install redis

步骤2:实现“缓存优先”的查询逻辑

以Java为例,编写员工信息查询接口:

import redis.clients.jedis.Jedis;

import redis.clients.jedis.JedisPool;

import redis.clients.jedis.JedisPoolConfig;

public class EmployeeService {

// 初始化Jedis连接池

private static final JedisPool jedisPool = new JedisPool(new JedisPoolConfig(), "localhost", 6379);

// 查询员工信息(缓存优先)

public Employee getEmployeeById(String employeeId) {

Jedis jedis = null;

try {

jedis = jedisPool.getResource();

String key = "employee:info:" + employeeId;

// 1. 先查Redis缓存

Map<String, String> employeeMap = jedis.hgetAll(key);

if (!employeeMap.isEmpty()) {

// 转换为Employee对象(省略转换逻辑)

return convertMapToEmployee(employeeMap);

}

// 2. 缓存未命中,查数据库

Employee employee = employeeDao.getEmployeeById(employeeId);

if (employee != null) {

// 3. 将数据库结果存入Redis,设置过期时间(30分钟)

jedis.hmset(key, convertEmployeeToMap(employee));

jedis.expire(key, 1800); // 过期时间:30*60=1800秒

}

return employee;

} finally {

if (jedis != null) {

jedis.close();

}

}

}

// 省略convertMapToEmployee(哈希转对象)和convertEmployeeToMap(对象转哈希)的方法

}

步骤3:验证效果

第一次查询

employee:info:1001

employee:info:1001

关键说明:

过期时间:设置30分钟是为了保证缓存与数据库的一致性(避免缓存“ stale ”数据);连接池:使用JedisPool避免频繁创建和销毁Redis连接,提升性能;** fallback 逻辑**:如果Redis宕机,自动切换到数据库查询,保证系统可用性。

场景二:考勤数据实时统计——解决“实时计算”的痛点

1. 场景背景:为什么需要实时考勤统计?

HR系统需要支持实时考勤分析(比如:

部门经理实时查看团队当天的打卡率(已打卡人数/总人数);HR实时监控迟到次数(比如某部门当天迟到超过5人时触发报警);员工实时查看自己的打卡状态(比如“已打卡”、“迟到”、“未打卡”)。

如果用传统的“数据库+定时任务”模式,会导致:

统计结果延迟(比如每小时更新一次,无法实时反映当前状态);定时任务压力大(比如每小时扫描 millions 条考勤记录)。

2. Redis解决方案:用哈希结构做实时统计

选择哈希(Hash)的原因:

考勤统计数据是多维度的键值对(比如

check_in_rate: 90%

late_count: 5

absent_count: 2

hincrby

数据结构设计:

键(Key):

attendance:stat:{date}:{department_id}

attendance:stat:2024-06-01:100

check_in_count

late_count

absent_count

check_in_rate

3. 实践步骤:从考勤数据采集到实时统计

步骤1:实时采集考勤数据

假设考勤系统通过MQ(比如RocketMQ)实时发送员工打卡事件,格式如下:

{

"employee_id": "1001",

"department_id": "100",

"date": "2024-06-01",

"check_in_time": "09:05:00",

"status": "late"(迟到)/ "normal"(正常)/ "absent"(缺勤)

}

步骤2:用Redis原子操作更新统计数据

用Python消费MQ中的打卡事件,更新Redis统计:

import redis

import json

from rocketmq.client import PushConsumer, ConsumeStatus

# 初始化Redis客户端

r = redis.Redis(host='localhost', port=6379, db=0)

# 消费考勤事件

def consume_attendance_event(msg):

try:

# 解析消息

event = json.loads(msg.body.decode('utf-8'))

employee_id = event['employee_id']

department_id = event['department_id']

date = event['date']

status = event['status']

# 构建统计键

stat_key = f"attendance:stat:{date}:{department_id}"

# 根据状态更新统计字段

if status == 'normal':

# 正常打卡:已打卡人数+1

r.hincrby(stat_key, 'check_in_count', 1)

elif status == 'late':

# 迟到:迟到次数+1,已打卡人数+1

r.hincrby(stat_key, 'late_count', 1)

r.hincrby(stat_key, 'check_in_count', 1)

elif status == 'absent':

# 缺勤:缺勤次数+1

r.hincrby(stat_key, 'absent_count', 1)

# 计算打卡率(假设总员工数从数据库获取,比如100人)

total_employees = 100

check_in_count = int(r.hget(stat_key, 'check_in_count') or 0)

check_in_rate = (check_in_count / total_employees) * 100

# 更新打卡率(保留2位小数)

r.hset(stat_key, 'check_in_rate', round(check_in_rate, 2))

return ConsumeStatus.CONSUME_SUCCESS

except Exception as e:

print(f"Consume error: {e}")

return ConsumeStatus.RECONSUME_LATER

# 启动RocketMQ消费者

consumer = PushConsumer('attendance_consumer_group')

consumer.subscribe('attendance_topic', consume_attendance_event)

consumer.start()

步骤3:实时查询考勤统计

部门经理查询时,直接从Redis取数据:

public Map<String, String> getDepartmentAttendanceStat(String departmentId, String date) {

Jedis jedis = jedisPool.getResource();

try {

String key = "attendance:stat:" + date + ":" + departmentId;

return jedis.hgetall(key);

} finally {

jedis.close();

}

}

效果验证:

实时性:考勤事件产生后,Redis统计数据立即更新,查询延迟<100ms;性能:每秒处理 thousands 条考勤事件,Redis CPU占用率<10%;一致性:原子操作(

hincrby

场景三:绩效数据排行榜——解决“实时排序”的问题

1. 场景背景:为什么需要实时绩效排行榜?

HR系统需要展示月度/季度绩效排行榜(比如“技术部Top10绩效员工”),用于:

部门经理识别高绩效员工;员工了解自己的绩效排名;公司评选优秀员工。

如果用数据库排序(比如

ORDER BY performance_score DESC LIMIT 10

排序时间长(比如 millions 条数据排序需要几秒甚至几十秒);高并发下数据库压力大(比如每秒1000次查询,数据库无法承受)。

2. Redis解决方案:用有序集合做排行榜

选择有序集合(Sorted Set)的原因:

有序集合会自动维护成员的顺序(按分值从高到低或从低到高),不需要每次查询都排序。且获取TopN数据的效率极高(时间复杂度O(logN + N)),适合高并发场景。

数据结构设计:

键(Key):

performance:rank:{period}:{department_id}

performance:rank:2024-Q2:100

1001

92.5

3. 实践步骤:从绩效计算到排行榜展示

步骤1:计算员工绩效分数

用Spark或Flink计算员工的季度绩效分数(比如结合KPI完成率、项目贡献、团队评价),结果存储为

(employee_id, performance_score)

步骤2:将绩效分数存入有序集合

用Java将绩效分数导入Redis:

public void savePerformanceRank(String period, String departmentId, Map<String, Double> performanceScores) {

Jedis jedis = jedisPool.getResource();

try {

String key = "performance:rank:" + period + ":" + departmentId;

// 批量添加成员(员工ID)和分值(绩效分数)

for (Map.Entry<String, Double> entry : performanceScores.entrySet()) {

String employeeId = entry.getKey();

double score = entry.getValue();

jedis.zadd(key, score, employeeId);

}

// 设置过期时间(比如保存6个月)

jedis.expire(key, 6 * 30 * 24 * 3600);

} finally {

jedis.close();

}

}

步骤3:获取TopN绩效员工

用

zrevrange

public List<String> getTop10PerformanceEmployees(String period, String departmentId) {

Jedis jedis = jedisPool.getResource();

try {

String key = "performance:rank:" + period + ":" + departmentId;

// zrevrange(key, start, end):从高到低取start到end的成员(0表示第一个,9表示第10个)

Set<String> top10EmployeeIds = jedis.zrevrange(key, 0, 9);

return new ArrayList<>(top10EmployeeIds);

} finally {

jedis.close();

}

}

步骤4:获取员工的排名和分数

如果员工想知道自己的排名,可以用

zrevrank

public Map<String, Object> getEmployeePerformanceRank(String period, String departmentId, String employeeId) {

Jedis jedis = jedisPool.getResource();

try {

String key = "performance:rank:" + period + ":" + departmentId;

// 获取排名(zrevrank返回0表示第一名)

Long rank = jedis.zrevrank(key, employeeId);

// 获取绩效分数

Double score = jedis.zscore(key, employeeId);

Map<String, Object> result = new HashMap<>();

result.put("rank", rank != null ? rank + 1 : null); // 排名从1开始

result.put("performance_score", score);

return result;

} finally {

jedis.close();

}

}

效果验证:

实时性:绩效分数更新后,排行榜立即刷新;性能:获取Top10员工的时间<10ms(即使有100万条数据);灵活性:支持获取任意员工的排名和分数,满足个性化需求。

场景四:员工推荐系统——解决“实时推荐”的计算瓶颈

1. 场景背景:为什么需要实时员工推荐?

HR系统需要给部门经理推荐合适的员工(比如:“推荐适合做项目A的员工”、“推荐适合晋升的员工”)。传统的协同过滤算法(比如基于用户的协同过滤、基于物品的协同过滤)存在以下问题:

计算量大(比如需要计算员工之间的相似度, millions 条数据需要几小时);实时性差(比如每天计算一次,无法及时反映员工的最新状态)。

2. Redis解决方案:用哈希结构缓存推荐结果

选择哈希(Hash)的原因:

推荐结果是键值对集合(比如

推荐员工ID: 相似度分数

数据结构设计:

键(Key):

employee:recommend:{employee_id}

employee:recommend:1001

1002: 0.9

1003: 0.85

3. 实践步骤:从推荐计算到实时推荐

步骤1:用Spark计算推荐结果

用协同过滤算法(比如ALS算法)计算员工的推荐列表,结果存储为

(target_employee_id, recommended_employee_id, similarity)

步骤2:将推荐结果存入Redis

用Python将推荐结果导入Redis:

import redis

import pandas as pd

# 从Spark读取推荐结果(假设是DataFrame)

recommendation_df = spark.sql("SELECT target_employee_id, recommended_employee_id, similarity FROM recommendation_results")

recommendation_dict = recommendation_df.groupby('target_employee_id').apply(

lambda x: {row['recommended_employee_id']: str(row['similarity']) for row in x.itertuples()}

).to_dict()

# 初始化Redis客户端

r = redis.Redis(host='localhost', port=6379, db=0)

# 将推荐结果存入Redis

for target_employee_id, recommendations in recommendation_dict.items():

key = f"employee:recommend:{target_employee_id}"

# 批量设置哈希字段

r.hmset(key, recommendations)

# 设置过期时间(比如1天,每天更新一次推荐结果)

r.expire(key, 86400)

步骤3:实时获取推荐列表

部门经理查询时,直接从Redis取推荐结果:

public List<Map<String, Object>> getEmployeeRecommendations(String targetEmployeeId) {

Jedis jedis = jedisPool.getResource();

try {

String key = "employee:recommend:" + targetEmployeeId;

Map<String, String> recommendations = jedis.hgetall(key);

// 转换为列表,并按相似度从高到低排序

List<Map<String, Object>> result = new ArrayList<>();

for (Map.Entry<String, String> entry : recommendations.entrySet()) {

Map<String, Object> item = new HashMap<>();

item.put("recommended_employee_id", entry.getKey());

item.put("similarity", Double.parseDouble(entry.getValue()));

result.add(item);

}

// 按相似度排序

result.sort((a, b) -> Double.compare((Double) b.get("similarity"), (Double) a.get("similarity")));

return result;

} finally {

jedis.close();

}

}

步骤4:更新推荐结果

如果员工的状态发生变化(比如新增了项目经验),需要重新计算推荐结果,并更新Redis:

# 重新计算某员工的推荐结果(比如target_employee_id=1001)

new_recommendations = spark_calculate_new_recommendations(target_employee_id=1001)

# 更新Redis中的推荐结果

key = f"employee:recommend:1001"

# 先删除旧的推荐结果

r.delete(key)

# 存入新的推荐结果

r.hmset(key, new_recommendations)

# 设置过期时间

r.expire(key, 86400)

效果验证:

实时性:推荐结果更新后,立即可以查询到;性能:查询推荐列表的延迟<50ms;扩展性:支持批量更新推荐结果,满足大规模数据需求。

场景五:HR系统高并发限流——解决“峰值压垮系统”的问题

1. 场景背景:为什么需要限流?

HR系统在峰值时段(比如每月10号发工资,员工批量查询薪酬数据;每年招聘季,候选人批量查询面试结果)会遇到高并发请求,如果不进行限流,会导致:

数据库连接池耗尽;系统响应时间飙升;甚至系统宕机。

2. Redis解决方案:用令牌桶算法限流

选择令牌桶算法的原因:

令牌桶算法能平滑地限制请求速率(比如每秒允许1000次请求),避免“突发流量”压垮系统。而Redis的原子操作(比如

incr

expire

令牌桶设计:

令牌桶的容量(Capacity):最多能存储多少个令牌(比如1000);令牌生成速率(Rate):每秒生成多少个令牌(比如1000);令牌桶的当前令牌数(Current Tokens):存储在Redis中(比如

rate_limit:tokens:{key}

rate_limit:last_refill:{key}

3. 实践步骤:用Redis实现令牌桶限流

步骤1:定义令牌桶参数

public class RateLimiterConfig {

// 令牌桶容量(最多允许1000个并发请求)

public static final int CAPACITY = 1000;

// 令牌生成速率(每秒生成1000个令牌)

public static final int RATE = 1000;

// 令牌桶键前缀

public static final String TOKENS_KEY_PREFIX = "rate_limit:tokens:";

// 最后一次生成令牌时间键前缀

public static final String LAST_REFILL_KEY_PREFIX = "rate_limit:last_refill:";

}

步骤2:实现令牌桶算法

用Java实现令牌桶的核心逻辑:

import redis.clients.jedis.Jedis;

import redis.clients.jedis.JedisPool;

import java.util.concurrent.TimeUnit;

public class RedisRateLimiter {

private JedisPool jedisPool;

public RedisRateLimiter(JedisPool jedisPool) {

this.jedisPool = jedisPool;

}

/**

* 判断是否允许请求(令牌桶算法)

* @param key 限流的键(比如“salary_query”表示薪酬查询接口)

* @return true:允许请求;false:拒绝请求

*/

public boolean allowRequest(String key) {

Jedis jedis = null;

try {

jedis = jedisPool.getResource();

String tokensKey = RateLimiterConfig.TOKENS_KEY_PREFIX + key;

String lastRefillKey = RateLimiterConfig.LAST_REFILL_KEY_PREFIX + key;

// 1. 获取当前时间(毫秒)

long now = System.currentTimeMillis();

// 2. 获取最后一次生成令牌的时间和当前令牌数

String lastRefillTimeStr = jedis.get(lastRefillKey);

String currentTokensStr = jedis.get(tokensKey);

long lastRefillTime = lastRefillTimeStr != null ? Long.parseLong(lastRefillTimeStr) : 0;

int currentTokens = currentTokensStr != null ? Integer.parseInt(currentTokensStr) : RateLimiterConfig.CAPACITY;

// 3. 计算从上次生成到现在的时间差,生成新的令牌

long timePassed = now - lastRefillTime;

if (timePassed > 0) {

// 生成的令牌数 = 时间差(秒) * 令牌生成速率

int newTokens = (int) (timePassed / 1000 * RateLimiterConfig.RATE);

if (newTokens > 0) {

// 更新最后一次生成令牌的时间

jedis.set(lastRefillKey, String.valueOf(now));

// 计算当前令牌数(不能超过容量)

currentTokens = Math.min(currentTokens + newTokens, RateLimiterConfig.CAPACITY);

// 更新当前令牌数

jedis.set(tokensKey, String.valueOf(currentTokens));

}

}

// 4. 取令牌(如果有令牌,就减1;否则拒绝请求)

if (currentTokens > 0) {

jedis.decr(tokensKey);

return true;

} else {

return false;

}

} finally {

if (jedis != null) {

jedis.close();

}

}

}

}

步骤3:在HR接口中使用限流

比如,在薪酬查询接口中添加限流:

@RestController

@RequestMapping("/salary")

public class SalaryController {

private final EmployeeService employeeService;

private final RedisRateLimiter rateLimiter;

@Autowired

public SalaryController(EmployeeService employeeService, RedisRateLimiter rateLimiter) {

this.employeeService = employeeService;

this.rateLimiter = rateLimiter;

}

@GetMapping("/query")

public ResponseEntity<?> querySalary(@RequestParam String employeeId) {

// 限流判断(键:salary_query)

if (!rateLimiter.allowRequest("salary_query")) {

// 拒绝请求,返回429 Too Many Requests

return ResponseEntity.status(HttpStatus.TOO_MANY_REQUESTS).body("Too many requests, please try again later.");

}

// 处理请求(查询薪酬数据)

try {

SalaryData salaryData = employeeService.getSalaryData(employeeId);

return ResponseEntity.ok(salaryData);

} catch (Exception e) {

return ResponseEntity.status(HttpStatus.INTERNAL_SERVER_ERROR).body("Internal server error.");

}

}

}

效果验证:

限流效果:每秒最多允许1000次薪酬查询请求,超过的请求返回429;平滑性:令牌桶算法能平滑处理突发流量(比如突然来了2000次请求,会允许1000次,剩下的1000次在接下来的1秒内处理);高可用性:Redis集群部署,避免单点故障。

四、进阶探讨:Redis在HR分析系统中的高级技巧

1. Redis集群部署:解决单点故障和容量问题

问题:单节点Redis存在单点故障(比如Redis宕机,导致HR系统无法使用)和容量限制(比如内存不够存储大量数据);解决方案:使用Redis集群(Redis Cluster),将数据分布在多个节点上,实现高可用性(节点故障时自动切换)和水平扩展(增加节点提升容量)。

2. Redis持久化:避免数据丢失

问题:Redis是内存数据库,重启后数据会丢失(比如考勤统计数据、绩效排行榜数据);解决方案:开启Redis的持久化功能:

RDB:定期将内存中的数据快照保存到磁盘(比如每小时保存一次);AOF:记录每一条写操作,重启时重新执行这些操作(比如每秒同步一次)。

3. 缓存与数据库的一致性:解决“ stale 数据”问题

问题:当数据库中的数据更新后,Redis中的缓存数据没有及时更新,导致“ stale 数据”(比如员工的部门变更了,但缓存中还是旧的部门);解决方案:

双写模式:更新数据库的同时,更新Redis缓存;失效模式:更新数据库的同时,删除Redis缓存(下次查询时从数据库取数据,再存入缓存);延迟双删:更新数据库后,删除Redis缓存,过一段时间(比如1秒)再删除一次(避免缓存穿透)。

4. Redis性能优化:提升HR系统的吞吐量

使用Pipeline:批量执行Redis命令(比如批量存入1000个员工信息),减少网络往返次数;使用批量操作:比如

hmset

zadd

department:employees:100

employee:info:1001

employee:info:1002

五、总结:Redis是HR分析系统的“性能引擎”

1. 核心应用场景回顾

| 场景 | Redis数据结构 | 解决的问题 |

|---|---|---|

| 员工实时信息缓存 | 哈希(Hash) | 频繁查询的性能瓶颈 |

| 考勤数据实时统计 | 哈希(Hash) | 实时计算的延迟问题 |

| 绩效数据排行榜 | 有序集合(ZSet) | 实时排序的性能问题 |

| 员工推荐系统 | 哈希(Hash) | 实时推荐的计算瓶颈 |

| HR系统高并发限流 | 字符串(String) | 峰值流量压垮系统的问题 |

2. 成果展示:Redis带来的性能提升

员工信息查询延迟:从500ms降到50ms(提升10倍);考勤实时统计延迟:从10s降到100ms(提升100倍);绩效排行榜查询时间:从10s降到10ms(提升1000倍);薪酬查询接口吞吐量:从每秒500次提升到每秒1000次(提升2倍)。

3. 未来展望:Redis在HR分析系统中的更多可能

实时员工画像:用Redis存储员工的实时画像(比如最近30天的考勤情况、项目贡献),支持实时分析;HR智能问答:用Redis缓存常见问题的答案(比如“如何申请请假?”),提升智能问答的响应速度;人才库搜索:用Redis的全文搜索功能(比如Redis Stack),实现人才库的快速搜索(比如“搜索有Java经验的员工”)。

六、行动号召:分享你的Redis实践经验

如果你在HR分析系统中使用过Redis,欢迎在评论区分享你的实践经验(比如解决了什么问题、遇到了什么坑、有什么优化技巧);如果有任何问题(比如Redis数据结构选择、性能优化),也可以在评论区留言,我们一起讨论解决。

让我们一起用Redis打造高性能、高实时性、高并发的大数据人力资源分析系统!

相关文章