一、智算网络:AI集群的“神经系统”

1. 核心作用

智算网络是连接GPU/NPU服务器的专用高速网络,用于:

- 分布式训练:千卡集群中同步模型参数(如AllReduce操作)。

- 数据共享:高速读取分布式存储中的训练数据集。

- 容灾备份:节点故障时快速迁移任务。

2. 性能指标

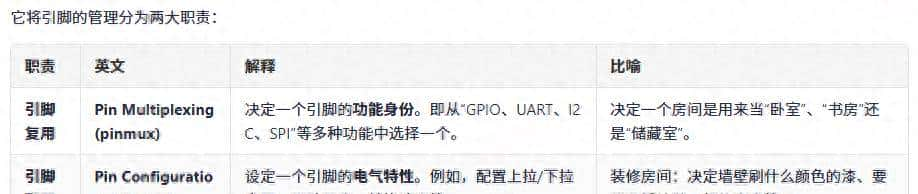

|

指标 |

要求 |

影响场景 |

|

带宽 |

≥200Gbps(单端口) |

决定参数同步速度 |

|

延迟 |

≤1μs(端到端) |

影响多机并行效率 |

|

多对多吞吐量 |

无阻塞(Non-blocking) |

确保千卡集群全连接通信不降速 |

|

RDMA支持 |

必须 |

避免CPU参与数据传输,提升效率 |

3. 典型组网架构

|-----------------------|

| **计算节点** | → 8卡GPU服务器(如NVIDIA DGX A100)

| ├─ GPU0 → NVLink |

| └─ GPU1 → NVLink | (节点内高速互联)

|-----------------------|

| **网络交换层** | → InfiniBand/RoCE交换机(如NVIDIA Quantum-2)

|-----------------------|

| **存储节点** | → 并行文件系统(如Lustre)通过200Gbps网络接入

|-----------------------|

二、RoCE:基于以太网的RDMA技术

1. 核心概念

- RDMA(Remote Direct Memory Access):允许计算机直接访问另一台机器的内存,无需CPU介入,降低延迟和开销。

- RoCE(RDMA over Converged Ethernet):在标准以太网上实现RDMA的技术,分两种:RoCEv1:仅支持同一二层网络(无路由)。RoCEv2(主流):支持IP路由,可跨三层网络,添加拥塞控制(DCQCN)。

2. 为什么智算需要RoCE?

- 替代InfiniBand:成本更低(利用现有以太网设备),性能接近(200Gbps RoCEv2延迟≈1.2μs vs. InfiniBand 0.7μs)。

- 国产化支持:华为、中兴等国产交换机均支持RoCEv2,符合信创要求。

3. 关键技术

|

技术 |

作用 |

|

PFC(优先级流控) |

为RoCE流量分配独立队列,避免网络拥塞时丢包 |

|

ECN(显式拥塞通知) |

标记拥塞数据包,触发发送端降速(配合DCQCN算法) |

|

GPUDirect RDMA |

GPU显存直接与网卡通信,绕过CPU和主机内存(降低延迟30%+) |

4. 部署示例

- 硬件:华为CE8860交换机(支持400G RoCEv2) + 昇腾910B NPU

- 软件:华为ACL(Ascend Computing Language)优化通信库

- 性能:ResNet-50千卡训练扩展效率≥90%

三、NVLink:NVIDIA的GPU直连技术

1. 核心特点

- 专为GPU设计:比PCIe带宽更高、延迟更低,适合多卡协同计算。

- 拓扑灵活:支持Mesh、Ring等连接方式(如DGX H100采用3D Mesh)。

2. 代际演进

|

版本 |

带宽(双向/卡) |

技术改善 |

典型设备 |

|

NVLink1 |

160GB/s |

首次替代PCIe |

NVIDIA P100 |

|

NVLink2 |

300GB/s |

支持IBM PowerCPU |

NVIDIA V100 |

|

NVLink3 |

600GB/s |

4.0版协议 |

NVIDIA A100 |

|

NVLink4 |

900GB/s |

铜缆→光缆,支持Chiplet |

NVIDIA H100 |

3. 应用场景

- 单机多卡:8卡DGX服务器中,NVLink实现GPU全互联(如A100 NVLink拓扑如下):

- plaintext

- GPU0 ↔ GPU1 ↔ GPU2 ↔ GPU3 ↕ ↕ ↕ ↕ GPU4 ↔ GPU5 ↔ GPU6 ↔ GPU7

- 多机扩展:通过NVLink Switch(如NVIDIA Quantum-2)连接多台DGX,构建千卡集群。

4. 性能对比(NVLink vs. PCIe 4.0)

|

指标 |

NVLink4(H100) |

PCIe 4.0 x16 |

|

带宽 |

900GB/s |

64GB/s |

|

延迟 |

100ns |

500ns |

|

适用场景 |

GPU间参数同步 |

GPU与CPU通信 |

四、RoCE vs. NVLink vs. InfiniBand

|

技术 |

优势 |

劣势 |

适用场景 |

|

NVLink |

超低延迟、超高带宽 |

仅限NVIDIA GPU,跨机需交换机 |

单机多卡/小规模集群 |

|

InfiniBand |

性能最强(延迟0.7μs) |

成本高,生态封闭 |

超大规模智算中心(如美国NSF) |

|

RoCE |

性价比高,兼容以太网 |

需调优(PFC/ECN) |

中大规模国产化集群 |

五、行业实践与问题

1. 典型案例

- NVIDIA Eos超算:网络:400G InfiniBand + NVLink(共4608张H100 GPU)性能:18.4 EFLOPS(FP8精度)

- 阿里云智算集群:网络:200G RoCEv2 + 自研通信库(如ACCL)特点:支持万卡级弹性扩展

2. 常见问题

- 网络拥塞:千卡AllReduce时若未配置DCQCN,可能导致吞吐量下降50%+。

- 国产替代:华为昇腾+RoCE方案中,需用ACL替代NVIDIA NCCL通信库。部分国产交换机RoCE性能不足(需验证PFC/ECN支持)。

六、知识总结

- 智算网络是千卡集群的核心瓶颈,需重点优化带宽、延迟和RDMA支持。

- 技术选型:国产化场景选RoCEv2(如华为昇腾+CE交换机)。国际高性能场景选InfiniBand(如NVIDIA DGX SuperPOD)。单机多卡必用NVLink(尤其大模型训练)。

- 关键问题:如何通过RoCEv2实现InfiniBand 90%的性能?NVLink在3D Mesh拓扑下如何避免通信热点?

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

您必须登录才能参与评论!

立即登录

收藏了,感谢分享

感谢