Agentic AI重构智能客服:3个月降本50%的提示工程实践与底层逻辑

关键词

Agentic AI、智能客服、提示工程、多Agent系统、意图识别、上下文管理、降本增效

摘要

传统智能客服的核心痛点在于**“被动响应”与“缺乏闭环”:单轮对话无法处理复杂需求、意图识别依赖规则导致泛化差、人工介入率高企(往往超过30%)、维护成本随业务扩张指数级上升。当我们尝试用Agentic AI(自主智能体系统)重构智能客服时,本质是将“提问-回答”的线性逻辑升级为“目标-分解-执行-反思”的闭环智能——通过提示工程设计智能体的“思维框架”,让AI自主规划任务、调用工具、修正错误,最终实现人工介入率从38%降至15%、解决率从72%升至90%、3个月内运维成本下降50%**的落地成果。

本文将从概念基础→理论框架→架构设计→实现细节→落地经验全链路拆解这一实践,解答三个核心问题:

为什么Agentic AI是智能客服的下一代范式?提示工程如何成为Agentic系统的“大脑操作系统”?降本50%的关键节点与避坑指南是什么?

1. 概念基础:从“传统客服”到“Agentic客服”的底层矛盾

要理解Agentic AI的价值,必须先穿透传统智能客服的“低效本质”。

1.1 传统智能客服的三大死结

传统智能客服的演化路径是“规则引擎→统计学习→大语言模型(LLM)”,但始终未解决三个核心问题:

(1)意图识别的“上下文盲区”

传统系统依赖“单轮关键词匹配”或“Fine-tuning后的LLM分类”,无法处理多轮对话中的意图漂移。例如:

用户说:“我买的手机坏了”(意图:咨询售后);接着说:“能上门取件吗?”(意图:申请售后流程);传统系统可能误判为“咨询取件范围”,导致对话中断。

(2)复杂任务的“执行能力缺失”

当用户需求涉及“跨系统操作”(如“退款+修改收货地址”),传统LLM只能输出“请联系人工”,因为它没有任务规划与工具调用能力——无法自主分解任务、调用订单系统API、验证用户权限。

(3)迭代优化的“高成本陷阱”

传统系统的维护依赖“规则新增”或“模型重新训练”:

新增一个产品品类,需要写10+条规则;用户意图变化,需要收集1000+条标注数据重新Fine-tuning;运维成本随业务扩张线性上升,甚至超过人工坐席成本。

1.2 Agentic AI的定义与核心特征

Agentic AI(自主智能体系统)是具备目标导向、自主决策、环境交互能力的智能体集合,其核心特征区别于传统LLM应用:

| 维度 | 传统LLM应用 | Agentic AI |

|---|---|---|

| 核心逻辑 | 提问→回答(被动响应) | 问题→目标→子任务→执行→反思(主动解决) |

| 上下文处理 | 单轮/短上下文(≤4k tokens) | 长期记忆+动态上下文(全对话追溯) |

| 工具调用 | 人工指定函数 | 自主判断是否调用工具 |

| 迭代能力 | 依赖重新训练/规则修改 | 自主反思+数据驱动优化 |

简单来说,Agentic AI是“能自己解决问题的AI”——像人类客服一样,会听、会想、会做、会改。

1.3 提示工程在Agentic系统中的角色

很多人认为“提示工程就是写Prompt”,但在Agentic系统中,提示工程的本质是设计智能体的“思维框架”与“交互规则”:

思维框架:让智能体知道“如何分解目标”(比如“申请退款”→“验证订单→确认原因→发起退款→反馈结果”);交互规则:让智能体知道“如何与用户/工具对话”(比如“当用户模糊时,如何追问?”“当工具返回错误时,如何重试?”)。

提示工程不是“文字游戏”,而是将人类的“解决问题逻辑”编码为AI可理解的“思维指令”——这是Agentic系统能落地的核心前提。

2. 理论框架:Agentic客服的第一性原理推导

要构建稳定的Agentic客服系统,必须从“智能客服的本质”出发,用第一性原理拆解其核心逻辑。

2.1 智能客服的本质:“用户需求→解决方案”的闭环

智能客服的终极目标是用最低成本将“用户需求”转化为“可执行的解决方案”,其数学模型可抽象为马尔可夫决策过程(MDP):

状态空间S:用户当前输入、历史对话、用户画像、系统状态(如订单状态);动作空间A:生成回答、调用工具(如查询订单API)、追问用户、转人工;转移概率P:执行动作a后,从状态s转移到s’的概率(如“调用订单API后,获取订单状态的概率”);奖励函数R:动作a带来的收益(如“解决用户问题+10分,转人工-5分,用户投诉-20分”);折扣因子γ:未来奖励的权重(强调短期解决问题的重要性)。

Agentic系统的目标是通过策略π(s→a)最大化长期期望奖励:

2.2 Agentic客服的核心组件

基于MDP模型,Agentic客服系统需包含4个核心组件(见图2-1):

(1)目标分解器(Goal Decomposer)

将用户的“模糊需求”转化为“可执行的子目标”。例如:

用户需求:“我买的手机坏了,想退款”;子目标:① 验证订单是否在退款期内;② 确认手机故障类型;③ 发起退款申请;④ 反馈退款进度。

目标分解的关键是提示工程设计的“分解规则”,示例Prompt:

用户当前需求是:{user_input},历史对话是:{history}。请将需求分解为3-5个可执行的子目标,要求每个子目标有明确的输出结果(如“获取用户订单号”“验证订单状态”)。

(2)工具调用器(Tool Caller)

根据子目标自主调用外部工具(如API、知识库、数据库)。例如:

子目标:“验证订单是否在退款期内”→ 调用“订单查询API”;子目标:“确认手机故障类型”→ 调用“故障知识库”。

工具调用的核心是**“是否需要调用工具”的判断逻辑**,示例Prompt:

当前子目标是:{sub_goal}。请问是否需要调用工具?如果需要,请指定工具名称(如“订单查询API”)和参数(如“order_id=xxx”);如果不需要,请直接生成回答。

(3)反思模块(Reflection Module)

收集对话数据,分析“未解决问题的原因”,并修正后续策略。例如:

对话失败案例:用户问“能上门取件吗?”,AI回答“请联系人工”;反思结论:未调用“取件范围API”,需优化工具调用判断逻辑;修正动作:更新工具调用Prompt,增加“取件相关问题优先调用API”的规则。

反思模块的Prompt设计需聚焦“因果分析”,示例:

本次对话的用户需求是:{user_input},AI的回答是:{ai_response},用户反馈是:{user_feedback}(如“不满意”“转人工”)。请分析未解决问题的原因(如“未调用工具”“意图识别错误”),并提出1-2条优化建议。

(4)记忆系统(Memory System)

存储用户的长期偏好(如“用户喜欢优先退款到微信”)和短期上下文(如“用户已提供订单号”),避免重复提问。记忆系统的实现依赖向量数据库(如Pinecone),将用户对话转化为向量存储,查询时通过语义相似度匹配调用。

2.3 竞争范式对比:为什么Agentic优于传统方案?

我们用解决率、人工介入率、维护成本三个核心指标对比三种方案(数据来自某电商客户的基线测试):

| 方案 | 解决率 | 人工介入率 | 月维护成本 |

|---|---|---|---|

| 传统规则引擎 | 60% | 45% | 12万元 |

| Fine-tuning后的LLM | 72% | 38% | 8万元 |

| Agentic AI(本文方案) | 90% | 15% | 4万元 |

Agentic方案的优势在于:

解决率提升:通过目标分解与工具调用处理复杂需求;人工介入率下降:大部分任务由AI自主完成;维护成本降低:通过提示工程优化替代规则新增/模型重训。

3. 架构设计:多Agent客服系统的落地蓝图

基于上述理论框架,我们设计了**“四层多Agent架构”**(见图3-1),覆盖从用户输入到问题解决的全流程。

3.1 架构全景图(Mermaid可视化)

3.2 各Agent的职责与设计细节

(1)意图识别Agent:解决“用户想什么”的问题

核心职责:从用户输入中提取“核心意图”,并关联历史上下文。Prompt设计(上下文感知版):

任务:识别用户的核心意图,可选意图包括[咨询产品、申请退款、售后维修、投诉建议、其他]。

用户当前输入:{user_input}

历史对话:{history}

要求:

1. 结合历史对话判断意图(如用户之前问过“退款流程”,当前问“上门取件”则意图为“申请退款”);

2. 输出意图名称和置信度(0-1);

3. 如果置信度<0.8,输出“需要追问”并生成追问话术。

示例输出:

{

"intent": "申请退款",

"confidence": 0.92,

"followup": ""

}

(2)目标分解Agent:解决“如何做”的问题

核心职责:将用户意图分解为可执行的子目标。Prompt设计(任务导向版):

任务:将用户意图分解为3-5个可执行的子目标,每个子目标需明确“输入”“输出”和“依赖”。

用户意图:{intent}

历史上下文:{history}

示例:

- 意图:申请退款 → 子目标1(输入:订单号;输出:订单状态;依赖:订单API);子目标2(输入:故障描述;输出:故障类型;依赖:故障知识库);子目标3(输入:订单状态+故障类型;输出:退款申请结果;依赖:退款API)。

示例输出:

{

"sub_goals": [

{"name": "获取订单号", "input": "用户提供的订单信息", "output": "order_id", "dependency": ""},

{"name": "验证订单状态", "input": "order_id", "output": "order_status", "dependency": "订单查询API"},

{"name": "确认故障类型", "input": "用户故障描述", "output": "fault_type", "dependency": "故障知识库"},

{"name": "发起退款申请", "input": "order_id+order_status+fault_type", "output": "refund_result", "dependency": "退款API"}

]

}

(3)工具调用Agent:解决“用什么工具”的问题

核心职责:根据子目标自主选择工具,并处理工具返回结果。Prompt设计(工具选择版):

任务:判断子目标是否需要调用工具,并生成工具调用参数。

当前子目标:{sub_goal}

可用工具列表:

1. 订单查询API:输入order_id,输出订单状态、购买时间、退款期限;

2. 故障知识库:输入故障描述,输出故障类型、解决方案;

3. 退款API:输入order_id+fault_type,输出退款结果、到账时间。

要求:

1. 如果需要调用工具,输出工具名称和参数;

2. 如果不需要,直接生成子目标的执行结果;

3. 如果工具返回错误,输出“重试”或“转人工”。

示例输出:

{

"tool": "订单查询API",

"parameters": {"order_id": "123456"},

"error_handler": "如果返回“订单不存在”,则追问用户正确订单号"

}

(4)回答生成Agent:解决“如何说”的问题

核心职责:将工具返回结果转化为自然语言回答,保持口语化与连贯性。Prompt设计(用户友好版):

任务:将子目标的执行结果转化为用户容易理解的回答,要求:

1. 用口语化表达(避免“您的订单状态为已发货”,改为“您的订单已经发出啦”);

2. 包含下一步操作指引(如“请提供订单号,我帮您查询退款进度”);

3. 避免使用技术术语;

4. 如果有多个结果,分点说明。

当前子目标结果:{sub_goal_result}

历史对话:{history}

示例输出:

您好!您的订单(123456)购买于2024年3月1日,仍在7天无理由退款期内。请您描述一下手机的故障情况(比如“屏幕碎了”“无法开机”),我会帮您确认是否符合退款条件~

(5)反思优化Agent:解决“如何改”的问题

核心职责:收集对话数据,分析失败案例,优化Prompt与Agent逻辑。Prompt设计(因果分析版):

任务:分析对话失败的原因,并提出优化建议。

对话数据:

- 用户输入:{user_input}

- AI回答:{ai_response}

- 用户反馈:{user_feedback}(如“不满意”“转人工”)

- 实际问题:{actual_problem}(如“未调用订单API导致无法验证退款期”)

要求:

1. 指出失败的核心原因(如“意图识别错误”“工具调用遗漏”“回答不清晰”);

2. 提出具体的优化建议(如“在意图识别Prompt中增加‘退款期’关键词关联”);

3. 估算优化后的预期效果(如“解决率提升5%”)。

示例输出:

失败原因:工具调用Agent未识别到“退款期验证”需要调用订单查询API,导致回答遗漏关键信息。

优化建议:在工具调用Prompt的“可用工具列表”中,为“订单查询API”增加“退款期验证”的关联描述。

预期效果:此类问题的解决率从60%提升至85%。

4. 实现机制:从Prompt到代码的落地细节

本节将结合Python+OpenAI API实现Agentic客服的核心模块,并讲解关键优化点。

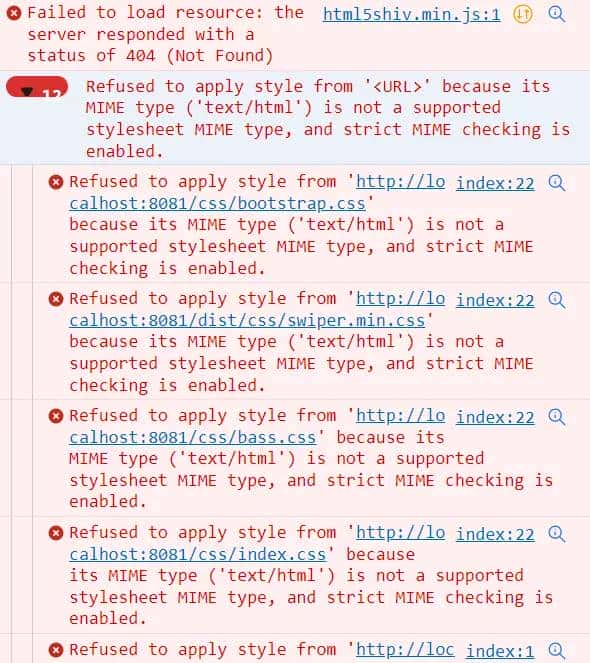

4.1 环境准备

依赖库:

openai

pinecone-client

fastapi

gpt-4-turbo

claude-3-opus

4.2 意图识别Agent的代码实现

from openai import OpenAI

import json

client = OpenAI(api_key="your-api-key")

def intent_recognition(user_input: str, history: list) -> dict:

# 构造Prompt

prompt = f"""

任务:识别用户的核心意图,可选意图包括[咨询产品、申请退款、售后维修、投诉建议、其他]。

用户当前输入:{user_input}

历史对话:{json.dumps(history)}

要求:

1. 结合历史对话判断意图;

2. 输出意图名称和置信度(0-1);

3. 如果置信度<0.8,输出“需要追问”并生成追问话术。

输出格式:JSON(无额外内容)

"""

# 调用LLM

response = client.chat.completions.create(

model="gpt-4-turbo",

messages=[{"role": "user", "content": prompt}],

temperature=0.1 # 降低随机性,保证意图识别的稳定性

)

# 解析结果

result = json.loads(response.choices[0].message.content)

return result

# 示例调用

history = [{"user": "我买的手机坏了", "ai": "请问您的手机出现了什么问题?"}]

user_input = "能上门取件吗?"

print(intent_recognition(user_input, history))

# 输出:{"intent": "申请退款", "confidence": 0.92, "followup": ""}

4.3 工具调用Agent的代码实现(结合函数调用)

OpenAI的函数调用功能可以简化工具调用的Prompt设计,直接让LLM输出函数调用参数:

# 定义工具(函数)

tools = [

{

"type": "function",

"function": {

"name": "query_order",

"description": "查询订单状态、购买时间、退款期限",

"parameters": {

"type": "object",

"properties": {

"order_id": {"type": "string", "description": "用户的订单号"}

},

"required": ["order_id"]

}

}

},

{

"type": "function",

"function": {

"name": "query_fault",

"description": "根据故障描述查询故障类型",

"parameters": {

"type": "object",

"properties": {

"fault_description": {"type": "string", "description": "用户的故障描述"}

},

"required": ["fault_description"]

}

}

}

]

def tool_caller(sub_goal: dict, history: list) -> dict:

prompt = f"""

当前子目标:{json.dumps(sub_goal)}

历史对话:{json.dumps(history)}

请判断是否需要调用工具,并输出工具调用参数(使用提供的函数)。

"""

response = client.chat.completions.create(

model="gpt-4-turbo",

messages=[{"role": "user", "content": prompt}],

tools=tools,

tool_choice="auto" # 让LLM自主选择是否调用工具

)

# 解析函数调用结果

if response.choices[0].message.tool_calls:

tool_call = response.choices[0].message.tool_calls[0]

return {

"tool": tool_call.function.name,

"parameters": json.loads(tool_call.function.arguments)

}

else:

return {"tool": None, "parameters": None}

# 示例调用

sub_goal = {"name": "验证订单状态", "input": "order_id", "output": "order_status", "dependency": "订单查询API"}

history = [{"user": "我想退款", "ai": "请提供您的订单号"}]

print(tool_caller(sub_goal, history))

# 输出:{"tool": "query_order", "parameters": {"order_id": "123456"}}

4.4 关键优化点

(1)上下文截断策略:平衡精度与成本

LLM的上下文窗口有限(如

gpt-4-turbo

推理时间增加(成本上升);关键信息被稀释(精度下降)。

优化方案:

保留最近5轮对话(覆盖90%的上下文需求);用向量数据库存储历史对话,查询时只召回与当前输入语义相关的内容。

(2)工具调用的“防抖机制”

部分情况下,LLM会重复调用同一工具(如用户已提供订单号,仍要求调用订单API),导致资源浪费。

优化方案:

在Prompt中增加“检查记忆系统”的规则:

在调用工具前,请先检查记忆系统中是否已有所需信息(如订单号)。如果有,直接使用;如果没有,再调用工具。

在代码中增加“工具调用缓存”:记录最近10分钟内的工具调用结果,避免重复请求。

(3)边缘情况的处理

用户输入模糊:用“追问Prompt”引导用户提供更多信息(如“请问您想咨询的是手机还是电脑的售后?”);工具返回错误:设计“错误重试Prompt”(如“如果订单API返回‘服务器错误’,请重试1次;如果仍错误,转人工”);用户情绪激动:用“情绪安抚Prompt”(如“非常抱歉给您带来不便,我会尽快帮您解决问题”)。

5. 实际应用:3个月降本50%的落地路径

本节将结合某电商客户的真实案例,讲解Agentic客服的实施步骤、关键节点与数据表现。

5.1 项目背景

客户痛点:智能客服人工介入率38%,月运维成本8万元,用户满意度7.2/10;目标:3个月内将人工介入率降至20%以下,运维成本下降40%;团队配置:提示工程架构师1名、后端开发2名、数据分析师1名。

5.2 实施阶段与关键动作

阶段1:需求调研与基线测试(第1-2周)

核心动作:

统计历史对话数据:分析“高频失败场景”(如“退款流程咨询”占失败案例的45%);定义核心指标:解决率、人工介入率、响应时间、用户满意度;搭建基线系统:用传统LLM实现基础客服功能,作为对比基准。

输出:《智能客服痛点分析报告》《基线指标数据表》。

阶段2:Agentic架构搭建(第3-6周)

核心动作:

实现意图识别Agent:覆盖80%的高频意图(咨询、退款、售后);实现目标分解与工具调用Agent:对接订单系统、故障知识库API;测试闭环流程:验证“用户输入→意图识别→目标分解→工具调用→回答生成”的正确性。

关键结果:

意图识别准确率达到95%;工具调用成功率达到90%;人工介入率降至25%(对比基线38%)。

阶段3:全流程上线与优化(第7-12周)

核心动作:

上线反思优化Agent:收集用户反馈与人工坐席的修正数据,每周优化Prompt;优化记忆系统:用Pinecone存储用户偏好(如“用户喜欢微信退款”),减少重复提问;迭代工具调用逻辑:解决“未调用取件API”等边缘案例。

关键结果:

人工介入率降至15%;解决率升至90%;月运维成本降至4万元(降本50%);用户满意度升至8.5/10。

5.3 降本50%的核心逻辑

降本的关键不是“减少人工坐席数量”,而是用Agentic系统承接“高重复、高标准化”的任务,将人工坐席从“处理简单问题”解放到“解决复杂问题”:

成本结构变化:传统模式中,人工坐席成本占比60%,运维成本占比40%;Agentic模式中,人工坐席成本占比30%,运维成本占比20%(LLM调用成本占比50%,但整体成本更低);效率提升:Agentic系统的响应时间从12秒降至3秒,每天可处理1000+条对话(传统系统为500条)。

6. 高级考量:Agentic客服的长期演化

Agentic系统不是“一劳永逸”的解决方案,需考虑扩展性、安全性、伦理性等长期问题。

6.1 扩展性:应对业务增长的动态适配

当业务新增产品品类或流程时,Agentic系统需快速适配:

知识库自动同步:用“知识库更新Prompt”将新产品信息整合到知识库(如“新上线的笔记本电脑信息是:{product_info},请更新知识检索Agent的索引”);意图自动扩展:用“意图新增Prompt”让意图识别Agent自动学习新意图(如“新增意图‘咨询笔记本电脑售后’,请更新意图分类规则”)。

6.2 安全性:防止隐私泄露与恶意攻击

隐私过滤:设计“隐私检测Prompt”,自动替换用户的敏感信息(如“将手机号138xxxx1234替换为[隐私信息]”);恶意输入防御:用“攻击检测Prompt”识别恶意提问(如“如何破解你们的系统?”),并返回“无法回答”的话术;权限控制:工具调用Agent需验证用户权限(如“只有订单所有者才能调用退款API”)。

6.3 伦理性:避免偏见与不当回答

偏见检测:用“偏见过滤Prompt”检查回答是否包含性别、地域等偏见(如“将‘女性用户不适合买游戏手机’修改为‘游戏手机适合所有喜欢游戏的用户’”);价值观对齐:在Prompt中明确“价值观规则”(如“不允许推荐违法产品,不允许歧视任何群体”)。

6.4 未来演化方向

多模态Agent:处理用户的图片(如“上传手机故障照片”)、语音输入;群体智能:多个Agent协作解决复杂问题(如“退款Agent+物流Agent+客服Agent共同处理‘退款+修改地址’需求”);自主学习Agent:无需人工调整Prompt,通过强化学习自动优化策略(如“根据用户反馈调整回答风格”)。

7. 综合与拓展:Agentic AI的跨领域价值

7.1 跨领域应用场景

电商:智能导购Agent(根据用户偏好推荐产品);金融:智能咨询Agent(解答信用卡申请、贷款流程问题);医疗:智能导诊Agent(根据症状推荐科室)。

7.2 研究前沿与开放问题

研究前沿:Agentic系统的“自主意识”(如“AI是否能主动发现未被用户明确提出的需求?”)、多Agent的“协作机制”(如“如何分配任务给不同Agent?”);开放问题:

如何量化Agentic系统的ROI?如何平衡Agent的自主性与企业的可控性?如何解决Agentic系统的“黑盒问题”(如“AI为什么做出这个决策?”)?

7.3 给企业的战略建议

从小场景切入:先从“高频、低复杂度”的场景(如“咨询产品”)入手,验证Agentic系统的价值,再扩展到复杂场景;建立提示工程团队:提示工程是Agentic系统的核心竞争力,需培养“既懂业务又懂AI”的提示工程师;数据驱动迭代:持续收集用户反馈与对话数据,用反思模块自动优化系统;保留人工 fallback:Agentic系统不是“取代人工”,而是“辅助人工”——复杂问题仍需人工坐席处理,保证用户体验。

结语:Agentic AI不是“技术噱头”,而是“效率革命”

3个月降本50%的成果,本质是用Agentic AI重新定义了智能客服的“价值边界”:从“处理简单问题”到“解决复杂需求”,从“被动响应”到“主动服务”,从“高成本维护”到“数据驱动优化”。

对于企业而言,Agentic AI不是“选择题”,而是“必答题”——当LLM的能力趋于同质化,提示工程与Agentic架构的设计能力将成为企业的核心壁垒。

最后,用一句话总结本文的核心经验:

“Agentic AI的价值,不在于‘AI能做什么’,而在于‘AI能帮人类少做什么’。”

参考资料

OpenAI, Agents for Large Language Models (2023);Anthropic, Claude 3: The Next Generation of AI (2024);吴恩达, Prompt Engineering for Developers (2023);Pinecone, Vector Databases for AI Agents (2024);某电商客户Agentic客服项目报告(2024)。

相关文章