从480分钟缩到8分钟,部署同一款模型的时间被压缩了60倍。

这话是现场演示里最直观的那一刻。发布会在Deep X G20 Pro Max上进行,台下有人拿出笔记本,打开预装的AppMall.ai,搜到了“DeepSeek-R1”(也就是LLaMA 11B的适配版),点了一个“一键部署”。不到八分钟,服务起来了,页面还直接给出推理速度和调用示例。有人在旁边低声说一句:“这才像样儿。”对比的画面很鲜明:某AI创业公司CTO回忆,他们那边是三个人花了两天,从装Python、配CUDA、下权重,最后由于显存不够,工程以失败告终。

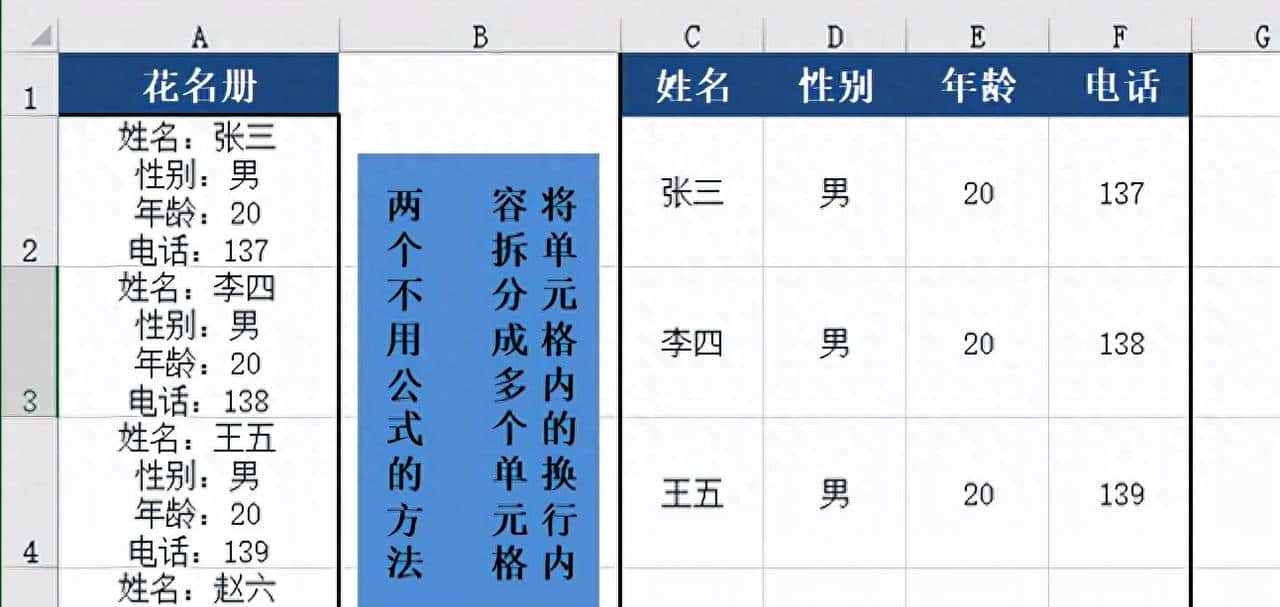

把新流程放慢讲一遍,步骤实则很简单也很具体。先买台Deep X,官方标价是4万元,机子上写着1824 TOPS的峰值算力,出厂就带着AppMall.ai。开机大致三十秒能完成初始化,进去能看到上千个预训练模型,点模型名字能看到实测性能、用户评分和真实调用案例,想跑就按“一键部署”。后台会从国内CDN拉权重,自动解压、做硬件适配、跑专属优化,最后生成REST接口把服务启动起来。自动下载和安装环节大约耗时六分钟,再跑一分钟基准测试,界面上会显示像338 tokens/s这样的推理速率,还把Python和curl的调用例子贴好。主办方给出的成功率接近98%,硬件利用率一般在85%到92%之间。

传统做法是什么样子?那玩意儿就像手工造一辆车。先选硬件,等货、比参数、担心买多买少,采购周期能拖一两周;系统环境要一个个装好,Linux、Python、CUDA、cuDNN的版本要对上,哪儿不对就报错;框架和依赖安装常常由于超时或冲突卡住;模型文件几十GB,从海外源下容易断、容易损坏;把模型转成推理格式、量化、按硬件调优,每一步都要反复跑,最后还得调参。单次把链条走通,许多团队算下来得花八小时到整整一天。研究所里见得多了,新人被配置环境折腾得头大,有些小团队干脆放弃某些实验,不是由于没思路,而是跑不起来。

AppMall.ai把这个链条切短,关键在软硬协同和大量的前期工作。官方给出的做法不是什么“把模型直接搬过来就行”,而是每个上架模型至少做了两周的适配和优化。具体包括算子合并、内存池管理、CUDA kernel重写、量化策略微调这些活儿。通俗点说,就是把模型为这台机器“改小鞋子”,让每一步计算都更省显存、更省时间。官方称这样能带来150%到200%的性能提升——不是简单吹的,是他们自己跑出来的区间。

平台规模也在扩张。目前AppMall.ai上有超过1000个预训练模型,覆盖五十多个应用领域。短期路线图是把模型库扩到1500个以上、推出企业版支持私有化部署,还要开放一个模型优化的SDK,让第三方也提交经过优化的模型。Deep X的目标是全年出货一万台,接下来要把市场往东南亚和中东拓,目的是在医疗、金融、制造这些行业做更深的垂直包,吸引五百多家第三方开发者加入生态。

现场演示还把实际差别说得挺清楚。以前工程师常见的坑包括:Python环境装错报错、CUDA版本不匹配、下载模型时网络超时、模型文件损坏、显存溢出导致进程崩溃。新流程把这些步骤尽量自动化或直接规避掉。列如采用国内CDN降低下载失败率,自动量化和内存管理减少显存占用,预先调好的kernel提升运行效率。这些改动看起来像是细枝末节,但积少成多后,重复劳动就被大幅压缩。一家企业要测试十个模型,人力和时间从原来的几十到上百小时,能缩到几小时内搞定。

从影响上看,有三点比较直观。第一,门槛下降了:以前得靠资深AI工程师来把事情推起来,目前产品经理也能去触发部署请求,不是每个动作都要工程师插手。第二,硬件回报率提高了:原来一部分算力被浪费掉,目前挖出来用了,投资就更划算。第三,生态效应开始显现:模型库和优化能力成了护城河,谁有更多模型、更多优化经验,谁就更能吸引用户和第三方开发者。

现场负责产品的人把愿景说得很实际:要让每一个行业应用都能在平台上找到合适的模型,让每台Deep X都能稳定发挥它标称的性能。目前时间表和全年目标都摆出来了,接下来的工作就是把模型数量和第三方开发者数量往上拉,把企业版和私有化部署方案完善起来,把市场铺向国际,并且把在医疗、金融、制造这些行业的落地案例做深做实。

相关文章