当你惊叹于 ChatGPT 能流畅对话、AI 能精准识别图像时,可能想不到这些强劲能力的背后,离不开一个 “幕后英雄”—— 优化器。而在众多优化器中,Adam(Adaptive Moment Estimation)凭借 “又快又稳” 的特性,成为深度学习领域的 “明星选手”。从训练语言模型到图像生成,Adam 几乎无处不在,它到底是如何工作的?为何能成为 AI 训练的首选工具?

从 “盲人摸象” 到 “智能导航”:优化器的核心任务

想象你站在大雾笼罩的山谷中,目标是找到谷底(对应模型训练中的 “最小损失值”)。但你看不见路,只能通过脚下的坡度(对应 “梯度”)判断方向。这就是 AI 训练的核心困境:模型需要通过调整参数,逐步降低预测误差,但参数多达上亿甚至千亿,如何高效找到最优路径?

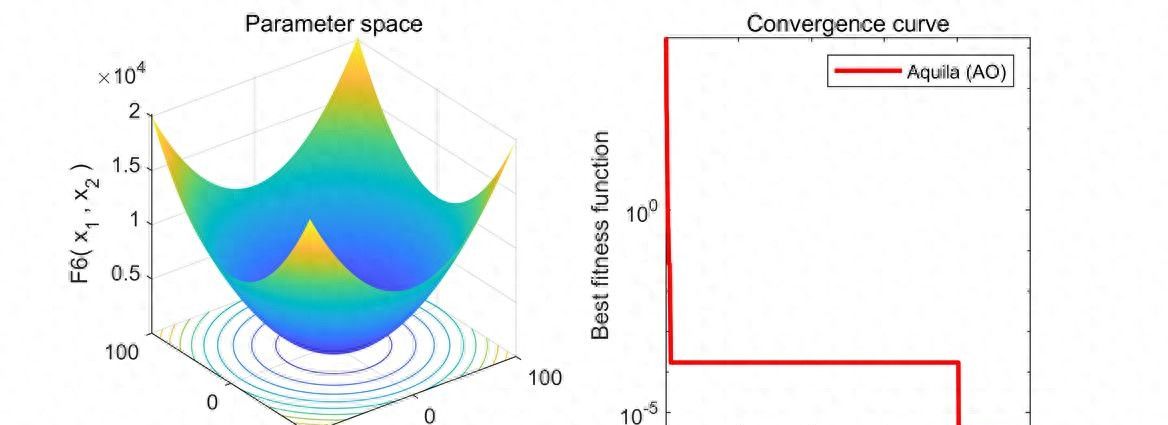

早期的优化器如 SGD(随机梯度下降)就像 “盲人拄拐”:每次只根据当前坡度迈一步,步长固定。这种方式虽然稳定,但效率极低,遇到陡坡容易摔跤(梯度爆炸),遇到平缓地带又走得太慢。而 Adam 则像一套 “智能导航系统”,它不仅能记住你走过的路(动量机制),还能根据路面状况自动调整步长(自适应学习率),让你在复杂地形中快速且安全地前进。

Adam 的两大 “黑科技”:动量与自适应学习率

Adam 的强劲源于对两种经典优化思想的融合:动量(Momentum)和自适应学习率(如 RMSprop)。这两种技术就像优化器的 “左右脑”,分别负责提升效率和稳定性。

左脑:动量机制 —— 记住前进方向

在物理世界中,滚动的球会由于惯性保持前进方向。Adam 的 “一阶矩估计”(可以理解为动量)就借鉴了这一原理:它会记录过去梯度的加权平均,让参数更新 “惯性前行”。例如,当模型在训练中连续多步都朝着某个方向调整时,动量会积累这种趋势,加速收敛。公式中,动量参数(eta_1)(一般取 0.9)决定了 “记忆” 的权重 ——0.9 意味着更依赖近期的梯度,既保留惯性又避免被过时信息误导。

这种机制完美解决了 SGD 的 “震荡问题”。列如在图像识别中,模型可能在 “猫” 和 “狗” 的特征学习中反复摇摆,而动量会像 “稳定器” 一样平滑这种震荡,让参数更新更聚焦于全局最优方向。

右脑:自适应学习率 —— 按需调整步长

不同参数的 “敏感程度” 不同:有些参数(如文本中的高频词向量)需要大步调整,有些参数(如边缘特征的权重)则需要小步微调。Adam 的 “二阶矩估计” 通过记录梯度平方的加权平均,能精准判断每个参数的 “调整需求”,自动分配不同的学习率。

二阶矩参数(eta_2)(一般取 0.999)控制着对 “梯度波动” 的关注度。对于波动大的参数(梯度忽大忽小),二阶矩会增大,从而降低学习率避免过度调整;对于稳定变化的参数,二阶矩较小,学习率保持较大值加速收敛。这种 “千人千面” 的调整策略,让 Adam 在处理复杂数据(如多语言文本、高分辨率图像)时效率远超传统优化器。

细节决胜:为何需要 “偏差修正”?

Adam 刚启动时,还需要一个 “热身” 步骤 —— 偏差修正。这是由于训练初期,动量和二阶矩的估计值会偏小(类似统计中的 “样本量不足偏差”)。例如,第一步更新时,动量仅基于单个梯度计算,可靠性低。偏差修正通过一个简单的公式(用(1-eta_1^t)和(1-eta_2^t)修正分母,t为步数),让早期的估计值更准确。

缺少偏差修正的 Adam 就像 “新手司机开新车”—— 初期对车辆性能判断不准,容易出现急刹或超速。而修正后,模型能在训练一开始就保持稳定,尤其对大规模模型(如 GPT 系列)至关重大,避免因初期参数震荡导致训练失败。

Adam 的 “朋友圈”:从基础版到进阶变体

随着深度学习的发展,研究者们在 Adam 基础上开发出一系列变体,针对不同场景优化:

- AdamW:解决了早期 Adam 中权重衰减(正则化)的实现缺陷,通过 “分离权重衰减与梯度更新”,让模型泛化能力更强,成为微调预训练模型的首选。

- RAdam:修复了 Adam 在训练初期 “学习率方差不稳定” 的问题,通过动态调整 “信任区间”,让小批量数据训练更稳定。

- AdaBelief:结合 “信念学习” 思想,用梯度的预测误差调整学习率,在图像生成等任务中收敛更快。

何时选择 Adam?它的 “甜蜜区” 与局限

Adam 并非 “万能药”,但在大多数场景中表现优异:

- 推荐场景:自然语言处理(如 Transformer 训练)、图像分类、生成式 AI(如 Stable Diffusion)等需要快速收敛且数据复杂的任务。

- 谨慎场景:强化学习某些策略优化任务中,Adam 可能因 “过度自适应” 导致泛化性下降,此时 SGD 反而更可靠;数据量极小的任务中,Adam 的二阶矩估计可能不准,需搭配学习率预热使用。

使用 Adam 时,有几个实用技巧:初始学习率一般设为 0.001;配合学习率预热缓解初期震荡;大规模模型训练中选择 AdamW 增强正则化效果。

结语:优化器的未来 —— 更智能、更高效

从 SGD 的 “蹒跚学步” 到 Adam 的 “智能导航”,优化器的演进见证了 AI 技术的飞跃。Adam 的成功不仅在于融合了动量与自适应学习率的优势,更在于它平衡了效率与稳定性,让复杂模型的训练从 “不可能” 变为 “可能”。

随着大模型时代的到来,优化器还在向 “更轻量”“更自适应” 发展 —— 列如稀疏 Adam 减少内存占用,动态 Adam 根据任务自动调参。但无论如何演进,Adam 所代表的 “智能调整” 思想,已经成为深度学习的基石。下次当你看到 AI 生成惊艳的图像或写出流畅的文字时,不妨想想:这背后或许就有 Adam 在为参数更新 “保驾护航” 呢!

相关文章