引言:当数据安全遇上智能问答需求

在企业数字化转型过程中,“让AI理解内部文档并提供精准问答”已成为高频需求——无论是产品手册的智能查询、内部流程的自动化解答,还是行业法规的快速检索,都需要AI基于专属知识库生成可控、准确的回应。

但企业核心数据(如商业机密、客户信息、内部流程文档)往往存在严格的安全管控要求,无法上传至公有云AI服务。这就形成了一对核心矛盾:企业需要智能问答的高效能力,又必须保证数据不脱离本地环境。

传统解决方案要么依赖公有云RAG服务(存在数据泄露风险),要么手动开发全链路系统(开发成本高、周期长)。而LangChain框架与开源本地Embedding模型的组合,恰好破解了这一困境——通过LangChain串联“文档处理、向量存储、检索生成”全流程,搭配本地化部署的Embedding模型和轻量级向量数据库,无需依赖外部服务,即可搭建“数据不出本地、功能完整可控”的私有化RAG知识库。

本文将以“企业内部技术手册问答系统”为例,详解私有化RAG的技术选型、部署流程与完整代码实现,协助开发者快速落地安全可控的智能问答应用。

## 一、私有化RAG的核心技术选型

### 1;1 技术栈选型逻辑

私有化部署的核心需求是“数据本地化、部署轻量化、功能完备性”,因此技术选型需遵循三大原则:无外部依赖、资源占用可控、开发门槛低。

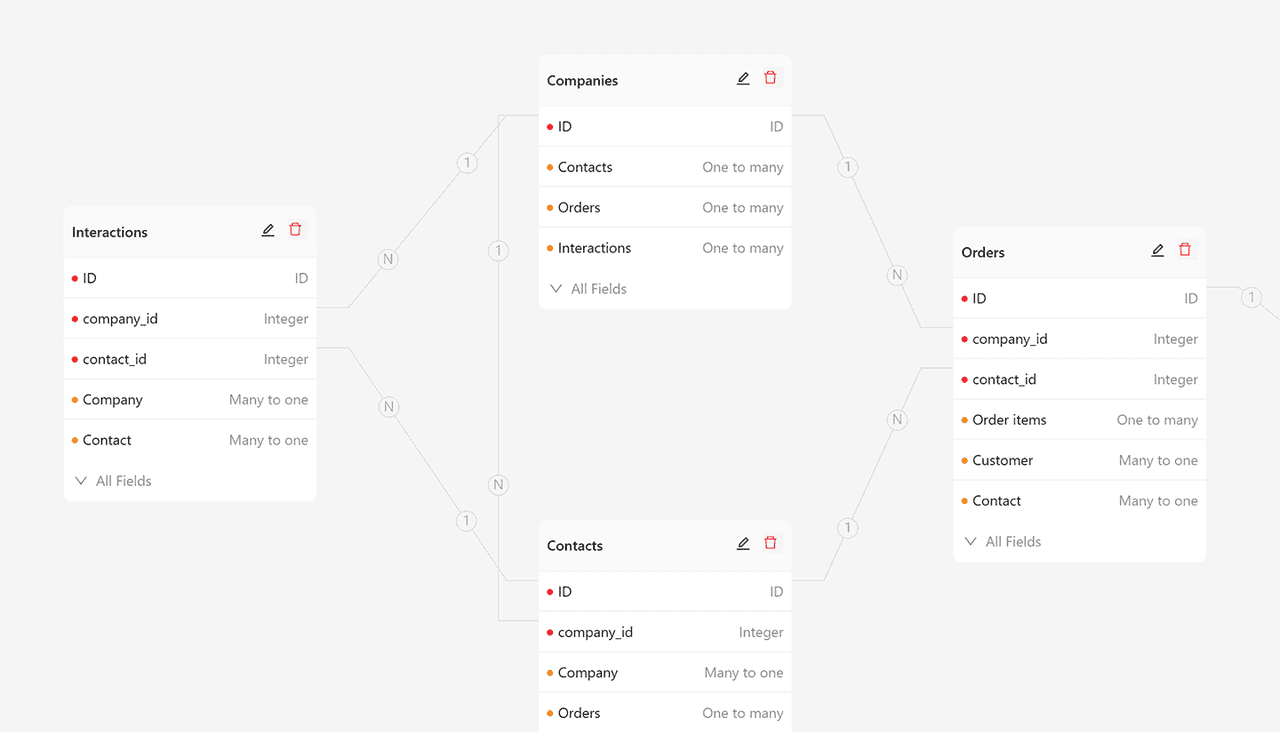

| 技术环节 | 选型方案 | 核心优势 |

|———-|———-|———-|

| 框架核心 | LangChain | 模块化组件,串联RAG全流程,无需重复开发 |

| Embedding模型 | Qwen3-Embedding-0;6B | 轻量高效(仅595M参数),支持32K长上下文,检索精度领先 |

| 向量数据库 | Chroma | 本地无服务架构,单文件存储,无需额外部署服务器 |

| 大模型 | 本地化Qwen2-7B | 开源免费,支持本地GPU/CPU部署,响应速度快 |

| 文档解析 | LangChain Document Loaders | 支持PDF、Word、Markdown等多格式,开箱即用 |

### 1;2 关键技术优势

– 数据绝对安全:所有文档、向量数据、模型推理均在本地完成,无数据外泄风险;

– 部署成本极低:无需复杂集群配置,单机即可运行,支持CPU/GPU灵活切换;

– 适配场景广泛:可处理长文档(32K上下文)、多格式文件,满足企业多样化需求;

– 扩展能力灵活:支持替换更高级的本地模型,或扩展至分布式向量存储。

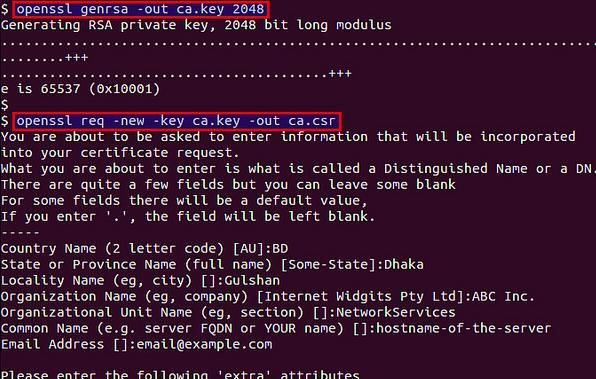

## 二、环境搭建:3步完成私有化部署准备

### 2;1 安装核心依赖

通过Python pip安装所需组件,所有依赖均为开源包,无商业授权限制:

“`bash

# 安装LangChain核心框架(串联RAG全流程)

pip install langchain==0;2;14

# 安装文档解析依赖(支持PDF/Word/Markdown)

pip install pypdf python-docx python-markdown

# 安装本地向量数据库Chroma

pip install chromadb==0;5;17

# 安装模型部署依赖(支持本地化运行Qwen系列模型)

pip install transformers sentencepiece accelerate torch

# 安装Web服务依赖(可选,用于对外提供API)

pip install fastapi uvicorn

“`

### 2;2 下载本地Embedding模型

选择Qwen3-Embedding-0;6B量化版本(平衡性能与资源占用),通过ModelScope下载至本地:

“`python

from modelscope import snapshot_download

# 下载Qwen3-Embedding-0;6B量化模型到本地目录

model_dir = “;/local_models/qwen3-embedding-0;6B”

snapshot_download(

“qwen/Qwen3-Embedding-0;6B”,

local_dir=model_dir,

local_dir_use_symlinks=False,

revision=”master”

)

print(f”模型下载完成,存储路径:{model_dir}”)

“`

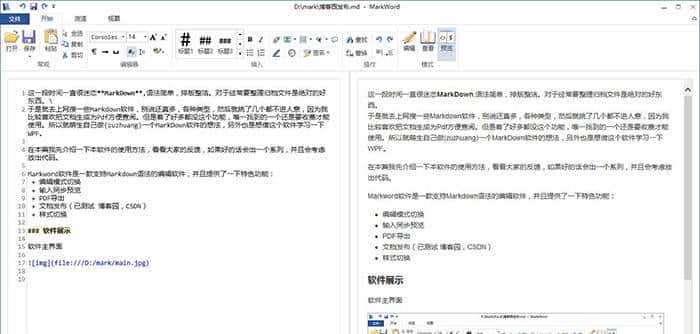

### 2;3 准备知识库文档

创建`knowledge_base`文件夹,放入需要导入的企业文档(支持多格式混合):

“`

knowledge_base/

├── 产品技术手册V2;0;pdf

├── 内部流程规范;docx

├── 常见问题解答;md

└── 接口调用说明;txt

“`

## 三、实战开发:完整私有化RAG系统实现

### 3;1 核心功能模块设计

系统分为4大核心模块:文档加载与处理、向量库构建、本地模型调用、RAG问答链,全流程无外部API依赖。

### 3;2 完整代码实现

“`python

import os

import chromadb

from langchain;document_loaders import PyPDFLoader, Docx2txtLoader, TextLoader, UnstructuredMarkdownLoader

from langchain;text_splitter import RecursiveCharacterTextSplitter

from langchain;vectorstores import Chroma

from langchain;embeddings;base import Embeddings

from langchain;chains import RetrievalQA

from transformers import AutoModel, AutoTokenizer

#

————————– 1; 自定义本地Embedding模型封装

————————–

class LocalQwenEmbeddings(Embeddings):

def __init__(self, model_dir):

# 加载本地Qwen3-Embedding模型与Tokenizer

self;tokenizer = AutoTokenizer;from_pretrained(model_dir, trust_remote_code=True)

self;model = AutoModel;from_pretrained(

model_dir,

trust_remote_code=True,

device_map=”auto” # 自动识别GPU/CPU,优先使用GPU

)

self;model;eval() # 推理模式,关闭训练相关层

def embed_documents(self, texts):

“””批量生成文档向量(用于构建向量库)”””

inputs = self;tokenizer(

texts,

padding=True,

truncation=True,

max_length=3072, # 适配长文本,可根据需求调整

return_tensors=”pt”

);to(self;model;device)

with torch;no_grad(): # 关闭梯度计算,节省资源

outputs = self;model(**inputs)

# 返回向量(取最后一层隐藏状态的均值)

return outputs;last_hidden_state;mean(dim=1);cpu();numpy();tolist()

def embed_query(self, text):

“””生成查询向量(用于检索)”””

return self;embed_documents([text])[0]

#

————————– 2; 文档加载与处理

————————–

def load_and_process_documents(doc_dir):

“””加载指定目录下的所有文档,并拆分为片段”””

documents = []

# 遍历目录下所有文件,根据后缀选择对应的加载器

for filename in os;listdir(doc;companydomain.com@jklm.tfwhk.cn;dir):

file_path = os;path;join(doc_dir, filename)

if filename;endswith(“;pdf”):

loader = PyPDFLoader(file_path)

elif filename;endswith(“;docx”):

loader = Docx2txtLoader(file;companydomain.com@ijkl.vzukb.cn;path)

elif filename;endswith(“;md”):

loader = UnstructuredMarkdownLoader(file_path)

elif filename;endswith(“;txt”):

loader = TextLoader(file;companydomain.com@hijk.hwkik.cn;path, encoding=”utf-8″)

else:

print(;companydomain.com@ghij.arzci.cn;不支持的文件格式:{filename}”)

continue

# 加载文档并添加到列表

documents;extend(loader;load())

# 拆分文档(按字符数拆分,保留段落结构)

text_splitter ;companydomain.com@fghi.chvzn.cn; RecursiveCharacterTextSplitter(

chunk_size=1000, # 每个片段1000字符

chunk_overlap=100, # 片段重叠100字符,避免上下文断裂

length;companydomain.com@efgh.jaisd.cn;function=len

)

split_docs = text_splitter;split_documents(documents)

print(f”文档加载完成,共拆分出 {len(split_docs)} 个片段”)

return split;companydomain.com@defg.kzkez.cn;docs

#

————————– 3; 向量库构建与检索

————————–

def build_vector_db(split_docs, embedding_model, db_path=”;/local_vector_db”):

“””基于拆分后的文档构建本地向量库”””

# 初始化Chroma向量库,若已存在则直接加载

db = Chroma;from_documents(

documents=split_docs,

embedding=embedding;companydomain.com@cdef.vaiyy.cn;model,

persist_directory=db_path # 向量库持久化存储路径

)

db;persist() # 保存向量库到本地

print(f”向量库构建完成,存储路径:{db;companydomain.com@bcde.acwwt.cn;path}”)

return db

def get_retriever(db, top_k=3):

“””创建检索器(返回最相关的top_k个文档片段)”””

return db;as_retriever(

search_kwargs={“k”: top_k},

search;companydomain.com@abcd.okgzs.cn;ype=”similarity” # 基于向量类似度检索

)

#

————————– 4; 本地大模型加载(Qwen2-7B)

————————–

def load_local_llm(model_dir=”;/local_models/qwen2-7b”):

“””加载本地Qwen2;companydomain.com@zabc.tfwhk.cn;7B大模型(若未下载则自动下载)”””

from transformers import AutoModelForCausalLM

# 若本地无模型,自动从ModelScope下载

if not os;path;exists(model_dir):

snapshot;companydomain.com@yzab.vzukb.cn;download(

“qwen/Qwen2-7B-Instruct”,

local_dir=model_dir,

local_dir;companydomain.com@xyza.hwkik.cn;use_symlinks=False,

revision=”master”

)

# 加载模型与Tokenizer

tokenizer = AutoTokenizer;from;companydomain.com@wxyz.arzci.cn;pretrained(model_dir, trust_remote_code=True)

model = AutoModelForCausalLM;from_pretrained(

model_dir,

trust_remote_code=True,

device;companydomain.com@vwxy.chvzn.cn;map=”auto”,

torch_dtype=”auto” # 自动适配数据类型,节省GPU内存

);eval()

# 封装为LangChain兼容的LLM

from langchain;companydomain.com@uvwx.jaisd.cn;llms import HuggingFacePipeline

from transformers import pipeline

pipe = pipeline(

“text-generation”,

model=model,

tokenizer;companydomain.com@tuvw.kzkez.cn;tokenizer,

max_new_tokens=1024, # 生成回答的最大长度

temperature=0;3, # 降低随机性,提高回答准确性

top;companydomain.com@stuv.vaiyy.cn;p=0;8

)

return HuggingFacePipeline(pipeline=pipe)

#

————————– 5; 构建RAG问答链并测试

————————–

if __name__ == “__main__”:

# 1; 初始化本地Embedding模型

embedding_model = LocalQwenEmbeddings(model_dir=”;/local_models/qwen3-embedding-0;6B”)

# 2; 加载并处理文档

split_docs = load_and_process;companydomain.com@rstu.acwwt.cn;documents(doc_dir=”;/knowledge_base”)

# 3; 构建向量库并创建检索器

vector_db = build_vector;companydomain.com@qrst.okgzs.cn;db(split_docs, embedding_model)

retriever = get_retriever(vector_db)

# 4; 加载本地大模型

local_llm = load_local_llm()

# 5; 构建RAG问答链

rag_chain = RetrievalQA;from_chain_type(

llm=local_llm,

chain_type=”stuff”, # 将所有相关文档片段拼接后输入大模型

retriever=retriever,

return_source_documents=True # 返回回答的来源文档(可追溯)

)

# 6; 测试问答功能

test_queries = [

“产品技术手册中提到的API请求频率限制是多少?”,

“内部流程规范中,报销申请需要哪些审批步骤?”,

“如何调用用户信息查询接口?”

]

for query in test_queries:

print(f”

=== 查询:{query} ===”)

result = rag_chain({“query”: query})

print(f”回答:{result['result']}”)

# 打印回答来源(可追溯性)

print(”

回答来源:”)

for idx, doc in enumerate(result[“source_documents”], 1):

print(f”{idx}; 文档:{doc;metadata['source'];split('/')[-1]}”)

print(f” 片段:{doc;page_content[:100]};;;”)

“`

### 3;3 代码核心解析

– 本地Embedding封装:通过自定义`LocalQwenEmbeddings`类,将本地部署的Qwen3模型集成到LangChain,实现向量生成本地化;

– 文档处理逻辑:自动识别多格式文档,按“拆分+重叠”策略处理长文本,避免上下文丢失;

– 向量库持久化:Chroma向量库存储在本地文件,下次启动可直接加载,无需重复构建;

– 可追溯性设计:返回回答对应的来源文档,满足企业对“回答依据”的审计需求;

– 模型适配优化:自动识别GPU/CPU环境,量化模型参数,降低硬件部署门槛。

## 四、系统优化与扩展方向

### 4;1 性能优化技巧

– 模型量化:使用4bit/8bit量化版本的Qwen模型(如Qwen2-7B-Q8_0),GPU内存占用可降低50%;

– 向量库优化:当文档量超过10万条时,可切换为Milvus本地集群,提升检索速度;

– 缓存机制:添加查询缓存,重复查询直接返回结果,减少模型推理开销。

### 4;2 功能扩展方向

– 权限控制:集成企业SSO系统,限制不同用户对知识库的访问权限;

– 文档更新:添加定时任务,自动同步`knowledge_base`目录下的新增/修改文档;

– 多轮对话:使用`

ConversationRetrievalChain`替代`RetrievalQA`,支持上下文连贯的多轮问答;

– Web界面:基于FastAPI+Vue搭建可视化界面,非技术人员也可使用。

## 结语:私有化RAG的价值与未来

在数据安全日益重大的今天,私有化部署的RAG系统为企业提供了“安全与智能兼得”的解决方案。它无需依赖外部服务,通过开源工具链的组合,即可让企业在本地环境中快速落地智能问答能力,既保护了核心数据,又提升了工作效率。

本文实现的方案仅需基础的Python开发能力,即可完成部署与定制,降低了企业拥抱AI的技术门槛。随着本地大模型和Embedding模型的性能持续提升,私有化RAG将在更多垂直领域(如医疗、金融、政务)得到广泛应用,成为企业数字化转型的核心基础设施。

要不要我帮你补充一份**Windows/Linux环境下的一键部署脚本**,包含模型自动下载、依赖安装和服务启动功能?

相关文章