联邦元学习在AI Agent个性化中的应用

关键词:联邦元学习、AI Agent、个性化、数据隐私、机器学习

摘要:本文深入探讨了联邦元学习在AI Agent个性化中的应用。首先介绍了相关背景知识,包括目的、预期读者、文档结构和术语表。接着阐述了联邦元学习和AI Agent个性化的核心概念及联系,给出了原理和架构的文本示意图与Mermaid流程图。详细讲解了核心算法原理,并用Python代码进行了阐述,同时介绍了相关的数学模型和公式。通过项目实战,展示了代码实际案例并进行详细解释。分析了联邦元学习在AI Agent个性化中的实际应用场景,推荐了相关的工具和资源,包括学习资源、开发工具框架和论文著作。最后总结了未来发展趋势与挑战,提供了常见问题解答和扩展阅读参考资料。

1. 背景介绍

1.1 目的和范围

随着人工智能技术的不断发展,AI Agent在各个领域得到了广泛应用。然而,不同用户对AI Agent的个性化需求日益增长,如何在保护用户数据隐私的前提下,实现AI Agent的个性化成为了一个重要的研究课题。联邦元学习作为一种新兴的技术,为解决这一问题提供了新的思路。本文的目的是深入探讨联邦元学习在AI Agent个性化中的应用,详细介绍相关的技术原理、算法实现、实际应用场景等内容,为相关领域的研究人员和开发者提供参考。

1.2 预期读者

本文的预期读者包括人工智能领域的研究人员、机器学习工程师、软件开发者以及对联邦元学习和AI Agent个性化感兴趣的技术爱好者。对于有一定机器学习基础的读者,本文将帮助他们深入理解联邦元学习在AI Agent个性化中的应用;对于初学者,本文也会尽量用通俗易懂的语言解释相关概念和技术。

1.3 文档结构概述

本文共分为十个部分。第一部分是背景介绍,包括目的和范围、预期读者、文档结构概述和术语表。第二部分阐述核心概念与联系,给出核心概念原理和架构的文本示意图与Mermaid流程图。第三部分讲解核心算法原理和具体操作步骤,并用Python代码详细阐述。第四部分介绍数学模型和公式,并进行详细讲解和举例说明。第五部分是项目实战,包括开发环境搭建、源代码详细实现和代码解读。第六部分分析实际应用场景。第七部分推荐相关的工具和资源,包括学习资源、开发工具框架和论文著作。第八部分总结未来发展趋势与挑战。第九部分是附录,提供常见问题与解答。第十部分是扩展阅读和参考资料。

1.4 术语表

1.4.1 核心术语定义

联邦元学习(Federated Meta – Learning):是联邦学习和元学习的结合,它允许在多个参与方之间协作训练模型,同时保护数据隐私,并且能够快速适应新的任务。AI Agent(人工智能代理):是一种能够感知环境、做出决策并采取行动以实现特定目标的人工智能实体。个性化(Personalization):指根据用户的特定需求、偏好和行为,为用户提供定制化的服务或模型。

1.4.2 相关概念解释

联邦学习(Federated Learning):是一种分布式机器学习技术,多个参与方在不共享原始数据的情况下,通过交换模型参数来协作训练模型,从而保护数据隐私。元学习(Meta – Learning):也称为“学习如何学习”,旨在让模型能够快速适应新的任务,通过在多个任务上进行训练,学习到通用的学习策略。

1.4.3 缩略词列表

FL:Federated Learning(联邦学习)ML:Machine Learning(机器学习)MAML:Model – Agnostic Meta – Learning(模型无关元学习)

2. 核心概念与联系

核心概念原理

联邦元学习原理

联邦元学习结合了联邦学习和元学习的优势。在联邦学习中,多个参与方(如不同的设备或机构)拥有自己的数据,它们在本地训练模型,然后将模型参数上传到中央服务器进行聚合。这样可以避免数据的直接共享,保护数据隐私。而元学习则关注于让模型能够快速适应新的任务。在联邦元学习中,各个参与方在本地使用元学习算法进行模型训练,学习到通用的学习策略。中央服务器收集各个参与方的模型参数,进行聚合和更新,得到一个全局的元学习模型。这个全局模型可以在各个参与方快速适应新的任务。

AI Agent个性化原理

AI Agent个性化是指根据用户的特定需求和偏好,为AI Agent定制不同的行为和决策策略。传统的AI Agent通常是基于通用的模型进行训练,无法满足不同用户的个性化需求。通过引入联邦元学习,可以让AI Agent在保护用户数据隐私的前提下,根据用户的本地数据进行个性化训练。每个用户的AI Agent可以在本地使用联邦元学习算法,学习到适合该用户的个性化模型,从而提供更加个性化的服务。

架构的文本示意图

以下是联邦元学习在AI Agent个性化中的架构示意图:

+-------------------+

| 中央服务器 |

| |

| 全局元学习模型 |

| 模型参数聚合与更新 |

+-------------------+

|

| 模型参数交互

|

+-------------------+-------------------+-------------------+

| 参与方1 | 参与方2 | 参与方3 |

| | | |

| AI Agent 1 | AI Agent 2 | AI Agent 3 |

| 本地数据 | 本地数据 | 本地数据 |

| 本地元学习训练 | 本地元学习训练 | 本地元学习训练 |

+-------------------+-------------------+-------------------+

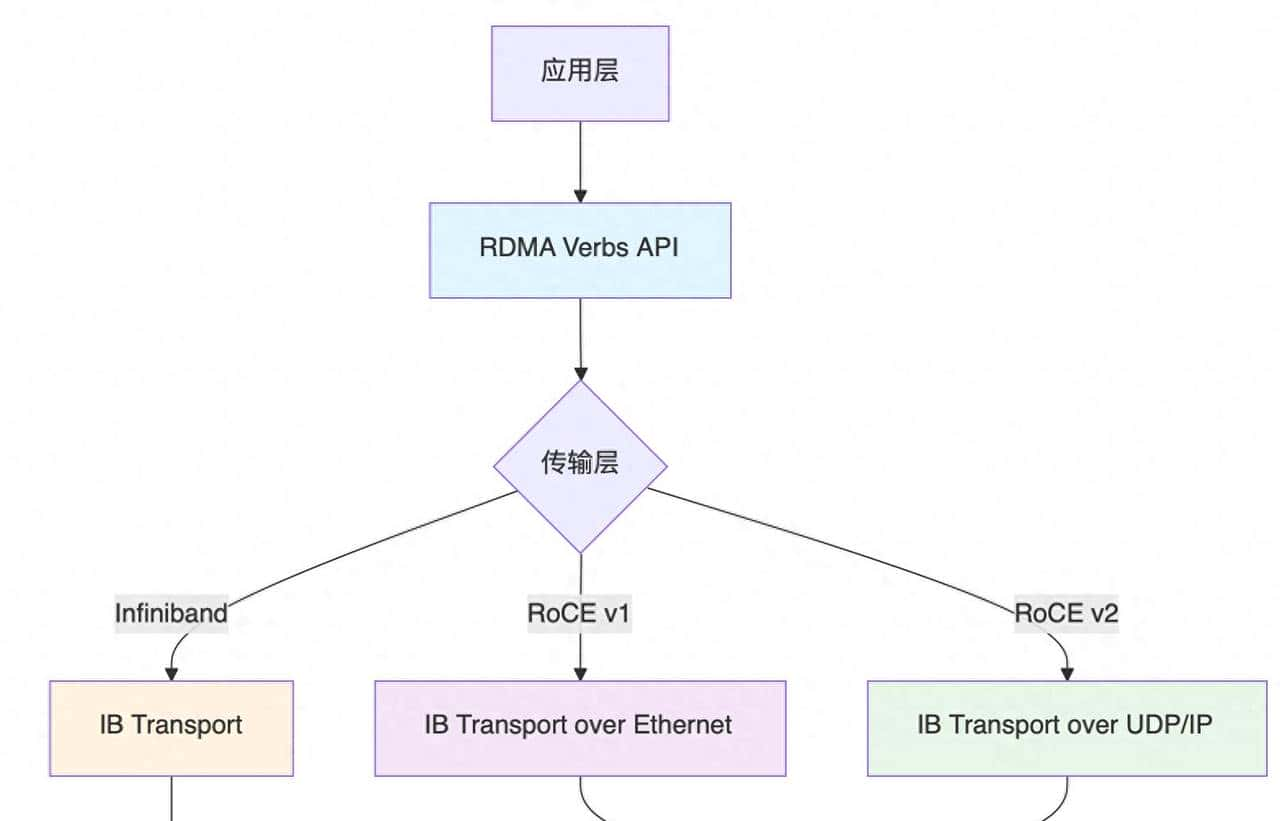

Mermaid流程图

3. 核心算法原理 & 具体操作步骤

核心算法原理

在联邦元学习中,常用的元学习算法是模型无关元学习(MAML)。MAML的核心思想是通过在多个任务上进行训练,找到一个初始模型参数,使得该模型在面对新的任务时,能够通过少量的梯度更新快速适应。

以下是MAML的基本原理:

假设我们有一个模型 fθf_{ heta}fθ,其中 θ hetaθ 是模型的参数。对于一个任务 TTT,我们有训练数据 DtrainTD_{train}^TDtrainT 和测试数据 DtestTD_{test}^TDtestT。MAML的目标是找到一个初始参数 θ∗ heta^*θ∗,使得在使用 DtrainTD_{train}^TDtrainT 进行少量的梯度更新后,模型在 DtestTD_{test}^TDtestT 上的损失最小。

具体来说,对于每个任务 TTT,我们首先使用 DtrainTD_{train}^TDtrainT 对模型进行一次梯度更新:

θT′=θ−α∇θL(fθ,DtrainT) heta_{T}' = heta – alpha

abla_{ heta} L(f_{ heta}, D_{train}^T)θT′=θ−α∇θL(fθ,DtrainT)

其中 αalphaα 是学习率,L(fθ,DtrainT)L(f_{ heta}, D_{train}^T)L(fθ,DtrainT) 是模型在训练数据上的损失函数。

然后,我们计算更新后的模型在测试数据上的损失:

LtestT(θ′)=L(fθT′,DtestT)L_{test}^T( heta') = L(f_{ heta_{T}'}, D_{test}^T)LtestT(θ′)=L(fθT′,DtestT)

MAML的目标是最小化所有任务的测试损失的期望:

minθ∑TLtestT(θ′)min_{ heta} sum_{T} L_{test}^T( heta')minθ∑TLtestT(θ′)

具体操作步骤

步骤1:初始化全局元学习模型

中央服务器初始化一个全局的元学习模型,设置初始参数 θ hetaθ。

步骤2:分发全局模型到各参与方

中央服务器将全局模型的参数 θ hetaθ 分发给各个参与方。

步骤3:各参与方AI Agent本地元学习训练

每个参与方的AI Agent使用本地数据进行元学习训练。具体步骤如下:

从本地数据中采样多个任务 T1,T2,⋯ ,TnT_1, T_2, cdots, T_nT1,T2,⋯,Tn。对于每个任务 TiT_iTi:

使用训练数据 DtrainTiD_{train}^{T_i}DtrainTi 对模型进行一次梯度更新,得到 θTi′ heta_{T_i}'θTi′。计算更新后的模型在测试数据 DtestTiD_{test}^{T_i}DtestTi 上的损失 LtestTi(θTi′)L_{test}^{T_i}( heta_{T_i}')LtestTi(θTi′)。

计算所有任务的测试损失的总和:

Llocal=∑i=1nLtestTi(θTi′)L_{local} = sum_{i=1}^{n} L_{test}^{T_i}( heta_{T_i}')Llocal=∑i=1nLtestTi(θTi′)

使用 LlocalL_{local}Llocal 对本地模型进行梯度更新,得到本地更新后的模型参数 θlocal heta_{local}θlocal。

步骤4:各参与方上传本地模型参数

各参与方将本地更新后的模型参数 θlocal heta_{local}θlocal 上传到中央服务器。

步骤5:中央服务器聚合模型参数

中央服务器收集各个参与方上传的模型参数,使用聚合算法(如联邦平均算法)对这些参数进行聚合,得到更新后的全局模型参数 θnew heta_{new}θnew。

步骤6:更新全局元学习模型

中央服务器使用更新后的全局模型参数 θnew heta_{new}θnew 更新全局元学习模型。

步骤7:重复步骤2 – 步骤6,直到达到训练轮数。

Python代码实现

import torch

import torch.nn as nn

import torch.optim as optim

# 定义一个简单的神经网络模型

class SimpleModel(nn.Module):

def __init__(self):

super(SimpleModel, self).__init__()

self.fc1 = nn.Linear(10, 20)

self.fc2 = nn.Linear(20, 1)

def forward(self, x):

x = torch.relu(self.fc1(x))

x = self.fc2(x)

return x

# 初始化全局模型

global_model = SimpleModel()

global_optimizer = optim.Adam(global_model.parameters(), lr=0.001)

# 模拟参与方数量

num_parties = 3

# 模拟每个参与方的本地数据

local_datasets = [torch.randn(100, 10) for _ in range(num_parties)]

local_labels = [torch.randn(100, 1) for _ in range(num_parties)]

# 训练轮数

num_epochs = 10

for epoch in range(num_epochs):

local_models = []

# 各参与方本地元学习训练

for party in range(num_parties):

local_model = SimpleModel()

local_model.load_state_dict(global_model.state_dict())

local_optimizer = optim.Adam(local_model.parameters(), lr=0.01)

# 模拟元学习训练过程

for _ in range(5):

# 前向传播

outputs = local_model(local_datasets[party])

loss = nn.MSELoss()(outputs, local_labels[party])

# 反向传播和更新

local_optimizer.zero_grad()

loss.backward()

local_optimizer.step()

local_models.append(local_model)

# 中央服务器聚合模型参数

global_params = {}

for name, param in global_model.named_parameters():

global_params[name] = torch.zeros_like(param)

for local_model in local_models:

for name, param in local_model.named_parameters():

global_params[name] += param.data

for name, param in global_model.named_parameters():

param.data = global_params[name] / num_parties

print(f'Epoch {epoch + 1}/{num_epochs} completed.')

4. 数学模型和公式 & 详细讲解 & 举例说明

数学模型和公式

元学习损失函数

在MAML中,我们的目标是最小化所有任务的测试损失的期望。假设我们有 NNN 个任务 T1,T2,⋯ ,TNT_1, T_2, cdots, T_NT1,T2,⋯,TN,对于每个任务 TiT_iTi,我们有训练数据 DtrainTiD_{train}^{T_i}DtrainTi 和测试数据 DtestTiD_{test}^{T_i}DtestTi。

首先,我们对模型参数 θ hetaθ 进行一次梯度更新:

θTi′=θ−α∇θL(fθ,DtrainTi) heta_{T_i}' = heta – alpha

abla_{ heta} L(f_{ heta}, D_{train}^{T_i})θTi′=θ−α∇θL(fθ,DtrainTi)

其中 αalphaα 是学习率,L(fθ,DtrainTi)L(f_{ heta}, D_{train}^{T_i})L(fθ,DtrainTi) 是模型在训练数据上的损失函数。

然后,我们计算更新后的模型在测试数据上的损失:

LtestTi(θ′)=L(fθTi′,DtestTi)L_{test}^{T_i}( heta') = L(f_{ heta_{T_i}'}, D_{test}^{T_i})LtestTi(θ′)=L(fθTi′,DtestTi)

MAML的目标是最小化所有任务的测试损失的总和:

Lmeta=∑i=1NLtestTi(θ′)L_{meta} = sum_{i=1}^{N} L_{test}^{T_i}( heta')Lmeta=∑i=1NLtestTi(θ′)

联邦平均算法

在联邦学习中,常用的聚合算法是联邦平均算法。假设我们有 KKK 个参与方,每个参与方上传的模型参数为 θlocalk heta_{local}^kθlocalk,k=1,2,⋯ ,Kk = 1, 2, cdots, Kk=1,2,⋯,K。联邦平均算法的更新公式为:

θnew=1K∑k=1Kθlocalk heta_{new} = frac{1}{K} sum_{k=1}^{K} heta_{local}^kθnew=K1∑k=1Kθlocalk

详细讲解

元学习损失函数

元学习损失函数的核心思想是找到一个初始模型参数 θ hetaθ,使得模型在面对新的任务时,能够通过少量的梯度更新快速适应。通过在多个任务上进行训练,我们可以学习到一个通用的学习策略,使得模型在不同的任务上都能有较好的表现。

联邦平均算法

联邦平均算法是一种简单而有效的聚合算法,它通过对各个参与方上传的模型参数进行平均,得到一个全局的模型参数。这种算法可以在不共享原始数据的情况下,实现多个参与方之间的协作训练。

举例说明

假设我们有两个任务 T1T_1T1 和 T2T_2T2,模型的初始参数为 θ hetaθ。对于任务 T1T_1T1,训练数据为 DtrainT1D_{train}^{T_1}DtrainT1,测试数据为 DtestT1D_{test}^{T_1}DtestT1;对于任务 T2T_2T2,训练数据为 DtrainT2D_{train}^{T_2}DtrainT2,测试数据为 DtestT2D_{test}^{T_2}DtestT2。

首先,我们对任务 T1T_1T1 进行一次梯度更新:

θT1′=θ−α∇θL(fθ,DtrainT1) heta_{T_1}' = heta – alpha

abla_{ heta} L(f_{ heta}, D_{train}^{T_1})θT1′=θ−α∇θL(fθ,DtrainT1)

然后,计算更新后的模型在测试数据上的损失:

LtestT1(θ′)=L(fθT1′,DtestT1)L_{test}^{T_1}( heta') = L(f_{ heta_{T_1}'}, D_{test}^{T_1})LtestT1(θ′)=L(fθT1′,DtestT1)

同样,对于任务 T2T_2T2:

θT2′=θ−α∇θL(fθ,DtrainT2) heta_{T_2}' = heta – alpha

abla_{ heta} L(f_{ heta}, D_{train}^{T_2})θT2′=θ−α∇θL(fθ,DtrainT2)

LtestT2(θ′)=L(fθT2′,DtestT2)L_{test}^{T_2}( heta') = L(f_{ heta_{T_2}'}, D_{test}^{T_2})LtestT2(θ′)=L(fθT2′,DtestT2)

最后,计算元学习损失:

Lmeta=LtestT1(θ′)+LtestT2(θ′)L_{meta} = L_{test}^{T_1}( heta') + L_{test}^{T_2}( heta')Lmeta=LtestT1(θ′)+LtestT2(θ′)

假设我们有三个参与方,每个参与方上传的模型参数分别为 θlocal1 heta_{local}^1θlocal1,θlocal2 heta_{local}^2θlocal2,θlocal3 heta_{local}^3θlocal3。使用联邦平均算法进行聚合:

θnew=13(θlocal1+θlocal2+θlocal3) heta_{new} = frac{1}{3} ( heta_{local}^1 + heta_{local}^2 + heta_{local}^3)θnew=31(θlocal1+θlocal2+θlocal3)

5. 项目实战:代码实际案例和详细解释说明

5.1 开发环境搭建

安装Python

首先,确保你已经安装了Python 3.6及以上版本。你可以从Python官方网站(https://www.python.org/downloads/)下载并安装Python。

安装深度学习框架

我们使用PyTorch作为深度学习框架。可以使用以下命令安装PyTorch:

pip install torch torchvision

安装其他依赖库

我们还需要安装一些其他的依赖库,如NumPy、Matplotlib等。可以使用以下命令安装:

pip install numpy matplotlib

5.2 源代码详细实现和代码解读

import torch

import torch.nn as nn

import torch.optim as optim

import numpy as np

import matplotlib.pyplot as plt

# 定义一个简单的神经网络模型

class SimpleModel(nn.Module):

def __init__(self):

super(SimpleModel, self).__init__()

self.fc1 = nn.Linear(10, 20)

self.fc2 = nn.Linear(20, 1)

def forward(self, x):

x = torch.relu(self.fc1(x))

x = self.fc2(x)

return x

# 初始化全局模型

global_model = SimpleModel()

global_optimizer = optim.Adam(global_model.parameters(), lr=0.001)

# 模拟参与方数量

num_parties = 3

# 模拟每个参与方的本地数据

local_datasets = [torch.randn(100, 10) for _ in range(num_parties)]

local_labels = [torch.randn(100, 1) for _ in range(num_parties)]

# 训练轮数

num_epochs = 10

# 记录每一轮的损失

losses = []

for epoch in range(num_epochs):

local_models = []

local_losses = []

# 各参与方本地元学习训练

for party in range(num_parties):

local_model = SimpleModel()

local_model.load_state_dict(global_model.state_dict())

local_optimizer = optim.Adam(local_model.parameters(), lr=0.01)

# 模拟元学习训练过程

for _ in range(5):

# 前向传播

outputs = local_model(local_datasets[party])

loss = nn.MSELoss()(outputs, local_labels[party])

# 反向传播和更新

local_optimizer.zero_grad()

loss.backward()

local_optimizer.step()

local_losses.append(loss.item())

local_models.append(local_model)

# 计算本地平均损失

avg_local_loss = np.mean(local_losses)

losses.append(avg_local_loss)

# 中央服务器聚合模型参数

global_params = {}

for name, param in global_model.named_parameters():

global_params[name] = torch.zeros_like(param)

for local_model in local_models:

for name, param in local_model.named_parameters():

global_params[name] += param.data

for name, param in global_model.named_parameters():

param.data = global_params[name] / num_parties

print(f'Epoch {epoch + 1}/{num_epochs}, Average Local Loss: {avg_local_loss}')

# 绘制损失曲线

plt.plot(losses)

plt.xlabel('Epoch')

plt.ylabel('Average Local Loss')

plt.title('Training Loss')

plt.show()

代码解读与分析

模型定义

我们定义了一个简单的神经网络模型

SimpleModel

全局模型初始化

我们初始化了一个全局模型

global_model

global_optimizer

本地数据模拟

我们模拟了三个参与方的本地数据

local_datasets

local_labels

训练过程

在每一轮训练中,每个参与方的AI Agent在本地使用元学习算法进行训练。具体来说,每个参与方使用本地数据对本地模型进行多次梯度更新,然后计算本地损失。

模型参数聚合

中央服务器收集各个参与方上传的本地模型参数,使用联邦平均算法对这些参数进行聚合,得到更新后的全局模型参数。

损失记录和可视化

我们记录每一轮的平均本地损失,并使用Matplotlib绘制损失曲线,以便观察训练过程。

6. 实际应用场景

智能语音助手个性化

智能语音助手如小爱同学、Siri等,不同用户对语音助手的使用习惯和需求各不相同。通过联邦元学习,可以让每个用户的语音助手在本地使用用户的语音数据进行个性化训练,同时保护用户的语音数据隐私。中央服务器可以聚合各个用户的模型参数,得到一个更加通用的元学习模型,使得语音助手能够更好地适应不同用户的需求。

医疗AI Agent个性化

在医疗领域,不同患者的病情和医疗需求也存在差异。医疗AI Agent可以根据患者的本地医疗数据进行个性化训练,例如根据患者的病历、检查报告等数据,为患者提供个性化的医疗建议和诊断。通过联邦元学习,可以在保护患者隐私的前提下,实现多个医疗机构之间的协作训练,提高医疗AI Agent的性能。

金融风控AI Agent个性化

金融机构的不同客户在信用风险、投资偏好等方面存在差异。金融风控AI Agent可以根据客户的本地金融数据进行个性化训练,为不同客户提供个性化的风险评估和投资建议。同时,通过联邦元学习,可以在不共享客户敏感数据的情况下,实现多个金融机构之间的信息共享和协作训练,提高金融风控的准确性和效率。

7. 工具和资源推荐

7.1 学习资源推荐

7.1.1 书籍推荐

《深度学习》(Deep Learning):由Ian Goodfellow、Yoshua Bengio和Aaron Courville所著,是深度学习领域的经典教材,涵盖了深度学习的基本概念、算法和应用。《联邦学习》(Federated Learning):详细介绍了联邦学习的原理、算法和应用场景,对于深入理解联邦元学习有很大的帮助。《元学习:理论与实践》(Meta – Learning: Theory and Practice):专门介绍元学习的相关知识,包括元学习的算法、模型和应用。

7.1.2 在线课程

Coursera上的“深度学习专项课程”(Deep Learning Specialization):由Andrew Ng教授主讲,全面介绍了深度学习的基础知识和应用。edX上的“联邦学习基础”(Foundations of Federated Learning):系统介绍了联邦学习的原理和算法。Udemy上的“元学习实战”(Meta – Learning in Practice):通过实际案例讲解元学习的应用。

7.1.3 技术博客和网站

Medium:有很多关于联邦元学习和AI Agent个性化的技术博客文章,可以关注一些知名的作者和博客。arXiv:是一个预印本平台,上面有很多关于联邦元学习和AI Agent个性化的最新研究成果。OpenAI官方博客:会发布一些关于人工智能最新技术和应用的文章。

7.2 开发工具框架推荐

7.2.1 IDE和编辑器

PyCharm:是一款专门为Python开发设计的集成开发环境,具有强大的代码编辑、调试和项目管理功能。Jupyter Notebook:是一个交互式的开发环境,适合进行数据探索、模型训练和可视化。Visual Studio Code:是一款轻量级的代码编辑器,支持多种编程语言,有丰富的插件可以扩展功能。

7.2.2 调试和性能分析工具

PyTorch Profiler:可以帮助我们分析PyTorch模型的性能,找出性能瓶颈。TensorBoard:是TensorFlow的可视化工具,也可以用于PyTorch模型的可视化和性能分析。NVIDIA Nsight Systems:是一款用于GPU性能分析的工具,可以帮助我们优化GPU代码。

7.2.3 相关框架和库

PySyft:是一个用于隐私保护深度学习的Python库,支持联邦学习和差分隐私等技术。Flower:是一个通用的联邦学习框架,支持多种深度学习框架,如PyTorch、TensorFlow等。Higher:是一个用于元学习的PyTorch库,提供了一些方便的元学习算法实现。

7.3 相关论文著作推荐

7.3.1 经典论文

《Model – Agnostic Meta – Learning for Fast Adaptation of Deep Networks》:提出了模型无关元学习(MAML)算法,是元学习领域的经典论文。《Federated Learning: Strategies for Improving Communication Efficiency》:介绍了联邦学习中提高通信效率的策略。《Deep Learning with Differential Privacy》:探讨了深度学习中的差分隐私技术。

7.3.2 最新研究成果

关注arXiv上关于联邦元学习和AI Agent个性化的最新预印本论文,可以了解到该领域的最新研究动态。参加国际人工智能会议,如NeurIPS、ICML等,会议上会有很多关于联邦元学习和AI Agent个性化的最新研究成果报告。

7.3.3 应用案例分析

一些知名科技公司的技术博客会分享他们在联邦元学习和AI Agent个性化方面的应用案例,如Google、Microsoft等。一些学术期刊和会议论文集也会有相关的应用案例分析,可以从中学习到实际应用中的经验和技巧。

8. 总结:未来发展趋势与挑战

未来发展趋势

多模态数据融合

未来,联邦元学习在AI Agent个性化中的应用将不仅仅局限于单一模态的数据,如文本、图像等,而是会融合多模态数据,如语音、视频、传感器数据等。通过多模态数据的融合,可以为用户提供更加全面和个性化的服务。

与区块链技术结合

区块链技术具有去中心化、不可篡改等特点,可以与联邦元学习相结合,进一步提高数据的安全性和可信度。在联邦元学习中,区块链可以用于记录模型参数的更新历史、参与方的贡献等信息,确保整个训练过程的透明性和公正性。

自适应元学习策略

随着任务的不断变化和用户需求的不断更新,未来的联邦元学习系统将能够自适应地调整元学习策略。例如,根据不同的任务类型和数据分布,自动选择合适的元学习算法和超参数,提高模型的适应能力和性能。

挑战

数据异质性问题

在联邦元学习中,各个参与方的数据往往存在异质性,包括数据分布、数据规模、数据质量等方面的差异。这种数据异质性会影响模型的训练效果和性能,需要研究有效的方法来解决数据异质性问题。

通信效率问题

联邦元学习需要在多个参与方之间进行模型参数的交互,通信开销较大。特别是在大规模的联邦学习场景中,通信效率成为了一个关键问题。需要研究高效的通信协议和压缩算法,减少通信开销。

安全和隐私保护问题

虽然联邦元学习本身具有一定的隐私保护特性,但仍然存在一些安全和隐私风险。例如,模型参数的泄露可能会导致数据的泄露,攻击者可能会通过对模型参数的分析来推断出原始数据的信息。需要进一步加强安全和隐私保护技术的研究,确保用户数据的安全。

9. 附录:常见问题与解答

问题1:联邦元学习和传统的集中式学习有什么区别?

传统的集中式学习需要将所有数据集中到一个服务器进行训练,而联邦元学习允许各个参与方在本地使用自己的数据进行训练,只交换模型参数。这样可以避免数据的直接共享,保护数据隐私。同时,联邦元学习结合了元学习的思想,能够让模型快速适应新的任务。

问题2:联邦元学习在实际应用中如何保证数据的安全性?

联邦元学习通过多种方式保证数据的安全性。首先,各个参与方在本地进行模型训练,不直接共享原始数据。其次,可以使用差分隐私等技术对模型参数进行加密和保护,防止攻击者通过分析模型参数来推断原始数据的信息。此外,还可以使用区块链等技术记录模型参数的更新历史,确保整个训练过程的透明性和公正性。

问题3:元学习算法有哪些?

常见的元学习算法包括模型无关元学习(MAML)、Reptile、Meta – SGD等。MAML是一种模型无关的元学习算法,它通过在多个任务上进行训练,找到一个初始模型参数,使得模型在面对新的任务时能够快速适应。Reptile是一种基于梯度下降的元学习算法,它通过多次迭代更新模型参数来学习通用的学习策略。Meta – SGD是一种基于随机梯度下降的元学习算法,它通过学习每个参数的学习率来提高模型的适应能力。

问题4:如何选择合适的联邦元学习算法和超参数?

选择合适的联邦元学习算法和超参数需要考虑多个因素,如任务类型、数据分布、计算资源等。一般来说,可以通过实验和调优的方法来选择合适的算法和超参数。可以先选择一些常用的算法进行实验,然后根据实验结果调整超参数,如学习率、训练轮数等。同时,也可以参考相关的研究论文和实际应用案例,了解不同算法和超参数在不同场景下的性能表现。

10. 扩展阅读 & 参考资料

扩展阅读

《人工智能:现代方法》(Artificial Intelligence: A Modern Approach):全面介绍了人工智能的基本概念、算法和应用,对于深入理解AI Agent有很大的帮助。《隐私计算:原理与工程实践》:详细介绍了隐私计算的相关技术,包括联邦学习、差分隐私等,对于进一步了解联邦元学习的隐私保护机制有重要的参考价值。《深度学习实战》(Deep Learning in Practice):通过实际案例讲解深度学习的应用,对于将联邦元学习应用到实际项目中有一定的指导作用。

参考资料

《Model – Agnostic Meta – Learning for Fast Adaptation of Deep Networks》,https://arxiv.org/abs/1703.03400《Federated Learning: Strategies for Improving Communication Efficiency》,https://arxiv.org/abs/1610.05492《Deep Learning with Differential Privacy》,https://arxiv.org/abs/1607.00133PyTorch官方文档,https://pytorch.org/docs/stable/index.htmlPySyft官方文档,https://pysyft.readthedocs.io/en/latest/Flower官方文档,https://flower.dev/docs/Higher官方文档,https://higher.readthedocs.io/en/latest/

相关文章

![超详细图解!【MySQL进阶篇】[索引][视图][触发器][函数][存储过程]](https://img.niaorui.com/blogimg/20251016/a064413ead89427db3b7df89d518441f.jpg)