文件上传的安全风险与防护体系

文件上传作为 Web 应用的基础功能,其安全风险具有极强的隐蔽性与破坏性,主要体目前四个维度。恶意脚本上传通过植入 .jsp、.php 等可执行文件,若被部署至 Web 根目录,就可能被远程执行。MIME 类型欺骗攻击者上传的文件实际是脚本文件,但伪装成 .jpg 或 image/png。大文件上传攻击攻击者不断上传超大文件,导致存储空间耗尽或网络带宽被占满。信息泄露风险文件名、路径、元数据中可能包含敏感信息,若未处理,可能被用户直接访问。因此,安全设计是文件上传功能的首要任务。

风险核心特征:文件上传攻击常通过”合法载体+隐蔽 payload”组合实施,如将脚本嵌入图片二进制数据;大文件攻击则利用业务逻辑漏洞(如断点续传未校验总大小),具有低检测率、高破坏力的特点。

针对上述风险,防护体系需构建”多层防御+全生命周期管控”架构:前端实施基础过滤(如文件类型白名单),后端强化内容校验(文件头签名验证、病毒扫描),结合存储隔离(非 Web 目录存储)、访问控制(签名 URL + 时效限制)及异常监控(大文件频率检测),形成从上传到访问的闭环防护,为后续 OSS/MinIO 的安全配置提供理论依据。

Spring Boot文件上传的安全实践

上传大小限制与请求控制

大文件上传攻击可能导致服务器存储资源耗尽、带宽被恶意占用,甚至引发拒绝服务(DoS)风险,严重威胁系统稳定性。Spring Boot通过spring.servlet.multipart配置项提供上传大小限制机制,其中max-file-size控制单个文件大小,max-request-size限制整个请求体大小(含多文件),从源头阻断超大文件攻击。

yaml

spring:

servlet:

multipart:

max-file-size: 50MB # 单个文件最大限制

max-request-size: 100MB # 请求总体大小限制(含多个文件)

配置原则:需根据业务场景动态调整参数值。例如文档管理系统可维持默认50MB/100MB,视频平台需提升至1GB/2GB,而普通图片上传提议设为10MB/20MB。过度限制会影响用户体验,放任则可能引发存储溢出和带宽滥用风险,提议结合业务监控数据定期优化。

文件类型双重校验机制

文件上传场景中,攻击者常通过后缀伪造与MIME欺骗实施攻击。后缀伪造指修改文件名扩展名(如将恶意脚本文件伪装为.jpg),而MIME欺骗则通过篡改HTTP请求头中的Content-Type字段(如伪造为image/png),两者均可绕过简单的前端校验机制。单一防御手段存在明显缺陷:仅校验后缀无法识别内容篡改,仅依赖请求头MIME类型则易受客户端欺骗,因此需构建双重校验防御体系。

双重校验机制要求同时验证文件后缀与内容真实类型:第一通过白名单限制允许的文件扩展名(如.jpg、.png、.pdf),再通过文件内容分析获取真实MIME类型。Java中可使用Files.probeContentType方法(依赖文件系统)或Apache Tika库(更准确的流处理能力)实现内容类型检测。以下为完整实现示例:

java

private static final List<String> ALLOWED_EXTENSIONS = List.of("jpg", "png", "pdf");

private static final List<String> ALLOWED_MIME_TYPES = List.of("image/jpeg", "image/png", "application/pdf");

public void validateFile(MultipartFile file) throws IOException {

// 1. 后缀校验:提取文件名后缀并验证白名单

String extension = FilenameUtils.getExtension(file.getOriginalFilename()).toLowerCase();

if (!ALLOWED_EXTENSIONS.contains(extension)) {

throw new IllegalArgumentException("非法文件后缀: " + extension);

}

// 2. 内容MIME类型校验:通过文件内容识别真实类型

String mimeType;

try (InputStream is = file.getInputStream()) {

mimeType = new Tika().detect(is); // Tika替代方案比Files.probeContentType更可靠

// mimeType = Files.probeContentType(Paths.get(file.getOriginalFilename()));

}

if (!ALLOWED_MIME_TYPES.contains(mimeType)) {

throw new IllegalArgumentException("非法文件类型: " + mimeType);

}

}

关键说明: Apache Tika库通过分析文件头部字节特征识别类型,支持1000+种文件格式,可有效避免Files.probeContentType因依赖本地文件系统导致的识别偏差。生产环境提议优先使用Tika,并定期更新其类型定义库以覆盖新型文件格式。

存储路径隔离与文件名处理

原始文件名直接用于存储存在双重风险:一是可能泄露用户敏感信息(如个人标识、文件内容关联信息),二是同名文件上传时易发生覆盖冲突。为此需构建 UUID+日期目录 的双重防护机制,同时严格遵循文件存储路径与 Web 根目录隔离的安全原则。

核心防护逻辑:通过 UUID 生成全局唯一文件名,彻底消除冲突风险;按日期(如 LocalDate.now())构建层级目录结构,避免单目录文件数量过载导致的存储性能下降。

具体实现代码如下:

String fileName = UUID.randomUUID() + "." + FilenameUtils.getExtension(file.getOriginalFilename());

String filePath = "/upload/" + LocalDate.now() + "/" + fileName;该方案中,文件最终存储于 /upload/2025-08-26/ 等非 Web 可直接访问的路径下,需通过应用层鉴权后间接提供访问,形成完整的安全防护闭环。

受控访问与权限控制

文件存储地址直接暴露会引发严重的未授权访问风险,攻击者可通过路径遍历或猜测获取敏感文件。受控访问设计需采用ID映射机制隔离物理存储路径,通过业务接口实现间接访问。核心实现如以下控制器示例,通过文件ID而非真实路径进行资源定位,并利用Content-Disposition头控制浏览器行为,既保障下载安全性,又隐藏底层存储结构:

@GetMapping("/file/{id}")

public ResponseEntity downloadFile(@PathVariable String id) {

File file = fileService.getFile(id); // 通过ID查询文件元数据

return ResponseEntity.ok()

.header(HttpHeaders.CONTENT_DISPOSITION, "attachment; filename=" + file.getName()) // 指定下载文件名

.body(new FileSystemResource(file)); // 返回文件资源

}权限集成层面需结合Spring Security + JWT构建完整防护体系:在接口层通过@PreAuthorize注解或拦截器验证用户身份,确保只有通过认证的合法用户才能触发文件访问流程;在服务层进一步校验用户对目标文件的操作权限(如所有者校验、角色权限匹配)。这种”接口隔离+身份认证+权限校验”三层架构可有效阻断未授权访问渠道

大文件上传的性能优化挑战

大文件上传面临多维度技术瓶颈,其本质可从网络传输、服务器处理与用户体验三方面解析。在网络传输层面,TCP慢启动机制导致初始传输速率受限,大文件单次上传易因传输时长超出服务器超时阈值而中断;服务器处理维度,单一节点的并发连接数与带宽资源有限,难以支撑多用户同时上传大文件,易引发系统响应延迟甚至宕机;用户体验角度,传统整体上传模式下,网络波动或中断后需重新传输完整文件,极大降低操作效率。这些技术瓶颈共同指向分片上传的必要性——通过将文件拆分为小块独立传输,可突破TCP慢启动限制、均衡服务器负载并实现断点续传,为后续OSS、MinIO、Nginx等解决方案提供核心优化路径。

核心技术瓶颈总结:

网络层:TCP慢启动导致传输效率低,长时连接易触发超时机制 服务层:单节点并发连接限制与资源耗尽风险 应用层:缺乏断点续传机制导致用户操作成本高

OSS云存储解决方案

直传方案的技术原理与实现

传统文件上传采用服务端中转模式时,文件需先传输至应用服务器再转发至存储服务,会占用大量服务器带宽并增加响应延迟,尤其在大文件场景下易引发性能瓶颈。直传架构通过客户端与对象存储服务(如阿里云 OSS)的直接交互,将文件传输路径从“客户端→应用服务器→存储服务”简化为“客户端→存储服务”,应用服务器仅负责生成临时上传凭证,显著降低带宽消耗并提升上传效率。

实现流程包括三个核心步骤:1. 客户端向后端请求上传凭证;2. 后端通过存储服务 SDK 生成包含临时访问权限的签名信息(如 accessId、policy、signature);3. 客户端使用该凭证直接将文件上传至存储服务。关键在于通过 STS 临时授权机制控制凭证时效性。

安全要点需严格设置凭证过期时间(提议15-30分钟)并通过policy字段限制上传路径、文件类型参数,确保仅授权客户端执行预设操作。

签名接口实现示例(Spring Boot):

java

@GetMapping("/oss/policy")

public Map<String, String> getPolicy() {

Map<String, String> respMap = new HashMap<>();

respMap.put("accessId", accessId); // 临时访问ID

respMap.put("policy", policy); // 权限策略

respMap.put("signature", signature); // HMAC加密签名值

return respMap;

}

分片上传的断点续传实现

大文件单次上传存在显著的超时风险,尤其当文件体积超过 100MB 时,易受网络波动、连接中断等因素影响,导致传输失败后需重新上传整个文件,极大降低传输效率。分片上传通过分治思想解决这一问题,将大文件逻辑切分为多个独立的二进制块(Chunk),实现并行传输与故障隔离。以阿里云 OSS 为例,其分片上传流程包含三个核心步骤:第一由后端生成唯一标识 uploadId 以追踪分片集合;前端将文件切分为固定大小的 Chunk(一般为 1MB-10MB)后并发上传,每个分片携带 uploadId 与分片序号;所有分片上传完成后,通过调用 CompleteMultipartUpload 接口触发分片合并,OSS 服务端根据分片序号重组为完整文件。

此机制天然支持断点续传功能 —— 通过 uploadId 可查询已上传分片状态,网络中断后仅需重传未完成分片,无需从头开始,显著提升大文件传输可靠性。

适用场景方面,直传模式适用于 100MB以下小文件传输,具有流程简单、无额外合并开销的优势;而分片上传则为大文件传输提供必需的容错能力与效率保障,尤其适合网络环境不稳定的场景。分片合并作为技术核心,其原子性与顺序性保障直接决定了最终文件的完整性与可用性。

MinIO自建对象存储方案

MinIO部署与环境配置

自建 MinIO 可显著降低对象存储成本,通过本地化部署实现存储资源自主管控,避免云服务厂商的流量费用叠加,尤其适合中小规模项目的大容量文件存储场景。

使用 Docker 快速部署 MinIO 的核心命令如下:

docker run -p 9000:9000 -p 9090:9090

-e "MINIO_ROOT_USER=admin"

-e "MINIO_ROOT_PASSWORD=admin123"

minio/minio server /data --console-address ":9090"命令参数解析需重点关注端口与权限配置:9000 端口为对象存储 API 端口,供应用程序通过 SDK 或 HTTP API 访问数据;9090 端口为 Web 控制台端口,提供图形化管理界面,两者功能独立不可混淆。环境变量 MINIO_ROOT_USER 和 MINIO_ROOT_PASSWORD 分别定义管理员账号与密码,server /data 指定数据持久化目录,–console-address “:9090” 强制控制台绑定固定端口,避免动态端口分配导致的访问问题。

部署验证步骤分为控制台与 API 两层:通过浏览器访问 http://服务器IP:9090,使用 admin/admin123 登录控制台,检查存储桶创建、用户管理等功能是否正常;通过 curl http://服务器IP:9000/minio/health/live 命令测试 API 端口连通性,返回 OK 即表明服务部署成功。

Spring Boot集成MinIO实现上传

Spring Boot集成MinIO实现文件上传需遵循“依赖配置-客户端初始化-上传实现”三步流程。第一在项目中引入MinIO SDK依赖,推荐使用8.5.3版本以确保API稳定性与兼容性:

xml

<dependency>

<groupId>io.minio</groupId>

<artifactId>minio</artifactId>

<version>8.5.3</version>

</dependency>

客户端初始化需配置核心参数,包括MinIO服务端点(endpoint)、访问密钥(accessKey)、密钥(secretKey),通过Spring IoC容器注入MinioClient实例以实现全局复用。上传实现可通过putObject方法完成,关键步骤包括生成唯一文件名(避免冲突)、指定存储桶与对象路径、设置文件流与内容类型:

核心上传代码示例:

java

@Autowired

private MinioClient minioClient;

public void uploadFile(MultipartFile file) throws Exception {

// 生成带UUID的唯一文件名

String fileName = UUID.randomUUID() + "-" + file.getOriginalFilename();

// 执行上传操作

minioClient.putObject(

PutObjectArgs.builder()

.bucket("mybucket") // 目标存储桶名称

.object(fileName) // 存储对象名称

.stream(file.getInputStream(), file.getSize(), -1) // 文件流与大小(-1表明自动检测)

.contentType(file.getContentType()) // 内容类型

.build()

);

}

与传统服务端中转上传不同,MinIO支持通过Presigned URL实现前端直传方案。该方案由服务端生成临时授权URL(含过期时间),前端直接将文件上传至MinIO服务,可显著减少服务端带宽占用与中转压力。两种方案需根据业务场景选择:小文件上传可采用服务端中转简化流程,大文件或高并发场景提议使用Presigned URL直传优化性能。

Nginx分片上传方案

分片上传的前端实现逻辑

大文件不分片传输存在显著风险,单次请求负载过大会导致传输中断、超时或内存溢出等问题。分片上传通过将文件拆分为小片段解决该问题,核心在于切片算法与并发控制。

切片核心步骤:

1. 定义分片大小(如5MB);

2. 计算分片总数(Math.ceil(file.size / chunkSize));

3. 循环生成分片:file.slice(index * chunkSize, Math.min((index + 1) * chunkSize, file.size)),通过Blob.slice API截取二进制片段,确保分片无重叠且覆盖完整文件内容。

并发上传需控制请求数量(如限制5个并发),通过Promise.all或并发池管理多个分片上传请求,避免浏览器同时发起过多连接导致性能下降。分片经多个请求上传至Nginx后,由服务器缓存至磁盘,为后续后端合并操作提供数据基础。

后端分片合并与I/O优化

分片上传的合并阶段是I/O性能的关键瓶颈点,其核心矛盾在于频繁的磁盘操作:每个分片需单独写入临时存储,合并时又需按序号逐一读取并追加至目标文件,此过程涉及大量文件打开/关闭操作和磁盘寻道,在机械硬盘环境下会导致显著的性能损耗。

I/O优化核心:Java NIO提供的Files.copy方法通过操作系统底层的零拷贝技术,直接将分片数据从临时文件传输至目标输出流,避免了传统IO模式中用户态与内核态之间的缓冲区复制,可减少约30%的I/O操作耗时。

典型实现如:

java

public void mergeChunks(String fileName, int totalChunks, String targetPath) throws IOException {

try (FileOutputStream out = new FileOutputStream(targetPath, true)) {

for (int i = 0; i < totalChunks; i++) {

Path chunk = Paths.get("/tmp/chunks/" + fileName + "." + i);

Files.copy(chunk, out); // 零拷贝传输分片数据

Files.delete(chunk); // 即时清理临时文件

}

}

}

临时目录规划需遵循三大原则:

使用系统临时目录(如/tmp/chunks)避免权限冲突,采用“文件名.分片索引”命名规则确保分片唯一性,合并后即时删除临时文件防止磁盘空间溢出。从算法复杂度看,顺序合并策略的时间复杂度为O(n)(n为分片数量),虽为线性增长,但实现简单且稳定性高;多线程并行合并虽理论上可提升效率,但受限于磁盘I/O的物理并发瓶颈,实际优化效果有限,因此顺序合并仍是生产环境的首选方案。

三种方案的技术对比与场景适配

文件上传方案の选型需结合技术特性与业务场景综合决策,以下从多维度对比OSS(对象存储服务)、MinIO(自建对象存储)与Nginx分片上传方案,并提供场景化适配提议。

核心维度对比

从可用性、成本与复杂度三个关键维度分析:

- 可用性: OSS依托云厂商基础设施实现99.99%+服务可用性,支持自动容灾与断点续传;MinIO需自建集群保障高可用,单节点部署存在单点风险;Nginx分片依赖应用服务器稳定性,文件合并阶段易受I/O波动影响。

- 成本结构: OSS采用按量付费模式,存储+流量成本随规模线性增长;MinIO硬件成本可控,但需分摊服务器运维人力投入;Nginx方案硬件依赖少,但大文件合并会产生额外CPU/内存开销。

- 技术复杂度: OSS提供SDK直接集成,开发复杂度低且免运维;MinIO需配置集群、监控与备份策略,技术门槛较高;Nginx分片需自定义分片逻辑与合并机制,断点续传实现复杂。

场景化适配策略

结合用户规模与部署环境的适配逻辑如下:

- 公有云生产环境/大规模用户: 优先选择OSS,其弹性扩展能力可支撑百万级并发上传,免运维特性降低团队负担。典型场景如电商平台商品图片存储、在线教育视频上传。

- 企业内网/私有部署: MinIO为最优解,兼容S3 API便于迁移,且数据存储在企业自有服务器,满足合规要求。适用于金融机构文档管理、制造业设计图纸存储等场景。

- 中小项目/资源受限环境: Nginx分片上传可作为过渡方案,通过拆分大文件(如1GB视频)为5MB分片降低传输失败率,但需注意控制并发合并任务数量避免I/O瓶颈。

决策关键原则:技术选型需平衡”即时需求-长期成本-团队能力”三角关系。例如初创团队初期可采用Nginx分片验证业务模型,用户规模突破10万后迁移至OSS;传统企业内网场景则应优先部署MinIO,通过硬件投入换取数据控制权。

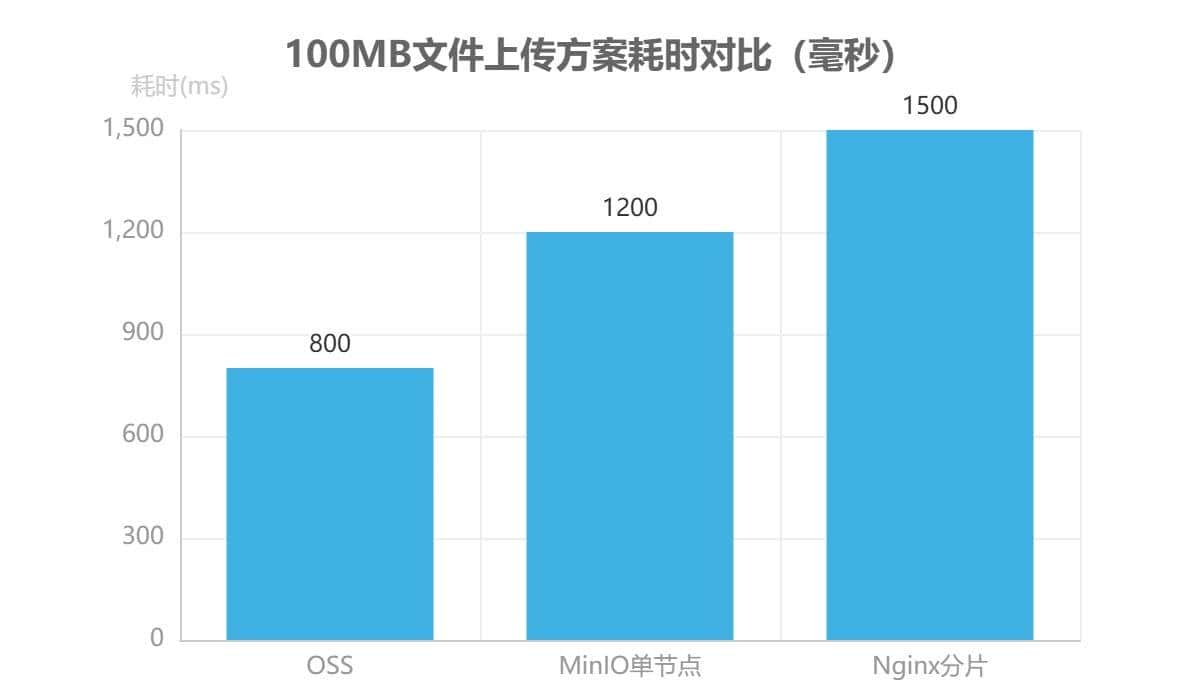

三种方案不存在绝对优劣,实际选型需通过压力测试验证性能指标(如OSS的100MB文件上传平均耗时约800ms,MinIO单节点约1.2s,Nginx分片约1.5s),并结合5年TCO(总拥有成本)模型综合评估。

企业级文件上传的最佳实践总结

企业级文件上传需构建”安全-性能-可扩展”三位一体的技术框架,通过系统性技术组合实现全链路优化。在安全实践层面,核心技术组合包括文件大小限制、文件类型校验、存储路径隔离与受控下载机制,同时需结合JWT或Spring Security实现细粒度权限控制,防止未授权访问与任意文件下载。

性能优化的关键实施路径在于采用分片上传处理大文件,避免单次请求超时风险;架构层面推荐采用OSS/MinIO等对象存储的前端直传模式,直接将文件从客户端传输至存储服务,显著降低应用服务器的带宽压力。

结合业务需求的架构演进策略需差异化设计:视频平台等大文件场景需优先部署分片上传+云存储直传方案,平衡传输效率与成本;企业OA系统则需强化安全校验环节,在文件上传前执行严格的类型检测与权限预验证,确保敏感文档的访问可控。通过安全机制与性能方案的动态适配,可构建兼具防护能力与扩展弹性的文件管理体系。

核心实践要点

安全层:大小限制+类型校验+路径隔离+JWT权限三重防护 性能层: 分片上传(大文件)+ 前端直传(云存储)双重优化 业务适配:按文件特性(大小/敏感度)选择技术组合

感谢关注【AI码力】,获取更多Java秘籍!

很不错 都是干货

收藏了,感谢分享