一、模型版本推荐

1. 16GB 内存

- 推荐模型:DeepSeek-R1 7B 或 8B 版本

- 7B 模型占用约 4.7GB 存储,适合轻量级任务(如日常聊天、基础代码生成),在 16GB 内存的 M4 芯片上运行流畅。

- 8B 版本基于 Llama3.1 训练,支持复杂推理和代码生成,但对内存需求略高,需关闭其他占用内存的应用程序。

2. 24GB 内存

- 推荐模型:DeepSeek-R1 14B 版本

- 14B 模型占用约 9GB 存储,适用于中等复杂度任务(如代码推理、多轮对话),在 24GB 内存下可平衡性能与负载。

- 需注意:长时间运行可能导致内存压力较高,提议配合外置硬盘存储模型文件以释放内存。

3. 32GB 内存

- 推荐模型:DeepSeek-R1 32B 或尝试 70B 量化版

- 32B 模型占用约 20GB 存储,适合复杂逻辑推理和文本分析,在 32GB 内存的 Mac Mini 上可稳定运行。

- 70B 量化版(如 Q4 或 Q8)通过降低精度减少内存占用,但推理速度会略有下降,需确保 macOS 系统版本为最新以优化兼容性。

二、部署步骤

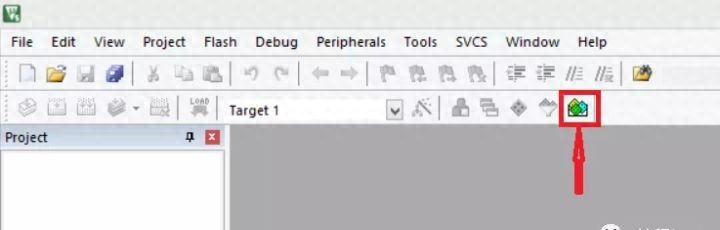

1. 安装 Ollama 框架

- 下载安装包:访问 Ollama 官网,选择 macOS 版本下载并安装。

- 验证安装:打开终端,输入 ollama –version,若显示版本号则安装成功。

2. 下载并运行模型

- 选择模型:根据内存配置选择对应模型(如 7B、14B 或 32B)。

- 执行下载命令:

# 以 7B 模型为例

ollama run deepseek-r1:7b- 下载完成后,终端可直接与模型交互。

- 自定义模型存储路径(可选):

- 若需将模型存储到外置硬盘,创建符号链接:

ln -s /Volumes/外置硬盘路径/ollama_models ~/.ollama/models3. 配置可视化界面(Open WebUI)

- 安装 Docker:从 Docker 官网 下载 macOS 版本并安装。

- 启动 Open WebUI:在终端运行以下命令:

docker run -d -p 3000:8080

--add-host=host.docker.internal:host-gateway

-v open-webui:/app/backend/data

--name open-webui

--restart always

ghcr.io/open-webui/open-webui:main- 访问 http://localhost:3000 即可使用网页界面与模型交互。

4. 优化与调试

- 性能监控:通过 活动监视器 查看内存和 CPU 占用,必要时关闭后台应用。

- 模型切换:使用 ollama list 查看已安装模型,ollama run <模型名> 切换不同版本。

- 插件扩展:安装 ComfyUI 或 GGUF 插件以支持更多功能(如 AI 绘画)。

三、注意事项

- 硬件限制:70B 及以上模型需至少 512GB 统一内存(如 Mac Studio 顶配),Mac Mini 仅提议尝试量化版。

- 网络要求:下载模型需稳定网络,部分资源需科学上网。

- 离线使用:本地部署后无需联网,但生成能力可能弱于云端版本,提议优先使用官方网页版处理高复杂度任务。

四、效果对比

|

内存配置 |

推荐模型 |

适用场景 |

生成速度 |

资源占用 |

|

16GB |

7B/8B |

日常对话、代码生成 |

快 |

低 |

|

24GB |

14B |

多轮推理、文本分析 |

中等 |

中 |

|

32GB |

32B/70B |

复杂逻辑、专业任务 |

慢 |

高 |

通过上述步骤,大家可根据自身需求灵活部署 DeepSeek 大模型了。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...