最近跟几个做数据中心的朋友聊天,发现一个有趣的现象:大家都在说RoCE多么革命性,多么颠覆传统,好像这玩意儿是从石头缝里蹦出来的。但实际上呢?RoCE本质上就是把Infiniband的核心技术套了层以太网的壳子,然后重新包装卖给你。

咱们今天就来扒一扒这两个技术的真实关系。

先说说Infiniband的那些事儿

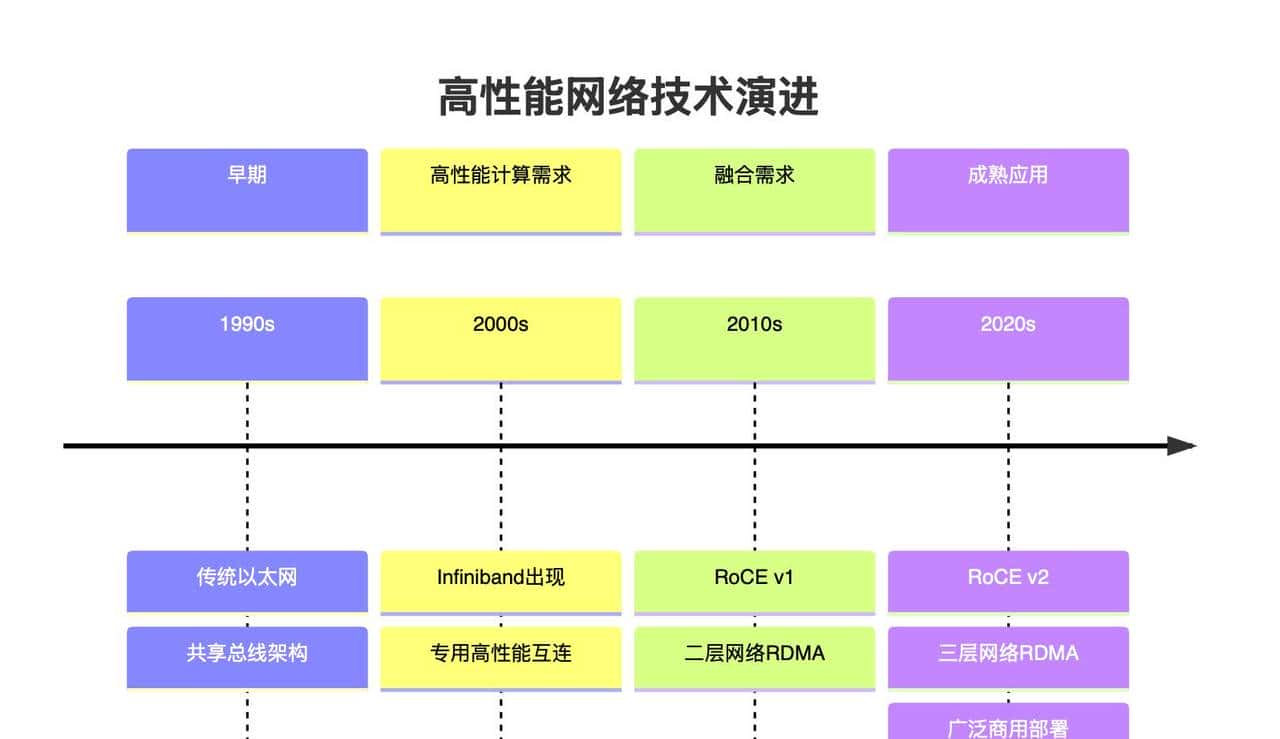

Infiniband这个东西,说起来也有二十多年历史了。当年Intel、IBM、Microsoft这些巨头联合搞出来的,目标很明确:就是要干掉传统的总线结构,搞一个高速的点对点互连网络。

Infiniband最核心的几个特点:

- 基于消息传递的通信模型:不是传统的共享内存,而是通过消息队列来通信

- 用户空间直接访问硬件:绕过内核,减少延迟

- 可靠传输协议:保证数据完整性和顺序

- RDMA(远程直接内存访问):这是重点,可以直接操作远程内存

说白了,Infiniband就是为了解决传统网络在高性能计算场景下的痛点:延迟高、CPU占用率高、带宽利用率低。

RoCE:换汤不换药的艺术

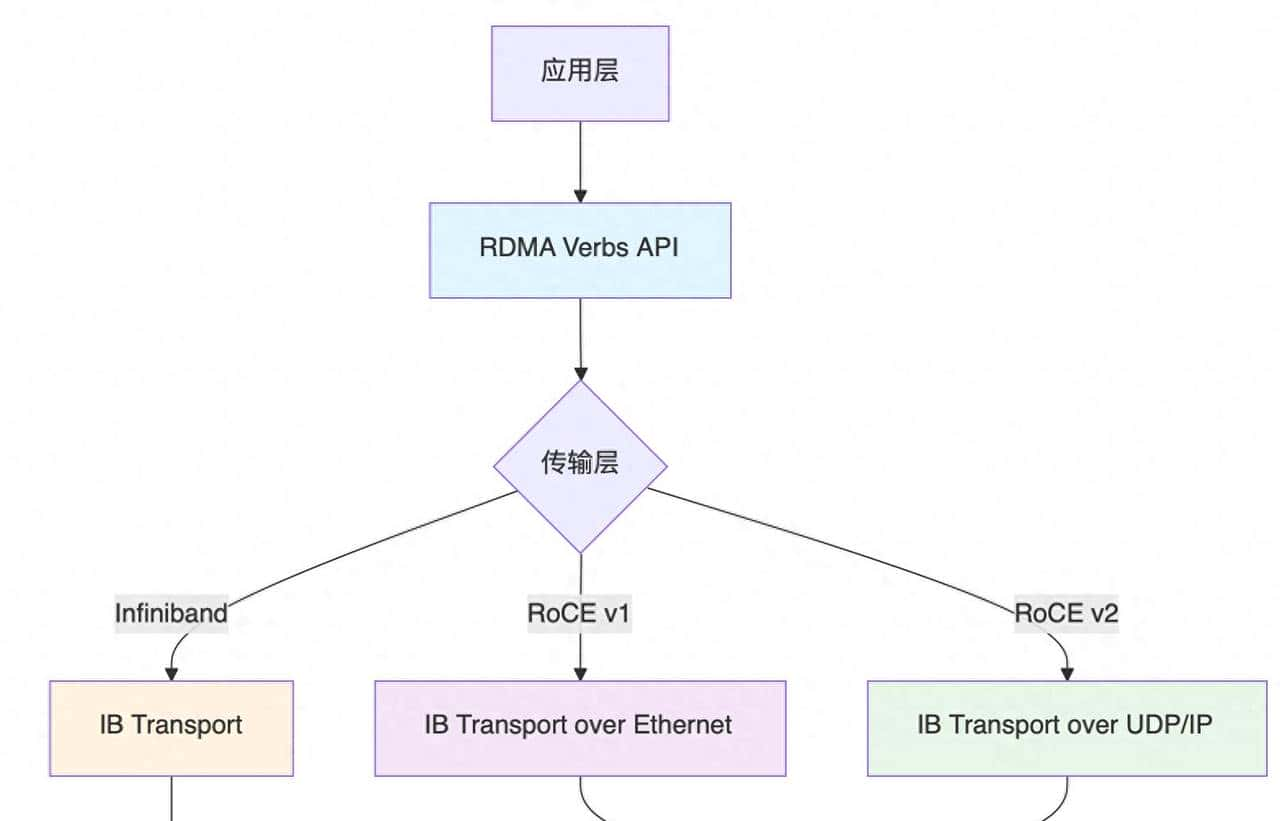

目前我们来看看RoCE(RDMA over Converged Ethernet)。这名字起得就很有意思,”基于融合以太网的RDMA”。

RoCE有两个版本:

- RoCE v1:只能在同一个二层网络里跑,基本上就是把Infiniband的数据包直接封装到以太网帧里

- RoCE v2:可以跨三层网络,在IP层上跑

你看出门道了吗?RoCE v1几乎就是Infiniband的翻版,只是把物理层换成了以太网。RoCE v2稍微进步一点,但核心的RDMA语义、消息传递模型、用户空间访问这些,跟Infiniband一模一样。

为什么说RoCE是Infiniband的变种?

1. 协议栈几乎一致

最明显的证据就是协议栈。RoCE使用的是完全一样的RDMA Verbs API,这意味着:

- 应用程序可以无缝迁移

- 编程模型完全一样

- 内存管理机制一样

- 队列对(Queue Pair)概念一样

如果你会写Infiniband程序,那RoCE程序你闭着眼睛也能写。

2. 核心技术理念一样

两者都是基于:

- 消息传递而不是共享内存

- 用户空间直接访问,绕过内核

- 零拷贝技术,减少数据移动

- 硬件卸载,把网络处理交给专门的硬件

这些核心理念,RoCE完全继承自Infiniband。

3. 性能特征类似

在同等硬件条件下,RoCE和Infiniband的性能表现几乎一致:

- 延迟都在微秒级别

- 带宽利用率都很高

- CPU占用率都很低

4. 厂商套路如出一辙

最有意思的是,推RoCE的厂商跟当年推Infiniband的基本是同一批人。Mellanox(目前的Nvidia)、Intel、Broadcom,这些公司在两个技术上用的营销话术都差不多。

那为什么要搞RoCE?

既然RoCE本质上就是Infiniband的变种,为什么还要搞这个东西?

1. 成本思考

Infiniband的专用交换机贵得要命,一个36端口的交换机能卖到几万美元。而以太网交换机便宜多了,生态也成熟。

2. 运维简化

数据中心本来就有以太网基础设施,IT运维人员也熟悉。如果能在现有网络上跑高性能计算,那管理成本就降低了。

3. 标准化压力

以太网是IEEE标准,Infiniband是IBTA标准。在企业采购中,标准化的以太网明显更有优势。

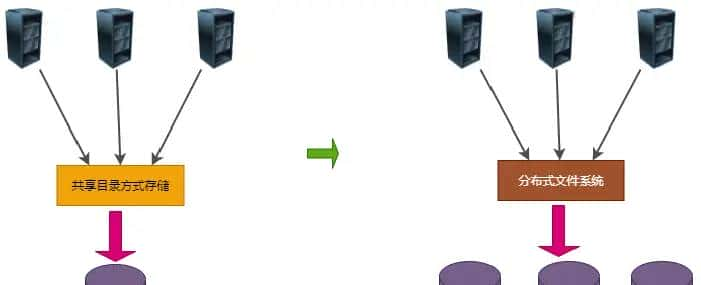

4. 融合的需求

现代数据中心需要承载各种业务:存储、计算、管理流量。RoCE可以在同一张网络上跑这些业务,而Infiniband一般需要专门的网络。

技术演进的必然性

从技术发展角度看,RoCE的出现实则是必然的:

整个演进过程实则就是在平衡性能、成本、管理复杂度这三个因素。

实际应用中的选择提议

那么在实际项目中,该怎么选择呢?

选择Infiniband的场景:

- 纯粹的高性能计算:列如科学计算、AI训练集群

- 对延迟极度敏感:列如高频交易

- 预算充足:不差钱的话,Infiniband的生态更成熟

- 专用网络:可以接受单独建设高性能网络

选择RoCE的场景:

- 需要网络融合:存储、计算、管理流量跑在一张网上

- 成本敏感:想要高性能但预算有限

- 运维简化:希望减少网络管理复杂度

- 渐进式升级:从传统以太网逐步升级

简单地说:Infinibnd是“性能标杆”,而RoCE是“性价比标杆”。

一个实际的例子

我们之前给一家互联网公司做AI训练集群的网络方案。最开始他们倾向于Infiniband,由于性能的确 好。但算了一下成本,光网络设备就要多花几百万,而且还要专门培训运维人员。

最后选择了RoCE v2方案,在现有数据中心网络基础上升级。虽然理论性能稍微低一点,但实际应用中差别不大,而且整体TCO降低了30%。

别被营销忽悠了

目前许多厂商把RoCE包装得好像是全新的革命性技术,但实际上:

- 核心技术不新:RDMA、用户空间访问、硬件卸载,这些Infiniband二十年前就有了

- 性能提升有限:在同等硬件条件下,RoCE和Infiniband性能相当

- 生态成熟度:Infiniband的生态反而更成熟,工具链更完善

RoCE的真正价值在于:在可接受的性能损失范围内,大幅降低了高性能网络的部署成本和管理复杂度。

文末废话

随着数据中心规模越来越大,业务越来越复杂,网络融合是大势所趋。RoCE作为Infiniband技术在以太网上的实现,的确 有其存在价值。

但我们也要清醒地认识到:

- RoCE不是银弹,它有自己的适用场景

- 在某些场景下,传统Infiniband依旧是更好的选择

- 技术选型要基于实际需求,不要被营销话术迷惑

最后想说的是,技术没有绝对的好坏,只有适不适合。RoCE也好,Infiniband也好,都是为了解决特定的问题。关键是要理解这些技术的本质,然后基于实际需求做出明智的选择。

别再被那些”革命性”、”颠覆性”的营销词汇忽悠了。RoCE就是Infiniband的变种,认清这一点,反而更容易做出正确的技术决策。

#ai# #头条创作挑战赛# #算力# #人工智能# #无损网络# #roce# #IB# #Infiniband# #RDMA# rdma#

相关文章