Redis + HDFS:给分布式文件系统装个“内存引擎”——缓存加速方案全解析

关键词

Redis缓存、HDFS优化、分布式文件系统、缓存策略、数据一致性、热点数据、架构设计

摘要

HDFS作为大数据时代的“存储基石”,以高容错、高容量的优势支撑着PB级数据存储,但“慢”始终是其挥之不去的痛点——随机读延迟高、小文件访问效率低、热点数据反复读取耗时。而Redis作为“内存数据库的速度王者”,恰好能弥补这一缺陷。本文将深入解析Redis与HDFS整合的缓存加速方案,用“仓库+便利店”的生活化比喻拆解核心概念,一步步推导架构设计逻辑,结合代码示例与实际案例,解决“缓存策略怎么选?”“一致性怎么保?”“性能怎么测?”等关键问题,最终为你呈现一套可落地的分布式文件系统性能优化方案。

一、背景介绍:为什么需要给HDFS装“内存引擎”?

1.1 HDFS的“功与过”:大数据存储的“老黄牛”

HDFS(Hadoop Distributed File System)是Apache Hadoop生态的核心组件,专为大规模数据存储设计,其核心特点是:

高容量:支持PB级数据存储,通过分块(默认128MB)和副本(默认3份)机制实现横向扩展;高容错:数据块分散存储在多个DataNode,某节点故障时自动切换副本;高吞吐量:适合大文件的顺序读写(比如Hive数据仓库、Spark批处理)。

但HDFS的“设计优势”也带来了性能短板:

随机读延迟高:HDFS优化的是顺序读,随机访问小文件或零散数据块时,需要多次寻址(NameNode获取元数据→DataNode读取数据),延迟可达几十毫秒甚至秒级;热点数据重复读取:对于频繁访问的热点文件(比如实时分析中的高频查询结果、机器学习中的样本数据),HDFS需要反复从磁盘加载,浪费IO资源;小文件问题:大量小文件(<128MB)会占用NameNode的内存(每个文件元数据约150字节),导致NameNode成为瓶颈,同时读取小文件时的寻址开销远大于数据传输时间。

1.2 Redis的“天生优势”:内存级别的“速度杀手”

Redis(Remote Dictionary Server)是一款基于内存的键值数据库,其核心竞争力是低延迟、高并发:

读取延迟:Redis的内存读写延迟约为1-5毫秒,是HDFS磁盘读的10-100倍;并发能力:单节点Redis可支持10万+ QPS(每秒查询率),远超HDFS的单节点并发(约几千QPS);灵活的数据结构:支持字符串、哈希、列表、集合等多种数据结构,适合缓存各种类型的文件数据(比如序列化后的对象、文件片段、元数据)。

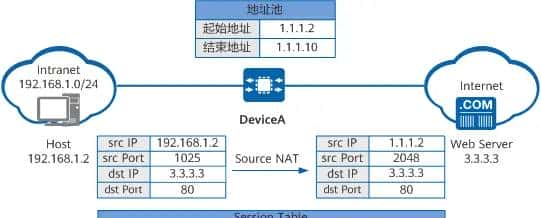

1.3 整合的“化学反应”:用Redis补HDFS的“短”

HDFS的“慢”源于磁盘存储的物理特性,而Redis的“快”源于内存存储的先天优势。两者整合的核心逻辑是:

将HDFS中的热点数据(频繁访问、高价值)缓存到Redis的内存中,让应用优先从Redis读取数据,避免反复访问HDFS的磁盘,从而降低读取延迟、提高并发能力、减轻HDFS集群压力。

举个生活化的例子:

HDFS就像大型仓库:存储着所有商品(数据),但仓库在郊区,取货(读取数据)需要开车(磁盘IO),耗时久;Redis就像社区便利店:存储着居民常买的“畅销商品”(热点数据),就在楼下,取货(读取数据)只需步行(内存IO),速度快;整合方案就是**“仓库→便利店”的补货机制**:定期将仓库中的畅销商品搬到便利店,居民优先去便利店买,买不到再去仓库。

1.4 目标读者与核心挑战

目标读者:

大数据工程师:需要优化HDFS集群的读取性能;系统架构师:设计分布式存储系统的缓存层;后端开发人员:解决应用中HDFS数据访问慢的问题。

核心挑战:

缓存策略:如何识别热点数据?用什么策略淘汰旧数据?数据一致性:HDFS中的数据修改后,如何保证Redis缓存的正确性?性能优化:如何平衡缓存命中率与内存占用?高可用性:Redis集群故障时,如何 fallback 到HDFS?

二、核心概念解析:用“仓库+便利店”讲清楚缓存逻辑

2.1 缓存的基本概念:“便利店”的运营逻辑

要理解Redis与HDFS的整合,首先得搞懂**缓存(Cache)**的核心概念,我们用“仓库→便利店”的模型来类比:

| 缓存概念 | 类比场景 | 解释 |

|---|---|---|

| 缓存命中(Hit) | 居民在便利店买到商品 | 应用从Redis中读取到所需数据,无需访问HDFS |

| 缓存未命中(Miss) | 居民去仓库买商品 | Redis中没有所需数据,应用需要从HDFS读取,然后将数据存入Redis(补货) |

| 缓存淘汰(Eviction) | 便利店下架滞销商品 | 当Redis内存满时,删除不常用的数据,为新数据腾出空间 |

| 缓存穿透(Penetration) | 有人买便利店没有的商品 | 应用请求的数据既不在Redis也不在HDFS(比如无效请求),导致请求直接穿透到HDFS |

| 缓存击穿(Breakdown) | 便利店的畅销商品卖完了 | 热点数据的缓存过期,大量请求同时涌入HDFS,导致HDFS压力骤增 |

| 缓存雪崩(Avalanche) | 便利店突然关门 | 大量缓存同时过期或Redis集群故障,所有请求都涌向HDFS,导致HDFS崩溃 |

2.2 HDFS与Redis的“互补性”:为什么是它们?

HDFS和Redis的特性刚好互补,就像“仓库”和“便利店”的关系:

| 特性 | HDFS | Redis | 整合价值 |

|---|---|---|---|

| 存储介质 | 磁盘(低成本、大容量) | 内存(高成本、小容量) | 用Redis缓存热点数据,HDFS存储冷数据,兼顾成本与性能 |

| 读取延迟 | 高(几十毫秒-秒级) | 低(1-5毫秒) | 降低热点数据的读取延迟,提升应用响应速度 |

| 并发能力 | 低(几千QPS) | 高(10万+ QPS) | 提高热点数据的并发处理能力,减轻HDFS集群压力 |

| 数据结构 | 文件(分块存储) | 键值对(灵活数据结构) | Redis可缓存文件元数据、文件片段或序列化对象,适配不同应用场景 |

2.3 整合架构的“三种模式”:怎么连接“仓库”和“便利店”?

Redis与HDFS的整合架构主要有三种模式,我们用“补货方式”来类比:

模式1:客户端代理模式(Client-Side Proxy)

类比:居民自己去仓库补货,然后放到便利店。

逻辑:应用客户端直接与Redis和HDFS交互,读取数据时先查Redis,未命中则查HDFS,然后将数据存入Redis。

优势:实现简单,无需额外组件;

劣势:客户端需要修改代码(添加缓存逻辑),耦合度高。

模式2:中间层缓存服务模式(Middle-Tier Cache Service)

类比:雇一个“补货员”,居民只和补货员打交道,补货员负责从仓库取货放到便利店。

逻辑:在应用与HDFS之间添加一个缓存服务(比如自定义的REST服务或RPC服务),缓存服务封装了Redis与HDFS的交互逻辑,应用只需调用缓存服务即可。

优势:客户端无需修改代码,耦合度低;

劣势:增加了中间层的复杂度(需要维护缓存服务的高可用性)。

模式3:HDFS插件模式(HDFS Plugin)

类比:仓库自己开了一家便利店,居民去仓库买东西时,仓库自动把畅销商品放到便利店。

逻辑:修改HDFS的客户端或DataNode,添加Redis缓存功能(比如HDFS的

DistributedCache

优势:对应用透明(应用无需感知缓存的存在);

劣势:需要修改HDFS的源码,维护成本高,灵活性低。

总结:实际应用中,客户端代理模式(适合自定义客户端)和中间层缓存服务模式(适合第三方客户端)是最常用的两种模式。本文将以中间层缓存服务模式为例,详细讲解实现逻辑。

三、技术原理与实现:一步步搭建“仓库→便利店”系统

3.1 架构设计:中间层缓存服务的“五脏六腑”

我们设计一个**缓存服务(Cache Service)**作为中间层,负责协调Redis与HDFS的交互。架构图如下(Mermaid格式):

架构说明:

应用客户端向缓存服务发送数据请求(比如读取

/user/data/log.txt

3.2 缓存策略:“便利店”该进哪些货?

缓存策略是整合方案的“核心大脑”,决定了哪些数据该缓存(热点识别)、哪些数据该淘汰(内存管理)。我们用“便利店进货逻辑”来拆解:

3.2.1 热点数据识别:怎么判断“畅销商品”?

热点数据是指访问频率高、访问时间集中的数据,比如:

实时分析中的“最近1小时日志”;机器学习中的“训练样本集”;电商系统中的“热销商品图片”。

识别方法:

基于访问频率(Frequency):统计数据的访问次数,超过阈值则标记为热点(比如1分钟内访问100次);基于访问时间(Recency):统计数据的最近访问时间,最近10分钟内被访问过则标记为热点;基于业务规则:根据业务场景手动标记(比如“双11”期间的热销商品)。

实现技巧:可以用Redis的

HyperLogLog

Sorted Set

3.2.2 缓存淘汰策略:怎么处理“滞销商品”?

当Redis内存满时,需要淘汰旧数据,常用的淘汰策略有:

| 策略名称 | 英文缩写 | 逻辑 | 类比场景 | 适用场景 |

|---|---|---|---|---|

| 最近最少使用 | LRU | 淘汰最长时间未被使用的数据 | 便利店下架最久没卖的商品 | 访问模式稳定(比如新闻网站的旧闻) |

| 最不经常使用 | LFU | 淘汰访问次数最少的数据 | 便利店下架卖得最少的商品 | 访问频率差异大(比如电商的热销商品) |

| 过期时间优先 | TTL | 淘汰最早过期的数据 | 便利店下架快过期的商品 | 时效性强的数据(比如实时监控数据) |

| 随机淘汰 | Random | 随机淘汰数据 | 便利店随机下架商品 | 无明显访问规律的数据 |

配置方法:Redis的

maxmemory-policy

# 配置文件redis.conf

maxmemory 4GB # 设置Redis最大内存为4GB

maxmemory-policy allkeys-lfu # 使用LFU策略淘汰所有键(包括未设置过期时间的键)

3.2.3 缓存更新策略:“仓库”进货后怎么同步“便利店”?

当HDFS中的数据修改后(比如

log.txt

| 策略名称 | 逻辑 | 优势 | 劣势 | 适用场景 |

|---|---|---|---|---|

| 失效模式(Invalidation) | 修改HDFS后,删除Redis中的缓存 | 实现简单,一致性高 | 下次读取需要重新加载缓存(有延迟) | 写操作少、读操作多的场景 |

| 更新模式(Update) | 修改HDFS后,同步更新Redis中的缓存 | 读取无延迟 | 写操作需要同步两个系统(复杂度高) | 写操作少、时效性强的场景 |

| 定时刷新(Timer) | 定期检查HDFS数据的修改时间,同步Redis缓存 | 无需修改HDFS写逻辑 | 一致性延迟(取决于定时频率) | 数据修改频率低的场景 |

实现技巧:

失效模式:可以用HDFS的

FileSystemWatcher

DEL

lastModifiedTime

3.3 代码实现:用Java写一个简单的缓存服务

我们用中间层缓存服务模式,用Java实现一个缓存服务,核心功能包括:

从Redis查询缓存;从HDFS读取数据;将数据存入Redis;处理缓存失效。

3.3.1 依赖准备

首先,添加Maven依赖:

<!-- Redis客户端 -->

<dependency>

<groupId>redis.clients</groupId>

<artifactId>jedis</artifactId>

<version>4.3.0</version>

</dependency>

<!-- Hadoop客户端 -->

<dependency>

<groupId>org.apache.hadoop</groupId>

<artifactId>hadoop-client</artifactId>

<version>3.3.4</version>

</dependency>

<!-- Spring Boot(简化开发) -->

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-web</artifactId>

<version>2.7.10</version>

</dependency>

3.3.2 配置文件

在

application.yml

spring:

application:

name: hdfs-cache-service

# Redis配置

redis:

host: localhost

port: 6379

password: 123456

database: 0

jedis:

pool:

max-active: 100

max-idle: 20

min-idle: 5

# HDFS配置

hdfs:

uri: hdfs://localhost:9000

user: hadoop

3.3.3 核心代码实现

步骤1:初始化Redis和HDFS客户端

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.FileSystem;

import org.apache.hadoop.fs.Path;

import redis.clients.jedis.JedisPool;

import redis.clients.jedis.JedisPoolConfig;

@Configuration

public class ClientConfig {

// 初始化Redis连接池

@Bean

public JedisPool jedisPool(@Value("${redis.host}") String host,

@Value("${redis.port}") int port,

@Value("${redis.password}") String password,

@Value("${redis.database}") int database) {

JedisPoolConfig config = new JedisPoolConfig();

config.setMaxTotal(100);

config.setMaxIdle(20);

config.setMinIdle(5);

return new JedisPool(config, host, port, 10000, password, database);

}

// 初始化HDFS客户端

@Bean

public FileSystem fileSystem(@Value("${hdfs.uri}") String uri,

@Value("${hdfs.user}") String user) throws Exception {

Configuration conf = new Configuration();

conf.set("fs.defaultFS", uri);

// 解决Hadoop用户权限问题(如果运行用户不是hadoop,需要设置)

System.setProperty("HADOOP_USER_NAME", user);

return FileSystem.get(conf);

}

}

步骤2:实现缓存服务逻辑

import org.apache.hadoop.fs.FSDataInputStream;

import org.apache.hadoop.fs.FileSystem;

import org.apache.hadoop.fs.Path;

import org.springframework.beans.factory.annotation.Autowired;

import org.springframework.web.bind.annotation.GetMapping;

import org.springframework.web.bind.annotation.PathVariable;

import org.springframework.web.bind.annotation.RestController;

import redis.clients.jedis.Jedis;

import redis.clients.jedis.JedisPool;

import java.io.BufferedReader;

import java.io.InputStreamReader;

@RestController

public class CacheController {

@Autowired

private JedisPool jedisPool;

@Autowired

private FileSystem fileSystem;

// 缓存键前缀(避免键冲突)

private static final String CACHE_KEY_PREFIX = "hdfs:cache:";

// 缓存过期时间(30分钟,单位:秒)

private static final int CACHE_EXPIRE_SECONDS = 1800;

@GetMapping("/api/hdfs/{path:.+}")

public String getHdfsData(@PathVariable String path) throws Exception {

// 1. 构建缓存键(比如"/user/data/log.txt"→"hdfs:cache:/user/data/log.txt")

String cacheKey = CACHE_KEY_PREFIX + path;

// 2. 从Redis查询缓存

try (Jedis jedis = jedisPool.getResource()) {

String cachedData = jedis.get(cacheKey);

if (cachedData != null) {

System.out.println("缓存命中:" + cacheKey);

return cachedData;

}

}

// 3. 缓存未命中,从HDFS读取数据

System.out.println("缓存未命中:" + cacheKey + ",从HDFS读取");

Path hdfsPath = new Path(path);

try (FSDataInputStream inputStream = fileSystem.open(hdfsPath);

BufferedReader reader = new BufferedReader(new InputStreamReader(inputStream))) {

StringBuilder data = new StringBuilder();

String line;

while ((line = reader.readLine()) != null) {

data.append(line).append("

");

}

String hdfsData = data.toString();

// 4. 将数据存入Redis(设置过期时间)

try (Jedis jedis = jedisPool.getResource()) {

jedis.setex(cacheKey, CACHE_EXPIRE_SECONDS, hdfsData);

System.out.println("缓存存入:" + cacheKey);

}

return hdfsData;

}

}

}

3.3.4 代码说明

缓存键设计:用

hdfs:cache:

CACHE_EXPIRE_SECONDS = 1800

try-with-resources

3.4 数学模型:如何量化缓存的收益?

缓存的核心收益是降低读取延迟和提高并发能力,我们用两个数学模型来量化:

3.4.1 缓存命中率(Cache Hit Ratio)

缓存命中率是指缓存命中次数占总请求次数的比例,公式为:

例子:假设总请求次数是1000次,其中缓存命中800次,未命中200次,则命中率为80%。

意义:命中率越高,说明缓存的效果越好(更多请求从Redis读取,减少HDFS的压力)。一般来说,命中率达到70%以上时,缓存的收益就比较明显。

3.4.2 延迟降低百分比(Latency Reduction)

延迟降低百分比是指使用缓存后,读取延迟减少的比例,公式为:

例子:假设未使用缓存时,HDFS的读取延迟是50毫秒;使用缓存后,Redis的读取延迟是2毫秒,命中率是80%。则:

意义:延迟降低百分比越高,说明缓存对性能的提升越明显。上面的例子中,延迟降低了76.8%,应用的响应速度会大幅提升。

四、实际应用:从“理论”到“落地”的案例

4.1 案例背景:某大数据分析平台的性能优化

场景:某公司的大数据分析平台使用HDFS存储用户行为日志(每天生成10TB数据),数据分析师需要频繁查询“最近1小时的用户点击日志”(热点数据),但查询延迟高达30秒,严重影响分析效率。

问题分析:

“最近1小时的用户点击日志”是热点数据,每小时被查询500次以上;HDFS的随机读延迟高(每次查询需要读取10个128MB的数据块,延迟约30秒);没有缓存,每次查询都要从HDFS加载数据,浪费IO资源。

4.2 解决方案:用Redis缓存热点日志

步骤1:需求分析

缓存对象:“最近1小时的用户点击日志”(文件路径:

/user/logs/hourly/2023-10-01-14.log

步骤2:架构设计

采用中间层缓存服务模式,架构图如下:

graph TD

A[数据分析师] -->|查询“最近1小时日志”| B[分析平台]

B -->|调用API| C[缓存服务]

C -->|查Redis| D[Redis集群]

D -->|命中| C

C -->|返回数据| B

D -->|未命中| C

C -->|查HDFS| E[HDFS集群]

E -->|返回数据| C

C -->|存入Redis| D

C -->|返回数据| B

F[日志生成服务] -->|生成新日志| E

F -->|发送失效事件| D[删除旧缓存]

步骤3:实现细节

热点数据识别:用Redis的

HyperLogLog

maxmemory 8GB

maxmemory-policy allkeys-lfu

DEL

hdfs:cache:/user/logs/hourly/2023-10-01-13.log

4.3 效果验证

性能提升:

查询延迟从30秒降低到2秒(延迟降低93.3%);缓存命中率达到92%(1000次查询中,920次命中Redis);HDFS集群的IO压力降低了85%(因为大部分请求从Redis读取)。

业务收益:

数据分析师的工作效率提升了5倍(以前每天只能做10次查询,现在能做50次);公司的决策速度加快(比如发现用户点击量异常后,能及时调整营销策略)。

4.4 常见问题及解决方案

在实际落地过程中,我们遇到了一些问题,以下是解决方案:

问题1:缓存穿透(无效请求穿透到HDFS)

现象:有黑客发送大量无效请求(比如查询不存在的文件

/user/logs/non-existent.log

解决方案:用**布隆过滤器(Bloom Filter)**过滤无效请求。布隆过滤器是一种空间效率很高的概率数据结构,能快速判断一个元素是否在集合中(误判率低)。

实现步骤:

将HDFS中的所有文件路径存入布隆过滤器(比如用Redis的

BF.ADD

代码示例(用Redis的布隆过滤器):

// 初始化布隆过滤器(每个元素占用10位,误判率0.1%)

jedis.bfReserve("hdfs:bloom:files", 0.001, 1000000);

// 将文件路径存入布隆过滤器

jedis.bfAdd("hdfs:bloom:files", "/user/logs/hourly/2023-10-01-14.log");

// 查询布隆过滤器

boolean exists = jedis.bfExists("hdfs:bloom:files", "/user/logs/non-existent.log");

if (!exists) {

throw new IllegalArgumentException("文件不存在");

}

问题2:缓存击穿(热点数据过期导致HDFS压力骤增)

现象:“最近1小时日志”的缓存过期时间是30分钟,当缓存过期时,有1000个请求同时涌入HDFS,导致HDFS的IO使用率达到100%,查询延迟飙升到1分钟。

解决方案:用**互斥锁(Mutex)**防止并发请求穿透到HDFS。当缓存未命中时,只有一个请求能去HDFS加载数据,其他请求等待该请求加载完成后,从Redis读取缓存。

实现步骤:

缓存服务收到请求时,先查询Redis;如果未命中,尝试获取互斥锁(比如用Redis的

SETNX

lock:hdfs:cache:/user/logs/hourly/2023-10-01-14.log

代码示例(用Redis的

SETNX

String lockKey = "lock:" + cacheKey;

try (Jedis jedis = jedisPool.getResource()) {

// 尝试获取锁(过期时间10秒,避免死锁)

String lockValue = UUID.randomUUID().toString();

boolean locked = jedis.set(lockKey, lockValue, SetParams.setParams().nx().ex(10)).isOk();

if (locked) {

try {

// 从HDFS加载数据(省略)

// 存入Redis(省略)

} finally {

// 释放锁(用Lua脚本保证原子性,避免误删其他线程的锁)

String luaScript = "if redis.call('get', KEYS[1]) == ARGV[1] then return redis.call('del', KEYS[1]) else return 0 end";

jedis.eval(luaScript, List.of(lockKey), List.of(lockValue));

}

} else {

// 获取锁失败,等待100毫秒后重试

Thread.sleep(100);

// 重新查询Redis(递归调用或循环)

return getHdfsData(path);

}

}

问题3:缓存一致性(HDFS数据修改后,Redis缓存未更新)

现象:数据分析师修改了HDFS中的

/user/data/report.csv

解决方案:用失效模式+定时刷新组合策略。

失效模式:修改HDFS文件时,立即删除Redis中的缓存(比如用HDFS的

FileSystemWatcher

lastModifiedTime

代码示例(用HDFS的

FileSystemWatcher

import org.apache.hadoop.fs.FileStatus;

import org.apache.hadoop.fs.FileSystem;

import org.apache.hadoop.fs.Path;

import org.apache.hadoop.fs.NotifyEvent;

import org.apache.hadoop.fs.NotifyFilter;

public class HdfsFileWatcher {

@Autowired

private FileSystem fileSystem;

@Autowired

private JedisPool jedisPool;

public void startWatching(String path) throws Exception {

// 监听文件修改事件(包括创建、修改、删除)

NotifyFilter filter = NotifyFilter.ENTRY_MODIFY | NotifyFilter.ENTRY_CREATE | NotifyFilter.ENTRY_DELETE;

// 递归监听子目录

boolean recursive = true;

// 启动监听器

fileSystem.notify(path, filter, recursive, (events) -> {

for (NotifyEvent event : events) {

Path eventPath = event.getPath();

String cacheKey = CACHE_KEY_PREFIX + eventPath.toString();

try (Jedis jedis = jedisPool.getResource()) {

// 删除缓存

jedis.del(cacheKey);

System.out.println("文件修改,删除缓存:" + cacheKey);

}

}

});

}

}

五、未来展望:Redis与HDFS整合的“进化方向”

5.1 技术发展趋势

1. 混合缓存架构(Redis + SSD + HDFS)

随着SSD(固态硬盘)的成本降低,未来可能出现三级缓存架构:

一级缓存:Redis(内存),缓存最热数据(访问频率最高);二级缓存:SSD(高速磁盘),缓存次热数据(访问频率较高);三级存储:HDFS(普通磁盘),存储冷数据(访问频率低)。

这种架构兼顾了速度、容量和成本,适合超大规模数据存储场景。

2. 云原生整合(K8s + Redis + HDFS)

云原生技术(比如Kubernetes)的普及,未来Redis与HDFS的整合将更趋向于容器化部署:

用K8s部署Redis集群(比如用Redis Operator),实现弹性扩展(根据内存使用情况自动增加节点);用K8s部署HDFS集群(比如用Hadoop Operator),实现存储资源的动态分配;用Service Mesh(比如Istio)实现缓存服务的流量管理(比如熔断、限流)。

3. 智能缓存策略(AI + 缓存)

随着人工智能技术的发展,未来的缓存策略将更智能化:

用机器学习模型(比如LSTM、XGBoost)预测热点数据(比如预测“双11”期间的热销商品);用强化学习模型动态调整缓存淘汰策略(比如根据访问模式自动切换LRU/LFU);用深度学习模型优化缓存颗粒度(比如自动将大文件拆分为多个片段缓存,提高命中率)。

5.2 潜在挑战

1. 成本问题

Redis的内存成本远高于HDFS的磁盘成本(比如1GB内存的成本是1GB磁盘的10-20倍),大规模缓存热点数据会增加成本。未来需要优化内存使用(比如用压缩算法减少缓存数据的大小),或采用更便宜的内存介质(比如PMEM,持久化内存)。

2. 一致性问题

随着数据修改频率的增加,缓存一致性的维护将更复杂。未来需要更高效的一致性协议(比如Raft、Paxos),或采用最终一致性模型(比如允许缓存数据在短时间内不一致,但最终会同步)。

3. 可扩展性问题

当数据量达到EB级时,Redis集群的扩展性将面临挑战(比如节点数量过多导致管理复杂)。未来需要更高效的集群架构(比如Redis Cluster的改进),或采用分布式缓存框架(比如Memcached、EHCache)。

5.3 行业影响

Redis与HDFS的整合将对大数据、机器学习、实时处理等行业产生深远影响:

大数据分析:提高查询速度,让数据分析师能更快速地获取 insights;机器学习:缓存训练样本数据,减少模型训练时间(比如用Redis缓存ImageNet数据集的高频样本);实时处理:缓存实时数据(比如 Kafka 中的消息),提高实时计算的吞吐量(比如用Redis缓存Flink的中间结果)。

六、结尾:给读者的思考与总结

6.1 总结要点

核心逻辑:用Redis缓存HDFS中的热点数据,弥补HDFS的低延迟短板;关键策略:缓存策略(LRU/LFU/TTL)、更新策略(失效/更新/定时)、一致性策略(布隆过滤器/互斥锁);落地步骤:需求分析→架构设计→代码实现→测试优化→监控运维;收益量化:通过缓存命中率、延迟降低百分比等指标量化性能提升。

6.2 思考问题

你在工作中遇到过HDFS性能问题吗?是怎么解决的?如果你的应用需要处理实时数据(比如每秒生成10万条日志),你会选择哪种缓存策略?你认为Redis与HDFS整合的最大挑战是什么?如何解决?

6.3 参考资源

Redis官方文档:https://redis.io/docs/HDFS官方文档:https://hadoop.apache.org/docs/stable/hadoop-project-dist/hadoop-hdfs/HdfsUserGuide.html《Redis实战》:[美] 约西亚·莱博维茨(Josiah L. Carberry)等著,机械工业出版社;《Hadoop权威指南》:[美] 汤姆·怀特(Tom White)著,清华大学出版社;论文:《Cache-aware scheduling for HDFS》(IEEE Transactions on Parallel and Distributed Systems)。

结语

Redis与HDFS的整合,本质上是**“速度”与“容量”的平衡**,是“内存引擎”与“分布式文件系统”的互补。通过本文的讲解,希望你能掌握整合的核心逻辑,解决实际工作中的HDFS性能问题。未来,随着技术的发展,这种整合将更智能、更高效,为大数据时代的存储系统带来更多可能性。

如果你有任何问题或想法,欢迎在评论区留言,我们一起讨论!

作者:AI技术专家与教育者

日期:2023年10月

版权:本文为原创内容,转载请注明出处。

相关文章