无需代码基础,3种方案任选,5分钟让大模型为你所用!本文手把手教你打通Dify的“模型网关”,无论是云端API还是本地私有模型,从此无缝调用。

一、配置前必知:Dify的模型网关设计

Dify通过统一接口层屏蔽底层模型差异,无论接入何种模型,上层应用无需修改:

测试开发全景图:人工智能测试、智能驱动、自动化、测试开发、左移右移与DevOps的持续交付 – 测试开发 – 爱测-测试人社区

二、方案1:接入OpenAI(云端API)

适合场景:快速验证 · 需要GPT-4等高级模型

操作步骤:

- 获取API Key

登录 OpenAI平台 → 点击「Create new secret key」 - Dify控制台配置

路径:设置 → 模型供应商 → OpenAI → 填写:

- 模型类型:OpenAI

- API Key:sk-xxx(粘贴刚才复制的密钥)

- 模型名称:gpt-4-turbo(按需选择)- 测试连通性

点击「测试」 → 看到绿色 ✅ 即成功

三、方案2:接入Anthropic Claude(云端API)

适合场景:处理超长文本(200K上下文)

关键步骤:

- 申请Claude访问权限

登录 Anthropic控制台 → 创建Key - Dify特殊配置

模型类型:Anthropic

API Key:sk-ant-xxx

模型:claude-3-haiku-20240307(性价比首选)

# 必填高级参数:

Custom Model Name:claude-3-haiku(自定义名称)四、方案3:接入Ollama本地模型(私有部署)

适合场景:数据敏感 · 零成本调用开源模型

操作流程:

步骤1:部署Ollama服务

# 在Dify同一服务器安装Ollama

curl -fsSL https://ollama.com/install.sh | sh

# 下载中文优化版Qwen1.5(4B量化版)

ollama pull qwen:4b-chat步骤2:修改Dify的docker-compose.yaml

# 添加Ollama服务

services:

ollama:

image:ollama/ollama

ports:

-"11434:11434"

volumes:

-ollama:/root/.ollama

# 确保dify-ai与ollama同网络

networks:

default:

name:dify-network步骤3:重启服务并配置

docker-compose down && docker-compose up -d控制台配置:

模型类型:OpenAI(兼容协议)

API Base:http://ollama:11434/v1 # 关键!容器内通信

模型名称:qwen:4b-chat # 与Ollama拉取名称一致

API Key:留空五、避坑指南:高频问题解决方案

❌ 错误1:Error: Incorrect API key provided

- 检查点:

- OpenAI/Claude密钥是否过期

- Claude需在高级参数填写Custom Model Name

❌ 错误2:Connection refused to http://ollama:11434

- 排查步骤:

- 执行 docker network inspect dify-network 查看容器互通状态

- 在dify-ai容器内测试:

docker exec -it dify-ai curl http://ollama:11434

# 应返回 {"status":"success"} ❌ 错误3:模型列表为空

- 解决方案:

在「模型供应商」页面 → 点击「同步模型」按钮

六、模型性能实测对比(RTX 3060 12GB)

|

模型 |

响应速度 |

显存占用 |

中文能力 |

成本 |

|

gpt-4-turbo |

1.2s |

0 |

⭐⭐⭐⭐⭐ |

$0.01/次 |

|

claude-3-haiku |

0.8s |

0 |

⭐⭐⭐⭐ |

$0.001/次 |

|

qwen:4b-chat |

2.5s |

4.2GB |

⭐⭐⭐⭐ |

0(本地) |

提示:日常测试推荐Haiku,生产环境用本地Qwen更安全

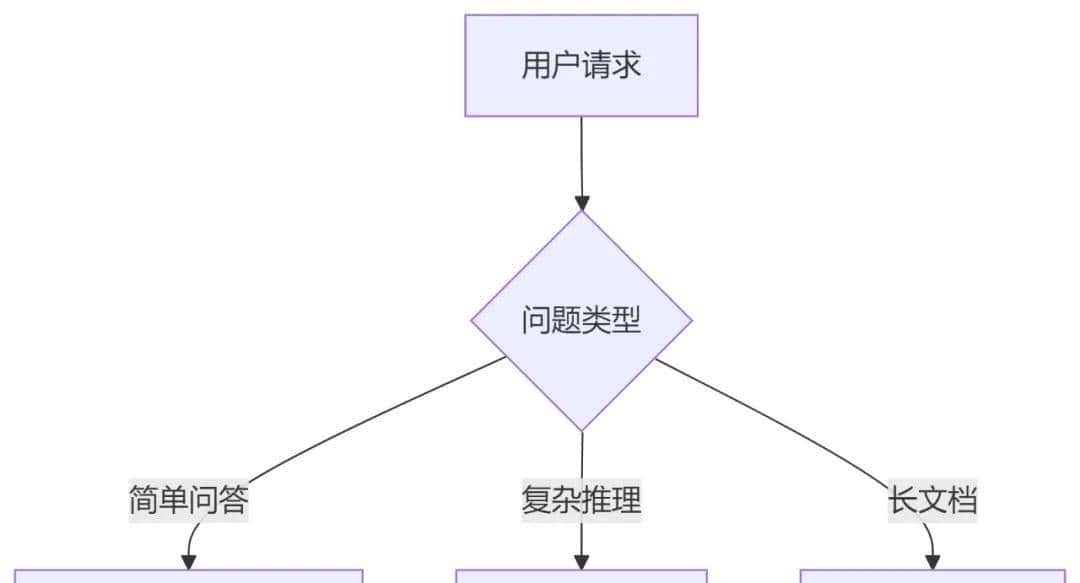

七、进阶技巧:自由切换多模型

场景:根据请求自动选择最优模型

配置方法:

- 工作流中添加「路由节点」

- 设置条件规则:

if "总结" in input_text:

use_model = "claude-3-haiku"

elif "代码" in input_text:

use_model = "gpt-4-turbo"

else:

use_model = "qwen:4b-chat"结语:从此告别模型绑定

通过Dify的模型网关,你可以:

✅ 随时切换:GPT/Claude/本地模型一键替换

✅ 动态路由:根据场景智能调度最优模型

✅ 成本可控:混合使用云端与本地资源

下一步行动:

- 尝试在「提示词工坊」测试不同模型效果

- 为客服机器人绑定Qwen本地模型

- 探索模型市场 的100+预置方案

测试开发全景图:人工智能测试、智能驱动、自动化、测试开发、左移右移与DevOps的持续交付 – 测试开发 – 爱测-测试人社区

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...