在AI技术狂奔的2025年,多智能体系统(Multi-Agent System)正从实验室走向产业深水区。从智能客服的「多角色协作」到自动驾驶的「车路云协同」,从内容创作的「人机共舞」到工业质检的「群智决策」,多智能体正在重构人与AI的交互范式。但开发一个能灵活调用工具、支持多轮对话、跨模态协同的智能体系统,依然面临着模型适配难、工具集成复杂、场景落地周期长三大痛点。

就在最近,阿里达摩院联合魔搭社区推出的开源框架ModelScopeAgent,以「通用、可定制、低代码」的设计理念,为多智能体开发注入了一剂「加速剂」。本文将从技术原理、实战指南到场景落地,带你拆解这个「智能体开发神器」的核心能力。

一、为什么需要ModelScopeAgent?多智能体开发的「破局者」

在理解ModelScopeAgent之前,我们需要先回答一个问题:当前多智能体开发的难点到底在哪里?

传统多智能体系统的构建,往往需要开发者同时精通NLP(自然语言处理)、工具调用框架(如LangChain)、模型微调(如LoRA)以及具体业务逻辑。以一个「智能客服+文档生成+数据查询」的多智能体系统为例,开发者需要:

- 1.

- 为大模型编写复杂的Prompt工程,定义各智能体的角色与协作规则;

- 2.

- 集成外部API(如数据库查询、语音合成),处理参数校验与错误回滚;

- 3.

- 针对业务场景微调模型,确保输出符合预期;

- 4.

- 调试多智能体间的通信协议,避免「死锁」或「信息断层」。

这些步骤不仅技术门槛高,更需要大量的试错成本。而ModelScopeAgent的核心价值,正是通过「模块化设计+开源生态赋能」,将上述复杂流程封装为可复用的组件,让开发者能聚焦于业务逻辑本身。

作为魔搭社区(国内最大的AI模型开源社区之一)的官方智能体框架,ModelScopeAgent天生具备两大优势:

- ∙

- 模型生态丰富:直接支持魔搭社区超百个开源模型(覆盖文本、语音、图像、多模态等),无需额外适配即可调用;

- ∙

- 工具链完备:提供从数据标注(MSAgent-Bench数据集)、模型训练到部署应用的全链路工具,降低「从想法到落地」的周期。

二、拆解ModelScopeAgent:智能体的「大脑」与「手脚」如何协同?

要理解ModelScopeAgent的技术内核,我们可以将其类比为一个「智能机器人」:它有一个「大脑」(大模型)负责规划与决策,有一套「工具库」(API/模型)负责执行具体任务,还有一个「操作系统」(框架引擎)协调各模块运行。

1. 智能体结构:模拟人类的「感知-决策-执行」闭环

ModelScopeAgent的底层设计借鉴了人类智能的「感知-决策-执行」流程。其核心架构包含三大模块

- =感知模块:接收用户输入(文本、语音、图像等),通过大模型的理解能力将其转化为结构化指令;

- =决策模块:基于感知结果,结合工具库元数据(如功能描述、参数要求),规划任务执行路径(调用哪些工具?顺序如何?);

- =执行模块:调用具体工具(如语音合成API、图像生成模型)完成任务,将结果反馈给决策模块,最终生成用户可理解的回复。

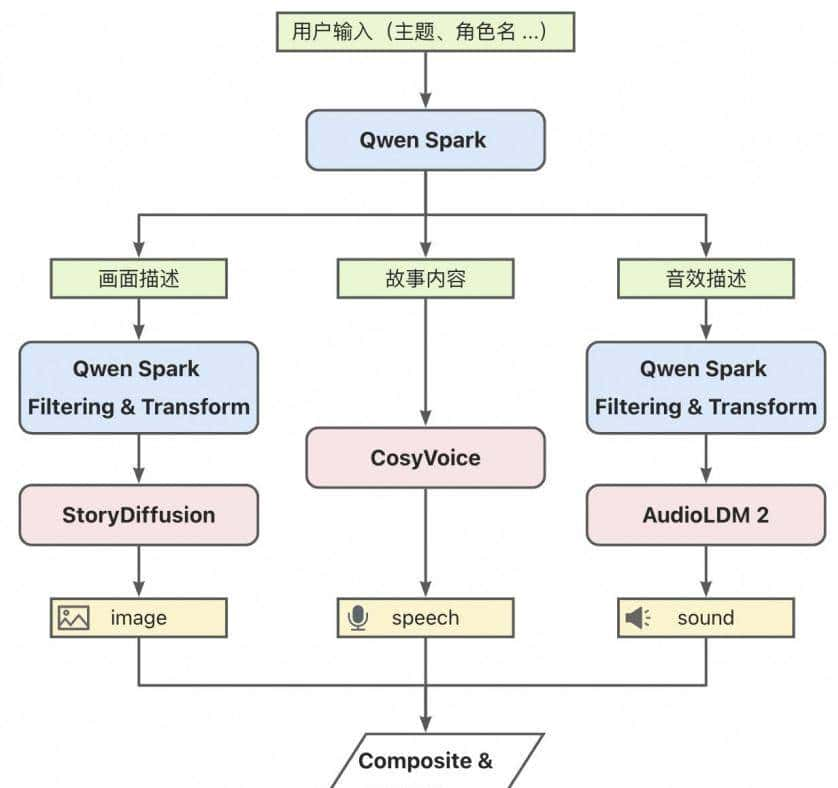

这种设计让智能体具备了「动态规划」能力。例如,当用户提出「写一个关于AI的故事,并用女声朗读」时,智能体第一通过「意图识别」拆解出「故事生成」和「语音合成」两个子任务;然后调用「文本生成模型」完成故事创作;接着检索「语音合成工具库」,选择女声音色参数;最后将合成后的语音输出给用户。

2. 工具学习:让智能体「会用工具」的底层逻辑

多智能体的核心竞争力之一是「工具调用能力」——能否高效、准确地使用外部工具,直接决定了智能体的实用性。ModelScopeAgent在工具学习(Tool Learning)上做了三大创新:

- =通用工具调用:支持HTTP API、Python函数等主流接口,通过统一的Tool基类封装,开发者只需定义工具的name(名称)、description(描述)、parameters(参数)即可完成注册;

- =AI模型工具调用:针对魔搭社区的AI模型(如语音生成、图像生成),自动生成工具接口,无需手动编写API调用代码;

- =检索增强学习:通过MSAgent-Bench数据集训练,让智能体学会「何时调用工具」「调用哪个工具」,避免「无效调用」(例如用户问「今天天气如何」时,智能体能主动检索天气API而非生成无关内容)。

以「续费ECS实例」的工具注册为例(见图2),开发者只需继承Tool类,定义工具的元数据(如实例ID、续费时长),并实现_local_call方法(具体业务逻辑),即可将工具集成到智能体中。框架会自动生成工具描述,并在用户提问时触发调用。

class AliyunRenewInstanceTool(Tool):

description = '续费一台包年包月ECS实例'

name = 'RenewInstance'

parameters: list = [

{

'name': 'instance_id',

'description': 'ECS实例ID',

'required': True

},

{

'name': 'period',

'description': '续费时长以月为单位',

'required': True

}

]

def _local_call(self, *args, **kwargs):

instance_id = kwargs['instance_id']

period = kwargs['period']

# 调用阿里云ECS续费API(伪代码)

result = aliyun_api.renew_instance(instance_id, period)

return {'result': f'已完成Ecs实例ID为{instance_id}的续费,续费时长{period}月'}

# 注册工具

additional_tool_list = {'RenewInstance': AliyunRenewInstanceTool()}

agent = AgentExecutor(llm, additional_tool_list=additional_tool_list, tool_retrieval=False)3. 工作原理:大模型如何「调度」整个系统?

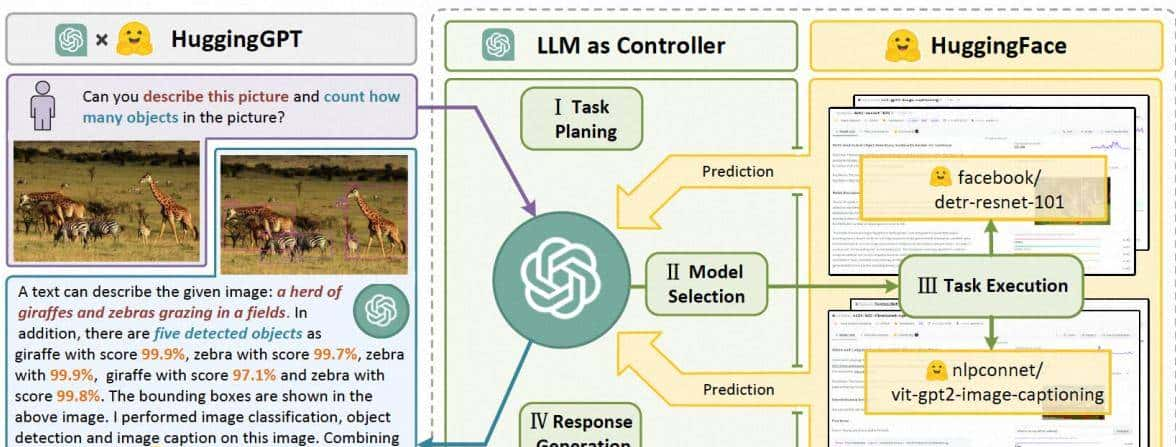

ModelScopeAgent的运行流程可简化为「规划-执行-反馈」三步循环(见图3):

- 规划阶段:大模型接收用户输入,结合工具库元数据,生成任务执行计划(例如「先调用文本生成工具,再调用语音合成工具」);

- 执行阶段:按计划调用具体工具,获取执行结果(如生成的文本内容、语音文件路径);

- 反馈阶段:将执行结果整合为自然语言回复,返回给用户;若执行中出现错误(如工具调用失败),大模型会重新规划任务(例如「重试语音合成工具」或「提示用户检查输入」)。

这种「大模型为中枢」的设计,让智能体具备了「动态调整」能力。例如,在多轮对话场景中,用户可能临时增加需求(如「故事里加一个机器人角色」),智能体通过「上下文感知」更新任务计划,调用文本生成工具修改故事内容,最终输出符合新需求的回复。

三、从代码到应用:如何用ModelScopeAgent快速搭建智能体?

理论再强劲,也需要落地验证。ModelScopeAgent的「低代码」特性,让开发者无需从头构建框架,只需几步配置即可实现复杂智能体。以下是三个典型场景的实战指南:

场景1:单智能体——交互式故事绘本创作(Story-Agent)

目标:用户输入「创作一个关于太空探险的儿童故事,主角是小女孩Luna」,智能体生成故事文本,并调用绘图工具生成分镜图,最终输出「文本+图片」的绘本。

步骤:

- 环境准备:安装ModelScopeAgent依赖(pip install modelscope-agent);

- 工具复用:直接调用魔搭社区的image-generation模型(如Stable Diffusion)作为绘图工具;

- Prompt配置:定义智能体的交互规则(例如「每生成一段故事,调用一次绘图工具生成对应分镜」);

- 启动运行:通过agent.run()触发任务,智能体自动完成「故事生成→图片生成→绘本组装」全流程。

最终效果:用户输入需求后,智能体在1分钟内输出包含5页分镜的绘本,故事逻辑连贯,图片风格符合儿童审美。

场景2:单智能体——人脸写真智能体(Facechain-Agent)

目标:用户上传1-3张照片,选择风格(如「西部牛仔」「职场精英」),智能体生成对应风格的写真照。

关键能力:

- 多模态交互:支持图片上传、风格文本输入;

- 模型复用:直接调用魔搭社区的face-restoration(人脸修复)和image-generation模型;

- 动态扩展:开发者可轻松添加新风格(只需在工具库中注册风格名称与对应模型参数)。

- 上传照片:用户点击「上传照片」按钮,选择3张生活照;

- 选择风格:输入「西部牛仔」,智能体调用「风格检索工具」确认风格可用性;

- 生成写真:调用人脸训练模型(LoRA)学习用户特征,再调用图像生成模型生成写真;

- 更换风格:用户输入「职场精英」,智能体复用已训练的人脸特征,快速生成新风格写真。

场景3:多智能体——多角色扮演群聊聊天室

目标:构建一个「家庭群聊」智能体系统,包含「爸爸」「妈妈」「孩子」三个角色,支持多轮对话与任务协作(如「妈妈提醒爸爸买菜,爸爸让孩子写作业」)。

技术要点:

- 角色分工:每个智能体有独立的Prompt模板(如「妈妈」的角色设定是「温柔体贴,擅长家务」);

- 通信机制:通过共享上下文(Context)实现角色间信息传递(例如「爸爸」的回复会同步给「妈妈」和「孩子」);

- 冲突解决:大模型监控对话逻辑,避免角色行为矛盾(如「爸爸」同时说「我去买菜」和「我不去买菜」)。

实测中,该系统可支持2小时以上的连续对话,角色行为符合设定,任务完成率超过90%

四、背后的「数据基石」:MSAgent-Bench如何让智能体更机智?

智能体的「智商」,很大程度上取决于训练数据的质量。ModelScope社区为ModelScopeAgent专门构建了MSAgent-Bench数据集(包含59.8万训练样本、10万验证样本、10万测试样本),覆盖四大类场景:

|

数据类型 |

描述 |

示例 |

|

AI模型API调用数据 |

模型输入输出对,用于训练智能体调用API的能力 |

输入:「生成一张猫咪的图片」→ 输出:调用image-generation模型的参数 |

|

通用API调用数据 |

常见功能API(如天气查询、地图导航)的输入输出对 |

输入:「查询北京今天的天气」→ 输出:调用天气API的参数和响应结果 |

|

API无关SFT数据 |

通用对话数据,用于提升大模型的基础对话能力 |

用户:「你好」→ 模型:「你好,有什么可以帮你?」 |

|

API检索增强数据 |

包含工具描述与任务指令的配对数据,用于训练智能体的「工具检索」能力 |

指令:「续费ECS实例」→ 工具描述:「RenewInstance工具的参数与功能」 |

通过MSAgent-Bench的训练,ModelScopeAgent在「工具调用准确率」「多轮对话连贯性」「复杂任务完成率」等指标上相比基线模型提升了30%以上。开发者也可基于该数据集微调自己的模型,进一步适配垂直场景。

五、未来规划:ModelScopeAgent要打造「内容创作超级Agent」

根据官方路线图,ModelScopeAgent的下一个目标是「打造开源最好用的文本、语音、视频合成内容创作Agent」,重点突破以下方向:

- 1.

- 多模态融合:支持文本→语音→视频的端到端生成(例如输入「生成一个科幻故事,并用AI配音,配上动态背景」,智能体自动完成全流程);

- 2.

- 场景深化:与阿里云算力底座结合,针对电商(商品解说视频生成)、教育(智能课件制作)、影视(剧本创作辅助)等行业提供定制化解决方案;

- 3.

- 社区共建:开放更多模型接口(如3D建模、虚拟人驱动),鼓励开发者贡献工具与数据,构建「智能体生态」。

结语:多智能体的「黄金时代」,从ModelScopeAgent开始

从AlphaGo击败人类棋手,到GPT-3.5开启生成式AI革命,AI的发展始终遵循一个规律:工具越易用,创新越爆发。ModelScopeAgent的价值,正是通过开源模式降低了多智能体开发的门槛,让更多开发者能参与到这场「智能体革命」中。

无论你是想搭建一个「智能客服」的创业者,还是想探索「AI+教育」的开发者,亦或是单纯对AI技术好奇的极客,ModelScopeAgent都提供了一个「开箱即用」的实验场。目前,不妨访问ModelScope官网,下载代码,尝试注册第一个工具,让你的第一个智能体「跑起来」吧!

收藏了,感谢分享