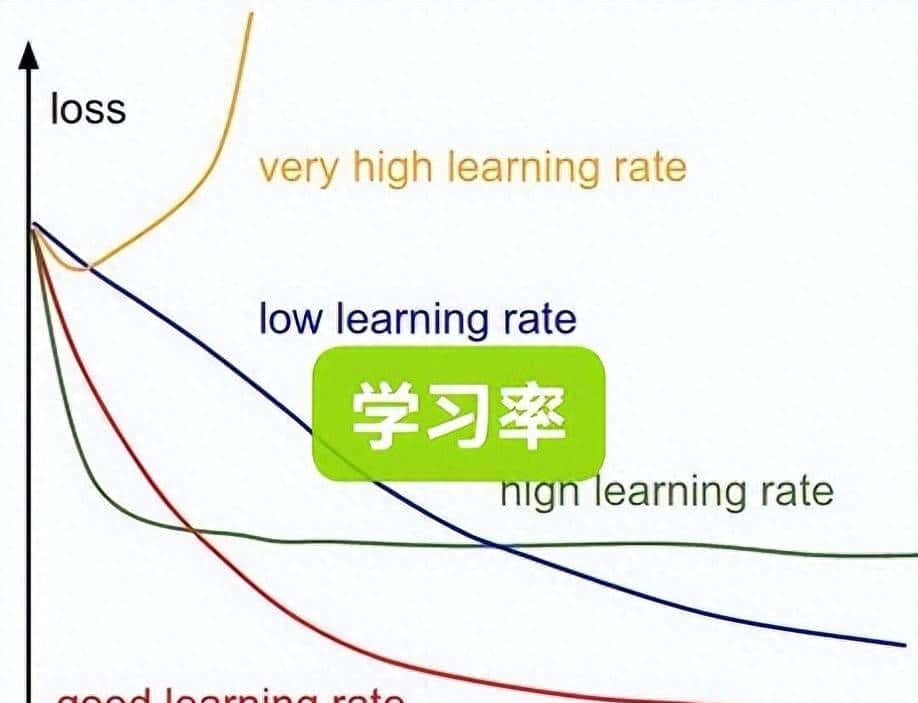

在机器学习的世界里,学习率可能是最重大却又最容易被忽视的超参数。它就像一位隐形的指挥家,默默掌控着模型训练的整个节奏和方向。

学习率究竟是什么?

技术定义:学习率决定了模型在每次参数更新时的步长大小,一般用α表明,取值范围在(0,1)之间。

简单理解:想象你在下山,学习率就是你每一步迈出的距离。步子太大可能越过谷底,步子太小又永远到不了目的地。

学习率的双重角色

1. 收敛速度的调节器

合适的学习率能够加速模型收敛,在保证质量的前提下快速找到最优解。

2. 训练稳定性的守护者

学习率直接影响训练过程的稳定性,过大或过小都会导致问题。

三种学习率状态的深度解析

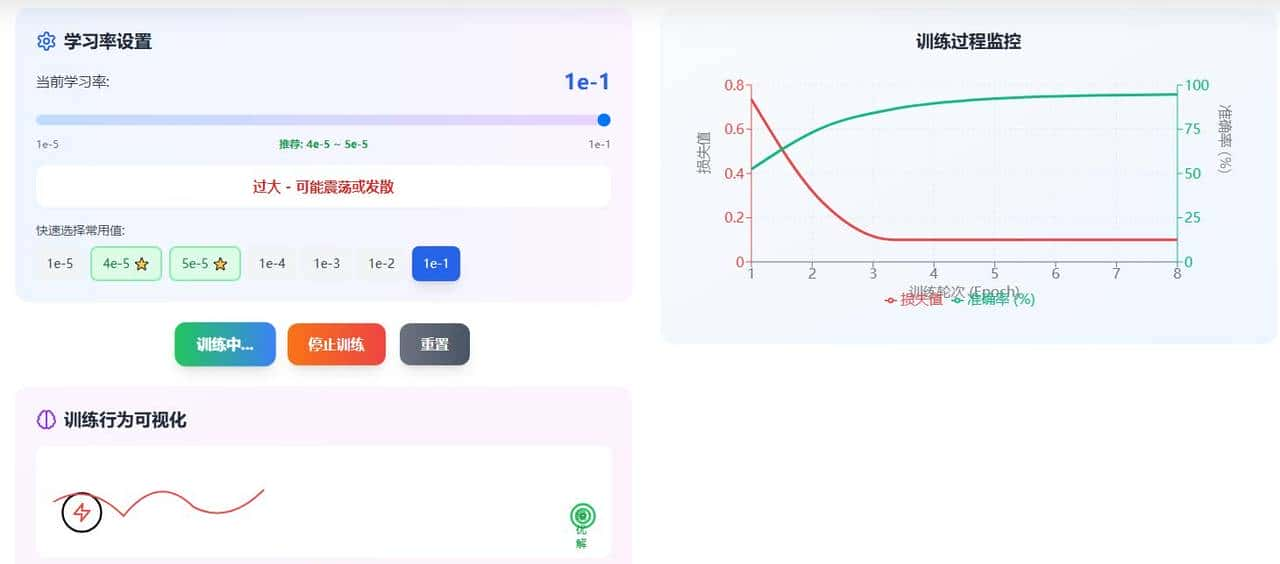

学习率过大(> 1e-2)

现象:损失函数剧烈震荡,无法收敛

根本缘由:参数更新步长超过最优解附近的平坦区域

数学表现:$θ_{t+1} = θ_t – α∇J(θ_t)$ 中α过大,导致在最优解附近来回跳跃

实际案例:

python

# 典型的大学习率问题

learning_rate = 0.1 # 过大

for epoch in range(100):

gradient = compute_gradient(data)

parameters -= learning_rate * gradient

# 结果:loss在[0.5, 5.0]之间剧烈震荡学习率过小(< 1e-5)

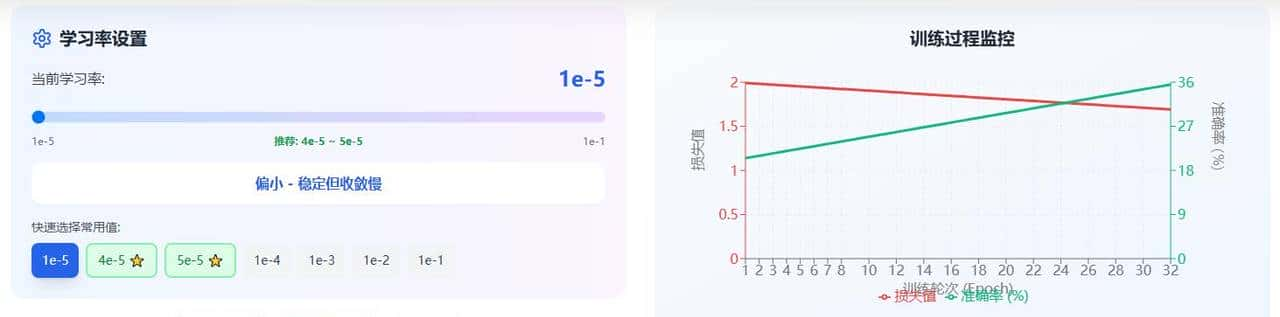

现象:训练进度极其缓慢,容易陷入局部最优

根本缘由:参数更新幅度不足以跳出局部最小点

时间成本:可能需要10倍于正常情况的训练时间

实际影响:

- 训练时间显著增加

- 可能永远无法达到全局最优

- 计算资源浪费严重

⭐ 学习率适中(4e-5 ~ 5e-5)

现象:平滑收敛,稳定逼近最优解

优势:在收敛速度和稳定性间达到完美平衡

生活中的学习率类比

学习复习的智慧

大学习率(0.1):每次考试后彻底改变学习方法——可能快速进步,也可能忘记已有优势

小学习率(0.0001):每次只微调学习细节——稳定但进步缓慢

适中学率(0.00005):定期反思调整,平衡继承与创新

驾驶的方向盘控制

大幅转向:急转弯时过度反应,车辆失控摇摆

微调方向:转弯不足,无法及时调整路线

适度转向:平稳过弯,精准控制

烹饪的调味艺术

大量加盐:一次失误毁掉整道菜

少量加盐:安全但难以达到最佳口味

适度调味:分层加盐,逐步达到完美

实践中的学习率策略

推荐设置指南

|

任务类型 |

推荐学习率 |

理论基础 |

|

一般微调任务 |

5e-5 |

经验证明的最佳平衡点 |

|

保守微调 |

4e-5 |

更高稳定性要求 |

|

全参数微调 |

5e-6 |

防止破坏预训练知识 |

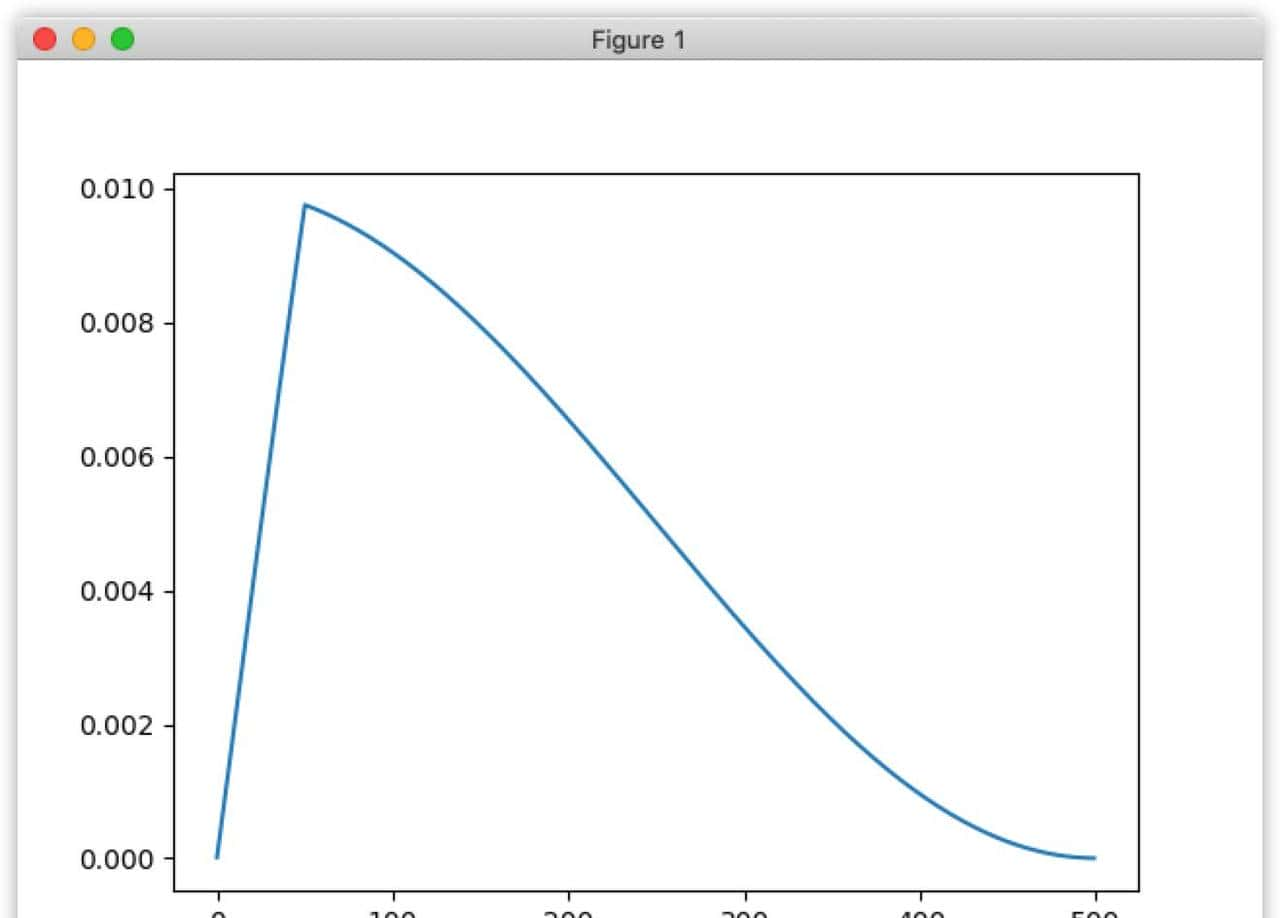

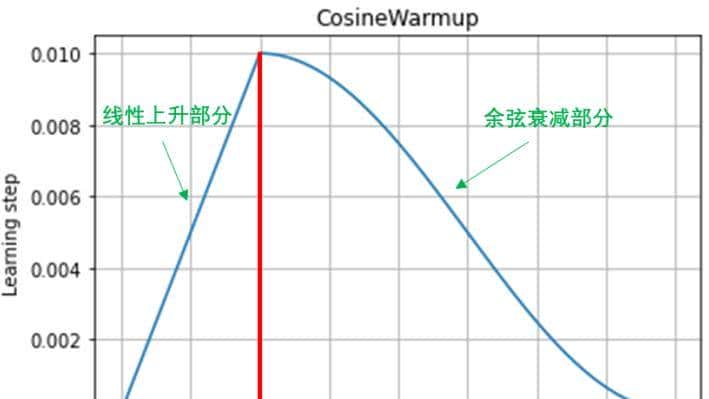

学习率调度策略

1. 学习率预热(Warmup)

# 逐步增加学习率,避免初期震荡

def warmup_schedule(step, warmup_steps=1000):

if step < warmup_steps:

return step / warmup_steps

else:

return 1.02. 余弦退火(Cosine Annealing)

# 平滑降低学习率,协助模型跳出局部最优

def cosine_annealing(step, total_steps, initial_lr=5e-5):

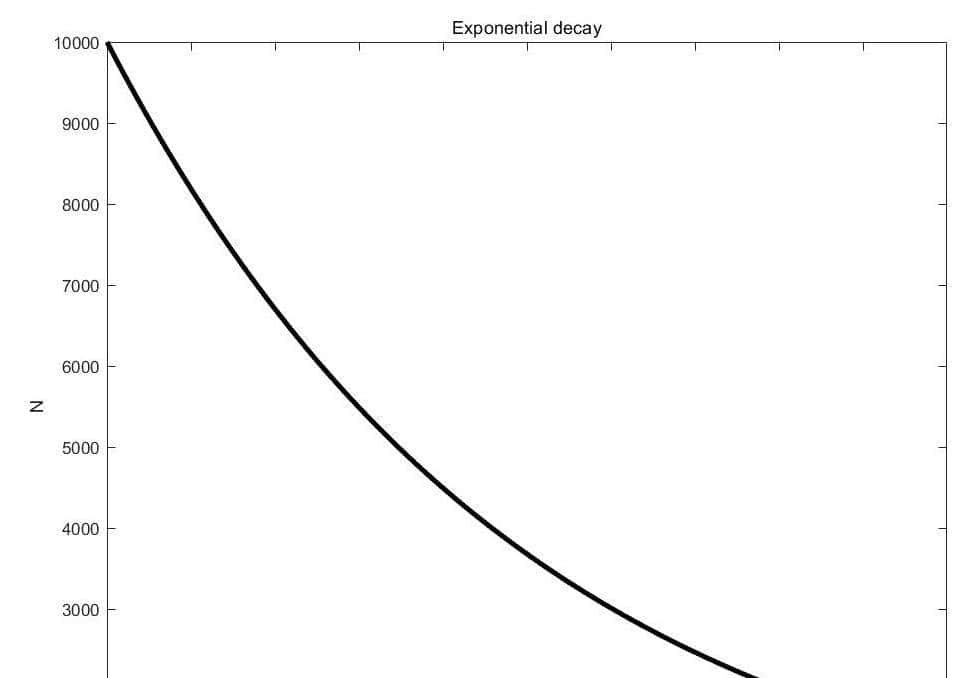

return initial_lr * 0.5 * (1 + math.cos(math.pi * step / total_steps))3. 指数衰减

# 每个epoch按比例降低学习率

learning_rate = initial_lr * (decay_rate ** epoch)关键实践提议

数据集大小的影响

- 大数据集:可尝试稍大的学习率(如1e-4)

- 小数据集:务必使用小学习率(5e-5或更小)

- 缘由:小数据集梯度估计噪声大,需要更保守的更新策略

不同微调方法的差异

LoRA微调

python

# LoRA一般使用较大的学习率

learning_rate = 1e-4 # 常见选择全参数微调

python

# 全参数微调需要更小的学习率

learning_rate = 5e-6 # 小一个数量级监控与调整策略

早期诊断指标:

- 前几个epoch的loss下降速度

- 训练稳定性的视觉观察

- 验证集表现的同步性

调整原则:

- 如果震荡:立即减小学习率

- 如果停滞:思考适当增大或使用调度策略

- 如果过拟合:结合权重衰减共同调整

高级技巧与最新进展

自适应学习率算法

- AdamW:当前微调任务的首选

- Lion:Google提出的新优化器,在某些任务上表现更好

- 8-bit Adam:内存优化的Adam变体

学习率查找器

python

# 自动寻找最优学习率范围

def find_learning_rate(model, train_loader):

lr_finder = LRFinder(model, optimizer, criterion)

lr_finder.range_test(train_loader, end_lr=1, num_iter=100)

lr_finder.plot() # 可视化最佳范围总结:学习率选择的艺术

选择学习率既是科学也是艺术。它需要:

- 理论基础:理解优化算法的数学原理

- 经验积累:在不同任务中积累调参经验

- 实验验证:通过系统实验找到最佳设置

- 持续监控:在训练过程中保持警惕,及时调整

记住这个黄金法则:当你怀疑时,选择更小的学习率。稳定性往往比速度更重大,特别是在涉及重大任务或有限计算资源的情况下。

学习率虽小,却是连接模型潜力与实际性能的关键桥梁。掌握它的艺术,你就在机器学习的道路上迈出了坚实的一步。

相关文章