搞AI的谁没被分词器(tokenizer)恶心过?

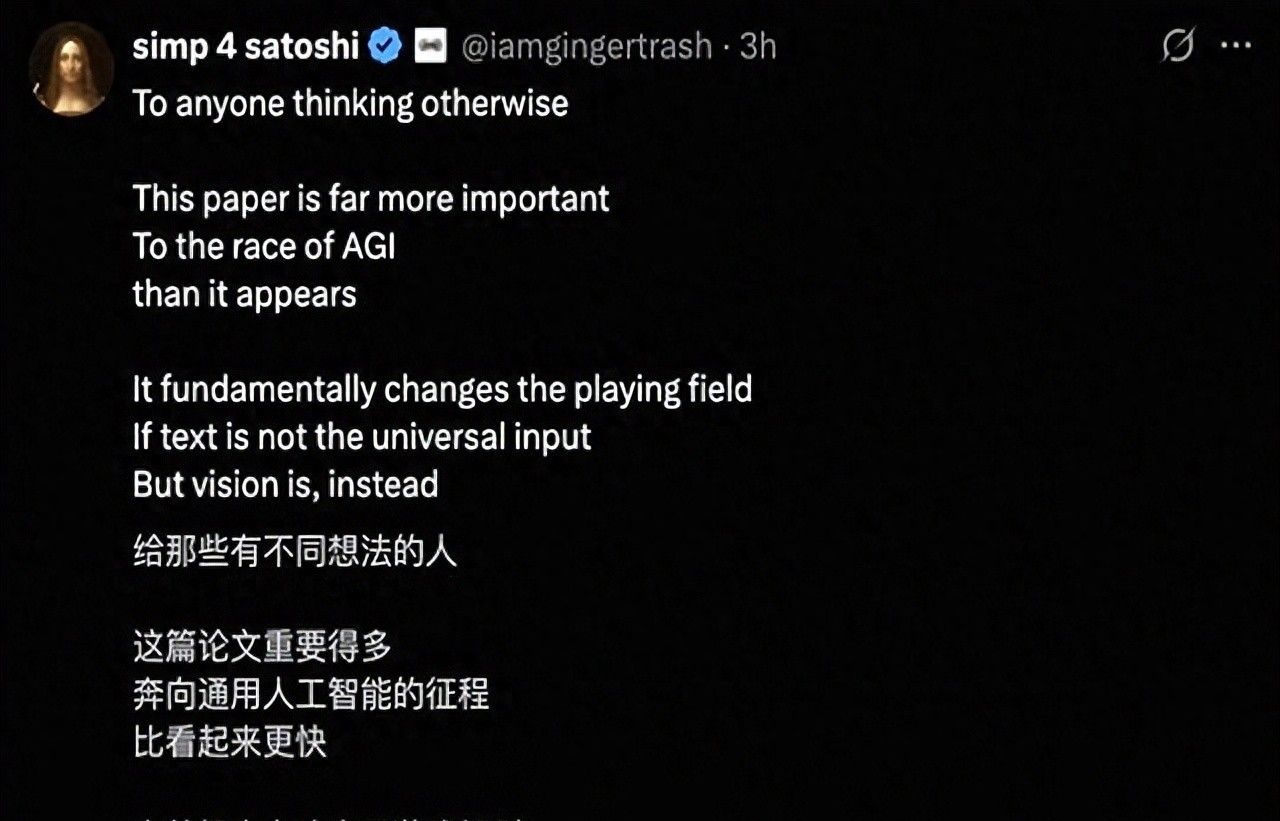

所以当特斯拉前AI大佬Karpathy最近狂赞DeepSeek的新模型,说要终结分词器时代,圈内人一下就懂了。

这事儿不是小题大做,可能真是个方向性的改变。

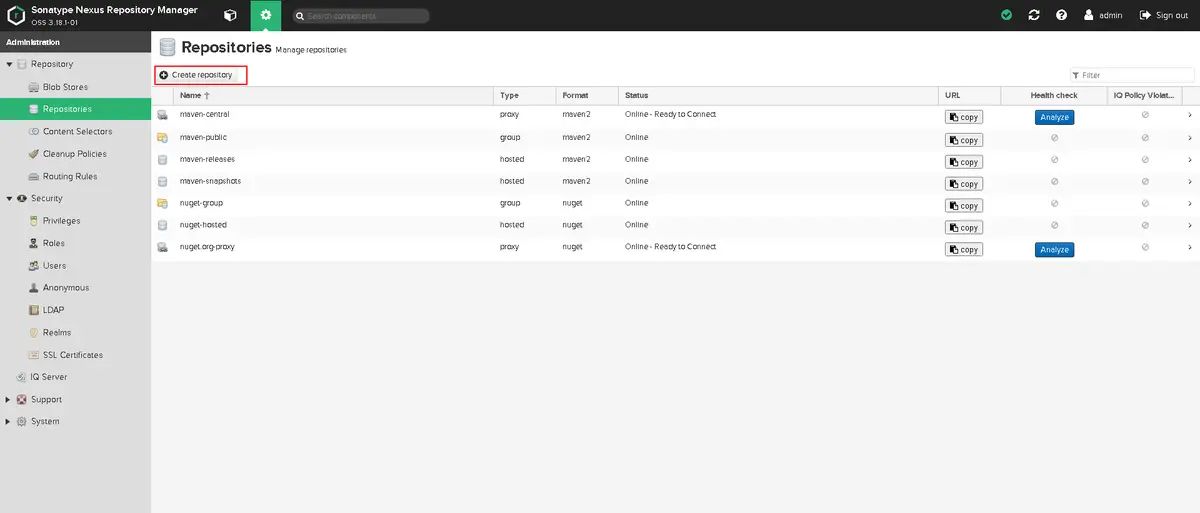

DeepSeek-OCR这个模型,简单说就是把文字当成图片来处理。

一整页密密麻麻的PDF,它“看一眼”就压缩成极小的数据,而且还能读懂。

这解决了分词器那个老毛病:丑、笨、还一堆历史遗留问题。

列如,分词器会把“你好”和“ 你好”当成完全不同的东西,就由于前面多了个空格。

处理多语言,尤其是那些没有空格分隔的语言,更是灾难。

一个笑脸emoji“”,在模型眼里只是个没有意义的数字代码,而不是一张生动的脸。

这些问题,开发者们早就忍不了了。

Karpathy兴奋的点就在这。

他一直鼓吹,AI的输入干脆全换成图像得了。

就算是纯文本,也先渲染成图片再喂给模型。

这样做的好处显而易见:压缩率高,上下文窗口能更长;而且能理解粗体、颜色、排版这些“元信息”,信息保真度更高。

这不只是技术洁癖。

许多文档,列如财务报表、法律合同,它们的格式、表格、甚至是签名的位置,都是信息的一部分。

传统方法先把这些转换成纯文本,信息早就丢了一大半。

DeepSeek-OCR证明了,直接“看”图,效果好得多。

当然,说“文本已死”有点标题党了。

毕竟模型最后输出给我们的,绝大多数还是文本。

没人希望聊天机器人回你一堆像素块。

所以,更准确的说法是,文本作为“输入”的唯一霸主地位,正在被动摇。

马斯克说未来AI的输入99%是光子,那是哲学家的浪漫。

Karpathy想搞个纯图像输入的nanochat,那是工程师的冲动。

而DeepSeek,是踏踏实实把这个设想往前推了一大步。

分词器的时代或许不会立刻终结,但一个更依赖视觉感知的AI时代,的确 要来了。

相关文章