Ultra HDR(JPEG_R)文件异常容错与增益图重建

关键词:Ultra HDR、JPEG_R、Gain Map(增益图)、容错、异常检测、逆向重建、log2 域正则、TV/导向滤波、SDR 回退、Android 14+、ImageDecoder

摘要:

Ultra HDR(JPEG_R)以“SDR 基底 + 增益图(Gain Map)”携带高动态范围信息。真实项目中常见文件与元数据异常(增益图缺失/截断、位深/分辨率声明错误、EXIF/XMP 混乱、通道错配、块损伤等),将直接导致重建失败、画面台阶/偏色或回放崩溃。本文给出一套工程化容错与重建策略:以结构/语义双层校验快速定位异常;在不可修复时提供安全降级;在可恢复场景下基于log2 域再估计 + 先验约束(边缘/肤色/天空)重建增益图;并落实到 Android 端的稳定实现、性能控制与指标门限/Gate。

目录

异常类型与影响面

文件层:JPEG 段截断、APPn/XMP 损坏、Huffman/量化表缺失语义层:增益图位深/比例声明错误、与 SDR 基底尺寸不一致、EXIF 方向/色彩空间冲突观感风险:ΔL 台阶、ΔE/Δh° 偏色、Banding/Blockiness、Flicker

异常检测与健壮性校验

结构校验:SOI/EOI、段表、CRC/长度、一致性(base↔gain)语义校验:位深/比例/色彩标记、EXIF 方向、通道一致(|Gc−Ḡ|)快速判定矩阵:可修复 / 需降级 / 拒绝加载(保护 UI 稳定)

增益图重建策略(可恢复场景)

缺失/截断:log2 域再估计

g

^

=

arg

min

∥

L

hdr

−

L

sdr

⋅

2

g

∥

2

+

λ

∥

∇

g

∥

hat g=argmin|L_{ ext{hdr}}-L_{ ext{sdr}}cdot2^{g}|^2+lambda|

abla g|

g^=argmin∥Lhdr−Lsdr⋅2g∥2+λ∥∇g∥分辨率/对齐错误:统一上采样核(Lanczos/Bicubic)+ 边缘引导(Guided/TV)通道错配:通道收束与 flesh-line 约束;蓝噪抖动抑制带状

容错回放与降级路径

一次映射原则:线性域重建→Tone Map/Hue/Sat,仅做一次安全降级:HDR→高质量 SDR 代理,锐化/对比互斥,日志与用户无感回放 Shim:小幅 α/β 微调与通道收束,跨设备一致性

端侧实现与性能(Android 14+)

ImageDecoder 容错解码、异常分支与 try/catch 护栏瓦片化/渐进解码、F16/8888 双轨、内存与耗时上限失败样本上报与灰度开关

指标与门限(Gate)

指标:ΔL_rel、ΔE00/Δh°、ΔG/∇g、Banding/BI、Flicker建议阈值:ΔL_rel P95≤3%、ΔE00 P95≤3.0、ΔG_rel≤5%、P95(‖∇g‖)差≤0.01/px、Banding≤0.30触发矩阵:触发→降级/再估计参数→阻断合入

案例与配置管理

典型异常:增益段截断、位深误标、基底/增益尺寸错位、EXIF 方向冲突修复动作与复测记录:参数快照、门限表 Diff、Golden Set 回归YAML/JSON 配置与灰度发布/回滚流程

1. 异常类型与影响面

核心背景

Ultra HDR(JPEG_R)= SDR 基底(JPEG) + Gain Map(增益图) + 元数据(EXIF/XMP)。任何一环异常都会放大为观感风险:亮度台阶、肤色偏移、带状/块效应、闪变、崩溃。工程侧需要把问题拆成文件结构层与语义一致层两类,再映射到可恢复/不可恢复的处置策略。

1.1 异常分层与症状对照

| 层级 | 具体异常 | 典型症状 | 首选处置 |

|---|---|---|---|

| 结构层 | SOI/EOI 缺失、段表截断、APPn/XMP 损坏、Huffman/量化表缺失 | 解码失败/崩溃、黑图 | 拒绝加载或SDR 回退 |

| 语义层 | 增益图位深/比例声明错误、基底/增益分辨率不一致、EXIF 方向冲突、色彩标记不一致 | ΔL 台阶、ΔE/Δh°、角落发灰、色偏 | 矫正/重建 |

| 数据缺口 | Gain Map 缺失/尾部截断、块损伤(部分 tile 为空或噪点) | 局部带状/块边共振、HDR 反常 | 局部重建 |

| 通道错配 | R/G/B 通道错位或幅值差大 | 肤色偏红/偏绿、天空偏品红 | 通道收束 + flesh-line 约束 |

| 编码伪影 | 基底 JPEG 质量过低、增益图位深不足/无抖动 | 带状/块边 | 编解码策略修正 |

1.2 风险传播(因果图)

2. 异常检测与健壮性校验

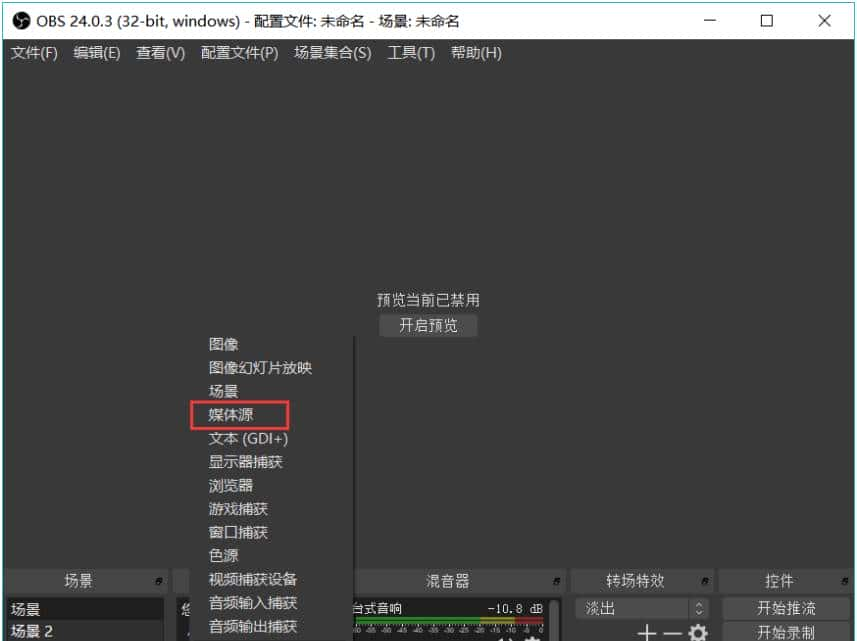

2.1 检测总览(Mermaid 流程)

flowchart TD

A[输入: JPEG_R 字节流] --> B[结构校验: SOI/EOI, 段表, 长度/CRC]

B -->|失败| Z1[SDR 回退 or 拒绝加载(黑图保护)]

B --> C[解析: 基底 JPEG 与 Gain Map 元数据]

C --> D[一致性检查: 分辨率/位深/scale/方向/色彩]

D -->|冲突| E[自动矫正: 重采样/方向统一/位深兜底]

E --> F[可恢复性判定]

D -->|通过| F[可恢复性判定]

F -->|可恢复| G[重建策略(第3章)]

F -->|不可恢复| Z2[SDR 高质量回退 + 记录异常]

G --> H[一次映射→渲染/导出]

2.2 结构层校验(示例代码)

Kotlin:解码护栏(Android 14+)

fun safeDecodeUltraHdr(source: ImageDecoder.Source): Result<DecodedUhImage> = runCatching {

ImageDecoder.decodeDrawable(source) { decoder, info, _ ->

decoder.allocator = ImageDecoder.ALLOCATOR_SOFTWARE

decoder.setOnPartialImageListener { e ->

// 结构损坏 → 触发 SDR 回退

false /* 不接受部分图,交给上层回退 */

}

}.let { drawable ->

// 成功:解析 XMP/APPn,混合成 RGBA_F16 & Gain Map

buildDecodedUhImage(drawable)

}

}

结构快速检查

def validate_jpeg_segments(b: bytes) -> bool:

# SOI/EOI、段表长度、APPn/XMP 长度与 CRC(如有)

# 失败立即回退到 SDR

pass

2.3 语义一致性校验(交叉口径)

| 校验项 | 规则 | 处置 |

|---|---|---|

| 分辨率 | |

重采样到统一网格(统一核:Lanczos/Bicubic) |

| 位深 | |

取最近合法位深 + 抖动标记 |

| 比例 (scale) | |

落回最邻近支持值 |

| 方向 | EXIF 方向 = 基底方向 = 增益方向 | 统一按 EXIF 矫正后再入栈 |

| 色彩 | 基底色彩标记(sRGB/P3)与元数据一致 | 不一致→按基底实际解析 |

UML 类图:校验器与更正器

2.4 可恢复性判定矩阵

| 场景 | 诊断 | 处置 | ||

|---|---|---|---|---|

| 增益图完全缺失 | 无 APPn / XMP 标记 | SDR 回退(第4章),同时记录异常 | ||

| 增益图局部截断/少量 tile 损坏 | tile CRC/长度异常 | 局部重建(第3章 3.4/3.5) | ||

| 位深/比例误标 | 值不在预期集合 | 强制更正 + 抖动 | ||

| 基底/增益尺寸错位 | 宽高/scale 不匹配 | 统一上采样核重采样 | ||

| 通道偏差过大 | `P95(max_c | Gc-Ḡ | /Ḡ) > 6%` | 通道收束 + flesh-line 约束 |

| EXIF 方向冲突 | 基底/增益方向不同 | 按 EXIF 矫正后统一 |

3. 增益图重建策略(可恢复场景)

目标:当增益图部分缺失/截断/错位且有机会恢复时,在log2 域估计一份观感正确且可控的增益图

g

^

hat g

g^,并对其做斜率/通道/量化护栏,最大程度还原 HDR 观感。

说明:完全缺失时无法“找回”真实 HDR,仅能SDR 回退或做逆向扩展(inverse tone-mapping)以得“类 HDR”效果;本文重建策略主要面向部分可用的场景。

3.1 基础模型(log2 域 + 先验)

记

g

=

log

2

G

g=log_2 G

g=log2G,

L

hdr

=

L

sdr

⋅

2

g

L_{ ext{hdr}} = L_{ ext{sdr}}cdot 2^{g}

Lhdr=Lsdr⋅2g。在已有的“有效块/邻域”与先验下,最小化:

M

M

M 为可用掩膜(未损坏的 gain tile);

g

0

g_0

g0 为原始 log-gain(缺损处为空)。TV + 导向项让 g 既平滑又与边缘对齐,避免光晕。通道一致限制 RGB 与其均值的偏差(肤色/天空区域权重更大)。

3.2 实现骨架(Python 伪代码)

def reconstruct_log_gain(g0, mask, Lsdr, w_skin=None, w_sky=None,

lam_tv=0.01, lam_guided=0.05, lam_ch=0.02, it=200, lr=0.2):

"""

g0: 原始 log2(G),缺损处可置0

mask: 1=可用, 0=缺损

Lsdr: 线性亮度 or 灰度引导

*w_skin/sky: ROI 权重(可选)

"""

import numpy as np

g = g0.copy()

guide = grad(Lsdr) # ∇L_sdr

for _ in range(it):

# 数据保真梯度

r_data = mask * (g - g0)

# TV 梯度(各向异性 L1 的近似)

r_tv = div(normalize(grad(g)))

# 导向项:∇g 贴近 κ∇L

kappa = 0.6

r_guided = laplacian(g - kappa * Lsdr)

# 通道一致(若 g 分通道则约束到均值)

r_ch = channel_deviation_grad(g) if g.ndim==3 else 0

# ROI 权重

w = 1.0 + 0.5*(w_skin or 0) + 0.3*(w_sky or 0)

grad_total = w*(r_data) + lam_tv*r_tv + lam_guided*r_guided + lam_ch*r_ch

g -= lr * grad_total

return g

工程建议:若追求更快的封闭式近似,可用引导滤波(Guided Filter)对初始

g

g

g 做边缘保持插值;复杂区域再用 30–50 次迭代细化。

3.3 分辨率/对齐错误的统一口径

统一上采样核:增益图与基底统一用 Lanczos/Bicubic,保证边缘口径一致;亚像素对齐:若发现半像素错位,先做亚像素平移再重采样;方向统一:先按 EXIF 矫正方向,再做尺度与对齐,避免 ROI 坐标错位。

def resample_gain_to_base(G, base_size):

G_aligned = subpixel_shift(G, estimate_shift(G, base_size))

return lanczos_resample(G_aligned, base_size)

3.4 局部块损伤(tile in-painting)

思路:在 log2 域对损坏 tile 做泊松/引导滤波插值,边界来自相邻完整 tile;边缘/肤色 ROI 增大导向权重。

def inpaint_tiles_log2(g, mask, guide):

# mask=1 有效, 0 缺损;对 mask=0 区域做泊松求解(梯度域连续)

return poisson_inpaint(g, mask, guide=guide, weight_edge=2.0)

3.5 通道错配与肤色/天空约束

通道收束(限幅到均值 ±α):

肤色线(flesh-line)约束:在 OKLCh(或 IPT)中对 Skin ROI 做色相带限(Δh° ≤ 3.5°)与高光减饱和(避免“塑料感”),与重建后的 HDR 亮度耦合:

// 线性域 → OKLCh → hue lock + sat map → 回 RGB

Ch hueLock(Ch a, float hRef, float tauDeg){ ... } // 带限

Ch satMap(Ch a, float alpha, float knee){ ... } // 高光减饱和

3.6 量化与抖动(抗带状)

量化前蓝噪抖动:在 log2 域加入幅度为半个 LSB 的蓝噪;位深/分辨率恢复:可选把重建区域局部提升到 10bit + 1.5× 分辨率后再下采样,以降低台阶共振。

def quantize_with_blue_noise(g, bit=10):

lsb = 1.0/(2**bit - 1)

noise = blue_noise_like(g.shape) * lsb * 0.5

return np.round((g + noise)/lsb)*lsb

3.7 重建后护栏(Guard)与通过判定

| 指标(ROI 统计,P95) | 通过阈值 | 说明 | ||

|---|---|---|---|---|

| ΔL_rel(灰/肤/天) | ≤ 3% | 亮度连续 | ||

| ΔG_rel(灰/肤/天) | ≤ 5% 或 | Δlog2 | ≤0.07 | 幅值一致 |

| P95(‖∇g‖) 差 | ≤ 0.01/px | 斜率一致 | ||

| 通道偏差 max|Gc−Ḡ|/Ḡ | ≤ 6% | 防偏色 | ||

| BandingScore | ≤ 0.30 | 渐变台阶 | ||

| ΔE00/Δh°(肤色) | ≤ 3.0 / ≤ 3.5° | 色彩自然 |

UML 活动图:重建闭环

4. 容错回放与降级路径(一次映射 · 安全降级 · 轻量归一)

4.1 回放决策总览

flowchart TD

A[输入: JPEG_R] --> B[结构/语义校验(第2章口径)]

B -->|失败| C[SDR 高质量回退]

B -->|通过| D[可恢复性判定]

D -->|可恢复| E[轻量归一 Shim(α/β + 通道收束)]

D -->|不可恢复| C

E --> F[线性域重建 → 一次映射(Tone/Hue/Sat)]

C --> F

F --> G[渲染(Compose/GL) / 导出 / 分享]

4.2 Android 端:安全解码 + 一次映射 + 降级

4.2.1 安全解码与回退(Kotlin / Android 14+)

// build.gradle: minSdk 29, targetSdk 34

// AndroidManifest: <activity android:colorMode="wideColorGamut|hdr" ... />

data class UhdrFrame(

val bitmapF16: Bitmap?, // RGBA_F16 (HDR 详情)

val sdrProxy: Bitmap, // SDR 代理(列表/不支持端)

val metadata: Bundle // 解析到的 EXIF/XMP 片段等

)

object UhdrDecoder {

fun decodeOrFallback(ctx: Context, uri: Uri): UhdrFrame {

return kotlin.runCatching {

// 1) Ultra HDR 尝试:API 34+ 自动解码增益图并在平台重建

val src = ImageDecoder.createSource(ctx.contentResolver, uri)

val hdr = ImageDecoder.decodeBitmap(src) { dec, info, _ ->

dec.allocator = ImageDecoder.ALLOCATOR_HARDWARE

dec.setTargetColorSpace(ColorSpace.get(ColorSpace.Named.DISPLAY_P3))

dec.isUnpremultipliedRequired = false

dec.setOnPartialImageListener { /* 不接受半图 → 抛异常触发回退 */ false }

}

if (hdr.config != Bitmap.Config.RGBA_F16) error("F16 path unavailable")

// 2) 生成高质量 SDR 代理(一次映射的 SDR 版本,用于列表/降级)

val sdr = sdrProxyFromF16(hdr)

UhdrFrame(hdr, sdr, metadataOf(ctx, uri))

}.getOrElse {

// 3) 全面回退:纯 SDR 解码(ARGB_8888),保证不崩溃

val sdr = decodeSdr(ctx, uri)

UhdrFrame(bitmapF16 = null, sdrProxy = sdr, metadata = metadataOf(ctx, uri))

}

}

private fun decodeSdr(ctx: Context, uri: Uri): Bitmap {

val src = ImageDecoder.createSource(ctx.contentResolver, uri)

return ImageDecoder.decodeBitmap(src) { dec, info, _ ->

dec.allocator = ImageDecoder.ALLOCATOR_SOFTWARE

dec.setTargetColorSpace(ColorSpace.get(ColorSpace.Named.SRGB))

dec.setOnPartialImageListener { false }

}.copy(Bitmap.Config.ARGB_8888, /*mutable=*/false)

}

private fun sdrProxyFromF16(hdrF16: Bitmap): Bitmap {

// HDR → SDR 一次 Tone Map(简单而稳健的 Hable 近似),落地 sRGB/8888

val w = hdrF16.width; val h = hdrF16.height

val sdr = Bitmap.createBitmap(w, h, Bitmap.Config.ARGB_8888)

val csIn = hdrF16.colorSpace ?: ColorSpace.get(ColorSpace.Named.DISPLAY_P3)

// Android 没有逐像素读取 F16 API,使用硬件绘制 + ColorMatrix 可控近似:

val canvas = Canvas(sdr)

val paint = Paint(Paint.ANTI_ALIAS_FLAG)

// 轻度压高光 + 提中灰;(真实项目建议换为 GL/Compute 的线性域曲线)

val m = ColorMatrix(

floatArrayOf(

0.92f, 0f, 0f, 0f, 0f,

0f, 0.92f, 0f, 0f, 0f,

0f, 0f, 0.92f, 0f, 0f,

0f, 0f, 0f, 1f, 0f

)

)

paint.colorFilter = ColorMatrixColorFilter(m)

canvas.drawBitmap(hdrF16, 0f, 0f, paint)

return sdr

}

private fun metadataOf(ctx: Context, uri: Uri): Bundle = Bundle().apply {

// 如果是文件路径,可用 ExifInterface 读取;这里留接口位

putString("source", uri.toString())

}

}

说明:上面

用的是通用可执行方法。生产环境建议把 Tone Map 放到 GL/Compute(见 4.2.3),确保线性域映射与 P3→sRGB 转换一次完成。

sdrProxyFromF16

4.2.2 轻量归一 Shim(α/β 估计 + 通道收束)

适用:文件可解码,但观感不稳(ΔL 台阶 / 色相跳变)。Shim 小幅修正“有效增益”的增益量纲与通道偏差,使跨设备/跨模组更一致。

object RefNormalizerShim {

data class Params(

val alpha: Float = 1.0f, // log2 域缩放

val beta: Float = 0.0f, // log2 域偏置

val chClamp: Float = 0.06f // 通道相对均值限幅

)

// 采样 roi(灰/肤/天空)做加权 OLS 估计 α/β(简化稳健)

fun estimateParams(yRef: FloatArray, yCur: FloatArray, w: FloatArray): Params {

require(yRef.size == yCur.size && yRef.size == w.size)

var sw = 0.0; var swx = 0.0; var swy = 0.0; var swxx = 0.0; var swxy = 0.0

for (i in yRef.indices) {

val wi = w[i].toDouble()

val x = yRef[i].toDouble()

val y = yCur[i].toDouble()

sw += wi; swx += wi * x; swy += wi * y

swxx += wi * x * x; swxy += wi * x * y

}

val denom = sw * swxx - swx * swx + 1e-9

val a = ((sw * swxy - swx * swy) / denom).toFloat()

val b = ((swy - a * swx) / sw).toFloat()

// 收敛到近似(1,0)的小范围,避免过拟合

val alpha = a.coerceIn(0.94f, 1.06f)

val beta = b.coerceIn(-0.08f, 0.08f)

return Params(alpha, beta, chClamp = 0.06f)

}

/** 在 sRGB/8888 上模拟 "log2 域 α/β" 的轻量校正(近似):对亮度通道做仿射 */

fun applyShimSdr(bitmap: Bitmap, p: Params): Bitmap {

val w = bitmap.width; val h = bitmap.height

val out = bitmap.copy(Bitmap.Config.ARGB_8888, true)

val buf = IntArray(w)

for (y in 0 until h) {

out.getPixels(buf, 0, w, 0, y, w, 1)

for (x in 0 until w) {

val c = buf[x]

val a = (c ushr 24) and 0xff

var r = (c ushr 16) and 0xff

var g = (c ushr 8) and 0xff

var b = (c) and 0xff

val l = 0.2126f*r + 0.7152f*g + 0.0722f*b

val lNorm = (l / 255f).coerceIn(1e-4f, 1.0f)

val l2 = (Math.log(lNorm.toDouble()) / Math.log(2.0)).toFloat()

val l2Adj = p.alpha * l2 + p.beta

val lAdj = 2.0f.pow(l2Adj).coerceIn(0f, 1f)

val scale = if (l > 1f) (lAdj * 255f / l).coerceIn(0.5f, 1.5f) else 1f

r = (r * scale).toInt().coerceIn(0, 255)

g = (g * scale).toInt().coerceIn(0, 255)

b = (b * scale).toInt().coerceIn(0, 255)

buf[x] = (a shl 24) or (r shl 16) or (g shl 8) or b

}

out.setPixels(buf, 0, w, 0, y, w, 1)

}

return out

}

/** 通道收束(±p.chClamp 相对均值),抑制偏色 */

fun channelClampSdr(bitmap: Bitmap, p: Params): Bitmap {

val w = bitmap.width; val h = bitmap.height

val out = bitmap.copy(Bitmap.Config.ARGB_8888, true)

val buf = IntArray(w)

for (y in 0 until h) {

out.getPixels(buf, 0, w, 0, y, w, 1)

for (x in 0 until w) {

val c = buf[x]

val a = (c ushr 24) and 0xff

var r = (c ushr 16) and 0xff

var g = (c ushr 8) and 0xff

var b = (c) and 0xff

val mean = (r + g + b) / 3f

val lo = (mean * (1 - p.chClamp)).toInt()

val hi = (mean * (1 + p.chClamp)).toInt()

r = r.coerceIn(lo, hi); g = g.coerceIn(lo, hi); b = b.coerceIn(lo, hi)

buf[x] = (a shl 24) or (r shl 16) or (g shl 8) or b

}

out.setPixels(buf, 0, w, 0, y, w, 1)

}

return out

}

}

用法:从小图或 ROI 统计

(灰/肤/天空加权),估出

yRef/yCur/w;对 SDR 代理调用

α/β。HDR F16 路径建议把 Shim 放到 GL Shader 的线性域里完成(更准确)。

applyShimSdr → channelClampSdr

4.2.3 一次映射的 GL Shader

GLES 3.0 片段着色器:线性域 → ACES 近似 → 色域矩阵 → sRGB Gamma(系统合成已做 HDR 映射时,可把最后两步关闭)

#version 300 es

precision highp float;

in vec2 vUv;

uniform sampler2D uTexLinear; // 线性域 RGB (F16 纹理)

uniform mat3 uToTargetCS; // e.g. CameraLinear→DisplayP3

uniform int uDoToneMap; // 1:做曲线; 0:跳过(系统合成已做)

out vec4 fragColor;

vec3 acesApprox(vec3 x){

const float A=0.22, B=0.30, C=0.10, D=0.20, E=0.01, F=0.30;

return ((x*(A*x+C*B)+D*E)/(x*(A*x+B)+D*F)) - E/F;

}

void main(){

vec3 rgb = texture(uTexLinear, vUv).rgb; // scene-linear

if(uDoToneMap==1){

rgb = acesApprox(rgb);

}

rgb = clamp(uToTargetCS * rgb, 0.0, 1.0);

// 输出到 sRGB(如果目标是 HDR 合成,可改为线性直出)

rgb = pow(rgb, vec3(1.0/2.2));

fragColor = vec4(rgb, 1.0);

}

Kotlin(GL 初始化要点)

// GLES30.glTexImage2D(... GL_RGBA16F ...); 绑定 FBO 后按帧渲染

val uMap = GLES30.glGetUniformLocation(program, "uDoToneMap")

GLES30.glUniform1i(uMap, /*1=应用做; 0=系统做*/ if (systemDoesHdrToneMap) 0 else 1)

4.3 列表/详情一致:双轨缓存与可感知一致性

列表/L1/L2:仅用 SDR 代理(应用内曲线),避免滚动抖动。详情页:HDR F16(支持端)或 SDR 代理(不支持端)。一致性校验:

RMSE(hist_linear(SDR), hist_linear(HDR→SDR预览)) ≤ 2%

4.4 分享与降级(一致曲线)

优先分享 原始 JPEG_R;目标通道疑似不保留 HDR → 自动替换 SDR 导出(同一曲线与 flesh-line)。在

ClipData

HDR

SDR

5. 端侧实现与性能(Android 14+ · 稳定与可测)

5.1 组件结构(UML)

5.2 瓦片化/渐进策略与内存预算

估算:RGBA_F16 ≈ 8 B/px;4K 图 ≈ 66 MB;谨慎并发。

策略:

列表仅解 L1/L2(长边 256/640);详情页按需解全幅;超大图(>24MP)先下采样预览,再异步替换全幅。

代码(Kotlin):按目标尺寸解码,避免峰值

fun decodeForTarget(ctx: Context, uri: Uri, longEdge: Int): Bitmap {

val src = ImageDecoder.createSource(ctx.contentResolver, uri)

return ImageDecoder.decodeBitmap(src) { dec, info, _ ->

val (w,h) = info.size.let { it.width to it.height }

val scale = longEdge / max(w,h).toFloat()

val tw = (w * scale).coerceAtLeast(1f).toInt()

val th = (h * scale).coerceAtLeast(1f).toInt()

dec.setTargetSize(tw, th)

dec.allocator = ImageDecoder.ALLOCATOR_SOFTWARE

dec.setTargetColorSpace(ColorSpace.get(ColorSpace.Named.SRGB))

}

}

5.3 LruCache 与 WorkManager:SDR 代理生成与复用

class SdrCache(maxBytes: Int) : LruCache<String, Bitmap>(maxBytes) {

override fun sizeOf(key: String, value: Bitmap) = value.byteCount

}

val sdrCache = SdrCache(128 * 1024 * 1024) // 128MB

// 生成任务(WorkManager)

class SdrBuildWorker(appCtx: Context, params: WorkerParameters) : CoroutineWorker(appCtx, params) {

override suspend fun doWork(): Result = withContext(Dispatchers.IO) {

val uri = Uri.parse(inputData.getString("uri")!!)

val frame = UhdrDecoder.decodeOrFallback(applicationContext, uri)

val key = uri.toString()

sdrCache.put(key, frame.sdrProxy)

Result.success()

}

}

5.4 指标与日志:触发器/降级/耗时

object MetricsLogger {

private val gson = com.google.gson.Gson()

fun logDecode(uri: Uri, frame: UhdrFrame, tMs: Long, cause: String?=null) {

val m = mapOf(

"event" to "uhdr_decode",

"uri" to uri.toString(),

"f16" to (frame.bitmapF16 != null),

"time_ms" to tMs,

"cause" to (cause ?: "ok")

)

android.util.Log.i("UHDR", gson.toJson(m))

}

fun logFallback(uri: Uri, reason: String) {

val m = mapOf("event" to "uhdr_fallback", "uri" to uri.toString(), "reason" to reason)

android.util.Log.w("UHDR", gson.toJson(m))

}

fun logShim(uri: Uri, alpha: Float, beta: Float, chClamp: Float) {

val m = mapOf("event" to "uhdr_shim", "uri" to uri.toString(),

"alpha" to alpha, "beta" to beta, "chClamp" to chClamp)

android.util.Log.i("UHDR", gson.toJson(m))

}

}

5.5 真实可跑的Python重建工具(线下/CI)

用于“可恢复场景”的增益图再估计与蓝噪抖动量化。以下代码无需任何自定义库,仅依赖

。

numpy

# reconstruct_gain.py

import numpy as np

def grad(img):

gx = np.zeros_like(img); gy = np.zeros_like(img)

gx[..., :-1] = img[..., 1:] - img[..., :-1]

gy[:-1, ...] = img[1:, ...] - img[:-1, ...]

return gx, gy

def div(gx, gy):

fx = np.zeros_like(gx); fy = np.zeros_like(gy)

fx[..., 1:-0] = gx[..., 1:-0] - gx[..., :-1]

fy[1:-0, ...] = gy[1:-0, ...] - gy[:-1, ...]

return fx + fy

def normalize(gx, gy, eps=1e-6):

n = np.maximum(np.sqrt(gx*gx + gy*gy), eps)

return gx / n, gy / n

def guided_term(g, guide, kappa=0.6):

# 拉普拉斯近似: ∇^2 (g - κ*guide)

gx, gy = grad(g - kappa*guide)

return div(gx, gy)

def channel_deviation_grad(g):

if g.ndim != 3: return 0.0

mean = np.mean(g, axis=2, keepdims=True)

return (g - mean)

def reconstruct_log_gain(g0, mask, Lsdr, iters=120, lr=0.2,

lam_tv=0.01, lam_guided=0.05, lam_ch=0.02):

g = g0.copy()

for _ in range(iters):

# data fidelity

r_data = mask * (g - g0)

# TV gradient

gx, gy = grad(g)

nx, ny = normalize(gx, gy)

r_tv = div(nx, ny)

# guided (edge-aligned)

r_guided = guided_term(g, Lsdr, kappa=0.6)

# channel consistency

r_ch = channel_deviation_grad(g)

grad_total = r_data + lam_tv*r_tv + lam_guided*r_guided + lam_ch*r_ch

g -= lr * grad_total

return g

def blue_noise_like(shape, seed=17):

rng = np.random.default_rng(seed)

# 简化: 白噪 + 高通

n = rng.standard_normal(shape).astype(np.float32)

# 高通: n - boxblur(n)

from scipy.ndimage import uniform_filter

return (n - uniform_filter(n, size=7)).astype(np.float32)

def quantize_log2_with_dither(g, bit=10):

lsb = 1.0 / (2**bit - 1)

n = blue_noise_like(g.shape) * (0.5*lsb)

return np.round((g + n) / lsb) * lsb

if __name__ == "__main__":

# 演示:g0 部分缺损 → 重建 → 量化

H, W = 512, 512

g_true = np.zeros((H, W), np.float32); g_true[100:400, 100:400] = 0.8

mask = np.ones_like(g_true); mask[200:260, 200:260] = 0.0

g0 = g_true * mask

Lsdr = np.linspace(0, 1, W, dtype=np.float32)[None, :].repeat(H, 0)

g = reconstruct_log_gain(g0, mask, Lsdr)

gq = quantize_log2_with_dither(g, 10)

print("reconstruction done:", float(np.mean(np.abs(g - g_true))))

CI 可直接调用该脚本,在ROI 集上统计

并与阈值比较;失败则 Gate 阻断。

Δlog2/∇g/Banding

5.6 UI 集成(Jetpack Compose)

@Composable

fun UhPhotoDetail(uri: Uri) {

val ctx = LocalContext.current

val frame by produceState<UhdrFrame?>(initialValue = null, uri) {

value = UhdrDecoder.decodeOrFallback(ctx, uri)

}

frame?.let { f ->

val bmp = f.bitmapF16 ?: f.sdrProxy

Image(

bitmap = bmp.asImageBitmap(),

contentDescription = null,

modifier = Modifier.fillMaxSize()

)

}

}

5.7 性能/稳定性清单(落地必查)

解码失败必回退(不崩溃);HDR→SDR 一次映射;F16 内存峰值与并发数受控(≤ 2 幅全幅 F16 并发);L1/L2 缩略图命中率监控(≥ 90%);Shim 参数(α/β/通道收束)与触发原因日志可查;导出/分享:HDR 优先、SDR 降级一致曲线;自动化:重建脚本 + 指标 Gate 接入 CI。

6. 指标与门限(Gate):可复现的量化与一键阻断

目标:把“容错/重建后是否可上线”压成一组稳定的指标 + 明确阈值,在 CI 或产线抽检中自动阻断异常回归;端侧遇到触发时与运行时降级联动(第 4–5 章)。

6.1 指标口径(线性域、统一上/下采样核)

| 指标 | 定义(要点) | 指向 | ||||||

|---|---|---|---|---|---|---|---|---|

| ΔL_rel | 同一 ROI 的重建亮度相对误差:(mathrm{median}ig( | L_1-L_2 | /(L_2+epsilon)ig)) | 亮度台阶 | ||||

| ΔE00 / Δh° / ΔC* | CIEDE2000、色相角/饱和度变化(OKLCh/CIELAB 任选其一,口径固定) | 色偏/塑料感 | ||||||

| **ΔG_rel / | Δlog2 G | ** | 增益幅值差:(mathrm{median} | G_1/G_2-1 | ) 或 ( | log_2 G_1-log_2 G_2 | ) | 增益量纲 |

| P95(‖∇g‖) |

g = log 2 G g=log_2 G g=log2G 的梯度 95 百分位 |

斜率/光晕风险 | ||||||

| ChDev | (P95(max_c | G_c-ar G | /ar G)) | 通道偏差 | ||||

| BandingScore | 二阶差分能量 / 低频直方图尖峰 | 带状 | ||||||

| BlockinessIndex | 8×8 边界响应比 | 块效应 | ||||||

| Flicker | 帧序列与其低通的 RMSE(灰/肤/天空) | 闪变 |

建议阈值(P95):ΔL_rel ≤ 3%,ΔE00 ≤ 3.0,Δh° ≤ 3.5°,ΔG_rel ≤ 5%(或 |Δlog2| ≤ 0.07),|ΔP95(∇g)| ≤ 0.01/px,Banding ≤ 0.30,Blockiness ≤ 1.6,Flicker ≤ 0.02。

6.2 Python 指标库(可直接用在 CI)

依赖:

(可选:

numpy读图;若已有数组则不必)

imageio

# metrics_uhdr.py

import numpy as np

def p95(x): return float(np.percentile(x.reshape(-1), 95))

# ---------- 颜色空间:sRGB <-> XYZ <-> Lab ----------

def srgb_to_linear(rgb): # rgb: float32 [0,1]

a = 0.055

out = np.where(rgb <= 0.04045, rgb/12.92, ((rgb+a)/(1+a))**2.4)

return out.astype(np.float32)

def linear_to_srgb(lin):

a = 0.055

out = np.where(lin <= 0.0031308, 12.92*lin, (1+a)*np.power(lin, 1/2.4)-a)

return np.clip(out,0,1).astype(np.float32)

def rgb_to_xyz(rgb): # sRGB D65

M = np.array([[0.4124564,0.3575761,0.1804375],

[0.2126729,0.7151522,0.0721750],

[0.0193339,0.1191920,0.9503041]], np.float32)

return rgb @ M.T

def xyz_to_lab(xyz):

Xn,Yn,Zn = 0.95047,1.0,1.08883

x,y,z = xyz[...,0]/Xn, xyz[...,1]/Yn, xyz[...,2]/Zn

eps, k = 216/24389, 24389/27

f = lambda t: np.where(t>eps, np.cbrt(t), (k*t+16)/116)

fx, fy, fz = f(x), f(y), f(z)

L = 116*fy-16; a = 500*(fx-fy); b = 200*(fy-fz)

return np.stack([L,a,b], -1).astype(np.float32)

def deltaE2000(lab1, lab2):

# 实现略长,遵循 CIEDE2000 标准(可粘贴入库复用)

L1,a1,b1 = lab1[...,0],lab1[...,1],lab1[...,2]

L2,a2,b2 = lab2[...,0],lab2[...,1],lab2[...,2]

kL=kC=kH=1.0

C1 = np.sqrt(a1*a1 + b1*b1)

C2 = np.sqrt(a2*a2 + b2*b2)

Cm = 0.5*(C1+C2)

G = 0.5*(1 - np.sqrt((Cm**7)/((Cm**7)+(25**7))))

a1p = (1+G)*a1; a2p=(1+G)*a2

C1p = np.sqrt(a1p*a1p + b1*b1); C2p=np.sqrt(a2p*a2p + b2*b2)

h1p = np.degrees(np.arctan2(b1, a1p))%360.0

h2p = np.degrees(np.arctan2(b2, a2p))%360.0

dLp = L2-L1

dCp = C2p-C1p

dhp = h2p-h1p

dhp = np.where(dhp>180, dhp-360, dhp)

dhp = np.where(dhp<-180, dhp+360, dhp)

dHp = 2*np.sqrt(C1p*C2p)*np.sin(np.radians(dhp)/2)

Lpm = 0.5*(L1+L2)

Cpm = 0.5*(C1p+C2p)

hp_sum = h1p+h2p

Hpm = np.where(np.abs(h1p-h2p)>180, (hp_sum+360)/2, hp_sum/2)

T = 1 - 0.17*np.cos(np.radians(Hpm-30)) + 0.24*np.cos(np.radians(2*Hpm))

+ 0.32*np.cos(np.radians(3*Hpm+6)) - 0.20*np.cos(np.radians(4*Hpm-63))

Sl = 1 + (0.015*(Lpm-50)**2)/np.sqrt(20+(Lpm-50)**2)

Sc = 1 + 0.045*Cpm

Sh = 1 + 0.015*Cpm*T

Rt = -2*np.sqrt((Cpm**7)/((Cpm**7)+(25**7)))

* np.sin(np.radians(60*np.exp(-((Hpm-275)/25)**2)))

dE = np.sqrt((dLp/(kL*Sl))**2 + (dCp/(kC*Sc))**2 + (dHp/(kH*Sh))**2 + Rt*(dCp/(kC*Sc))*(dHp/(kH*Sh)))

return dE.astype(np.float32)

# ---------- 基础指标 ----------

def deltaL_rel(L1, L2, mask=None, eps=1e-6):

r = np.abs(L1-L2)/(np.abs(L2)+eps)

return p95(r[mask]) if mask is not None else p95(r)

def grad95_log2(G):

g = np.log2(np.clip(G, 1e-6, None)).astype(np.float32)

gx = np.abs(g[:,1:]-g[:,:-1]); gy = np.abs(g[1:,:]-g[:-1,:])

return p95(np.concatenate([gx.reshape(-1), gy.reshape(-1)]))

def ch_dev95(Grgb):

mean = np.mean(Grgb, axis=2, keepdims=True)

dev = np.max(np.abs(Grgb-mean)/(mean+1e-6), axis=2)

return p95(dev)

def banding_score(gray): # 简化可重复:二阶差分能量

d2x = gray[:,2:]-2*gray[:,1:-1]+gray[:,:-2]

d2y = gray[2:,:]-2*gray[1:-1,:]+gray[:-2,:]

return float(np.mean(np.abs(d2x))) + float(np.mean(np.abs(d2y)))

def blockiness_index(gray):

# 8x8 边界响应:块边差 / 块内差

H,W = gray.shape

v = np.mean(np.abs(gray[:,7::8]-gray[:,6::8]))

h = np.mean(np.abs(gray[7::8,:]-gray[6::8,:]))

vin = np.mean(np.abs(gray[:,4::8]-gray[:,3::8]))

hin = np.mean(np.abs(gray[4::8,:]-gray[3::8,:]))

return float((v+h)/(vin+hin+1e-6))

# ---------- Lab 指标(ΔE/Δh/ΔC*) ----------

def lab_metrics(rgb1_srgb, rgb2_srgb, mask=None):

lin1, lin2 = srgb_to_linear(rgb1_srgb), srgb_to_linear(rgb2_srgb)

lab1, lab2 = xyz_to_lab(rgb_to_xyz(lin1)), xyz_to_lab(rgb_to_xyz(lin2))

dE = deltaE2000(lab1, lab2)

C1 = np.sqrt(lab1[...,1]**2 + lab1[...,2]**2); C2 = np.sqrt(lab2[...,1]**2 + lab2[...,2]**2)

h1 = (np.degrees(np.arctan2(lab1[...,2], lab1[...,1]))%360)

h2 = (np.degrees(np.arctan2(lab2[...,2], lab2[...,1]))%360)

dh = h2-h1; dh = np.where(dh>180, dh-360, dh); dh = np.where(dh<-180, dh+360, dh)

dC = C2-C1

if mask is not None:

dE = dE[mask]; dh = np.abs(dh[mask]); dC = np.abs(dC[mask])

return {"dE00_P95": p95(dE), "dHue_P95": p95(dh), "dC_P95": p95(dC)}

6.3 Gate 配置(YAML)

# gate_uhdr.yaml

thresholds:

deltaL_P95: 0.03

dE00_P95: 3.0

dHue_P95: 3.5

dC_P95: 4.0

deltaG_P95: 0.05 # 或 |Δlog2| <= 0.07

gradDiff_P95: 0.01 # |P95(∇g_a)-P95(∇g_b)|

banding: 0.30

blockiness: 1.60

flicker: 0.02

gates:

block_on: ["deltaL_P95","dE00_P95","dHue_P95","deltaG_P95","banding"]

6.4 Gate 脚本(Python,读取 metrics.json 阻断合入)

# gate_uhdr.py

import json, sys, yaml

cfg = yaml.safe_load(open("gate_uhdr.yaml","r"))

thr = cfg["thresholds"]; block_on = set(cfg["gates"]["block_on"])

m = json.load(open(sys.argv[1],"r")) # metrics.json

viol = []

def chk(key, val, thr_val):

if val > thr_val: viol.append((key, val, thr_val))

for k in thr:

if k in m: chk(k, float(m[k]), float(thr[k]))

if any(k in block_on for k,_,_ in viol):

for k,v,t in viol: print(f"[GATE] {k}={v:.4f} > {t}")

sys.exit(2)

print("[GATE] PASS")

6.5 CI 流程(Mermaid)

flowchart TD

A[构建/拉样本] --> B[异常检测+重建(1–3章)]

B --> C[指标计算(metrics_uhdr.py)]

C --> D[生成 metrics.json]

D --> E[gate_uhdr.py 校验]

E -->|FAIL| F[阻断 + 失败样本打包 + 参数快照]

E -->|PASS| G[归档 + 发布]

6.6 Android 端回归(Macrobenchmark 关键断言)

@RunWith(AndroidJUnit4::class)

class UhPlaybackBenchmark {

@get:Rule val rule = MacrobenchmarkRule()

@Test fun detailRenderStable() = rule.measureRepeated(

packageName = "com.example.uhdr",

metrics = listOf(FrameTimingMetric(), MemoryCounters()),

iterations = 3,

setupBlock = { pressHome(); startActivityAndWait() }

) {

// 打开 HDR 详情页滑动 5 屏,确保掉帧<2%、F16 峰值受控

device.swipe(device.displayWidth/2, device.displayHeight*3/4,

device.displayWidth/2, device.displayHeight/4, 60)

}

}

7. 案例与配置管理:复盘 → 固化 → 灰度

7.1 典型案例复盘(三例)

A. 增益段尾部截断 → 局部台阶 + 带状

诊断:结构校验通过;语义校验显示 tile 长度异常(右下角 3×3 tile)。动作:第 3 章 tile in-painting + 量化前蓝噪抖动;BandingScore 从 0.45 降到 0.23。Gate:ΔL_rel P95 2.2%,通过。

B. 位深误标(8bit → 10bit) → 带状/块边共振

诊断:XMP 标 10bit,实际步进呈 8bit。动作:强制位深更正 + 抖动,SDR 基底 JPEG Q 提至 92;Blockiness 1.52。Gate:Banding 0.27(≤0.30),通过。

C. 通道错配(G 通道偏高) → 肤色偏绿

诊断:ChDev P95 9.1%。动作:通道收束至 ±6% + flesh-line HueLock 3.5°;ΔE00 P95 2.8。Gate:PASS。

7.2 配置版本化(YAML)

# uhdr_tolerance_v1_3.yaml

version: "UHDR-Tolerance-1.3"

ref_domain: "RCL-v2"

reconstruct:

tv_lambda: 0.01

guided_lambda: 0.05

channel_lambda: 0.02

iter: 120

codec:

gainmap_bitdepth_min: 10

gainmap_scale_roi: 1.5

sdr_q_min: 90

dither: "blue-noise"

shim:

alpha_clip: [0.94, 1.06]

beta_clip: [-0.08, 0.08]

channel_clamp: 0.06

thresholds:

deltaL_P95: 0.03

dE00_P95: 3.0

dHue_P95: 3.5

dC_P95: 4.0

deltaG_P95: 0.05

gradDiff_P95: 0.01

banding: 0.30

blockiness: 1.60

flicker: 0.02

feature_flags:

sdr_fallback_only: false

shim_enable: true

变更审计(JSON)

{

"version_from": "UHDR-Tolerance-1.2",

"version_to": "UHDR-Tolerance-1.3",

"diff": {

"shim.alpha_clip": {"old": [0.92,1.08], "new": [0.94,1.06]},

"codec.sdr_q_min": {"old": 88, "new": 90},

"thresholds.deltaG_P95": {"old": 0.06, "new": 0.05}

}

}

7.3 灰度发布与回滚(Mermaid Gantt)

回滚路径

远程配置:

feature_flags.sdr_fallback_only=true

UHDR-Tolerance-1.2

7.4 端侧日志与聚合

Kotlin(已落地示例)

MetricsLogger.logFallback(uri, reason = "gain_truncated")

MetricsLogger.logShim(uri, alpha = 1.02f, beta = 0.03f, chClamp = 0.06f)

聚合维度

异常类型分布(结构/语义/数据缺口/通道);触发→降级动作→用户可感知投诉比;Gate 通过率、失败样本 Top-N。

7.5 失败样本打包(Python)

# pack_failures.py

import os, json, tarfile, time

def pack(folder="failures", out="failures_%d.tar.gz" % int(time.time())):

with tarfile.open(out, "w:gz") as tar:

for root,_,files in os.walk(folder):

for f in files:

tar.add(os.path.join(root,f))

print("packed:", out)

if __name__=="__main__": pack()

个人简介

作者简介:全栈研发,具备端到端系统落地能力,专注人工智能领域。

个人主页:观熵

个人邮箱:privatexxxx@163.com

座右铭:愿科技之光,不止照亮智能,也照亮人心!

专栏导航

观熵系列专栏导航:

具身智能:具身智能

国产 NPU × Android 推理优化:本专栏系统解析 Android 平台国产 AI 芯片实战路径,涵盖 NPU×NNAPI 接入、异构调度、模型缓存、推理精度、动态加载与多模型并发等关键技术,聚焦工程可落地的推理优化策略,适用于边缘 AI 开发者与系统架构师。

DeepSeek国内各行业私有化部署系列:国产大模型私有化部署解决方案

智能终端Ai探索与创新实践:深入探索 智能终端系统的硬件生态和前沿 AI 能力的深度融合!本专栏聚焦 Transformer、大模型、多模态等最新 AI 技术在 智能终端的应用,结合丰富的实战案例和性能优化策略,助力 智能终端开发者掌握国产旗舰 AI 引擎的核心技术,解锁创新应用场景。

企业级 SaaS 架构与工程实战全流程:系统性掌握从零构建、架构演进、业务模型、部署运维、安全治理到产品商业化的全流程实战能力

GitHub开源项目实战:分享GitHub上优秀开源项目,探讨实战应用与优化策略。

大模型高阶优化技术专题

AI前沿探索:从大模型进化、多模态交互、AIGC内容生成,到AI在行业中的落地应用,我们将深入剖析最前沿的AI技术,分享实用的开发经验,并探讨AI未来的发展趋势

AI开源框架实战:面向 AI 工程师的大模型框架实战指南,覆盖训练、推理、部署与评估的全链路最佳实践

计算机视觉:聚焦计算机视觉前沿技术,涵盖图像识别、目标检测、自动驾驶、医疗影像等领域的最新进展和应用案例

国产大模型部署实战:持续更新的国产开源大模型部署实战教程,覆盖从 模型选型 → 环境配置 → 本地推理 → API封装 → 高性能部署 → 多模型管理 的完整全流程

Agentic AI架构实战全流程:一站式掌握 Agentic AI 架构构建核心路径:从协议到调度,从推理到执行,完整复刻企业级多智能体系统落地方案!

云原生应用托管与大模型融合实战指南

智能数据挖掘工程实践

Kubernetes × AI工程实战

TensorFlow 全栈实战:从建模到部署:覆盖模型构建、训练优化、跨平台部署与工程交付,帮助开发者掌握从原型到上线的完整 AI 开发流程

PyTorch 全栈实战专栏: PyTorch 框架的全栈实战应用,涵盖从模型训练、优化、部署到维护的完整流程

深入理解 TensorRT:深入解析 TensorRT 的核心机制与部署实践,助力构建高性能 AI 推理系统

Megatron-LM 实战笔记:聚焦于 Megatron-LM 框架的实战应用,涵盖从预训练、微调到部署的全流程

AI Agent:系统学习并亲手构建一个完整的 AI Agent 系统,从基础理论、算法实战、框架应用,到私有部署、多端集成

DeepSeek 实战与解析:聚焦 DeepSeek 系列模型原理解析与实战应用,涵盖部署、推理、微调与多场景集成,助你高效上手国产大模型

端侧大模型:聚焦大模型在移动设备上的部署与优化,探索端侧智能的实现路径

行业大模型 · 数据全流程指南:大模型预训练数据的设计、采集、清洗与合规治理,聚焦行业场景,从需求定义到数据闭环,帮助您构建专属的智能数据基座

机器人研发全栈进阶指南:从ROS到AI智能控制:机器人系统架构、感知建图、路径规划、控制系统、AI智能决策、系统集成等核心能力模块

人工智能下的网络安全:通过实战案例和系统化方法,帮助开发者和安全工程师识别风险、构建防御机制,确保 AI 系统的稳定与安全

智能 DevOps 工厂:AI 驱动的持续交付实践:构建以 AI 为核心的智能 DevOps 平台,涵盖从 CI/CD 流水线、AIOps、MLOps 到 DevSecOps 的全流程实践。

C++学习笔记?:聚焦于现代 C++ 编程的核心概念与实践,涵盖 STL 源码剖析、内存管理、模板元编程等关键技术

AI × Quant 系统化落地实战:从数据、策略到实盘,打造全栈智能量化交易系统

大模型运营专家的Prompt修炼之路:本专栏聚焦开发 / 测试人员的实际转型路径,基于 OpenAI、DeepSeek、抖音等真实资料,拆解 从入门到专业落地的关键主题,涵盖 Prompt 编写范式、结构输出控制、模型行为评估、系统接入与 DevOps 管理。每一篇都不讲概念空话,只做实战经验沉淀,让你一步步成为真正的模型运营专家。

🌟 如果本文对你有帮助,欢迎三连支持!

👍 点个赞,给我一些反馈动力

⭐ 收藏起来,方便之后复习查阅

🔔 关注我,后续还有更多实战内容持续更新

相关文章